4.ЕНТРОПІЯ ТА ІНФОРМАЦІЯ

4.1. Ентропія як міра статистичної невизначеності.В одному з недавніх громадських обговорень проблем освіти було висловлено думку, що кожна освічена людина має розуміти фундаментальність поняття невизначеності. В останні десятиліття цей термін впевнено лідирує серед фізичних першопринципів, проникаючи у нові галузі знання. У цьому розділі слід ближче ознайомитися з цим поняттям і усвідомити зв'язок невизначеності із системоутворюючими характеристиками.

Невизначеність може мати різне походження. Один із її видів – невідомість– розглядається теорією пізнання та філософією; такого типу невизначеність виникає, коли ми, наприклад, ставимо питання «Чи є життя інших планетах?». чи «Чи існують інші цивілізації?» і т.п.

Інший вид невизначеності – розпливчастість, розмитість,- Наприклад, «Скільки треба взяти піщин, щоб утворити невелику купу»? З невизначеністю цього ми зустрічаємося в квантової механіці. На її основі побудовано нелокальну версію термодинаміки, яка здатна відповісти на подібне питання: «скільки треба мати частинок, щоб утворити макрорівень і яке квантове розсіювання цього числа»? Ця невизначеність об'єктивна, для неї характерно, що вона непереборна у процесі вимірів. У математиці такою невизначеністю займається теорія розмитих множин. Слід принагідно відзначити, що розмитість – характерна властивість мови: «у кімнату (яку?) увійшов високий (якого зростання?) молодий (якого саме віку?) людина (хто він?) тощо.

Третій вид невизначеності – випадковість. У її основі лежать статистичні закономірності, які встановлюються теорією ймовірності. Цей вид невизначеності використовується статистичною фізикою та разом з невизначеністю другого типу у квантовій механіці. Відмінна риса статистичної невизначеності полягає в тому, що для неї можна встановити кількісний захід, про який йтиметься далі.

Залишимо поки осторонь питання про практичну значимість статистичної міри невизначеності, зосередивши увагу на її сутності. Розглянемо кілька найпростіших ситуацій, які називатимемо дослідамиА, BiC. Передбачається, що читачеві знайомі елементи теорії ймовірності.

Досвід А полягатиме в киданні монети. У цьому досвіді можливі два результату(k=2): "орел або решка". Очевидно, ймовірність кожного результату ( i=1,2).

Дослід B - кидання гральної шестигранної кістки. У цьому досвіді можливі вже шість результатів ( k=6). Імовірність кожного результату.

Досвід C передбачає одночасне кидання двох кісток. Для цього досвіду k=36 в.

Оцінка невизначеності результатів експериментів є оцінка проблеми передбачення результату експерименту. Інтуїтивно ясно, що з усіх описаних ситуацій досвід має максимальну невизначеність, оскільки число результатів тут найбільше і заздалегідь передбачати результат цього досвіду найважче.

Щоб перейти до кількісної оцінки невизначеності, сформулюємо основні вимоги до функції, яка повинна грати роль невизначеності. Будемо позначати цю функцію буквою H.

Першу вимогу. Функція Нмає монотонно зростати зі збільшенням числа наслідків досвіду.

Друга вимога. Функція Нповинна дорівнювати нулю, якщо є єдиний результат ( k=1). Це означає, що якщо можливий лише один результат, то ніякої невизначеності немає і результат досвіду можна передбачити безпомилково.

Третє вимога. Звернімо увагу на те, що один досвід можна розглядати як два досвіди В, і вимагатимемо, щоб сумарне значення ентропії двох дослідів В дорівнювало ентропії досвіду С

або в загальному випадку не для двох, а nпростих дослідів

Якби третьої вимоги не дотримувалося, то оцінка невизначеності досвіду С виявилася б суперечливою і залежала б від суб'єктивного трактування самого досвіду – чи вважати, що мав місце досвід С, чи все ж таки кістки впали не одночасно і мали місце два досвіди В. Прийняття цієї вимоги рівносильно запровадження властивостей адитивності для майбутньої оцінки невизначеності. За замовчуванням приймається, що елементи (кістки), що розглядаються, не взаємодіють між собою. У термодинамічному трактуванні це рівносильно прийняттю ідеальної системи.

Розв'яжемо функціональне рівняння (4.1) щодо функції . Для цього диференційуємо обидві частини виразу (4.1-1) k, використовуючи вимогу монотонності функції:

Тепер диференціюємо (4.1) за n

Розділимо рівняння (4.2) на (4.3)

що рівносильно

Інтегруючи цей вираз, використовуючи для правої частини табличний інтеграл, знаходимо

де - Постійна інтегрування.

З останнього виразу

Бо зі збільшенням kентропія зростає (перша вимога), то C>0, і це вираз можна переписати у такому остаточному вигляді:

,a>1.

З нього випливає, що воно задовольняє також другу вимогу. Вибір підстави логарифмів при a>1не має значення і визначає лише вибір одиниці виміру невизначеності. Найчастіше застосовують двійкові чи натуральні логарифми. Якщо використовують двійкові логарифми, то за одиницю виміру невизначеності приймають невизначеність досвіду, який має два рівноймовірні результати (досвід А). Така ситуація відповідає ентропії одного елементарного комп'ютерного осередку, у якій зберігається або 0 або 1. Для цього осередку

Така одиниця виміру називається бітом(Від англ.binarydiget - двійкова одиниця).

Отже, за kрівноймовірних наслідків невизначеність досвіду становить

де p- Імовірність результату досвіду.

Якщо врахувати, що для рівноймовірних наслідків

то, помножуючи (4.4) на одиницю у вигляді суми ймовірностей

Кожен член правої частини цього виразу можна як вклад окремого результату у загальну невизначеність досвіду. У разі рівноймовірних результатів вклад кожного з них у загальну невизначеність досвіду однаковий і формула (4.5) згортається (4.4).

Вираз (4.5) легко узагальнюється у разі, коли ймовірності результатів різні. У цьому випадку (4.5) можна розглядати як середню ентропію досвіду, а ймовірності перед log набувають сенсу вагових коефіцієнтів. Тепер передбачається, що внесок кожного результату у загальну невизначеність досвіду необов'язково однаковий. Як приклад ситуації з нерівноймовірними наслідками може бути досвід вилучення навмання кулі з урни, в якій знаходиться велика кількість куль кількох кольорів. Застереження щодо великої кількості куль зроблено спеціально, щоб наголосити на ймовірнісному характері міри невизначеності.

Вираз (4.5) можна записати у компактній формі

Якщо кількість дослідів N, то з урахуванням адитивності ентропії

Ентропія як міра невизначеності була введена американським математиком Клодом Шенноном у 1949 році при розробці математичної теорії зв'язку. Функцію типу (4.6), або ентропію виборучасто називають також шененнонівською ентропією.Оскільки поняття ентропії сьогодні стає загальнонауковим, то вказівка на її інформаційне походження, як правило, використовується лише у випадках, якщо за текстом слід розрізняти інформаційну та термодинамічну (фізичну) ентропію.

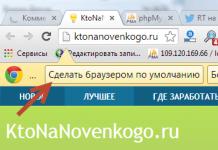

Мал. 4.1. Залежність ентропії для двох результатів досвіду

Розглянемо деякі властивості ентропії. Зазначимо насамперед, що ентропія неспроможна приймати негативних значень: оскільки , то завжди позитивно. Якщо, то (для підтвердження слід розкрити невизначеність типу). Якщо, то також.

Бо тільки при p=0 або p=1, то ентропія досліду дорівнює нулю тільки у випадку, коли одна з ймовірностей дорівнює одиниці і, отже, всі інші дорівнюють нулю. Ця обставина добре узгоджується зі змістом величини Hяк заходи невизначеності: у разі досвід взагалі немає ніякої невизначеності, оскільки результат досвіду можна передбачити заздалегідь.

На рис.4.1 зображено графік функції Hдля двох наслідків досвіду, з якого видно, як змінюється ентропія при зміні одного з наслідків досвіду від нуля до одиниці. З графіка випливає, що максимальне значення ентропії відповідає рівноймовірним подіям. При цьому максимальне значення ентропії

У загальному випадку, тобто не для двох, а kрезультатів досвіду, максимальне значення ентропії відповідає.

Той факт, що максимум ентропії відповідає рівноймовірним подіям, узгоджується із змістом ентропії. Справді, у разі рівноймовірних подій не можна віддати перевагу жодному результату і таким чином передбачити результат найважче.

4.2. Ентропія як міра кількості інформації.Повернімося до найпростіших дослідів із монетою або гральною кісткою. Перед проведенням досвіду існує певна невизначеність, що з незнанням результату досвіду. Після проведення досвіду, тобто. після отримання результату ця невизначеність усувається, зникає. Однак така ситуація далеко не завжди, і в практиці найчастіше трапляються випадки, коли і після закінчення досвіду ще залишається деяка невизначеність.

Якщо невизначеність до досвіду становила Н(апріорна невизначеність), а після досвіду –( апостеріорна невизначеність), то очевидно, невизначеність, усунена під час досвіду, складе:

Ця різниця зветься кількості інформації.

Таким чином, кількість інформації є кількість усуненої невизначеності. В окремому випадку, коли невизначеність в результаті досвіду усувається повністю, як це було в дослідах А, В, і С, отримуємо:. Хоча тут кількість інформації формально дорівнює ентропії, слід мати на увазі різне значення кількості інформації та ентропії. Ентропія (невизначеність) існує до досвіду, тоді як інформація виникає після проведення досвіду. Просто слід враховувати, що з кількісної оцінки інформації відсутня інший захід крім ентропії. Зв'язок між поняттями ентропії та кількістю інформації нагадує співвідношення між фізичними поняттями потенціалу (ентропії) та різницею потенціалів (кількість інформації).

Кількість інформації, як і ентропія, вимірюється у бітах. Один біт інформації – це кількість інформації, що повідомляє про те, яка з двох рівноймовірних подій мала місце. Наприклад, кількість інформації, що полягає в одному елементарному осередку ЕОМ, що містить або 0 або 1, становить один біт.

Розглянемо приклад, у якому фігурувала б апостеріорна невизначеність. Нехай шляхом перебору варіантів ведеться пошук кореня деякого рівняння з точністю до напівцілого числа. Попередньо відомо, що значення кореня знаходиться в інтервалі від 1 до 100, тому слід перебрати 200 варіантів. Тоді невизначеність значення кореня в рівноймовірному варіанті (4.4) становитиме H = log 2 200 = 133 біт.

Нехай проведено перевірку 150 варіантів можливих значень кореня, але коріння не знайдено. Однак чи отримано деяку інформацію про значення кореня? Безперечно, і щоб її визначити, необхідно спочатку знайти залишкову (апостеріорну) невизначеність: Н 1 = log 2 (200 - 150) = 5,6. Тоді потрібна кількість інформації становитиме= 13,3 – 5,6 = 7,7 біт.

Умовна ентропія.Розглянемо поняття кількості інформації з прикладу передачі сигналів. Нехай передається група сигналів абеткою Морзе:

До отримання чергового символу на приймальному кінці існує невизначеність "який сигнал буде відправлено?" Цю невизначеність можна характеризувати ентропією «однієї символ» (4.6) при числі результатів k= 3 (точка, тире, пропуск) з ймовірностями р i (i= 1, 2, 3). Ймовірності появи на приймальному кінці точки, тирі чи пробілу, тобто. ймовірності (частоти) вживання символів конкретної мови фахівцям відомі зі статистичного аналізу великого обсягу текстів цією мовою. Підрахувавши ентропію однією символ, за формулою (4.6) легко визначити загальну ентропію повідомлення (4.7). У цьому прикладі 10 символів, включаючи пробіл і, отже, N = 10.

Отже, на приймальному кінці до отримання повідомлення існувала апріорна невизначеність (4.7) або один знак (4.6). Після отримання повідомлення невизначеність була усунена та отримана інформація I = H-0.

Однак така проста ситуація виникає, якщо повідомлення передається без перешкод ( канал без шуму). Якщо є шум, то його дія призводить до того, що переданий символ може залишитися колишнім (i-м), або бути випадково підміненим будь-яким іншим (n-м) символом. Імовірність такої заміни за позначенням р(y n x i), де х відноситься до переданого сигналу, а y до сигналу, що приймається в приймачі. У каналі без перешкод у y n = x i . Імовірність р(y n x i) зветься умовної ймовірності x i) - ймовірність того, що відправлений i-й сигнал відповідає n-му сигналу на приймальному кінці. Звичайно, цю ситуацію можна розглядати і з боку передавача, використовуючи умовні ймовірності виду р(x i y n). У цьому випадку р(x i y n) – ймовірність того, що прийнятий на приймальному кінці n-й сигнал відповідає i-му сигналу на стороні, що передає. Поняття умовної ймовірності запроваджує умовну ентропіюяк функцію умовної ймовірності. Загалом це записується в наступних позначеннях:

I(X,Y) = H(X) – H(XY)

I(X,Y) = H(Y) – H(YX)

У цих ідентичних висловлюваннях умовна ентропія відіграє роль апостеріорної ентропії, а кількість інформації є міра відповідностідвох випадкових об'єктів Х та Y.

Цей захід дозволяє зрозуміти зв'язок між поняттямінформації та її кількістю. Інформація є відображенням одного об'єкта іншим. У цьому прикладі такими об'єктами є приймач і передавач. Середня кількість інформації і є числова характеристика повноти цього відображення, ступеня відповідності, нарешті, ступеня взаємодіїцих об'єктів. Але при взаємодії об'єкти впливають один на одного, і ми звикли при цьому розрізняти причину та наслідок. Кількісний опис інформації - це інший тип опису взаємодій, ніяк не пов'язаний з класичними причинно-наслідковими описами.. Такий тип зв'язку характерний НВТ.

Тут корисно звернутися до п.3.6, де вже стосувалися обмежень класичного, причинно-наслідкового механізму в описах взаємодій відкритої системі.

4.3.Ентропія безперервної множини.Раніше була розглянута ентропія дискретної множини.Це означає, що малися на увазі системи, де число можливих результатів (елементів множини) звичайно. Однак доводиться часто стикатися з ситуаціями, коли кількість елементів може бути як завгодно велика. З теорії ймовірностей відомо, що в цьому випадку слід мати справу не з ймовірністю окремого результату, що дорівнює нулю, а з щільністю розподілу ймовірності. Ця функція має таку властивість, що є ймовірність того, що цікава для нас змінна x(значення кореня у прикладі п.4.2.) набере значення, укладені в інтервалі від xдо x+dx.

Тепер для оцінки невизначеності необхідно вдатися до ентропії безперервної множини, яка за аналогією з ентропією дискретної множини (4.5) має вигляд

![]() . (4.9)

. (4.9)

Як приклад використання цієї функції спробуємо оцінити невизначеність досвіду, пов'язаного з випадковим пошуком у заданому інтервалі значення кореня (див. п.4.2) за відсутності обмеження на точність пошуку.

Підвищуючи вимоги до точності відповіді, можна очікувати скільки завгодно великої кількості можливих результатів досвіду. При цьому ймовірність кожного результату прагне нуля, а корінь може приймати всі можливі (незчисленні) значення в заданому числовому інтервалі від 0 до 200. Спробуємо використовувати для цього завдання ентропію безперервної множини. Введемо відрізок завдовжки l= x 1 - x 0 відносних одиниць. Імовірність виявити значення кореня на ділянці dx становить dx/ 1 . З іншого боку, ця ж ймовірність визначення. Отже, для рівноймовірного випадку = dx/lі = 1/ l.Підставляючи це значення (4.), нескладно отримати H = log 2 l = 5,6 біт.

Порівняємо отриманий результат із прикладом у п.4.2. У разі дискретної множини в ентропії використовується кількість дискретних інтервалів на виділеному відрізку, а у разі безперервної множини – відносна довжина самого відрізка. Зауважимо, що довжина має бути виражена у відносній формі, інакше під логарифмом з'явилася б розмірна величина. Масштаб приведення до відносної форми не має для інформаційної ентропії принципового значення, оскільки від початку ентропія введена з точністю до множника (до постійної інтегрування, див процедуру інтегрування в п.4.1).

Ентропія безперервної множини або диференційна ентропія(4.9) має більшість властивостей ентропії дискретної множини.

У сучасній літературі можна зустріти критику поняття диференціальної ентропії і з цього поняття диференціальної кількості інформації. Ця критика за характером збігається з критикою концепції безперервності, розглянутої раніше у п.3.5.

4.4.Ентропія як міра різноманітності, невпорядкованості, хаосу.До цього часу поняття ентропії пов'язувалося з невизначеністю. Ентропія припускає й інше тлумачення. Уявімо систему, що складається з камери, в якій знаходяться Nшарів типів, що відрізняються, наприклад, кольором . Передбачається, що досить велика кількість. Позначимо частку куль i-го типу (колір) -. Якщо зробити досвід над системою, що полягає у витяганні навмання однієї кулі, то ентропія одного досвіду згідно (4.6) складе:

При цьому прийнято, що розміри куль однакові, інакше ймовірність вилучення куль i-Того типу не буде точно відповідати їхній частці в камері. Ентропія всіх дослідів над системою

Оскільки права частина останніх виразів включає в себе параметри, що характеризують вміст системи, виникає питання, чи не можна не звертаючись до дослідів з кулями усвідомити, з якої точки зору ці функції характеризують вміст камери.

Перша з двох функцій характеризує ступінь невпорядкованостісистеми чи ступінь різноманітності у ній з урахуванням обраної ознаки для розрізнення елементів системи (колір куль). Якби в камері знаходилися кулі одного типу, тоді одне із значень ймовірності p=zдорівнювало б одиниці, проте інші – нулю, і ентропія прийняла б нульове значення. Це означало б, що система повністю впорядкована, або, що те саме – у системі відсутня різноманітність за оцінюваною ознакою (колір).

Друга функція (4.11) вимірює невпорядкованість (різноманітність) у системі дещо інакше. Відмінність цих двох функцій можна ілюструвати наведеним нижче прикладом. Якщо камеру розділити на дві частини, то при досить великій кількості куль у ній частка куль i-го типу в кожній з двох частин залишиться колишньою, але число куль зменшиться вдвічі, також вдвічі зменшиться невпорядкованість, що оцінюється формулою (4.11). Однак ступінь невпорядкованості для кожної з двох частин, що оцінюється функцією (4.10), залишиться незмінною.

За аналогією з розглянутим прикладом формулою (4.11) можна оцінювати невпорядкованість потоку суміші будь-яких речовин. У цьому випадку – концентрація i-го компонента у мольних частках; N- Витрата потоку або число молекул, що проходить через деякий переріз в одиницю часу. Оскільки число Nу практичних завданнях завжди дуже велике, можна перейти до іншого масштабу для ентропії. Наприклад, поділивши ліву та праву частини на число Авогадро, отримаємо

де F- Витрата потоку, кмоль / од. часу. Позначення ентропії у новому масштабі залишено тим самим.

Таким чином, ентропія оцінює різноманітність елементів у системі за деякою певною ознакою, яка може нас цікавити в тій чи іншій задачі; см п. 4.6 та 4.7.

Звернемо увагу, що вираз (4.10) з точністю до множника збігається з термодинамічний вираз для мольної ентропії змішування ідеального газу

S = -R, (4.13)

де R - газова постійна.

На цьому прикладі можна помітити зв'язок інформаційної ентропії, запровадженої у попередніх розділах без використання будь-яких фізичних принципів, із термодинамікою. Тут корисно також відзначити як зовнішню, структурну аналогію. Ентропія змішування (4.13) це тільки ентропія термодинамічно і д а л ь н ної суміші. При розгляді камери з кулями були прийняті деякі обмеження, наприклад, вимога рівних розмірів куль.

Ентропію, записану через ймовірності, часто називають функціональною, на відміну ентропії, вираженої через молитовні частки, яку називають атрибутивною.

4.5.Связь інформаційної ентропії з фізикою.Поняття ентропії вперше було введено в термодинаміку Клаузисом як співвідношення, що зв'язує елементарне збільшення ентропії. dSз елементарною кількістю теплоти dQпри температурі Т

dS = dQ/T(4.14)

Цей вислів мало говорить про фізичну сутність ентропії. У фізиці неодноразово робилися спроби розкрити зміст цього поняття, керуючись модельними уявленнями.

Ентропія Больцмана.Розглянемо засноване на статистичному підході відоме рівняння Больцмана

де k B- Постійна Больцмана, k B=1,3810Дж/К;W– число мікростанів.

Щоб зрозуміти сутність статистичних методів як початкового прикладу розглянемо газ, як ансамбль великої кількості часток. Перше, що здається необхідно зробити при побудові математичної моделі поведінки частинок, це спробувати записати рівняння руху для кожної з них, адже газ, принаймні в першому наближенні, є системою частинок, що рухаються за законами механіки Ньютона.

Однак при такому підході кількість рівнянь стає неймовірно великою, не кажучи вже про те, що для інтегрування цих рівнянь необхідні початкові швидкості та координати кожної молекули. Тим не менш, такий шлях не тільки складний, а й безплідний, оскільки знання траєкторій та закону руху окремих молекул виявляється не дає жодної інформації щодо властивостей газу в цілому. Справа в тому, що в системі, що складається з багатьох частинок, виникають нові, суто статистичні системні або інтегративні закономірності, яких не було в системі з малим числом частинок.

Простежимо на дуже спрощеній моделі, як з'являються нові властивості, пов'язані з поняттям ентропії Больцмана.

Для наочності візьмемо систему лише з десяти частинок ( N=10), розподілених на чотирьох енергетичних рівнях, що мають відносні величини енергії 1, 2, 3 та 4. Загальна енергія системи дорівнює 20 відносним одиницям. Завдання у тому, щоб висловити деякі міркування щодо стану, яке прийме система, надана собі, тобто. щодо того, як розподіляться частки за рівнем енергії.

Для цього з'ясуємо, які енергетичні розподіли частинок можливі. При цьому розрізнятимемо зміни мікро- та макростану системи. Якщо відбулася зміна частот на якомусь енергетичному рівні, то говоритимемо про зміну макростанусистеми. Якщо ж відбувся тільки обсяг часток між енергетичними рівнями, але число частинок на кожному рівні енергії залишилося колишнім, будемо фіксувати зміну мікростанусистеми. Для зовнішнього спостерігача, який стежить лише за макростанами системи, зміни мікроскопічного характеру виявляться непоміченими, а мікростани невиразні. Один макростан може бути реалізований за допомогою дуже багатьох мікростанів.

Так, один з можливих макростанів в системі, що розглядається, з десяти частинок така: на першому енергетичному рівні знаходиться одна частка ( N 1 = 1), на другому розташовуються вісім частинок ( N 2 = 8) і одна займає третій рівень ( N 3 = 1). Четвертий рівень не зайнятий. Загальна енергія дорівнює 11+82+13+ 40=20. Припустимо, що частки пронумеровані. Тоді даний макростан можна було б здійснювати різним способом (через різні мікростани), поміщаючи, наприклад, на рівень енергії 1 по черзі частинки з номером 1, 2, 3, 4, 5 і т.д., тобто. здійснюючи різні перестановки частинок, не порушуючи макростану системи.

![]() . (4.16)

. (4.16)

Тут r- Число енергетичних рівнів; у цьому прикладі r= 4.

Якщо перейти до іншого макростану, тобто. взяти інший розподіл частинок за енергетичними рівнями, наприклад, N 1 =2,N 2 =7,N 3 =0 і N4 = 1 (загальна енергія 21+72+14 = 20), то число способів здійснення даного макростануW виявляється рівним 360.

При будь-якому процесі управління та передачі відбувається перетворення вхідної інформації у вихідну. Зазвичай, під інформацією розуміють деякі відомості, символи, знаки. Статистична теорія: поняття інформації характеризується як усунення невизначений.

Інформація визначається як зведення є об'єктом зберігання, передачі та прийому. Інформація надсилається за допомогою сигналу. В основі кількісної оцінки отримання інформації лежить уявлення про передачу повідомлення як про випадковий стохастичний процес у часі.

Усувають невизначеність за допомогою випробувань, чим вища невизначеність, тим вища цінність інформації.

Ступінь невизначеності залежить від числа значень, які може набувати величина та результату подій.

За міру кількості інформації визначається випадкова величина H(А):

де  -ймовірністьвиходу.

-ймовірністьвиходу.

Знак мінус стоїть як компенсація H(А)-це ентропія досвіду А (формулу вигадав Клод Шинон).

Чим більше H(A), тим більше міра незнання.

Чим більше H(A), тим більше міра незнання.

Накопичення відомостей про деяку систему зменшує ентропію. Інформація - це певний внесок в ентропію.

Нехай дана x-система.

якщо  , то

, то

де

де

Отримання інформації є об'єктивним відображенням стану системи і може бути використана для передачі, керування, рішення тощо.

Інформація не є матеріальною чи енергетичною категорією, вона не коли не створюється, а лише передається та приймається, але може втрачатися, зникати.

Згідно з другим законом термодинаміки ентропія збільшується паралельно з руйнуванням організованих структур прагнучи хаотичного імовірнісного стану.

За одиницю вимірювання приймається кількість інформації, що міститься в деякій випадковій величині, що приймає з рівною ймовірністю. За одиницю ступеня невизначеності приймається ентропія елементарної події, які мають два результати з однаковою ймовірністю два різні значення.

-Двійкова одиниця або біт.

-Двійкова одиниця або біт.

x-система пов'язані

y-система

I(x,y)=H(x)+H(y)-H(x,y), де

H(x, y)-ентропія об'єднаної системи.

, де,

, де,

Для безперервного сигналу.

де(x)-щільність ймовірності величиниx. Шинонський підхід не враховує семантичного змісту.

де(x)-щільність ймовірності величиниx. Шинонський підхід не враховує семантичного змісту.

33. Поняття ергодичного джерела. Надмірність.

Насправді зустрічаються ергодичні джерела, у яких кореляційні зв'язку поширюється кінцеве число попередніх джерел. В ергодичному джерелі  кореляційні зв'язки відсутні, тобто.

кореляційні зв'язки відсутні, тобто.

Математичним поданням повідомлень створюваних ергодичними джерелами є ланцюг Маркова.

Ланцюгом Маркова n-порядку називають послідовність, залежність випробувань при якій, ймовірність деякого результату  Випробування залежить від результатів, що мали місце в будь-яких попередніх випробуваннях, але не залежить від більш ранніх результатів.

Випробування залежить від результатів, що мали місце в будь-яких попередніх випробуваннях, але не залежить від більш ранніх результатів.

В ергодичному джерелі nпорядку розподілу  при k = 1,2, ..., m не залишається постійною, а залежить від того, які були останні літери повідомлень.

при k = 1,2, ..., m не залишається постійною, а залежить від того, які були останні літери повідомлень.

ймовірність вибору букви з алфавіту.

ймовірність вибору букви з алфавіту.

Число можливих станів визначається:  , де це алфавіту, n-порядок, M-число можливих станів джерела.

, де це алфавіту, n-порядок, M-число можливих станів джерела.

Для визначення повної ентропії необхідно:

якщо M=1, отримуємо класичну формулу Шинона.

Кореляційна зв'язок у ергодичному джерелі обов'язково супроводжується зміною розподілу ймовірності, вибору елемента повідомлень від стану до стану, що також призводить до зменшення ентропії, це означає, що частина інформації джерелом, що передається, може бути передбачена, отже її можна не передавати, т.к. вона може бути відновлена на приймальній стороні. Чим менша ентропія джерела, тим більше інформації він виробляє.

R-надмірність, показує ефективність роботи джерела.

Причиною R є однозначність та опеорна ймовірність вибору між повідомленнями.

Питання зв'язку між ентропією та інформацією обговорюється вже давно, фактично з часів формулювання парадоксу з «демоном Максвелла». Деякий час проблема здавалася абстрактною. Зараз, однак, вона стає актуальною, оскільки виявляється пов'язаною із цілком конкретними питаннями: яка ентропійна (і енергетична) плата за інформацію, які мінімальні розміри інформаційного осередку тощо.

Ці питання набувають особливої гостроти у зв'язку з біологічною специфікою. По-перше, інформаційні системи в живій природі мають малі (мікроскопічні) розміри. По-друге, вони функціонують за нормальної температури, т. е. за умов, коли теплові флуктуації не зневажливо малі. -третє, в біології особливу важливість набуває запам'ятовування та зберігання інформації. Зазначимо, що у техніці більш актуальні проблеми передачі; на прикладі оптимізації передачі розроблено основні положення теорії інформації. А питанням рецепції та зберігання інформації приділялося менше уваги. У біології, навпаки, ці питання стають першорядними.

Не претендуючи на суворе визначення поняття «інформація», наголосимо на двох необхідних її атрибутах: 1) інформація передбачає вибір одного (або кількох) варіантів з багатьох можливих, 2) зроблений вибір має бути запам'ятаний. Підкреслимо: друга умова – запам'ятовування інформації – є дуже важливою. Вперше на це звернув увагу Кастлер [П26] у 1960. р. У процесах передачі «запам'ятовуваність» відіграє меншу роль, ніж при рецепції, обробці та зберіганні інформації. Дійсно, передавальна система має запам'ятати інформацію лише тимчасово передачі, що у принципі то, можливо коротким. У біології умова запам'ятовування тривалий термін, навпаки, грає значної ролі.

Кількість інформації називають величину

![]()

де повна кількість можливих варіантів, число обраних варіантів. Кількість інформації відмінно від нуля, якщо відомо, що з якихось причин з апріорних варіантів реалізувався один із варіантів (але не відомо, який саме). Ця кількість максимально, якщо відомо, що реалізувався (обраний) один певний варіант. Величина якщо

Нічого не відомо. Підстава логарифму (тобто двійкова система) вибрано для зручності; одиницею інформації у цій системі є один біт; він відповідає вибору одного варіанта із двох можливих.

Вираз (12.8) легко узагальнюється на випадок, коли a priori N варіантів можуть реалізуватися з ймовірностями а реалізуються a posteriori з ймовірностями

Вибір або реалізація апостеріорних варіантів може здійснюватися двома різними способами; або в результаті дії сторонніх сил - у цьому випадку говорять про рецепцію інформації від іншої (сторонньої) системи, або спонтанно, внаслідок нестійкої поведінки самої системи - у цьому випадку має місце народження (виникнення) нової інформації.

Інформаційна система повинна бути здатною: а) рецептувати інформацію; б) зберігати або, що те, запам'ятовувати інформацію; в) видавати інформацію при взаємодії з іншою, акцепторною по відношенню до аналізованої, системою. Звідси випливає, що інформаційна система має бути мультистаціонарною.

Число стійких стаціонарних станів визначає інформаційну ємність, тобто максимальну кількість інформації, яку система може рецептувати:

![]()

Система має бути дисипативною. Це означає, що речові частини всіх характеристичних чисел стаціонарних станів негативні; це є необхідною умовою запам'ятовування інформації. Прикладом такої системи може бути китайський більярд. Він є кулькою на дошці з бортами, лунками і штирями. Приналежність кульки до певної лунки є інформацією про стан системи.

На мікроскопічному (молекулярному) рівні проблема конструкції інформаційної системи стає не тривіальною. По-перше, у мультистаціонарній системі кожна з фазових траєкторій розташовується лише певної частини фазового простору (в області тяжіння даного стану). Весь фазовий об'єм недоступний кожній із траєкторій. Це означає, що інформаційна система не є повністю зргодичною і термодинамічно рівноважною. Повинні існувати виділені ступені свободи, які протягом тривалого часу зберігають свої значення, а не перебирають усі можливі.

Пояснимо це на прикладі китайського більярду. Виділеними ступенями свободи тут є координати кульки. Зміна х та у обмежена краями лунок; кулька не може переміститися в іншу лунку без втручання. При цьому

інші ступеня свободи, пов'язані з коливаннями атомів як кульки, і дошки, можуть (і далі повинні) бути ергодичними.

По-друге, умова диссипативності, як ми бачили, пов'язана з нестійкістю (і звідси хаотичністю) мікроскопічних рухів. Це означає, відповідні ступеня свободи би мало бути ергодичними. Таким чином, фазовий простір інформаційної системи має бути розшарований на ергодичну та динамічну підсистеми. Однак таке розшарування не можна здійснити абсолютно суворо, різні ступені свободи завжди пов'язані один з одним. Це проявляється в тому, що динамічні (інформаційні) ступеня свободи флуктуюють і існує деяка ймовірність їхньої радикальної зміни (наприклад, перекидання кульки в іншу лунку) під впливом ергодичної підсистеми (тобто теплових флуктуацій).

У макроскопічних інформаційних системах ця ймовірність дуже мала, проте в мікроскопічних системах її потрібно враховувати. Таким чином, умови мультистаціонарності та дисипативності не можуть бути виконані одночасно абсолютно суворо; вони є додатковими. Це означає, що умова «запам'ятовування» може бути абсолютним, можна говорити про запам'ятовуванні з певною ймовірністю на певне (не нескінченно велике) час. Інакше кажучи, інформаційна система неспроможна пам'ятати вічно. У реальних інформаційних системах характерний час запам'ятовування залежить від їхньої конструкції, температури та вільної енергії.

Питання про зв'язок між ентропією та інформацією у світлі викладеного виявляється не тривіальним. Фізична ентропія є логарифм фазового обсягу, доступного для системи (з урахуванням умовності цього поняття - див. вище), виміряного в одиницях де число ступенів свободи і розмір мінімального (квантового) осередку фазового простору. Формально ентропія може бути подана у вигляді

Розмір є ентропією, виміряної в бітах; число осередків фазового простору. З іншого боку, інформаційна ємність може бути записана у формі

де розмір фазового простору одного інформаційного осередку. Зіставлення формул (12.11) і (12.12) показує, що ентропія та інформація відрізняються як коефіцієнтом, так і розміром комірки.

Збіг (12.11) і (12.12) формою послужило основою твердження про тотожність понять інформації та ентропії. Точніше, стверджується, що ентропія є недостатня інформація про стан системи та (або) інформація є недостатня ентропія, тобто різниця між максимальною ентропією, якою

мала б систему без інформації, і реальну ентропію, яку система має, володіючи отриманою інформацією. У зв'язку з цим використовується термін негоентропія, який вважається тотожною інформацією.

Багатьох, однак, ці твердження не задовольняють і питання зв'язку інформації та ентропії залишається дискусійним.

Обговоримо питання детальніше.

Насамперед впадає у вічі велика кількісна різниця між інформацією, укладеної у системі, та її ентропією.

Блюменфельд (див. [П61) на ряді біологічних прикладів (клітина, організм і т. д.) показав, що ентропія, що міститься в об'єкті, у багато разів (на кілька порядків) перевищує наявну в ньому інформацію. Різниця ще більша у сучасних неживих інформаційних системах (наприклад, у друкованому тексті ентропія перевищує інформацію приблизно у 1010 разів).

Така велика кількісна різниця не випадкова. Вона пов'язана з тим, що обсяг фазового простору інформаційного осередку великий у порівнянні з величиною Останнє зумовлено тим, що інформаційний осередок повинен містити ергодичну підсистему і, отже, займати великий (порівняно з елементарним осередком) обсяг.

Таким чином, різниця масштабів ентропії та інформації не випадкова, а пов'язана з їхньою принциповою відмінністю. Ентропія - це міра безлічі тих станів системи, про перебування у яких система має забути; інформація - міра безлічі тих станів, перебування яких система повинна пам'ятати.

Подивимося, як пов'язані зміни ентропії та інформації на прикладі китайського більярду. Обмежимо розгляд часом існування системи. Справа в тому, що будь-яка інформаційна система, будучи нерівноважною, за структурними ступенями свободи релаксує та руйнується, тобто перестає бути інформаційною.

Час структурної релаксації більший (або дорівнює) часу запам'ятовування. У нашому прикладі йдеться про спонтанне руйнування бар'єрів між лунками; характерний час цього досить великий. Протягом цього часу структурні ступеня свободи не змінюються, отже, і не роблять вкладу в ентропію. (Частина фазового простору, пов'язана з цими ступенями свободи, у цей час є недоступною.) Ентропія при цьому пов'язана лише зі ступенями свободи, які швидко релаксують. Їхня поведінка не залежить від того, в якій з лунок знаходиться кулька і покладена вона в якусь лунку або лежить навколо. Фізична ентропія системи у всіх випадках однакова, проте кількість інформації по-різному: вона дорівнює нулю, якщо кулька не покладено в лунку, і якщо вона лежить у певній лунці.

Процес рецепції інформації (у разі - приміщення кульки в певну лунку) вимагає витрати роботи що у тепло (інакше рецепція була б незворотною). Отже, при рецепції фізична ентропія системи збільшується (на величину та одночасно

збільшується інформація (на величину Зазвичай, але в іншому вони ніяк не пов'язані. Таким чином, при рецепції інформації співвідношення не дотримується.

Дещо складніша ситуація у разі виникнення нової інформації. Система, здатна народжувати інформацію, повинна мати всі властивості інформаційної і, крім того, задовольняти умові: певний шар її фазового простору повинен бути зргодичним, включаючи виділені (інформаційні) ступеня свободи. Саме в цьому випадку задаються початкові умови за спонтанного виникнення інформації.

Прикладом може бути той же китайський більярд зі штирьками. Якщо спочатку кінетична енергія кульки досить велика (більше бар'єрів між лунками), то кулька рухається всією дошкою, не застряючи в лунках. Через нестійкість відбиття від шпильок (вони відіграють роль увігнутих поверхонь у більярді Сінаю, рис. 12.2) рух кульки стохастичний і початкові умови швидко забуваються. При зменшенні кінетичної енергії (через дисипативність системи, в даному випадку через тертя та зіткнення) до величини порядку висоти бар'єру кулька потрапляє в область тяжіння однієї з лунок і залишається в ній. Таким чином, обраний стан «запам'ятовується», що є народженням інформації. Той самий принцип використовується в рулетці та інших ігрових машинах.

У всіх цих випадках критерієм відокремлення ергодичного шару початкових умов від інформаційного шару є величина початкової вільної енергії (у більярді це кінетична енергія кульки). Вона визначає і приріст ентропії системи у процесі народження інформації. Оцінимо величину Якщо інформаційна ємність системи мала: головним обмеженням знизу є умова де бар'єр між лунками. Бар'єри визначають час «запам'ятовування» відповідно до співвідношення

При досить великій (макроскопічній) величині бар'єр становить

Таким чином, у цьому випадку збільшення ентропії, що припадає на один біт інформації, дорівнює

або в інформаційних одиницях:

У випадку, коли інформаційна ємність велика (тобто потрібно врахувати іншу умову: до того, як «вибрано» певний стан, система повинна побувати хоча б раз у сфері впливу кожного з можливих станів.

Нехай при проходженні кожного із станів дисипує енергія Мінімальна величина порядку енергії теплових флуктуацій: При цьому обмежена умовою знизу

Приріст ентропії на один біт інформації при цьому дорівнює

Таким чином, у разі виникнення інформації за неї потрібно «платити» збільшенням ентропії, таким, що Однак співвідношення типу «приріст інформації дорівнює убутку ентропії» і в даному випадку немає місця.

Обговоримо ситуацію, яка виникає, якщо відмовитись від умови запам'ятовування інформації. У цьому випадку можна говорити про інформацію про миттєві значення координат та імпульсів всіх атомів системи. Щоб відрізнити цю «інформацію» від справжньої (запам'ятовується), Лайзер запропонував термін мікроінформація, що запам'ятовується, при цьому називається макроінформацією.

Якщо відомо, що в даний момент система знаходиться в одному (з можливих) певному осередку фазового простору, то кількість мікроінформації максимально і дорівнює

![]()

Ентропія системи при цьому дорівнює нулю, оскільки всі інші осередки зараз можна вважати «недоступними».

Якщо відомо, що в даний момент система знаходиться в будь-якому з можливих осередків, але невідомо, в якій, то мікроінформація дорівнює нулю, а ентропія максимальна і дорівнює

Якщо відомо, що в даний момент система знаходиться в одному (будь-якому) з осередків то

і між мікроінформацією та ентропією має місце просте співвідношення:

Мікроінформація, в принципі, може бути перетворена на макроінформацію шляхом рецепції її іншою інформаційною системою. Наприклад, шляхом фотографування картини броунівського руху миттєві координати частинок можуть бути відбиті (запам'ятані) на фотоплівці. Ця інформація потім може використовуватися для будь-яких (навіть не пов'язаних з рухом частинок)

цілей. Важливо, що при цьому в процесі рецепції (перетворення мікроінформації на макро- повинна бути витрачена робота та підвищена ентропія всієї системи на величину, що явно перевищує кількість запам'ятованої інформації).

Саме цей процес – перетворення мікроінформації на макро- та використання її для управління – лежить в основі парадоксу з «демоном Максвелла». Дозвіл його в тому, що процес рецепції мікроінформації та використання її для управління супроводжується збільшенням ентропії всієї системи/переважає інформацію.

У зв'язку з настільки суттєвою різницею між мікро- та макроінформацією використовується також і два поняття ентропії. Поряд із фізичною ентропією використовується інформаційна ентропія, яка визначається як

![]()

де число стаціонарних стійких макростанів, про які відомо, що система знаходиться в одному з них (але невідомо, в якому саме).

Відповідно до визначення, інформаційна ентропія пов'язана з інформацією співвідношенням

Збільшення інформації (при збереженні при цьому завжди супроводжується рівним зменшенням інформаційної ентропії. Термін Інформаційна ентропія зручно використовувати, коли йдеться про виникнення інформації та упорядкування системи. Саме в цьому сенсі він вживається в гл. 2. Підкреслимо, що з фізичною ентропією ця величина, взагалі кажучи, не пов'язана.

Отже, основою відмінності фізичної ентропії та інформації (як якісно, так і кількісно) є умова запам'ятовування та обумовлений цим великий обсяг фазового простору інформаційного осередку порівняно з елементарним.

Цікавить оцінити величину «запасу». Зробити це загалом зараз важко. Можна думати, однак, що в живій природі реалізувався оптимальний розмір (тобто мінімальний, але відповідний вимогам). Його можна оцінити, використовуючи фактичні дані.

У молекулі ДНК осередком, що містить два біти інформації, є пара комплементарних нуклеотидів. Вона містить близько атомів. Ентропія, пов'язана з коливальними ступенями свободи, становить біт, або ентропія, що припадає на один біт інформації, дорівнює приблизно 60 біт. Звідси обсяг фазового простору, що припадає на один біт, дорівнює

Концепція Ентропії

вперше введено у 1865 р. Клаузіусом у термодинаміці для визначення заходу незворотного розсіювання енергії. Ентропія застосовується у різних галузях науки, зокрема й теорії інформації як міра невизначеності будь-якого досвіду, випробування, що може мати різні результати. Ці визначення ентропії мають глибокий внутрішній зв'язок. Так, на основі уявлень про інформацію можна вивести всі найважливіші положення статистичної фізики. [БЕС. фізика. М: Велика російська енциклопедія, 1998].

Ця величина також називається середньою ентропієюповідомлення. Ентропія у формулі Шеннона є середньою характеристикою - математичним очікуванням розподілу випадкової величини.

Наприклад, у послідовності літер, що становлять якусь пропозицію російською, різні літери з'являються з різною частотою, тому невизначеність появи для деяких літер менша, ніж для інших.

У 1948 році, досліджуючи проблему раціональної передачі інформації через зашумлений комунікаційний канал, Клод Шеннон запропонував революційний імовірнісний підхід до розуміння комунікацій і створив першу, справді математичну теорію ентропії. Його сенсаційні ідеї швидко стали основою розробки теорії інформації, яка використовує поняття ймовірності. Поняття ентропії, як міри випадковості, введено Шенноном у його статті «A Mathematical Theory of Communication», опублікованій у двох частинах Bell System Technical Journal в 1948 році.

У випадку рівноймовірних подій (приватний випадок), коли всі варіанти рівноймовірні, залишається залежність тільки від кількості варіантів, що розглядаються, і формула Шеннона значно спрощується і збігається з формулою Хартлі, яка вперше була запропонована американським інженером. Ральфом Хартліу 1928 році, як один із наукових підходів до оцінки повідомлень:

, де I – кількість інформації, що передається, p – ймовірність події, N – можлива кількість різних (рівноймовірних) повідомлень.Завдання 1. На ймовірні події.

У колоді 36 карт. Яка кількість інформації міститься в повідомленні, що з колоди взято картку з портретом “туз”; "Туз пік"?

Імовірність p1 = 4/36 = 1/9, а p2 = 1/36. Використовуючи формулу Хартлі, маємо:

Відповідь: 3.17; 5.17 біт

Зауважимо (з другого результату), що з кодування всіх карт, необхідно 6 біт.

З результатів також ясно, що чим менша ймовірність події, тим більше інформації вона містить. (Ця властивість називається монотонністю)

Завдання 2. На нерівноймовірні події

У колоді 36 карт. З них 12 карток з “портретами”. Почергово з колоди дістається і показується одна з карт для визначення, чи зображено на ній портрет. Карта повертається у колоду. Визначити кількість інформації, що передається щоразу, при показі однієї картки.

Кількість інформації

Вступ

2. Невизначеність, кількість інформації та ентропія

3. Формула Шеннона

4. Формула Хартлі

5. Кількість інформації, одержуваної у процесі повідомлення

Список використаної літератури

Вступ

За визначенням А.Д. Урсула – «інформація є відбитим розмаїттям». Кількість інформації є кількісною мірою різноманітності. Це може бути різноманітність сукупного вмісту пам'яті; різноманітність сигналу, сприйнятого у процесі конкретного повідомлення; різноманітність результатів конкретної ситуації; розмаїтість елементів деякої системи… - це оцінка розмаїття найширшому значенні слова.

Будь-яке повідомлення між джерелом та приймачем інформації має деяку тривалість у часі, але кількість інформації сприйнятої приймачем в результаті повідомлення, характеризується в результаті зовсім не довжиною повідомлення, а різноманітністю сигналу породженого в приймачі цим повідомленням.

Пам'ять носія має деяку фізичну ємність, у якій вона здатна накопичувати образи, і кількість накопиченої у пам'яті інформації, характеризується у результаті саме розмаїттям заповнення цієї ємності. Для об'єктів неживої природи це різноманітність їхньої історії, для живих організмів це різноманітність їхнього досвіду.

Різноманітність необхідна під час передачі інформації. Не можна намалювати білим по білому, одного стану недостатньо. Якщо комірка пам'яті здатна перебувати тільки в одному (вихідному) стані і не здатна змінювати свій стан під зовнішнім впливом, це означає, що вона не здатна сприймати та запам'ятовувати інформацію. Інформаційна ємність такого осередку дорівнює 0.

Мінімальна різноманітність забезпечується наявністю двох станів. Якщо осередок пам'яті здатна, залежно від зовнішнього впливу, приймати один із двох станів, які умовно позначаються зазвичай як «0» і «1», вона має мінімальну інформаційну ємність.

Інформаційна ємність однієї комірки пам'яті, здатної перебувати у двох різних станах, прийнята за одиницю виміру кількості інформації - 1 біт.

1 біт (bit - скорочення від англ. binary digit - двійкове число) - одиниця виміру інформаційної ємності та кількості інформації, а також ще однієї величини - інформаційної ентропії, з якою ми познайомимося пізніше. Біт, одна з найбезумовніших одиниць виміру. Якщо одиницю виміру довжини можна було покласти довільною: лікоть, фут, метр, то одиниця виміру інформації було по суті ніякої інший.

На фізичному рівні біт є осередком пам'яті, яка в кожний момент часу знаходиться в одному з двох станів: "0" або "1".

Якщо кожна точка деякого зображення може бути тільки чорною, або білою, таке зображення називають бітовим, тому що кожна точка являє собою комірку пам'яті ємністю 1 біт. Лампочка, яка може або горіти, або не горіти також символізує біт. Класичний приклад, що ілюструє 1 біт інформації - кількість інформації, що отримується в результаті підкидання монети - "орел" або "решка".

Кількість інформації, що дорівнює 1 біту, можна отримати у відповіді на запитання типу «так»/ «ні». Якщо спочатку варіантів відповідей було більше двох, кількість одержуваної конкретної відповіді інформації буде більше, ніж 1 біт, якщо варіантів відповідей менше двох, тобто. одне, це питання, а твердження, отже, отримання інформації не потрібно, якщо невизначеності немає.

Інформаційна ємність осередку пам'яті, здатної приймати інформацію, може бути менше 1 біта, але кількість одержуваної інформації то, можливо і менше, ніж 1 біт. Це відбувається тоді, коли варіанти відповідей «так» і «ні» не є рівноймовірними. Нерівноймовірність у свою чергу є наслідком того, що деяка попередня (апріорна) інформація з цього питання вже є отримана, припустимо, на підставі попереднього життєвого досвіду. Таким чином, у всіх міркуваннях попереднього абзацу слід враховувати одне дуже важливе застереження: вони справедливі лише для рівноймовірного випадку.

Кількість інформації ми позначатимемо символом I, ймовірність позначається символом P. Нагадаємо, що сумарна ймовірність повної групи подій дорівнює 1.

2.Невизначеність, кількість інформації та ентропія

Основоположник теорії інформації Клод Шеннон визначив інформацію як зняту невизначеність. Точніше сказати, отримання інформації – необхідна умова для зняття невизначеності. Невизначеність виникає у ситуації вибору. Завдання, що вирішується під час зняття невизначеності - зменшення кількості аналізованих варіантів (зменшення різноманітності), й у результаті вибір однієї відповідної ситуації варіанти у складі можливих. Зняття невизначеності дає можливість приймати обґрунтовані рішення та діяти. У цьому роль інформації.

Ситуація максимальної невизначеності передбачає наявність кількох рівноймовірних альтернатив (варіантів), тобто. жоден з варіантів не є кращим. Причому, що більше рівноймовірних варіантів спостерігається, то більше вписувалося невизначеність, тим складніше зробити однозначний вибір і тим більше інформації потрібно при цьому отримати. Для варіантів N ця ситуація описується наступним розподілом ймовірностей: (1/N, 1/N, … 1/N).

Мінімальна невизначеність дорівнює 0, тобто. ця ситуація повної визначеності, що означає, що вибір зроблено, і вся необхідна інформація отримана. Розподіл імовірностей для повної визначеності виглядає так: (1, 0, …0).

Величина, що характеризує кількість невизначеності в теорії інформації, позначається символом H і має назву ентропія, точніше інформаційна ентропія.

Ентропія (H) – міра невизначеності, виражена в бітах. Також ентропію можна як міру рівномірності розподілу випадкової величини.

Мал. 1. Поведінка ентропії

для двох альтернатив.

На малюнку 1. показано поведінку ентропії для двох альтернатив, при зміні співвідношення їх ймовірностей (p, (1-p)).

Максимального значення ентропія досягає у разі тоді, коли обидві ймовірності рівні між собою і рівні?, нульове значення ентропії відповідає випадкам (p0=0, p1=1) і (p0=1, p1=0).

Мал. 2. Зв'язок між ентропією та кількістю інформації.

Кількість інформації I та ентропія H характеризують ту саму ситуацію, але з якісно протилежних сторін. I - це кількість інформації, яка потрібна для зняття невизначеності H. За визначенням Леона Бріллюена інформація є негативною ентропією (негентропією).

Коли невизначеність знята повністю, кількість отриманої інформації I дорівнює існувала невизначеності H.

При частковому знятті невизначеності, отримана кількість інформації та невизначеність, що залишилася незнятою, становлять у сумі вихідну невизначеність. Ht+It=H.

З цієї причини формули, які будуть представлені нижче для розрахунку ентропії H є формулами для розрахунку кількості інформації I, тобто. коли йдеться повне зняття невизначеності, H у яких може замінюватися на I.

3. Формула Шеннона

У випадку, ентропія H і кількість одержуваної результаті зняття невизначеності інформації I залежить від вихідного кількості аналізованих варіантів N і апріорних ймовірностей реалізації кожного їх P: (p0, p1, …pN-1), тобто. H=F(N, P). Розрахунок ентропії у разі проводиться у разі формулі Шеннона, запропонованої їм у 1948 року у статті " Математична теорія зв'язку " .

У окремому випадку, коли всі варіанти рівноймовірні, залишається залежність лише від кількості аналізованих варіантів, тобто. H = F (N). І тут формула Шеннона значно спрощується і збігається з формулою Хартлі, яка була запропонована американським інженером Ральфом Хартлі в 1928 року, тобто. на 20 років раніше.

Формула Шеннона має такий вигляд:

Мал. 3. Знаходження логарифму b на підставі a - це знаходження ступеня, в який потрібно звести a, щоб отримати b.

Нагадаємо, що таке логарифм.

Логарифм на підставі 2 називається двійковим:

log2(8)=3 => 23=8

log2(10)=3,32 => 23,32=10

Логарифм на підставі 10 -називається десятковим:

log10 (100) = 2 => 102 = 100

Основні властивості логарифму:

1. log (1) = 0, т.к. будь-яке число в нульовому ступені дає 1;

2. log(ab)=b*log(a);

3. log(a*b)=log(a)+log(b);

4. log(a/b)=log(a)-log(b);

5. log(1/b)=0-log(b)=-log(b).

Знак мінус у формулі (1) не означає, що ентропія – негативна величина. Пояснюється це тим, що pi1 за визначенням, а логарифм числа меншої одиниці – величина негативна. За властивістю логарифму, тому цю формулу можна записати і у другому варіанті, без мінусу перед знаком суми.

інтерпретується як окрему кількість інформації, одержуване у разі реалізації i-ого варіанта. Ентропія у формулі Шеннона є середньою характеристикою – математичним очікуванням розподілу випадкової величини (I0, I1, … IN-1).

Приклад розрахунку ентропії за формулою Шеннона. Нехай у деякій установі склад працівників розподіляється так: ? - Жінки, ? - Чоловіки. Тоді невизначеність, наприклад, щодо того, кого ви зустрінете першим, зайшовши до закладу, буде розрахована низкою дій, показаних у таблиці 1.

Таблиця 1.

Ii = log2 (1 / pi), біт

pi*log2(1/pi), біт

Якщо ж апріорі відомо, що чоловіків і жінок в установі порівну (два рівноймовірні варіанти), то при розрахунку за тією ж формулою ми повинні отримати невизначеність в 1 біт. Перевірку цього припущення проведено в таблиці 2.

Таблиця 2.

Ii = log2 (1 / pi), біт

pi*log2(1/pi), біт

4.Формула Хартлі

Формула Хартлі - окремий випадок формули Шеннона для рівноймовірних альтернатив.

Підставивши в формулу (1) замість pi його (у рівноймовірному випадку не залежить від i) значення, отримаємо:

таким чином, формула Хартлі виглядає дуже просто:

З неї явно випливає, що чим більша кількість альтернатив (N), тим більша невизначеність (H). Ці величини пов'язані у формулі (2) не лінійно, а через двійковий логарифм. Логарифмування на підставі 2 і наводить кількість варіантів до одиниць вимірювання інформації - біт.

Ентропія буде цілим числом лише тому випадку, якщо N є ступенем числа 2, тобто. якщо N належить ряду: (1, 2, 4, 8, 16, 32, 64, 128, 256, 512, 1024, 2048…)

Мал. 3. Залежимо ентропії кількості рівноймовірних варіантів вибору (рівнозначних альтернатив).

Для вирішення зворотних завдань, коли відома невизначеність (H) або отримана в результаті її зняття кількість інформації (I) і потрібно визначити, яка кількість рівноймовірних альтернатив відповідає виникненню цієї невизначеності, використовують зворотну формулу Хартлі, яка виводиться відповідно до визначення логарифму і виглядає ще простіше :

Наприклад, якщо відомо, що в результаті визначення того, що Коля Іванов, який нас цікавить, живе на другому поверсі, було отримано 3 біти інформації, то кількість поверхів у будинку можна визначити за формулою (3), як N=23=8 поверхів.

Якщо ж питання стоїть так: “в будинку 8 поверхів, яку кількість інформації ми отримали, дізнавшись, що Коля Іванов, який нас цікавить, живе на другому поверсі?”, потрібно скористатися формулою (2): I=log2(8)=3 біта.

5.Кількість інформації, одержуваної у процесі повідомлення

До цих пір були наведені формули для розрахунку ентропії (невизначеності) H, вказуючи, що H в них можна замінювати на I, тому що кількість інформації, що отримується при повному знятті невизначеності деякої ситуації, кількісно дорівнює початковій ентропії цієї ситуації.

Але невизначеність може бути знята лише частково, тому кількість інформації I, одержуваної з деякого повідомлення, обчислюється як зменшення ентропії, що сталося в результаті отримання повідомлення.

Для рівноймовірного випадку, використовуючи для розрахунку ентропії формулу Хартлі, отримаємо:

Друга рівність виводиться на підставі властивостей логарифму. Таким чином, у рівноймовірному випадку I залежить від того, у скільки разів змінилася кількість варіантів вибору, що розглядаються (розглянута різноманітність).

Виходячи з (5) можна вивести наступне:

Якщо, то повне зняття невизначеності, кількість отриманої в повідомленні інформації дорівнює невизначеності, яка існувала до отримання повідомлення.

Якщо, то невизначеності не змінилася, отже, інформації отримано не було.

Якщо, то => , якщо => . Тобто. кількість отриманої інформації буде позитивною величиною, якщо в результаті отримання повідомлення кількість альтернатив, що розглядаються, зменшилася, і негативною, якщо збільшилося.

Якщо кількість розглянутих альтернатив внаслідок отримання повідомлення зменшилося вдвічі, тобто. , то I = log2 (2) = 1 біт. Інакше кажучи, отримання 1 біта інформації виключає з розгляду половину рівнозначних варіантів.

Розглянемо як приклад досвід із колодою з 36 карт.

Мал. 4. Ілюстрація до досвіду з колодою з 36 карт.

Нехай хтось виймає одну картку з колоди. Нас цікавить, яку саме з 36 карток він вийняв. Початкова невизначеність, що розраховується за формулою (2), становить H = log2 (36) 5,17 біт. Витягнув карту повідомляє нам частину інформації. Використовуючи формулу (5), визначимо, скільки інформації ми отримуємо з цих повідомлень:

Варіант A. "Це карта червоної масті".

I=log2(36/18)=log2(2)=1 біт (червоних карток у колоді половина, невизначеність зменшилася вдвічі).

Варіант B. "Це карта пікової масті".

I=log2(36/9)=log2(4)=2 біта (пікові карти становлять чверть колоди, невизначеність зменшилася вчетверо).

Варіант С. "Це одна із старших карт: валет, дама, король або туз".

I=log2(36)-log2(16)=5,17-4=1,17 біта (невизначеність зменшилася більше ніж удвічі, тому отримана кількість інформації більше одного біта).

Варіант D. "Це одна карта з колоди".

I=log2(36/36)=log2(1)=0 біт (невизначеність не зменшилася - повідомлення не інформативно).

Варіант D. "Це жінка пік".

I=log2(36/1)=log2(36)=5,17 біт (невизначеність повністю знята).