Всі ми знаємо, що у відеокарти та процесора кілька різні завдання, проте чи знаєте ви, чим вони відрізняються один від одного у внутрішній структурі? Як CPU (англ. - central processing unit), так і GPU (англ. graphics processing unit) є процесорами, і з-поміж них є багато спільного, проте сконструйовані вони були до виконання різних завдань. Докладніше про це ви дізнаєтеся з цієї статті.

CPU

Основне завдання CPU, якщо говорити простими словами, виконання ланцюжка інструкцій за максимально короткий час. CPU спроектований таким чином, щоб виконувати декілька таких ланцюжків одночасно або розбивати один потік інструкцій на кілька і після виконання їх окремо зливати їх знову в одну, в правильному порядку. Кожна інструкція в потоці залежить від наступних за нею, і саме тому в CPU так мало виконавчих блоків, а весь наголос робиться на швидкість виконання та зменшення простоїв, що досягається за допомогою кеш-пам'яті та конвеєра.

GPU

Основна функція GPU - рендеринг 3D графіки та візуальних ефектів, отже, в ньому все трохи простіше: йому необхідно отримати на вході полігони, а після проведення над ними необхідних математичних та логічних операцій на виході видати координати пікселів. По суті, робота GPU зводиться до оперування над величезною кількістю незалежних між собою завдань, отже, він містить великий обсяг пам'яті, але не такої швидкої, як у CPU, і величезна кількість виконавчих блоків: у сучасних GPU їх 2048 і більше, на той час як у CPU їх кількість може досягати 48, але найчастіше їхня кількість лежить у діапазоні 2-8.

Основні відмінності

CPU відрізняється від GPU насамперед способами доступу до пам'яті. У GPU він пов'язаний і легко передбачуваний - якщо з пам'яті читається текстури текстури, то через деякий час настане черга і сусідніх текстилів. Із записом схожа ситуація - піксель записується у фреймбуфер, і через кілька тактів записуватиметься розташований поруч із ним. Також графічному процесору, на відміну від універсальних процесорів, просто не потрібна кеш-пам'ять великого розміру, а для текстур потрібно лише 128–256 кілобайт. Крім того, на відеокартах застосовується швидша пам'ять, і в результаті GPU доступна в рази більша пропускна здатність, що також дуже важливо для паралельних розрахунків, що оперують з величезними потоками даних.

Існує безліч відмінностей і в підтримці багатопоточності: CPU виконує 1 – 2 потоки обчислень на одне процесорне ядро, а GPU може підтримувати кілька тисяч потоків на кожен мультипроцесор, яких у чіпі кілька штук! І якщо перемикання з одного потоку на інший для CPU коштує сотні тактів, то GPU перемикає кілька потоків за один такт.

У CPU більша частина площі чіпа зайнята під буфери команд, апаратне передбачення розгалуження і величезні обсяги кеш-пам'яті, а GPU більша частина площі зайнята виконавчими блоками. Вищеописаний пристрій схематично зображено нижче:

Різниця у швидкості обчислень

Якщо CPU - це свого роду "начальник", який приймає рішення відповідно до вказівок програми, то GPU - це "робочий", який виробляє величезну кількість однотипних обчислень. Виходить, що якщо подавати на GPU незалежні найпростіші математичні завдання, він справиться значно швидше, ніж центральний процесор. Даною відмінністю успішно користуються майнери біткоїнів.

Майнінг Bitcoin

Суть майнінгу у тому, що комп'ютери, що у різних точках Землі, вирішують математичні завдання, у яких створюються биткоины . Усі біткоін-переклади по ланцюжку передаються майнерам, чия робота полягає в тому, щоб підібрати з мільйонів комбінацій один-єдиний хеш, що підходить до всіх нових транзакцій і секретного ключа, який і забезпечить майнеру нагороду в 25 біткоїнів за раз. Оскільки швидкість обчислення залежить від кількості виконавчих блоків, виходить, що GPU значно краще підходять для виконання даного типу завдання, ніж CPU. Чим більша кількість вироблених обчислень, тим вищий шанс отримати біткоїни. Справа навіть дійшла до спорудження цілих ферм із відеокарт.

Сучасні відеокарти, в силу вимог від них величезної обчислювальної потужності під час роботи з графікою, оснащуються своїм власним команднимцентром, інакше кажучи – графічним процесором.

Це було зроблено для того, щоб «розвантажити» центральний процесор, який через свою широку «сферу застосування» просто не в змозі справлятися з вимогами, які висуває сучасна.ігрова індустрія.

Графічні процесори (GPU) за складністю абсолютно не поступаються центральним процесорам, але через свою вузьку спеціалізацію, в змозі більш ефективно справлятися із завданням обробки графіки, побудовою зображення, з наступним виведенням його на монітор.

Якщо говорити про параметри, то вони у графічних процесорів дуже схожі на центральні процесори. Це вже відомі всім параметри, такі як мікроархітектура процесора, тактова частотароботи ядра, техпроцес виробництва. Але вони мають і досить специфічні характеристики. Наприклад, важлива характеристика графічного процесора – це кількість піксельних конвеєрів (Pixel Pipelines). Ця характеристика визначає кількість пікселів, що обробляються, за один такт роботи GPU. Кількість даних конвеєрів може відрізнятися, наприклад, у графічних чіпах серії Radeon HD 6000, їхня кількість може досягати 96.

Піксельний конвеєр займається тим, що прораховує кожен наступний піксель чергового зображення з урахуванням його особливостей. Для прискорення процесу прорахунку використовується кілька паралельно працюючих конвеєрів, які прораховують різні пікселі того самого зображення.

Також, кількість піксельних конвеєрів впливає на важливий параметр – швидкість заповнення відеокарти. Швидкість заповнення відеокарти можна розрахувати, помноживши частоту ядра на кількість конвеєрів.

Розрахуємо швидкість заповнення, наприклад, для відеокарти AMD Radeon HD 6990 (Рис.2)Частота ядра GPU цього чіпа становить 830 МГц, а кількість піксельних конвеєрів – 96. Нехитрими математичними обчисленнями (830х96), ми приходимо до висновку, що швидкість заповнення дорівнюватиме 57,2 Гпіксель/c.

Мал. 2

Крім піксельних конвеєрів, розрізняють ще так званих текстурних блоків у кожному конвеєрі. Чим більше текстурних блоків, тим більше текстур може бути накладено за один прохід конвеєра, що також впливає на загальну продуктивність відеосистеми. У вищезгаданому чіпі AMD Radeon HD 6990 кількість блоків вибірки текстур становить 32х2.

У графічних процесорах можна виділити й інший вид конвеєрів – вершинні, вони відповідають за розрахунок геометричних параметрів тривимірного зображення.

Тепер, давайте розглянемо поетапний, трохи спрощений, процес конвеєрного розрахунку, з подальшим формуванням зображення:

1 - й етап.Дані про вершини текстур надходять до вершинних конвеєрів, які займаються розрахунком параметрів геометрії. На цьому етапі підключається блок T&L (Transform & Lightning). Цей блок відповідає за освітлення та трансформацію зображення у тривимірних сценах. Обробка даних у вершинному конвеєрі проходить рахунок програми вершинного шейдера (Vertex Shader).

2 - ой етап.На другому етапі формування зображення підключається спеціальний Z-буфер для відсікання невидимих полігонів і граней тривимірних об'єктів. Далі відбувається процес фільтрації текстур, для цього в «бій» вступають піксельні шейдери. У програмних інтерфейсах OpenGL або Direct3D описані стандарти для роботи з тривимірними зображеннями. Програма викликає певну стандартну функцію OpenGL або Direct3D, а шейдери цю функцію виконують.

3-ий етап.У завершальному етапі побудови зображення в конвеєрній обробці дані передаються в спеціальний буфер кадрів.

Отже, щойно ми стисло розглянули структуру і принципи функціонування графічних процесорів, інформація, звичайно, «не з легких» для сприйняття, але для загального комп'ютерного розвитку, я думаю, буде дуже корисна:)

Графічний процесор (GPU) не менш важливим компонентом SoC мобільного пристрою, ніж (CPU). За останні п'ять років бурхливий розвиток мобільних платформ Android та iOS спонукав розробників мобільних графічних процесорів, і сьогодні нікого не здивувати мобільними іграми з тривимірною графікою рівня PlayStation 2 або навіть вище. Другу статтю циклу "Лікнеп по мобільному залізу" я присвятив графічним процесорам.

В даний час більшу частину графічних чіпів виробляють за допомогою ядра: PowerVR (Imagination Technologies), Mali (ARM), Adreno (Qualcomm, раніше ATI Imageon) та GeForce ULP (nVIDIA).

PowerVR – це підрозділ компанії Imagination Technologies, яка в недавньому минулому розробляла графіку для настільних систем, але під тиском ATI та nVIDIA змушена була залишити цей ринок. Сьогодні PowerVR розробляє, мабуть, найпотужніші GPU для мобільних пристроїв. Чіпи PowerVR використовують при виробництві процесорів такі компанії, як Samsung, Apple, Texas Instruments та ін. Наприклад, різні ревізії GPU від PowerVR встановлені у всіх поколіннях Apple iPhone. Актуальними залишаються серії чіпів 5 та 5XT. До п'ятої серії відносяться одноядерні чіпи: SGX520, SGX530, SGX531, SGX535, SGX540 та SGX545. Чіпи серії 5XT можуть мати від 1 до 16 ядер: SGX543, SGX544, SGX554. Специфікації 6 серії (Rogue) поки що уточнюються, але вже відомий діапазон продуктивності чіпів серії – 100-1000GFLOPS.

Mali – це графічні процесори, що розробляються та ліцензуються британською ARM. Чіпи Mali є складовою різних SoC, вироблених Samsung, ST-Ericsson, Rockchip та ін. Наприклад, Mali-400 MP входить до складу SoC Samsung Exynos 421x, що використовуються в таких смартфонах, як Samsung Galaxy SII і SIII, у двох поколіннях "смартфонпланшетмашу" ?” Samsung Note. Актуальним на сьогодні є Mali-400 MP у дво- та чотириядерних варіантах. На підході чіпи Mali-T604 та Mali-T658, продуктивність яких до 5 разів вища, ніж у Mali-400.

Adreno – це графічні чіпи, які розробляє однойменний підрозділ американської Qualcomm. Назва Adreno є анаграмою від Radeon. До Qualcomm підрозділ належав ATI, а чіпи мали назву Imageon. Останні кілька років Qualcomm при виробництві SoC використовувала чіпи 2xx серії: Adreno 200, Adreno 205, Adreno 220, Adreno 225. Останній зі списку - зовсім свіжий чіп - виконаний за 28нм технологією, найпотужніший з Adreno 2х серії. Його продуктивність у 6 разів вища, ніж у "старого" Adreno 200. У 2013 році все більше пристроїв отримають графічні процесори Adreno 305 і Adreno 320. Вже зараз 320-й встановлений в Nexus 4 і китайську версію Nokia Lumia 920T, за деякими параметрами вдвічі потужніший за 225-й.

GeForce ULP (ultra-low power) - мобільна версія відео-чіпа від nVIDIA, входить до складу системи-на-кристалі Tegra всіх поколінь. Однією з найважливіших конкурентних переваг Tegra є спеціалізований контент, призначений лише для пристроїв на основі цієї SoC. У nVIDIA традиційно тісний зв'язок із розробниками ігор, і їхня команда Content Development працює разом з ними для того, щоб оптимізувати ігри для графічних рішень GeForce. Для доступу до таких ігор nVIDIA навіть запустила Android-програму Tegra Zone, спеціалізований аналог Android Market, в якому можна завантажити оптимізовані для Tegra програми.

Продуктивність графічних процесорів зазвичай вимірюється за трьома параметрами:

– кількість трикутників за секунду зазвичай у мільйонах – Мега (MTriangles/s);

– кількість пікселів за секунду зазвичай у мільйонах – Мега (MPixel/s);

- Кількість операцій з плаваючою точкою в секунду зазвичай у мільярдах - Гіга (GFLOPS).

По "флопс" потрібно невелике пояснення. FLOPS (FLoating-point Operations Per Second) – це кількість обчислювальних операцій або інструкцій, що виконуються над операндами з плаваючою точкою (комою) за секунду. Операнд з плаваючою точкою - це неціле число (коректніше було б сказати "з плаваючою комою", адже знаком, що відокремлює цілу частину числа від дробової в російській мові є кома). Зрозуміти який графічний процесор встановлений у твоєму смартфоні допоможе ctrl+Fта таблиця наведена нижче. Зверніть увагу на те, що GPU різних смартфонів працюють на різній частоті. Щоб обчислити продуктивність у GFLOPS для конкретної моделі необхідно число вказане в стовпці “продуктивність у GFLOPS” розділити на 200 і помножити на частоту окремо взятого GPU (наприклад у Galaxy SIII GPU працює на частоті 533МГц означає 7,2/200*533 = 19,1 :

| Назва смартфона/планшета | Процесор | Графічний процесор | Продуктивність у GFLOPS |

| Samsung Galaxy S 4 | Samsung Exynos 5410 | PowerVR SGX544MP3 | 21,6 @ 200МГц |

| HTC One | Qualcomm Snapdragon 600 APQ8064T | Adreno 320 | 20,5 @ 200МГц |

| Samsung Galaxy S III, Galaxy Note II, Galaxy Note 10.1 | Samsung Exynos 4412 | Mali-400 MP4 | 7,2 @ 200МГц |

| Samsung Chromebook XE303C12, Nexus 10 | Samsung Exynos 5250 | Mali-T604 MP4 | 36 @ 200МГц |

| Samsung Galaxy S II, Galaxy Note, Tab 7.7, Galaxy Tab 7 Plus | Samsung Exynos 4210 | Mali-400 MP4 | 7,2 @ 200МГц |

| Samsung Galaxy S, Wave, Wave II, Nexus S, Galaxy Tab, Meizu M9 | Samsung Exynos 3110 | PowerVR SGX540 | 3,2 @ 200Мгц |

| Apple iPhone 3GS, iPod touch 3gen | Samsung S5PC100 | PowerVR SGX535 | 1,6 @ 200Мгц |

| LG Optimus G, Nexus 4, Sony Xperia Z | Qualcomm APQ8064 (ядра Krait) | Adreno 320 | 20,5 @ 200МГц |

| HTC One XL, Nokia Lumia 920, Lumia 820, Motorola RAZR HD, Razr M, Sony Xperia V | Qualcomm MSM8960 (ядра Krait) | Adreno 225 | 12,8 @ 200МГц |

| HTC One S, Windows Phone 8x, Sony Xperia TX/T | Qualcomm MSM8260A | Adreno 220 | ~8,5 * @ 200МГц |

| HTC Desire S, Incredible S, Desire HD, SonyEricsson Xperia Arc, Nokia Lumia 800, Lumia 710 | Qualcomm MSM8255 | Adreno 205 | ~4,3 * @ 200МГц |

| Nokia Lumia 610, LG P500 | Qualcomm MSM7227A | Adreno 200 | ~1,4 * @ 128МГц |

| Motorola Milestone, Samsung i8910, Nokia N900 | TI OMAP3430 | PowerVR SGX530 | 1,6 @ 200Мгц |

| Samsung Galaxy Nexus, Huawei Ascend P1, Ascend D1, Amazon Kindle Fire HD 7″ | TI OMAP4460 | PowerVR SGX540 | 3,2 @ 200Мгц |

| RIM BlackBerry Playbook, LG Optimus 3D P920, Motorola ATRIX 2, Milestone 3, RAZR, Amazon Kindle Fire першого та другого поколінь | TI OMAP4430 | PowerVR SGX540 | 3,2 @ 200Мгц |

| Motorola Defy, Milestone 2, Cliq 2, Defy+, Droid X, Nokia N9, N950, LG Optimus Black, Samsung Galaxy S scLCD | TI OMAP3630 | PowerVR SGX530 | 1,6 @ 200Мгц |

| Acer Iconia Tab A210/A211/A700/ A701/A510, ASUS Transformer Pad, Google Nexus 7, Eee Pad Transformer Prime, Transformer Pad Infinity, Microsoft Surface, Sony Xperia Tablet S, HTC One X/X+, LG Optimus 4X HD, Lenovo IdeaPad Yoga | nVidia Tegra 3 | GeForce ULP | 4,8 @ 200МГц |

| Acer Iconia Tab A500, Iconia Tab A501, Iconia Tab A100, ASUS Eee Pad Slider, Eee Pad Transformer, HTC Sensatoin/XE/XL/4G, Lenovo IdeaPad K1, ThinkPad Tablet, LG Optimus Pad, Optimus 2X, Motorola Atrix 4G, Electrify, Photon 4G, Xoom, Samsung Galaxy Tab 10.1, Galaxy Tab 8.9, Sony Tablet P, Tablet S | nVidia Tegra 2 | GeForce ULP | 3,2 @ 200МГц |

| Apple iPhone 5 | Apple A6 | PowerVR SGX543MP3 | 19,2 @ 200МГц |

| Apple iPad 2, iPhone 4S, iPod touch 5gen, iPad mini | Apple A5 | PowerVR SGX543MP2 | 12,8 @ 200МГц |

| Apple iPad, iPhone 4, iPod touch 4gen | Apple A4 | PowerVR SGX535 | 1,6 @ 200МГц |

* - Дані приблизні.

Наведу ще одну таблицю з абсолютними значеннями продуктивності найпопулярніших смартфонів верхнього цінового діапазону:

* - Неофіційні дані.

Потужність мобільної графіки зростає з року в рік. Вже цього року у топових смартфонах ми можемо побачити ігри рівня PS3/X-Box360. Одночасно з потужністю зростає енергоспоживання SoC і непристойно знижується автономність мобільних пристроїв. Що ж, чекатимемо на прорив у галузі виробництва джерел харчування!

Ще один споживач енергії в сучасному мобільному пристрої - це, безумовно, дисплей. Екрани в мобільних телефонах стають все кращими. Дисплеї смартфонів випущених з різницею лише на рік, разюче відрізняються за якістю картинки. У наступній статті циклу я розповім про дисплеї: яких типів вони бувають, що таке PPI, від чого залежить енергоспоживання та інше.

Диспетчер завдань Windows 10містить докладні інструменти моніторингу графічного процесора (GPU). Ви можете переглядати використання кожної програми та загальносистемного графічного процесора, а Microsoftобіцяє, що показники диспетчера завдань будуть точнішими, ніж показники сторонніх утиліт.

Як це працює

Ці функції графічного процесорабули додані в оновленні Fall Creators для Windows 10 , також відомому як Windows 10 версія 1709 . Якщо ви використовуєте Windows 7, 8 або старішу версію Windows 10, ви не побачите ці інструменти в диспетчері завдань.

Windowsвикористовує новіші функції в Windows Display Driver Model, щоб витягувати інформацію безпосередньо з графічного процесора (VidSCH) та менеджера відеопам'яті (VidMm) у графічному ядрі WDDM, які відповідають за фактичний розподіл ресурсів. Він показує дуже точні дані незалежно від того, які програми API використовують для доступу до GPU-Microsoft DirectX, OpenGL, Vulkan, OpenCL, NVIDIA CUDA, AMD Mantle або чогось іншого.

Саме тому в диспетчері завдань відображаються лише системи з сумісними з WDDM 2.0 графічними процесорами . Якщо ви цього не бачите, графічний процесор вашої системи, ймовірно, використовує старіший тип драйвера.

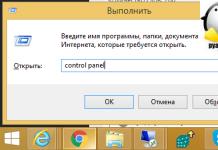

Ви можете перевірити, яка версія WDDM використовується вашим драйвером GPU, натиснувши кнопку Windows+R, набравши в полі «dxdiag», а потім натисніть «Enter», щоб відкрити інструмент « Засіб діагностики DirectX». Перейдіть на вкладку «Екран» та перегляньте праворуч від «Модель» у розділі «Драйвери». Якщо ви бачите тут драйвер WDDM 2.x, система сумісна. Якщо ви бачите тут драйвер WDDM 1.x, ваш GPUне сумісний.

Як переглянути продуктивність графічного процесора

Ця інформація доступна в диспетчері завдань , хоча за умовчанням вона прихована. Щоб відкрити її, відкрийте Диспетчер завдань, клацнувши правою кнопкою миші на будь-якому порожньому місці на панелі завдань та вибравши « Диспетчер завданьабо натиснувши Ctrl+Shift+Esc на клавіатурі.

Натисніть кнопку «Докладніше» у нижній частині вікна « Диспетчер завдань», якщо ви бачите стандартний простий вигляд.

Якщо GPU не відображається в диспетчері завдань , у повноекранному режимі на вкладці « Процеси» клацніть правою кнопкою миші будь-який заголовок стовпця, а потім увімкніть опцію « Графічний процесор ». Це додасть стовпець графічного процесора , який дозволяє побачити відсоток ресурсів графічного процесора , що використовуються кожною програмою.

Ви також можете увімкнути опцію « Ядро графічного процесора», щоб побачити, який графічний процесор використовує програму.

Загальне використання GPUвсіх програм у вашій системі відображається у верхній частині стовпця Графічний процесор. Клацніть стовпець GPU, щоб відсортувати список і переглянути, які програми використовують ваш GPUнайбільше зараз.

Число в стовпці Графічний процесор- це найвище використання, яке додаток використовує для всіх двигунів. Так, наприклад, якщо програма використовує 50% 3D-движка GPU і 2% декодування відео движка GPU, ви просто побачите, що в стовпці GPU відображається число 50%.

У стовпці « Ядро графічного процесора» відображається кожна програма. Це показує вам, який фізичний GPUі який движок використовує програму, наприклад, використовує він 3D-движок або механізм декодування відео. Ви можете визначити, який графічний процесор відповідає певному показнику, перевіривши вкладку « Продуктивність», про яку ми поговоримо у наступному розділі.

Як переглянути використання відеопам'яті програми

Якщо вам цікаво, скільки відеопам'яті використовується програмою, вам потрібно перейти на вкладку «Подробиці» у диспетчері завдань. На вкладці «Подробиці» клацніть правою кнопкою миші будь-який заголовок стовпця та виберіть «Вибрати стовпці». Прокрутіть вниз і увімкніть колонки « Графічний процесор », « Ядро графічного процесора », « » та « ». Перші два доступні також на вкладці "Процеси", але останні дві опції пам'яті доступні лише на панелі "Подробиці".

Стовпець « Виділена пам'ять графічного процесора » показує, скільки пам'яті додаток використовує на вашому GPU. Якщо на вашому ПК встановлена дискретна відеокарта NVIDIA або AMD, це частина його VRAM, тобто скільки фізичної пам'яті на вашій відеокарті використовує додаток. Якщо у вас вбудований графічний процесор частина вашої звичайної системної пам'яті зарезервована виключно для вашого графічного обладнання. Це показує, яка частина зарезервованої пам'яті використовується програмою.

Windowsтакож дозволяє програмам зберігати деякі дані у звичайній системній пам'яті DRAM. Стовпець « Загальна пам'ять графічного процесора » показує, скільки пам'яті програма використовує в даний час для відеопристроїв зі звичайної системної ОЗП комп'ютера.

Ви можете клацнути будь-який зі стовпців для сортування по них і подивитися, який додаток використовує найбільше ресурсів. Наприклад, щоб переглянути програми, які використовують найбільшу відеопам'ять на графічному процесорі, клацніть стовпець « Виділена пам'ять графічного процесора ».

Як відстежити використання загального ресурсу GPU

Щоб відстежувати загальну статистику використання ресурсів GPU, перейдіть на вкладку « Продуктивність» і подивіться на « Графічний процесор» внизу на бічній панелі. Якщо на комп'ютері кілька графічних процесорів, тут ви побачите кілька варіантів GPU.

Якщо у вас є кілька пов'язаних графічних процесорів - використовуючи таку функцію, як NVIDIA SLI або AMD Crossfire, ви побачите їх, ідентифіковані «#» у їхньому імені.

Windowsвідображає використання GPUу реальному часі. За замовчуванням диспетчер завдань намагається відобразити найцікавіші чотири движки відповідно до того, що відбувається у вашій системі. Наприклад, ви побачите різні графіки в залежності від того, чи ви граєте в 3D-ігри або кодуєте відео. Однак ви можете натиснути будь-яке з імен над графіками і вибрати будь-який з інших доступних движків.

Назва вашого GPUтакож відображається на бічній панелі та у верхній частині цього вікна, що дозволяє легко перевірити, яке графічне обладнання встановлене на вашому ПК.

Ви також побачите графіки використання виділеної та спільної пам'яті GPU. Використання спільної пам'яті GPUвідноситься до того, яка частина загальної пам'яті системи використовується для завдань GPU. Ця пам'ять може використовуватися як для звичайних системних завдань, так і відеозаписів.

У нижній частині вікна ви побачите інформацію, таку як номер версії встановленого відеодрайвера, дату розробки та фізичне розташування GPUу вашій системі.

Якщо ви хочете переглянути цю інформацію в більш маленькому вікні, яке простіше залишити на екрані, двічі клацніть десь всередині екрана графічного процесора або клацніть правою кнопкою миші в будь-якому місці всередині і виберіть параметр « Графічний звіт». Ви можете розгорнути вікно, двічі клацнувши на панелі або клацнувши правою кнопкою миші в ньому і знявши прапорець. Графічний звіт».

Ви також можете клацнути правою кнопкою миші за графіком і вибрати «Змінити графік» > «Одне ядро», щоб переглянути лише один графік движка GPU.

Щоб це вікно постійно відображалося на екрані, натисніть «Параметри» > « Поверх решти вікон».

Двічі клацніть усередині панелі GPUще раз, і у вас буде мінімальне вікно, яке ви можете розташувати будь-де на екрані.

При читанні специфікацій смартфонів і планшетів більшість користувачів перш за все звертають свою увагу на характеристики центрального процесора і обсяг оперативної пам'яті, розмір екрану, вбудований накопичувач і камеру. При цьому вони часом забувають про такий важливий компонент девайсу, як графічний процесор (GPU). Звичайний графічний процесор від тієї чи іншої компанії асоціюється з певним центральним процесором. Наприклад, відомі процесори Qualcomm Snapdragon завжди інтегруються з графічними чіпами Adreno. Тайванська компанія MediaTek зазвичай постачала свої чіпсети з графічними процесорами PowerVR від Imagination Technologies, а з недавніх пір - з ARM Mali.

До китайських процесорів Allwiner зазвичай додаються графічні процесори Mali. Центральні процесори Broadcom працюють разом із графічними процесорами VideoCore Graphic. Intel використовує зі своїми мобільними процесорами графічні процесори PowerVR та графіку NVIDIA. Ресурсом s-smartphone.com було складено рейтинг із трьох десятків найкращих за своїми параметрами графічних процесорів, призначених для використання у смартфонах та планшетах. Кожному сучасному користувачеві важливо знати, .

1. Qualcomm Adreno 430, що використовується у смартфоні та;

3. PowerVR GX6450;

4. Qualcomm Adreno 420;

7. Qualcomm Adreno 330;

8. PowerVR G6200;

9. ARM Mali-T628;

10. PowerVR GSX 544 MP4;

11. ARM Mali-T604;

12. NVIDIA GeForce Tegra 4;

13. PowerVR SGX543 MP4;

14. Qualcomm Adreno 320;

15. PowerVR SGX543 MP2;

16. PowerVR SGX545;

17. PowerVR SGX544;

18. Qualcomm Adreno 305;

19. Qualcomm Adreno 225;

20. ARM Mali-400 MP4;

21. NVIDIA GeForce ULP (Tegra 3);

22. Broadcom VideoCore IV;

23. Qualcomm Adreno 220;

24. ARM Mali-400 MP2;

25. NVIDIA GeForce ULP (Tegra 2);

26. PowerVR GSX540;

27. Qualcomm Adreno 205;

28. Qualcomm Adreno 203;

29. PowerVR 531;

30. Qualcomm Adreno 200.

Графічний процесор є важливим компонентом смартфона. Від його технічних можливостей залежить продуктивність графіки і насамперед найбільш графічно інтенсивних програм — ігор. Оскільки рейтинг складався у першій половині року, з того часу в ньому могли відбутися деякі зміни. Як ви вважаєте, чи відповідає позиції процесорів у даному рейтингу їхньої реальної продуктивності?