QoS – тема велика. Перш ніж розповідати про тонкощі налаштувань та різні підходи щодо застосування правил обробки трафіку, має сенс нагадати, що таке взагалі QoS.

Quality of Service (QoS)- технологія надання різним класам трафіку різних пріоритетів в обслуговуванні.

По-перше, легко зрозуміти, що будь-яка пріоритезація має сенс лише в тому випадку, коли виникає черга на обслуговування. Саме там, у черзі, можна «прослизнути» першим, використовуючи своє право.

Черга ж утворюється там, де вузько (зазвичай такі місця називаються «пляшковим шийкою», bottle-neck). Типове «шийка» - вихід в Інтернет офісу, де комп'ютери, підключені до мережі як мінімум на швидкості 100 Мбіт/сек, використовують канал до провайдера, який рідко перевищує 100 Мбіт/сек, а часто становить мізерні 1-2-10Мбіт/сек . На всіх.

По-друге, QoS не панацея: якщо «шийка» надто вузька, то часто переповнюється фізичний буфер інтерфейсу, куди поміщаються всі пакети, які збираються вийти через цей інтерфейс. І тоді нові пакети будуть знищені, навіть якщо вони надпотрібні. Тому, якщо черга на інтерфейсі в середньому перевищує 20% від свого максимального розміру (на маршрутизаторах cisco максимальний розмір черги становить як правило 128-256 пакетів), є привід міцно задуматися над дизайном своєї мережі, прокласти додаткові маршрути або розширити смугу до провайдера.

Розберемося зі складовими елементами технології

(далі під катом, багато)

Маркування.У полях заголовків різних мережевих протоколів(Ethernet, IP, ATM, MPLS та інших.) є спеціальні поля, виділені для маркування трафіку. Маркувати трафік потрібно для подальшої більш простої обробки в чергах.

Ethernet. Поле Class of Service (CoS) – 3 біти. Дозволяє розділити трафік на 8 потоків з різним маркуванням

IP. Є 2 стандарти: старий і новий. У старому було поле ToS (8 біт), з якого у свою чергу виділялися 3 біти під назвою IP Precedence. Це поле копіювалось у поле CoS Ethernet заголовка.

Пізніше було визначено новий стандарт. Поле ToS було перейменовано на DiffServ, і додатково виділено 6 біт для поля Differencial Service Code Point (DSCP), у якому можна передавати необхідні параметри.

Маркувати дані найкраще ближче до джерела цих даних. Тому більшість IP-телефонів самостійно додають до IP-заголовка голосових пакетів поле DSCP = EF або CS5. Багато програм також маркують трафік самостійно, сподіваючись, що їхні пакети будуть оброблені пріоритетно. Наприклад, цим "грішать" пірингові мережі.

Черги.

Навіть якщо ми не використовуємо жодних технологій пріоритезації, це не означає, що немає черг. У вузькому місці черга виникне у будь-якому випадку і надаватиме стандартний механізм FIFO (First In First Out). Така черга, вочевидь, дозволить не знищувати пакети одразу, зберігаючи їх до відправлення в буфері, але жодних преференцій, скажімо, не надасть голосового трафіку.

Якщо хочеться надати деякому виділеному класу абсолютний пріоритет (тобто пакети з цього класу завжди будуть оброблятися першими), така технологія називається Priority queuing. Усі пакети, що знаходяться у фізичному вихідному буфері інтерфейсу будуть розділені на 2 логічні черги і пакети з привілейованої черги будуть надсилатися, поки вона не спорожніє. Тільки після цього почнуть передаватись пакети з другої черги. Ця технологія проста, досить груба, її вважатимуться застарілою, т.к. обробка непріоритетного трафіку постійно зупинятиметься. На маршрутизаторах cisco можна створити

4 черги з різними пріоритетами. У них дотримується сувора ієрархія: пакети з менш привілейованих черг не обслуговуватимуться доти, доки не спорожніють усі черги з вищим пріоритетом.

Справедлива черга ( Fair Queuing). Технологія, яка дозволяє кожному класу трафіку надати однакові права. Зазвичай немає, т.к. мало дає з погляду поліпшення якості сервісу.

Зважена справедлива черга ( Weighted Fair Queuing, WFQ). Технологія, що надає різним класамтрафіку різні права (можна сказати, що «вага» у різних черг різна), але одночасно обслуговує всі черги. "На пальцях" це виглядає так: всі пакети діляться на логічні черги, використовуючи в

як критерій поле IP Precedence. Це ж поле ставить пріоритет (що більше, тим краще). Далі, маршрутизатор обчислює, пакет із якої черги «швидше» передати і передає саме його.

Вважає він це за формулою:

DT=(t(i)-t(0))/(1+IPP)

IPP – значення поля IP Precedence

t(i) - Час, необхідний реальну передачу пакета інтерфейсом. Можна обчислити, як L/Speed, де L – довжина пакета, а Speed – швидкість передачі інтерфейсу

Така черга за замовчуванням включена на всіх інтерфейсах маршрутизаторів ciscoкрім інтерфейсів точка-точка (інкапсуляція HDLC або РРР).

WFQ має ряд мінусів: така чергизація використовує вже відмарковані раніше пакети, і не дозволяє самостійно визначати класи трафіку і смугу, що виділяється. Мало того, як правило, вже ніхто не маркує полем IP Precedence, тому пакети йдуть немарковані, тобто. усі потрапляють в одну чергу.

Розвитком WFQ стала виважена справедлива черга, заснована на класах ( Class-Based Weighted Fair Queuing, CBWFQ). У цій черзі адміністратор сам визначає класи трафіку, дотримуючись різних критеріїв, наприклад, використовуючи ACL, як шаблон або аналізуючи заголовки протоколів (див. NBAR). Далі, для цих класів

визначається «вага» і пакети їх черг обслуговуються, пропорційно вазі (більше вага - більше пакетів з цієї черги піде в одиницю часу)

Але така черга не забезпечує суворого пропускання найбільш важливих пакетів (як правило, голосових або пакетів інших інтерактивних додатків). Тому з'явився гібрид Priority та Class-Based Weighted Fair Queuing. PQ-CBWFQ, також відомий як, Low Latency Queuing (LLQ). У цій технології можна задати до 4х пріоритетних черг, решту класів обслуговувати за механізмом CBWFQ

LLQ - найбільш зручний, гнучкий і часто використовуваний механізм. Але він вимагає налаштування класів, налаштування політики та застосування політики на інтерфейсі.

Таким чином, процес надання якості обслуговування можна поділити на 2 етапи:

Маркування. Ближче до джерел.

Обробка пакетів. Приміщення їх у фізичну чергу на інтерфейсі, підрозділ на логічні черги та надання цим логічним чергам різних ресурсів.

Технологія QoS - досить ресурсомістка і дуже суттєво вантажить процесор. І тим більше вантажить, чим глибше в заголовки доводиться залазити для класифікації пакетів. Для порівняння: маршрутизатору набагато простіше заглянути в заголовок IP пакета і проаналізувати там три біти IPP, ніж розкручувати потік практично до рівня програми, визначаючи, що за протокол йде всередині (технологія NBAR)

Для спрощення подальшої обробки трафіку, а також для створення так званої «області довіри» (trusted boundary), де ми віримо всім заголовкам QoS, ми можемо робити наступне:

1. На комутаторах та маршрутизаторах рівня доступу (близько до клієнтським машинам) ловити пакети, розкидати їх за класами

2.У політиці як дія перефарбовувати заголовки по-своєму або переносити значення QoS-заголовків вищого рівня на нижні.

Наприклад, на маршрутизаторі ловимо всі пакети з гостьового WiFi домену (припускаємо, що там можуть бути не керовані нами комп'ютери та софт, який може використовувати нестандартні QoS-заголовки), змінюємо будь-які заголовки IP на дефолтні, зіставляємо заголовки 3 рівня (DSCP) заголовки канального рівня(CoS),

щоб далі і комутатори могли ефективно пріоритезувати трафік, використовуючи лише мітку канального рівня.

Налаштування LLQ

Налаштування черг полягає у налаштуванні класів, потім для цих класів треба визначити параметри смуги пропускання та застосувати всю створену конструкцію на інтерфейс.

Створення класів:

class-map NAME

match?

access-group Access group

any Any packets

class-map Class map

cos IEEE 802.1Q/ISL class of service/user priority values

destination-address Destination address

discard-class Discard behavior identifier

dscp Match DSCP в IP(v4) and IPv6 пакетів

flow Flow based QoS parameters

fr-de Match on Frame-relay DE bit

fr-dlci Match on fr-dlci

input-interface Select an input interface to match

ip IP specific values

mpls Multi Protocol Label Switching specific values

not Negate this match result

packet Layer 3 Packet length

precedence Match Precedence в IP(v4) and IPv6 пакетів

protocol Protocol

qos-group Qos-group

source-address Source address

vlan VLANs to match

Пакети в класи можна розсортувати за різними атрибутами, наприклад, вказуючи ACL, як шаблон, по полю DSCP, або виділяючи конкретний протокол (включається технологія NBAR)

Створення політики:

policy-map POLICY

class NAME1

?

bandwidth Bandwidth

compression Activate Compression

drop Drop all packets

log Log IPv4 і ARP пакети

netflow-sampler NetFlow action

police Police

priority Strict Scheduling Priority for this Class

queue-limit Queue Max Threshold for Tail Drop

random-detect Enable Random Early Detection as drop policy

service-policy Configure Flow Next

set Set QoS values

shape Traffic Shaping

Для кожного класу в політиці можна або виділити пріритетно шмат смуги:

policy-map POLICY

class NAME1

priority?

Kilo Bits per second

percent% of total bandwidth

і тоді пакети цього класу можуть завжди розраховувати як мінімум на цей шматок.

Або описати, яка «вага» має цей клас у рамках CBWFQ

policy-map POLICY

class NAME1

bandwidth?

Kilo Bits per second

percent% of total Bandwidth

remaining% of the remaining bandwidth

В обох випадках можна вказати як аболютне значення, так і відсоток від усієї доступної смуги

Виникає резонне питання: а звідки маршрутизатор знає ВРЮ смугу? Відповідь банальна: з параметра bandwidth на інтерфейсі. Навіть якщо він не налаштований явно, якесь його значення обов'язково є. Його можна переглянути командою sh int.

Також обов'язково пам'ятати, що за умовчанням ви розпоряджаєтесь не всією смугою, а лише 75%. Пакети, які явно не потрапили в інші класи, потрапляють у class-default. Це налаштування для дефолтного класу можна задати явно

policy-map POLICY

class class-default

bandwidth percent 10

(UPD, дякую OlegD)

Змінити максимальну доступну смугу з дефолтних 75% можна командою на інтерфейсіmax-reserved-bandwidth

Маршрутизатори ревно стежать, щоб адмін не видав випадково більше смугичим є і лаються на такі спроби.

Складається враження, що політика видаватиме класам не більше, ніж написано. Проте така ситуація буде лише в тому випадку, якщо всі черги наповнені. Якщо ж якась порожня, то виділену їй смугу наповнені черги поділять пропорційно до своєї «ваги».

Працювати ж вся ця конструкція буде так:

Якщо йдуть пакети із класу із зазначенням priority, то маршрутизатор зосереджується передачі цих пакетів. Причому т.к. таких пріоритетних черг може бути кілька, то між ними смуга ділиться пропорційно до зазначених відсотків.

Як тільки всі пріоритетні пакети закінчилися, настає черга CBWFQ. За кожний відлік часу з кожної черги «зачерпується» частка пакетів, вказана в налаштуванні цього класу. Якщо ж частина черг порожня, їх смуга ділиться пропорційно «ваги» класу між завантаженими чергами.

Застосування на інтерфейсі:

int s0/0

service-policy POLICY

А що робити, якщо треба строго рубати пакети з класу, що виходять за дозволену швидкість? Адже вказівка Bandwidth лише розподіляє смугу між класами, коли черги завантажені.

Для вирішення цього завдання для класу трафіку у політиці є технологія

police conform-action [дія] exceed-action [дія]

Вона дозволяє явно зазначити бажану середню швидкість (speed), максимальний «викид», тобто. кількість даних, що передаються за одиницю часу. Що «викид», то більше реальна швидкість передачі може відхилятися від бажаної середньої. Також зазначаються: дія для нормального трафіку, що не перевищує

зазначену швидкість та дію для трафіку, що перевищив середню швидкість. Дії можуть бути такими

police 100000 8000 conform-action?

drop drop packet

exceed-action action when rate is within conform and

conform + exceed burst

set-clp-transmit set atm clp and send it

set-discard-class-transmit set discard-class and send it

set-dscp-transmit set dscp and send it

set-frde-transmit set FR DE and send it

set-mpls-exp-imposition-transmit set exp at tag imposition and send it

set-mpls-exp-topmost-transmit set exp on topmost label and send it

set-prec-transmit rewrite packet precedence and send it

set-qos-transmit set qos-group and send it

transmit transmit packet

Часто виникає ще й інше завдання. Припустимо, що треба обмежити потік, що йде у бік сусіда з повільним каналом.

Щоб точно передбачити, які пакети дійдуть до сусіда, а які будуть знищені через завантаженість каналу на «повільній» стороні, треба на «швидкій» стороні створити політику, яка заздалегідь обробляла черги і знищувала надлишкові пакети.

І тут ми стикаємося з однією дуже важливою річчю: для вирішення цього завдання треба семулювати «повільний» канал. Для цієї емуляції мало лише розкидати пакети по чергах, треба ще симулювати фізичний буфер «повільного» інтерфейсу. Кожен інтерфейс має швидкість передачі пакетів. Тобто. в одиницю часу кожен інтерфейс може передати трохи більше, ніж N пакетів. Зазвичай фізичний буфер інтерфейсу розраховують те щоб забезпечити «автономну» роботу інтерфейсу кілька одиниць вермени. Тому фізичний буфер, скажімо, GigabitEthernet буде в десятки разів більше за будь-який інтерфейс Serial.

Що ж поганого у тому, щоб запам'ятати багато? Давайте розглянемо докладно, що відбудеться, якщо буфер на швидкій стороні, що передає, буде значно більше буфера приймаючої.

Нехай для простоти є одна черга. На "швидкій" стороні симулюємо малу швидкість передачі. Це означає, що, потрапляючи під нашу політику, пакети почнуть накопичуватися в черзі. Т.к. фізичний буфер великий, те й логічна черга вийде значною. Частина додатків (працюючих через ТСР) пізно отримають повідомлення про те, що частина пакетів не отримана і довго триматиметься великий розмірвікна, навантажуючи сторону-приймач. Це буде відбуватися в тому ідеальному випадку, коли швидкість передачі дорівнюватиме або менше швидкостіприйому. Але інтерфейс приймаючої сторони може бути завантажений й іншими пакетами

і тоді маленька черга на стороні, що приймає, не зможе вмістити всіх пакетів, що передаються їй з центру. Почнуться втрати, які спричинять за собою додаткові передачі, Але в передає буфері ще залишиться солідний «хвіст» раніше накопичених пакетів, які будуть передаватися «вхолосту», т.к. на приймаючій стороні не дочекалися більш раннього пакета, а значить пізніші будуть просто проігноровані.

Тому для коректного вирішення задачі зниження швидкості передачі до повільного сусіда фізичний буфер теж треба обмежити.

Робиться це командою

shape average

Ну а тепер найцікавіше: а як бути, якщо мені, крім емуляції фізичного буфера, треба всередині нього створити логічні черги? Наприклад, виділити пріоритетний голос?

Для цього створюється так звана вкладена політика, яка застосовується всередині основної та ділить на логічні черги те, що до неї потрапляє з батьківської.

Настав час розібрати якийсь залихватський приклад на основі наведеної картинки.

Нехай ми збираємося створити стійко працюючі голосові канали через інтернет між CO та Remote. Для простоти нехай мережа Remote (172.16.1.0/24) має лише зв'язок із СО (10.0.0.0/8). Швидкість інтерфейсу на Remote – 1 Мбіт/сек та виділяється 25% цієї швидкості на голосовий трафік.

Тоді для початку нам треба виділити пріоритетний клас трафіку з обох боків та створити політику для цього класу. На СО додатково створимо клас, який описує трафік між офісами

class-map RTP

match protocol rtp

Policy-map RTP

class RTP

priority percent 25

Ip access-list extended CO_REMOTE

permit ip 10.0.0.0 0.255.255.255 172.16.1.0 0.0.0.255

Class-map CO_REMOTE

match access-list CO_REMOTE

На Remote зробимо інакше: нехай через дохлість заліза ми не можемо використовувати NBAR, тоді нам залишається тільки явно описати порти для RTP

ip access-list extended RTP

permit udp 172.16.1.0 0.0.0.255 range 16384 32768 10.0.0.0 0.255.255.255 range 16384 32768

Class-map RTP

match access-list RTP

Policy-map QoS

class RTP

priority percent 25

policy-map QoS

class CO_REMOTE

shape average 1000000

service-policy RTP

та застосувати політику на інтерфейсі

int g0/0

service-policy output QoS

На Remote встановимо параметр bandwidth (у кбіт/сек) у відповідність до швидкості інтерфейсу. Нагадаю, що саме від цього параметра вважатиметься 25%. І застосуємо політику.

int s0/0

bandwidth 1000

service-policy output QoS

Розповідь була б не повною, якщо не охопити можливості комутаторів. Зрозуміло, що суто L2 комутатори не здатні так глибоко заглядати в пакети і ділити їх на класи за тими самими критеріями.

На більш розумних L2/3 комутаторах на інтерфейсах, що маршрутизуються (тобто або на interface vlan, або якщо порт виведений з другого рівня командою no switchport) застосовується та ж конструкція, що працює і на маршрутизаторах, а якщо порт або весь комутатор працює в режимі L2 (вірно для моделей 2950/60), то там для класу трафіку можна використовувати лише вказівку police, а priority чи bandwidth не доступні.

Причому часто хробак поширюється по потрібних для роботи портам (ТСР/135,445,80 та ін.) Просто закрити на маршрутизаторі ці порти було б необачно, тому гуманніше чинити так:

1. Збираємо статистику з мережевого трафіку. Або з NetFlow, або NBARом, або з SNMP.

2. Виявляємо профіль нормального трафіку, тобто. за статистикою, в середньому, протокол HTTPзаймає не більше 70%, ICMP – не більше 5% і т.д. Такий профіль можна створити вручну, або застосувавши накопичену NBARом статистику. Мало того, можна навіть автоматично створити класи, політику та застосувати на інтерфейсі

командою autoqos :)

3. Далі можна обмежити для нетипового мережевого трафікусмугу. Якщо раптом і підчепимо заразу нестандартним портом, великої біди для шлюзу не буде: на завантаженому інтерфейсі зараза займе не більше виділеної частини.

4. Створивши конструкцію ( class-map - policy-map - service-policy) можна оперативно реагувати на появу нетипового сплеску трафіку, створюючи вручну йому клас і сильно обмежуючи смугу цього класу.

Пропускна здатністьлокальної мережі — тема, що стає з поширенням швидкісного інтернету дедалі актуальнішою. Щоразу ми намагаємося підключити до роутера все більше пристроїв, а програмне забезпечення за замовчуванням не завжди може з ними з усіма впоратися. В цьому випадку на допомогу приходить налаштування пріоритетів QoS пакетів пропускну здатністьлокальної мережі на маршрутизаторі. Вона призначає пріоритет виконання тих чи інших найважливіших на Наразізадач і доступна не тільки на топових маршрутизатори Mikrotikабо Cisco, але і на будь-якій недорогій моделі TP-Link, Asus, Zyxel Keenetic, D-Link.

Більшість сучасних роутерів мають вбудовану можливість керувати потоками інтернет-трафіку всередині. локальної мережі, призначаючи пріоритет під час роботи тієї чи іншої програми. Ну, наприклад, ви граєте в онлайн гру або переглядаєте сторінки улюблених сайтів. І паралельно качаєте цікавий фільм торрентом. При цьому гра починає гальмувати і файл хитається ледве-ледь. Що робити?

Потрібно вибрати, яка дія для вас зараз є більш важливою. Напевно, це таки онлайн гра. Тому за допомогою налаштування планувальника пакетів QoSми можемо встановити пріоритет виконання ігрових завдань перед завантаженням файлів.

Але пропускна спроможність локальної мережі та каналу інтернет обмежена. Перша – можливостями роутера. Пам'ятаєте, ми говорили про?

Друга – вашим тарифним планомвід провайдера. То як у своїй поділяється пріоритет виконання цих одночасних завдань?

Як правило, за замовчуванням найвищий пріоритет надається веб-серфінгу, тобто роботі вашого браузера. Але якщо в даний момент ви відкрили і читаєте статтю і при цьому вам хочеться якнайшвидше закачати фільм, то логічніше було б віддати пріоритет саме програмі-файлозавантажувачу, а не браузеру.

Саме тому в роутерах передбачено можливість налаштувати пропускну спроможність мережі вручну. А саме розподілити пріоритет так, як вам це потрібно. Називається ця функція - QoS (Quality of Service). Тобто, технологія надання різним класам трафіку пріоритетів в обслуговуванні.

Диспетчер трафіку на роутері Asus

У різних моделях ця настройка може ховатися під різними назвами пункту меню. У мене зараз працює роутер Asusу новій прошивці – показую на RT-N10U версії B1. І тут налаштування планувальника QoS здійснюється у розділі "Диспетчер трафіку".

Для початку потрібно змінити автоматичний режим активований за замовчуванням на один з двох. «Визначені користувачем правила QoS» або «Пріоритет, що визначається користувачем»

Правила планувальника пакетів QoS, що визначаються користувачем.

Дана настройка дозволяє задати пріоритет для вже встановлених вшитих у програмне забезпечення маршрутизатора програм з різних «вагових категорій». При цьому морочитися з різними формулами і проводити розрахунок пропускної спроможності мережі не знадобиться. Все вже вигадано до нас. Без скріншота трохи не зрозуміло, тому наводжу його:

Отже, зараз на «Web Serf», тобто на підключення через браузер через порт, що використовується для цього, стоїть «Найвищий» пріоритет. Клікнувши по списку, ми можемо вибрати інший із запропонованого списку. У той же час на File Transfer, тобто для програм-завантажувачів файлів найменший. Змінивши ці параметри місцями ми отримаємо ефект, що при одночасного завантаженняфайлу з будь-якого сайту та перегляді html-сторінки, більша швидкість буде віддаватися першому процесу.

Але це ще не все. Для програм передачі файлів за допомогою P2P (наприклад, BitTorrent), або он-лайн ігор, а також безлічі інших програм можна задати свої значення пріоритету. Це робиться додаванням нового правила до існуючих.

Для його створення клацаємо по пункту «Виберіть» і з випадаючого списку вибираємо тип передачі даних, що цікавить нас, або попередньо встановлені налаштування для конкретного додатку. Наприклад, можна задати в пропускній здатності мережі пріоритет для поштових додатківтипу Outlook або TheBat (пункт SMTP, POP3…) або ftp-клієнтів (FTP, SFTP, WLM…). Також є великий список популярних ігор, наприклад Counter Strike, та програм для обміну файлами - BitTorrent, eDonkey і т.д.

Виберемо качалку торентів. Автоматично проставляються порти, що використовуються цією програмою за замовчуванням.

Але краще на слово роутеру не вірити і перевіряти ще раз їх самостійно. Відкриємо програму (у мене uTorrent) і зайдемо до «Установки > Установки програми > З'єднання». Подивимося, який порт заданий роботи цієї проги.

Якщо він відрізняється від тих, які були по дефолту прописані в налаштуваннях роутера, змініть. Або там чи тут, головне, щоб вони були однаковими. Зберігаємо налаштування у програмі і, повернувшись до адмінки роутера, застосовуємо параметри. Вони активуються після перезавантаження апарату.

Пріоритет пакетів QoS, що визначається користувачем

Це друге налаштування ручного управління пропускною здатністю мережі, яка дозволяє налаштувати параметри, що задаються в попередньому розділі. А саме визначити, яка саме швидкість у відсотковому співвідношенні буде призначена для кожного з параметрів пріоритету.

Наприклад, для вихідного трафіку на «Найвищий» зараз за замовчуванням у мене задано 80%. мінімальне значеннята 100% - максимальне. Це означає, що ті, у яких найвищий пріоритет, отримуватимуть не менше 80% ширини пропускання каналу. Незалежно від того, скільки одночасних процесів не виробляли б вихідні з'єднання з інтернетом. Ті ж, хто має пріоритет «Високий» — не менше 10%. І так далі — гадаю, суть ви зрозуміли. Відредагувавши ці значення, можна детально керувати швидкістю завантаження та вивантаження для різних категорій працюючих програм.

Тепер пропоную подивитися розгорнутий відеоурок про налаштування QoS на роутерах фірми Cisco

Налаштування планувальника пакетів QoS на роутері TP-Link

Нижче для вашої зручності наведу кілька скріншотів адміністраторських розділів для керування пропускною здатністю з моделей інших фірм. На роутерах TP-Link планувальник пакетів QoS знаходиться в розділі «Контроль пропускної здатності». Для його активації ставимо галочку на «Включити контроль смуги пропускання» та задаємо максимальну швидкістьдля вхідного та вихідного трафіку.

Натиснувши кнопку «Додати», можна додати нове правило на пріоритет для одного або кількох комп'ютерів. Для цього необхідно вписати їх IP-адресу або діапазон адрес. А також вказати порти та тип обміну пакетами, на які це правилопоширюватиметься.

Нещодавно у TP-Link з'явилася нова візуалізація панелі адміністратора, яка встановлюється на нові моделі. У ній планувальник QoS знаходиться в Додаткові настройки» у розділі «Пріоретизація даних». Включаємо її галочкою та регулюємо повзунками три види пріоритетів:

- Високий

- Середній

- Низький

Для додавання фільтра натискаємо на кнопку «Додати» в одній із трьох вікон встановлених налаштувань

Відкриється список підключених до роутера клієнтів - вибираємо потрібний і тиснемо на посилання "Вибрати" і далі "ОК"

Пропускна спроможність мережі IntelliQoS на Zyxel Keenetic

На маршрутизаторах Keenetic функція керування пропускною спроможністю мережі називається IntelliQoS. Спочатку цей модуль не присутній у прошивці. Необхідно додатково >> встановити компонент IntelliQoS з відповідного розділу панелі адміністратора. Після чого в меню "Мої мережі та WiFi" з'явиться окремий однойменний пункт.

Для активації режиму контролю трафіку вмикаємо цю службу та вказуємо максимальну швидкість інтернету, передбачену тарифним планом провайдера. Для більш точного її визначення можна запустити онлайн тестшвидкості і виходить з цього реального значення.

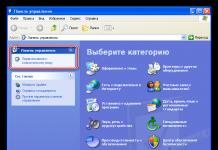

Налаштування пропускної здатності мережі на роутері D-Link

Для роутера D-Link модель DIR-620 розробники чомусь реалізували можливість встановити QOS обмеження за швидкістю тільки на комп'ютери, підключені по кабелю до одного з LAN портів. Знаходиться це налаштування в розділі «Додатково — Управління смугою пропускання»

Вибравши один із них, включаємо обмеження та встановлюємо швидкість

На цьому поки що все - пробуйте і експериментуйте з пропускною здатністю локальної мережі для того, щоб роутер не пригальмовував роботу тих програм, від яких ви чекаєте максимальної віддачі в даний момент.

Відео з налаштування QoS на роутері

Немає жодної людини, яка б хоч раз не прочитала якусь FAQ по Windows XP. А якщо так, то кожен знає, що є така шкідлива служба Quality of Service - скорочено QoS. При налаштуванні системи її настійно рекомендується відключати, тому що вона за умовчанням обмежує мережну пропускну здатність на 20%, і начебто ця проблема існує і в Windows 2000.

Ось ці рядки:

"Q: Як повністю вимкнути QoS (Quality of Service)? Як її налаштувати? Чи правда, що вона обмежує швидкість мережі? A: Дійсно, за замовчуванням Quality of Service резервує для своїх потреб 20% від пропускної спроможності каналу (будь-якого модем на 14400, хоч гігабітний Ethernet). Причому навіть якщо видалити QoS Packet Scheduler з Properties-з'єднання, цей канал не звільняється. Звільнити канал або просто налаштувати QoS можна тут. Запускаємо аплет Group Policy (gpedit.msc). У Group Policy знаходимо Local computer policy та натискаємо на Administrative templates. Вибираємо пункт Network – QoS Packet Sheduler. Включаємо Limit reservable bandwidth. Тепер знижуємо Bandwidth limit 20% до 0% або просто вимикаємо його. За бажання тут можна налаштувати й інші параметри QoS. Для активації зроблених змін залишається лише перезавантажитись".

20% – це, звичайно, дуже багато. Воістину Microsoft - "маздай". Твердження подібного роду кочують з FAQ у FAQ, з форуму на форум, зі ЗМІ в ЗМІ, використовуються у різноманітних "твікалках" - програмах з "налаштування" Windows XP (до речі, відкрийте " Групові політики"і" Локальні політикибезпеки", і жодна "твикалка" не зрівняється з ними за багатством варіантів налаштування). Викривати голослівні твердження такого роду потрібно обережно, що ми зараз і зробимо, застосувавши системний підхід. Тобто ґрунтовно вивчимо проблемне питання, спираючись на офіційні першоджерела.

Що таке мережа із якісним сервісом?

Давайте приймемо таке спрощене визначення мережевої системи. Програми запускаються і працюють на хостах та обмінюються даними між собою. Програми надсилають дані операційній системі передачі по мережі. Як тільки дані передані операційній системі, вони стають мережевим трафіком.

Мережева служба QoS спирається на здатність мережі обробити цей трафік так, щоб гарантовано виконати запити деяких програм. Це вимагає наявності фундаментального механізму обробки мережевого трафіку, здатного ідентифікувати трафік, що має право на особливу обробку і право керувати цими механізмами.

Функціональні можливості QoS покликані задовольнити двох суб'єктів мережі: мережеві програми та мережевих адміністраторів. Вони часто мають суперечності. Адміністратор мережі обмежує ресурси, що використовуються специфічним додатком, в той же час програма намагається захопити якнайбільше мережевих ресурсів. Їхні інтереси можуть бути узгоджені, беручи до уваги той факт, що мережевий адміністратор відіграє чільну роль по відношенню до всіх додатків та користувачів.

Основні параметри QoS

Різні програми мають різні вимоги щодо обробки їх мережевого трафіку. Програми більшою чи меншою мірою терпимі до затримок та втрат трафіку. Ці вимоги знайшли застосування у наступних параметрах, пов'язаних з QoS:

Bandwidth (смуга пропускання) - швидкість, з якою трафік, що генерується додатком, має бути переданий по мережі

- Latency (затримка) – затримка, яку програма може допустити в доставці пакета даних.

- Jitter – зміна часу затримки.

- Loss (втрата) – відсоток втрачених даних.

Якби були доступні нескінченні мережеві ресурси, весь трафік програми можна було б передати з необхідною швидкістю, з нульовим часом затримки, нульовим зміною часу затримки і нульовими втратами. Проте мережеві ресурси не безмежні.

Механізм QoS контролює розподіл мережевих ресурсів для трафіку програми, щоб виконати вимоги щодо його передачі.

Фундаментальні ресурси QoS та механізми обробки трафіку

Мережі, які пов'язують хости, використовують різноманітні мережеві пристрої, включаючи мережеві адаптери хостів, маршрутизатори, свічі та хаби. Кожен має мережні інтерфейси. Кожен мережний інтерфейс може прийняти та передати трафік з кінцевою швидкістю. Якщо швидкість, з якою трафік спрямовано інтерфейс, вище, ніж швидкість, з якою інтерфейс передає трафік далі, виникає перевантаження.

Мережеві пристрої можуть обробити стан навантаження, організуючи чергу трафіку в пам'яті пристрою (у буфері), доки перевантаження не пройде. В інших випадках мережеве обладнання може відмовитись від трафіку, щоб полегшити перевантаження. В результаті програми зіштовхуються зі зміною часу очікування (оскільки трафік зберігається в чергах на інтерфейсах) або зі втратою трафіку.

Здатність мережевих інтерфейсівдо пересилання трафіку та наявність пам'яті для збереження трафіку в мережевих пристроях (доки трафік не може бути надісланий далі) становлять фундаментальні ресурси, потрібні для забезпечення QoS для потоків трафіку додатків.

Розподіл ресурсів QoS по мережевих пристроях

Пристрої, що підтримують QoS, розумно використовують ресурси мережі передачі трафіку. Тобто трафік додатків, більш терпимих до затримок, стає в чергу (зберігається в буфері пам'яті), а трафік додатків, критичних до затримок, передається далі.

Для виконання цього завдання мережевий пристрій має ідентифікувати трафік шляхом класифікації пакетів, а також мати черги та механізми обслуговування.

Механізм обробки трафіку

Механізм обробки трафіку включає:

802.1p

- Диференційовані послуги per-hop-behaviors (diffserv PHB).

- Інтегровані послуги (intserv).

- ATM та ін.

Більшість локальних мереж засновані на технології IEEE 802, включаючи Ethernet, token-ring та ін. 802.1p - це механізм обробки трафіку для підтримки QoS у таких мережах.

802.1p визначає поле (рівень 2 в мережевої моделі OSI) у заголовку пакета 802, яке може нести одне з восьми значень пріоритету. Як правило, хости або маршрутизатори, посилаючи трафік у локальну мережу, маркують кожен пакет, присвоюючи йому певне значення пріоритету. Передбачається, що мережні пристрої, такі як свічі, мости і хаби, оброблять пакети відповідним чином, використовуючи механізми організації черг. Область застосування 802.1p обмежена локальною мережею (LAN). Як тільки пакет перетинає локальну мережу (через рівень 3 OSI), пріоритет 802.1p видаляється.

Diffserv – це механізм рівня 3. Він визначає поле в рівні 3 заголовка пакетів IP, названих diffserv codepoint (DSCP).

Intserv - це цілий комплекс послуг, що визначає гарантований сервіс та сервіс, що керує завантаженням. Гарантований сервісобіцяє нести певний обсяг трафіку з вимірною та обмеженою затримкою. Сервіс, що керує завантаженням, погоджується нести деякий обсяг трафіку з "появою легкої завантаженості мережі". Це вимірні послуги в тому сенсі, що вони визначені, щоб забезпечити вимірний QoS до певної кількості трафіку.

Оскільки технологія ATM фрагментує пакети відносно маленькі комірки, то вона може запропонувати дуже низький час затримки. Якщо необхідно передати пакет терміново, інтерфейс ATM може завжди звільнятися для передачі на час, який потрібно передати одну комірку.

QoS має ще багато різних складних механізмів, які забезпечують роботу цієї технології. Відзначимо лише один важливий момент: для того, щоб QoS запрацювала, необхідна підтримка цієї технології та відповідне налаштування на всьому протязі передачі від початкової точки до кінцевої.

Для наочності розглянемо рис. 1.

Приймаємо таке:

Усі маршрутизатори беруть участь у передачі потрібних протоколів.

- Один QoS-сеанс, що вимагає 64 Kbps, ініціалізований між хостом А та хостом B.

- Інший сеанс, що вимагає 64 Kbps, ініціалізований між хостом А та хостом D.

- Для спрощення схеми вважаємо, що маршрутизатори налаштовані так, що можуть резервувати всі мережеві ресурси.

У нашому випадку один запит про резервування 64 Kbps досяг би трьох маршрутизаторів на шляху даних між хостом А та хостом B. Інший запит про 64 Kbps досяг би трьох маршрутизаторів між хостом А та хостом D. Маршрутизатори виконали б ці запити на резервування ресурсів, тому що вони не перевищують максимуму. Якщо замість цього кожен з хостів B і C одночасно ініціалізував би 64 Kbps QoS-сеанс з хостом A, маршрутизатор, що обслуговує ці хости (B і C), заборонив би одне зі з'єднань.

Тепер припустимо, що адміністратор мережі відключає обробку QoS в трьох нижніх маршрутизаторах, що обслуговують хости B, C, D, E. У цьому випадку запити про ресурси до 128 Kbps задовольнялися б незалежно від розташування хоста, що бере участь у з'єднанні. При цьому гарантії якості були б низькими, оскільки трафік для одного хоста ризикував трафік іншого. Якість обслуговування могла б бути збережена, якби верхній маршрутизатор обмежував усі запити до 64 Kbps, однак це призвело б до неефективного використання мережевих ресурсів.

З іншого боку, пропускну здатність всіх мережевих зв'язківможна було б збільшити до 128 Kbps. Але збільшена пропускна спроможність використовуватиметься тільки коли хости B і C (або D і E) одночасно зажадають ресурси. Якщо це не так, то ресурси мережі знову використовуватимуться неефективно.

QoS-компоненти Microsoft

Windows 98 містить компоненти QoS тільки рівня користувача, включаючи:

Компоненти програм.

- GQoS API (частина Winsock 2).

- QoS Service Provider.

Операційна система Windows 2000/XP/2003 містить усі описані вище та наступні компоненти:

Resource Reservation Protocol Service Provider (Rsvpsp.dll) та служби RSVP (Rsvp.exe) та QoS ACS. У Windows XP 2003 не використовуються. Управління трафіком (Traffic.dll).

- Generic Packet Classifier (Msgpc.sys). Класифікатор пакетів визначає клас сервісу, якому належить пакет. При цьому пакет буде поставлено у відповідну чергу. Черги керуються планувальником пакетів QoS.

- Планувальник пакетів QoS (Psched.sys). Визначає QoS параметри для специфічного потоку даних. Трафік позначається певним значенням пріоритету. Планувальник пакетів QoS визначає графік постановки в чергу кожного пакета та обробляє конкуруючі запити між поставленими в чергу пакетами, які потребують одночасного доступу до мережі.

Діаграма на рис.2 ілюструє стік протоколів, компоненти Windows та їх взаємодію на хості. Елементи, які використовуються у Windows 2000, але не використовуються у Windows XP/2003, на діаграмі не показані.

Програми знаходяться вгорі стека. Вони можуть знати чи не знати про QoS. Щоб використовувати всю потужність QoS, Microsoft рекомендує використовувати у програмах виклики Generic QoS API. Це особливо важливо для програм, що вимагають високоякісних гарантій обслуговування. Деякі утиліти можуть використовуватися для виклику QoS від імені програм, які не знають QoS. Вони працюють через API керування трафіком. Наприклад, NetMeeting використовує GQoS API. Але для таких програм якість не гарантується.

Останній цвях

Вищевикладені теоретичні моменти не дають однозначної відповіді на запитання, куди подінуться горезвісні 20% (які, зауважу, ніхто точно не вимірював). Виходячи з вищесказаного, такого не повинно бути. Але опоненти висувають новий аргумент: система QoS хороша, та реалізація крива. Отже, 20% все-таки "віджираються". Мабуть, проблема допекла і софтверного гіганта, оскільки він уже досить давно окремо спростував подібні вигадки.

Втім, дамо слово розробникам та викладемо вибрані моменти зі статті "316666 - Windows XP Quality of Service (QoS) Enhancements and Behavior".

"Сто відсотків мережної смуги пропускання доступні для розподілу між усіма програмами, якщо будь-яка програма явно не запитує пріоритетну смугу пропускання. Ця "зарезервована" смуга пропускання доступна іншим програмам, якщо програма, яка її зажадала, не надсилає дані.

За промовчанням програми можуть резервувати до 20% основної швидкості з'єднання кожного інтерфейсу комп'ютера. Якщо програма, яка резервувала смугу пропускання, не надсилає достатньо даних, щоб використовувати її повністю, невикористана частина зарезервованої смуги пропускання доступна для інших потоків даних.

Були заяви у різних технічних статтях та телеконференціях, що Windows XP завжди резервує 20% доступної смуги пропускання для QoS. Ці заяви неправильні".

Якщо тепер у когось все ще "віджирається" 20% смуги пропускання, що ж, я можу порадити і далі використовувати якомога більше "твікалок" і кривих мережевих драйверів. Ще й не стільки "віджиратиметься".

Немає жодної людини, яка б хоч раз не прочитала якусь FAQ по Windows XP. А якщо так, то кожен знає, що є така шкідлива служба Quality of Service — скорочено QoS. При налаштуванні системи її настійно рекомендується відключати, тому що вона за умовчанням обмежує мережну пропускну здатність на 20%, і начебто ця проблема існує і в Windows 2000.

Ось ці рядки:

Q: Як повністю вимкнути QoS (Quality of Service)? Як її налаштувати? Чи правда, що вона обмежує швидкість мережі?

A: Дійсно, за замовчуванням Quality of Service резервує для своїх потреб 20% від пропускної спроможності каналу (будь-якого модем на 14400, хоч гігабітний Ethernet). Причому навіть якщо видалити QoS Packet Scheduler з Properties-з'єднання, цей канал не звільняється. Звільнити канал або просто налаштувати QoS можна тут. Запускаємо аплет Group Policy (gpedit.msc). У Group Policy знаходимо Local computer policy та натискаємо на Administrative templates. Вибираємо пункт Network – QoS Packet Sheduler. Включаємо Limit reservable bandwidth. Тепер знижуємо Bandwidth limit 20% до 0% або просто вимикаємо його. За бажання тут можна налаштувати й інші параметри QoS. Для активації змін залишається лише перезавантажитися.

20% – це, звичайно, дуже багато. Воістину Microsoft - "маздай". Твердження подібного роду кочують з FAQ у FAQ, з форуму на форум, зі ЗМІ в ЗМІ, використовуються у різноманітних "твікалках" - програмах з "налаштування" Windows XP (до речі, відкрийте "Групові політики" та "Локальні політики безпеки", і жодна "твікалка" не зрівняється з ними за багатством варіантів налаштування). Викривати голослівні твердження такого роду потрібно обережно, що ми зараз зробимо, застосувавши системний підхід. Тобто ґрунтовно вивчимо проблемне питання, спираючись на офіційні першоджерела.

Що таке мережа із якісним сервісом?

Давайте приймемо таке спрощене визначення мережевої системи. Програми запускаються і працюють на хостах та обмінюються даними між собою. Програми надсилають дані операційній системі передачі по мережі. Як тільки дані передані операційній системі, вони стають мережевим трафіком.

Мережева служба QoS спирається на здатність мережі обробити цей трафік так, щоб гарантовано виконати запити деяких програм. Це вимагає наявності фундаментального механізму обробки мережевого трафіку, здатного ідентифікувати трафік, що має право на особливу обробку і право керувати цими механізмами.

Функціональні можливості QoS покликані задовольнити двох суб'єктів мережі: мережеві програми та мережевих адміністраторів. Вони часто мають суперечності. Адміністратор мережі обмежує ресурси, що використовуються специфічним додатком, в той же час програма намагається захопити якнайбільше мережевих ресурсів. Їхні інтереси можуть бути узгоджені, беручи до уваги той факт, що мережевий адміністратор відіграє чільну роль по відношенню до всіх додатків та користувачів.

Основні параметри QoS

Різні програми мають різні вимоги щодо обробки їх мережевого трафіку. Програми більшою чи меншою мірою терпимі до затримок та втрат трафіку. Ці вимоги знайшли застосування у наступних параметрах, пов'язаних з QoS:

- Bandwidth (смуга пропускання) - швидкість, з якою трафік, що генерується додатком, має бути переданий по мережі;

- Latency (затримка) - затримка, яку програма може допустити в доставці пакета даних;

- Jitter – зміна часу затримки;

- Loss (втрата) – відсоток втрачених даних.

Якби були доступні нескінченні мережеві ресурси, весь трафік програми можна було б передати з необхідною швидкістю, з нульовим часом затримки, нульовим зміною часу затримки і нульовими втратами. Проте мережеві ресурси не безмежні.

Механізм QoS контролює розподіл мережевих ресурсів для трафіку програми, щоб виконати вимоги щодо його передачі.

Фундаментальні ресурси QoS та механізми обробки трафіку

Мережі, які пов'язують хости, використовують різноманітні мережеві пристрої, включаючи мережеві адаптери хостів, маршрутизатори, свічі та хаби. Кожен має мережні інтерфейси. Кожен мережний інтерфейс може прийняти та передати трафік з кінцевою швидкістю. Якщо швидкість, з якою трафік спрямовано інтерфейс, вище, ніж швидкість, з якою інтерфейс передає трафік далі, виникає перевантаження.

Мережеві пристрої можуть обробити стан навантаження, організуючи чергу трафіку в пам'яті пристрою (у буфері), доки перевантаження не пройде. В інших випадках мережеве обладнання може відмовитись від трафіку, щоб полегшити перевантаження. В результаті програми зіштовхуються зі зміною часу очікування (оскільки трафік зберігається в чергах на інтерфейсах) або зі втратою трафіку.

Здатність мережевих інтерфейсів до пересилання трафіку і наявність пам'яті для збереження трафіку в мережевих пристроях (доки трафік не може бути надісланий далі) становлять фундаментальні ресурси, потрібні для забезпечення QoS для потоків трафіку додатків.

Розподіл ресурсів QoS по мережевих пристроях

Пристрої, що підтримують QoS, розумно використовують ресурси мережі передачі трафіку. Тобто трафік додатків, більш терпимих до затримок, стає в чергу (зберігається в буфері пам'яті), а трафік додатків, критичних до затримок, передається далі.

Для виконання цього завдання мережевий пристрій має ідентифікувати трафік шляхом класифікації пакетів, а також мати черги та механізми обслуговування.

Механізм обробки трафіку

Механізм обробки трафіку включає:

- 802.1p;

- диференційовані послуги per-hop-behaviors (diffserv PHB);

- Інтегровані послуги (intserv);

- ATM та ін.

Більшість локальних мереж засновані на технології IEEE 802, включаючи Ethernet, token-ring та ін. 802.1p – це механізм обробки трафіку для підтримки QoS у таких мережах.

802.1p визначає поле (рівень 2 мережної моделі OSI) в заголовку пакета 802, яке може нести одне з восьми значень пріоритету. Як правило, хости або маршрутизатори, посилаючи трафік у локальну мережу, маркують кожен пакет, присвоюючи йому певне значення пріоритету. Передбачається, що мережні пристрої, такі як свічі, мости і хаби, оброблять пакети відповідним чином, використовуючи механізми організації черг. Область застосування 802.1p обмежена локальною мережею (LAN). Як тільки пакет перетинає локальну мережу (через рівень 3 OSI), пріоритет 802.1p видаляється.

Diffserv – це механізм рівня 3. Він визначає поле в рівні 3 заголовка пакетів IP, названих diffserv codepoint (DSCP).

Intserv - це цілий комплекс послуг, що визначає гарантований сервіс та сервіс, що керує завантаженням. Гарантований сервіс обіцяє нести певний обсяг трафіку з вимірюваною та обмеженою затримкою. Сервіс, що керує завантаженням, погоджується нести деякий обсяг трафіку з "появою легкої завантаженості мережі". Це вимірні послуги в тому сенсі, що вони визначені, щоб забезпечити вимірний QoS до певної кількості трафіку.

Оскільки технологія ATM фрагментує пакети відносно маленькі комірки, то вона може запропонувати дуже низький час затримки. Якщо необхідно передати пакет терміново, інтерфейс ATM може завжди звільнятися для передачі на час, який потрібно передати одну комірку.

QoS має ще багато різних складних механізмів, які забезпечують роботу цієї технології. Відзначимо лише один важливий момент: для того, щоб QoS запрацювала, необхідна підтримка цієї технології та відповідне налаштування на всьому протязі передачі від початкової точки до кінцевої.

QoS це можливість мережі забезпечити спеціальний рівень обслуговування для конкретних користувачів або програм без шкоди решті трафіку. Головна мета QoS це забезпечення більш передбачуваної поведінки мережі передачі даних при роботі з тим чи іншим типом трафіку, шляхом забезпечення необхідної смуги пропускання, контролем над затримкою та джиттером та покращенням характеристик при втраті пакетів. Алгоритми QoS досягають цих цілей шляхом обмеження трафіку, більше ефективним використаннямканалів передачі та призначенням тих чи інших політик до трафіку. QoS забезпечує інтелектуальну передачу поверх корпоративної мережі, і, при правильному налаштуванні, покращує показники продуктивності.

Політики QoS

| Тип трафіку | QoS | Безпека | Коли? |

|---|---|---|---|

| Голос | Затримка менше 150 мс в один бік | Шифрування на рівні передачі голосу | Понеділок п'ятниця |

| Система планування ресурсів підприємства | Забезпечення доступної смуги пропускання щонайменше 512 кб/с | Зашифровано | 24 години на добу, 7 днів на тиждень, 365 днів на рік |

| Трафік, що створюється програмним забезпеченнямверстатів та обладнання | Забезпечення доступної смуги пропускання щонайменше 256 кб/с | У відкритому вигляді | Понеділок п'ятниця |

| Трафік від використання інтернет ресурсів HTTP/HTTPS | Негарантована доставка за принципом Best Effort | HTTP проксі сервер | Понеділок – П'ятниця, з 8 ранку до 9 вечора. |

Здійснення QoS у мережах уніфікованих комунікацій

Умовно, процес здійснення QoS у мережах Unified Communications(Уніфікованих комунікацій), можна розділити на 3 етапи:

- Визначення типу трафіку в мережіта його вимог. На даному етапі необхідно навчити мережу визначати типи трафіку, щоб застосовувати до них ті чи інші QoS алгоритми;

- із однаковими вимогами QoS. Наприклад, можна визначити 4 типи трафіку: голос, високо – пріоритетний трафік, низько – пріоритетний трафік та трафік від користування браузером для перегляду WEBсторінок;

- Призначити політики QoS, що застосовуються до класів, визначених у п.2.

У сучасних корпоративних мережах голосовий трафік завжди вимагає мінімальну затримку. Трафік, який генерують критично важливі для бізнесу програми, вимагає маленької затримки (наприклад, інформація, що стосується банківського обслуговування). Інші типи інформації можуть бути не такі чутливі до затримок, наприклад, передача файлів або електронна пошта. Звичайне використанняІнтернету в особистих цілях на роботі може бути також обмежено або навіть заборонено.

Відповідно до зазначених принципів, можна умовно виділити три QoS політики:

- Без затримки:Надається в голосовому трафіку;

- Найкраще обслуговування:Надається до трафіку з найвищим пріоритетом;

- Решта:Надається до низько - пріоритетного і трафіку web - браузерів;

Крок 1: Визначення типу трафіку

Першим кроком на шляху до QoS є ідентифікація типів трафіку в мережі та визначення конкретних вимог кожного з типів. Перед здійсненням QoS, настійно рекомендується провести аудит мережі, щоб повністю розуміти, як і які програми працюють у корпоративній мережі. Якщо здійснити політики QoS не маючи повного розуміння корпоративного сегменту мережі, то результати можуть бути плачевними.

Далі, необхідно визначити проблеми користувачів під час роботи з тими чи іншими мережевими програмами: наприклад, додаток повільно працює через що має погану продуктивністьроботи. Необхідно виміряти мережевий трафік у години найбільшого навантаження, використовуючи спеціальні утиліти. Для розуміння процесів у мережі необхідним кроком є вимірювання завантаження процесора кожного з одиниць активного мережевого обладнанняу період найбільшої завантаженості, щоб чітко знати, де потенційно можуть виникати проблеми.

Після цього необхідно визначити бізнес мети та моделі роботи та скласти список бізнес – вимог. За підсумками цих дій, кожен із пунктів списку можна порівняти з тим чи іншим класом трафіку.

Насамкінець, необхідно визначити рівні обслуговування які потрібні для різного видутрафіку залежно від необхідної доступності та швидкодії.

Крок 2: Згрупувати трафік у класи

Після ідентифікації мережного трафіку необхідно використовувати список бізнес вимог, складений на першому етапі, щоб визначити класи трафіку.

Голосовий трафік завжди визначається окремим класом. Компанія Cisco має розроблені механізми QoS для голосового трафіку, наприклад, Low latency queuing (LLQ), Мета якого полягає в контролі за тим, щоб голос отримував перевагу в обслуговуванні. Після того, як визначено найбільш критичні програми, необхідно визначити класи трафіку використовуючи список бізнес вимог.

Не кожен додаток має власний клас обслуговування. Досить багато додатків зі схожими вимогами до QoS групуються разом у єдиний клас.

Приклад класифікації трафіку

Типовий корпоративний ландшафт визначає 5 класів трафіку:

- Голос:Найвищий пріоритет для трафіку VoIP;

- Критично важливі:Невеликий набір критично важливих для бізнесу програм;

- Транзакції:У даному класі присутні послуги баз даних, інтерактивний трафік і привілейований мережевий трафік;

- Негарантована доставка:Працює за принципом Best Effort, що дослівно перекладається як «краще зусилля». До цього класу можна віднести інтернет трафік та e-mail.

Крок 3: Згрупувати трафік до класів

Третім кроком необхідно описати політики QoS для кожного з класів трафіку, які включають такі дії:

- Призначити мінімальний розміргарантованої смуги пропускання;

- Призначити максимальний розмір смуги пропускання;

- Призначити пріоритети для кожного класу;

- Використати QoS технології, такі як алгоритми контролю черг керувати навантаженнями.

Розглянемо на поточному прикладі визначення політик QoS для кожного класу:

- Голос:Доступна смуга пропускання – 1мбіт/с. Використовувати мітку Differentiated Services Code Poin (DSCP) зі значенням EF . Мітка EF (Expedited Forwarding) означає те, що пакети з таким маркером отримують пріоритет у черзі згідно з принципом найменшої затримки. Додатково використовується алгоритм LLQ;

- Критично важливі:Мінімальна смуга пропускання – 1мбіт/с. Використовувати мітку Differentiated Services Code Poin (DSCP) зі значенням AF31 (мітка в полі DSCP 011010), що забезпечує найменшу ймовірність відкидання пакета. Паралельне використанняалгоритм CBWFQ гарантує необхідну смугу пропускання для маркованого трафіку;

- Негарантована доставка:Максимальна смуга пропускання – 500кбіт/с. Використовувати мітку Differentiated Services Code Poin (DSCP) зі значенням Default (мітка в полі DSCP 000000), що забезпечує стандартне обслуговування. Алгоритм CBWFQ забезпечує «доставку по можливості», яка нижча за пріоритетом класів «Голос» та «Критично важливі».

Чи корисна вам ця стаття?

Будь ласка, розкажіть чому?

Нам шкода, що стаття не була корисна для вас: (Будь ласка, якщо не утруднить, вкажіть з якої причини? Ми будемо дуже вдячні за докладну відповідь. Дякую, що допомагаєте нам стати кращими!