เจ้าของเว็บไซต์จำนวนมากมุ่งเน้นที่การทำให้เนื้อหามีเอกลักษณ์เฉพาะตัวเป็นหลักเมื่อเปรียบเทียบกับแหล่งข้อมูลอื่นๆ อย่างไรก็ตาม คุณไม่ควรมองข้ามการมีอยู่ของเนื้อหาที่ซ้ำกันภายในไซต์เดียวกัน สิ่งนี้มีผลกระทบอย่างมากต่อการจัดอันดับด้วย

เนื้อหาที่ซ้ำกันคืออะไร

เนื้อหาที่ซ้ำหรือซ้ำกันคือกลุ่มข้อความจำนวนมากที่ตรงกันภายในไซต์ในหน้าต่างๆ สิ่งนี้ไม่จำเป็นต้องทำด้วยเจตนาร้าย แต่บ่อยครั้งจะเกิดขึ้นด้วยเหตุผลทางเทคนิค ตามที่อธิบายในรายละเอียดด้านล่าง

อันตรายก็คือเนื้อหาที่ซ้ำกันมักไม่สามารถมองเห็นได้ด้วยตาเปล่า แต่เครื่องมือค้นหาจะมองเห็นได้อย่างสมบูรณ์และตอบสนองตามนั้น

เนื้อหาที่ซ้ำกันมาจากไหนและพบบ่อยที่สุดที่ไหน

สาเหตุหลักของปรากฏการณ์นี้:

- การเปลี่ยนโครงสร้างของไซต์

- การใช้งานโดยเจตนาเพื่อวัตถุประสงค์เฉพาะ (เช่น ฉบับพิมพ์)

- การกระทำที่ผิดพลาดของโปรแกรมเมอร์และเว็บมาสเตอร์

- ปัญหาเกี่ยวกับ CMS

ตัวอย่างเช่น สถานการณ์ทั่วไปเกิดขึ้น: Replytocom (ตอบกลับความคิดเห็น) ใน WordPress จะสร้างหน้าใหม่โดยอัตโนมัติด้วย URL ที่แตกต่างกัน แต่ไม่ใช่เนื้อหา

โดยทั่วไปแล้วจะสังเกตเห็นเนื้อหาที่ซ้ำกันเมื่อสร้างประกาศบทความในหน้าอื่นๆ ของเว็บไซต์ การโพสต์บทวิจารณ์ รวมถึงเมื่อมีคำอธิบายผลิตภัณฑ์ หมวดหมู่ และหัวข้อที่เหมือนกัน

เหตุใดเนื้อหาที่ซ้ำกันจึงไม่ดี

เนื้อหาที่ซ้ำมีอะนาล็อกจากสาขาเศรษฐศาสตร์ - เงินเบิกเกินบัญชีธนาคาร นี่คือที่ซึ่งเรียกว่างบประมาณการรวบรวมข้อมูลถูกใช้ไป นี่คือจำนวนหน้าทรัพยากรที่เครื่องมือค้นหาสามารถรวบรวมข้อมูลในช่วงเวลาที่กำหนด ทรัพยากรนี้มีค่ามากและควรใช้กับหน้าที่สำคัญและเกี่ยวข้องอย่างแท้จริงมากกว่าการใช้ข้อความที่ซ้ำกันหลายสิบครั้ง

ดังนั้นเนื้อหาที่ซ้ำกันจึงทำให้การเพิ่มประสิทธิภาพกลไกค้นหาแย่ลง นอกจากนี้ ลิงก์ตามธรรมชาติจะสูญหายไปและการกระจายลิงก์ไม่ถูกต้องภายในไซต์ และหน้าที่เกี่ยวข้องอย่างแท้จริงก็ถูกแทนที่ด้วย

วิธีค้นหาเนื้อหาที่ซ้ำกันบนเว็บไซต์ (ด้วยตนเอง โปรแกรมและบริการ)

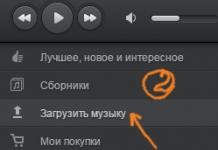

มีโปรแกรมพิเศษสำหรับการวิเคราะห์ทรัพยากร ผู้ใช้เน้นเป็นพิเศษกับ Netpeak Spider ค้นหาสำเนาของหน้าทั้งหมด รายการที่ตรงกันตามชื่อหรือคำอธิบาย หรือส่วนหัว อีกทางเลือกหนึ่งคือ Screaming Frog ซึ่งมีฟังก์ชันการทำงานที่คล้ายคลึงกันและมีความแตกต่างเฉพาะในอินเทอร์เฟซเท่านั้น นอกจากนี้ยังมีแอปพลิเคชัน Link Sleuth ของ Xenu ซึ่งทำงานในลักษณะเดียวกันกับเสิร์ชเอ็นจิ้นและสามารถรวมเว็บไซต์เพื่อหารายการซ้ำได้อย่างมีประสิทธิภาพ

ขออภัย ไม่มีเครื่องมือใดที่สามารถติดตามข้อความที่ซ้ำกันทั้งหมดได้อย่างสมบูรณ์ ดังนั้นจึงเป็นไปได้มากว่าคุณจะต้องทำการตรวจสอบด้วยตนเอง ต่อไปนี้เป็นรายการปัจจัยที่เป็นไปได้ที่ทำให้เกิดปัญหา:

เราพบวิธีค้นหาเนื้อหาที่ซ้ำกัน และผู้ช่วยที่ดีที่สุดในการต่อสู้กับสิ่งนี้คือการเปลี่ยนเส้นทาง 301, แท็ก Canonical URL, คำแนะนำใน robots.txt และพารามิเตอร์ Nofollow และ Noindex ซึ่งเป็นส่วนหนึ่งของเมตาแท็ก "robots"

วิธีหนึ่งในการตรวจสอบอย่างรวดเร็วว่ามีเนื้อหาที่ซ้ำกันบนเว็บไซต์หรือไม่คือการค้นหาขั้นสูงใน Yandex หรือ Google คุณต้องป้อนที่อยู่ไซต์และข้อความจากหน้าที่คุณตัดสินใจตรวจสอบ คุณยังสามารถใช้โปรแกรมมากมายเพื่อตรวจสอบความเป็นเอกลักษณ์ของข้อความ:

- ข้อความ.Ru;

- eTXT ต่อต้านการลอกเลียนแบบ;

- แอดเวโก ปลาเกียตัส;

- เนื้อหา-รับชม

วิธีจัดการและล้างเนื้อหาที่ซ้ำกัน

ระบบช่วยเหลือเดียวกันของ Google ให้คำแนะนำหลายประการเพื่อป้องกันไม่ให้ปัญหานี้เกิดขึ้น

- 301 เมื่อทำการเปลี่ยนแปลงโครงสร้างทรัพยากร คุณต้องระบุการเปลี่ยนเส้นทาง 301 ในไฟล์ htaccess

- ใช้มาตรฐานอ้างอิงเดียว

- เนื้อหาเฉพาะภูมิภาคจะถูกวางไว้ในโดเมนระดับบนสุดดีกว่าในโดเมนย่อยหรือไดเรกทอรีย่อย

- ตั้งค่าวิธีการจัดทำดัชนีที่คุณต้องการโดยใช้ Search Console

- อย่าใช้เทมเพลต แทนที่จะวางข้อความลิขสิทธิ์ในแต่ละหน้า ควรสร้างลิงก์ที่จะนำไปสู่หน้าแยกต่างหากที่มีข้อความนี้

- เมื่อพัฒนาเพจใหม่ ตรวจสอบให้แน่ใจว่าเพจเหล่านั้นปิดจากการจัดทำดัชนีจนกว่าจะพร้อมอย่างเต็มที่

- ทำความเข้าใจอย่างชัดเจนถึงวิธีการแสดงเนื้อหาของคุณ - การแสดงบนบล็อกและฟอรัมอาจแตกต่างกัน

- หากมีบทความที่คล้ายกันหลายบทความบนไซต์ จะเป็นการดีกว่าถ้ารวมเนื้อหาเป็นบทความเดียวหรือแยกแต่ละบทความออกจากกัน

เครื่องมือค้นหาไม่ได้กำหนดมาตรการคว่ำบาตรใดๆ ต่อไซต์ที่มีเนื้อหาที่ซ้ำกันด้วยเหตุผลทางเทคนิค (ไม่เหมือนกับที่กระทำโดยเจตนาเพื่อบิดเบือนผลการค้นหาหรือทำให้ผู้เข้าชมเข้าใจผิด)

หลังจากลบรายการที่ซ้ำกันแล้ว สิ่งที่เหลืออยู่คือการลบออกจากผลการค้นหา Yandex ดำเนินการนี้ด้วยตัวเอง โดยที่ไฟล์ robots.txt ได้รับการกำหนดค่าอย่างถูกต้อง สำหรับ Google: คุณจะต้องตั้งกฎด้วยตนเองในเว็บมาสเตอร์บนแท็บ "พารามิเตอร์ URL"

บทสรุป

การต่อสู้กับเนื้อหาที่ซ้ำกันบนเว็บไซต์ถือเป็นสิ่งสำคัญในกิจกรรมของเจ้าของเว็บไซต์ มีเหตุผลบางประการที่ทำให้เกิดเหตุการณ์ดังกล่าว และมีหลายวิธีในการกำจัดมัน

อย่างไรก็ตาม กฎหลักยังคงอยู่: โพสต์เนื้อหาต้นฉบับโดยเฉพาะ โดยไม่คำนึงถึงประเภทของไซต์ ถึงแม้จะเป็นร้านลูกโซ่ขนาดใหญ่ที่มีเพจนับพันเพจก็ตาม

รับประกาศโพสต์ที่คล้ายกันไปยังอีเมลของคุณ

สมัครสมาชิกและรับสิ่งที่น่าสนใจไม่เกินสัปดาห์ละครั้งจากโลกแห่งการตลาดทางอินเทอร์เน็ต, SEO, การโปรโมตเว็บไซต์, ร้านค้าออนไลน์, สร้างรายได้บนเว็บไซต์

“ฉันได้สัมผัสหัวข้อของหน้าที่ซ้ำกันแล้ว และวันนี้เราจะพูดถึงรายละเอียดเพิ่มเติมเกี่ยวกับเรื่องนี้

เกิดอะไรขึ้น หน้าที่ซ้ำกัน- หน้าเหล่านี้เป็นหน้าที่มีข้อความคล้ายกันหรือเหมือนกันใน URL ที่ต่างกัน ตัวอย่างเช่น การซ้ำกันของหน้าหลักของทรัพยากรที่พบบ่อยมาก

ด้านล่างนี้เราจะดูตัวเลือกทั่วไปหลายประการสำหรับการทำซ้ำเนื้อหา แต่ตอนนี้เรามาพูดถึงผลกระทบที่ตัวเลือกเหล่านั้นกัน หน้าที่คล้ายกันสำหรับการโปรโมทเว็บไซต์

เสิร์ชเอ็นจิ้นได้เรียนรู้มานานแล้วในการกำหนดเอกลักษณ์ของข้อความตามลำดับอักขระนั่นคือโดยประโยคที่แต่งเหมือนกันซึ่งใช้ลำดับตัวอักษรและช่องว่าง หากเนื้อหาไม่ซ้ำกัน (ถูกขโมย) หุ่นยนต์จะเข้าใจได้ง่าย และเมื่อข้อความที่ไม่ซ้ำกันเกิดขึ้นบ่อยครั้ง โอกาสที่ทรัพยากรดังกล่าวจะตกอยู่ภายใต้ตัวกรอง AGS ก็ค่อนข้างสูง

ลองจินตนาการถึงการทำงานของหุ่นยนต์ค้นหา เมื่อเยี่ยมชมเว็บไซต์ สิ่งแรกที่เขาดูคือไฟล์ robots.txtและได้รับคำแนะนำจากเขาว่า สิ่งใดที่ต้องจัดทำดัชนี และสิ่งใดที่ปิดการทำดัชนี การดำเนินการถัดไปคือการเข้าถึงไฟล์ sitemap.xml ซึ่งจะแสดงให้หุ่นยนต์เห็นแผนผังเว็บไซต์พร้อมเส้นทางที่อนุญาตทั้งหมด อ่านบทความ - “ไฟล์ Sitemap.xml สำหรับเครื่องมือค้นหา Google และ Yandex” เมื่อได้รับข้อมูลที่จำเป็นทั้งหมดแล้ว หุ่นยนต์ก็เริ่มทำงานตามปกติ

เมื่อเยี่ยมชมหน้าใดหน้าหนึ่ง เขาจะ "ดูดซับ" เนื้อหาในหน้านั้นและเปรียบเทียบกับข้อมูลที่มีอยู่ในสมองอิเล็กทรอนิกส์ของเขา ซึ่งรวบรวมมาจากอินเทอร์เน็ตอันกว้างใหญ่ไพศาล เมื่อตรวจพบข้อความที่ไม่ซ้ำกัน เครื่องมือค้นหาจะไม่จัดทำดัชนีหน้านี้ และจะจดบันทึกลงในสมุดบันทึกโดยระบุ URL ที่ "ละเมิด" อย่างที่คุณอาจเดาได้แล้วเขาจะไม่กลับมาหน้านี้อีกเพื่อไม่ให้เสียเวลาอันมีค่าของเขา

สมมติว่าหน้าเว็บมีลักษณะเฉพาะสูงและโรบอตได้จัดทำดัชนีไว้แล้ว แต่หลังจากติดตาม URL ถัดไปของทรัพยากรเดียวกัน มันก็จบลงที่หน้าเว็บที่มีข้อความคล้ายกันทั้งหมดหรือบางส่วน เครื่องมือค้นหาจะทำอะไรในสถานการณ์เช่นนี้? แน่นอนว่าเขาจะไม่จัดทำดัชนีการทดสอบที่คล้ายกัน แม้ว่าการทดสอบต้นฉบับจะอยู่บนไซต์เดียวกัน แต่อยู่ที่ URL อื่นก็ตาม หุ่นยนต์อาจจะไม่พอใจกับเวลาที่เสียไปและจะจดบันทึกไว้ในสมุดบันทึกอย่างแน่นอน ขอย้ำอีกครั้ง หากเหตุการณ์ดังกล่าวเกิดขึ้นซ้ำๆ ทรัพยากรอาจไม่เป็นที่โปรดปรานของเครื่องมือค้นหา

ข้อสรุปหมายเลข 1หน้าที่คล้ายกันซึ่งอยู่ใน URL ที่แตกต่างกันจะใช้เวลาที่กำหนดให้กับโรบ็อตในการจัดทำดัชนีไซต์ ยังคงไม่สร้างดัชนีหน้าที่ซ้ำกัน แต่จะใช้เวลาส่วนหนึ่งในการทำความคุ้นเคยกับหน้าเหล่านั้น และอาจไม่มีเวลาเข้าถึงเนื้อหาที่ไม่ซ้ำใครอย่างแท้จริง

ข้อสรุปหมายเลข 2เนื้อหาที่ซ้ำกันจะส่งผลเสียต่อการโปรโมตเว็บไซต์ของคุณในเครื่องมือค้นหา เครื่องมือค้นหาไม่ชอบข้อความที่ไม่ซ้ำใคร!

ข้อสรุปหมายเลข 3คุณควรตรวจสอบโปรเจ็กต์ของคุณเพื่อหาหน้าที่ซ้ำกันเพื่อหลีกเลี่ยงปัญหาที่ระบุไว้ข้างต้น

หลายๆ คนไม่สนใจเกี่ยวกับ "ความบริสุทธิ์" ของเนื้อหาเลย ด้วยความอยากรู้อยากเห็น ฉันจึงตรวจสอบเว็บไซต์หลายแห่งและค่อนข้างแปลกใจกับสถานะของหน้าที่ซ้ำกัน ในบล็อกของผู้หญิงคนหนึ่ง ฉันไม่พบไฟล์ robots.txt เลย

จำเป็นต้องต่อสู้กับเนื้อหาที่ซ้ำกันอย่างจริงจังและเริ่มต้นด้วยการระบุเนื้อหาเหล่านั้น

ตัวอย่างของเนื้อหาที่ซ้ำกันทั่วไปและวิธีการแก้ไขปัญหา

หน้าหลักซ้ำกัน ตัวอย่าง:

- http://site.com

- http://site.com/index.php

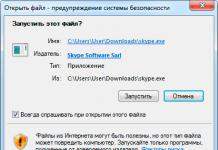

ในกรณีนี้ ปัญหาได้รับการแก้ไขโดยใช้การเปลี่ยนเส้นทาง 301 ซึ่งเป็น “คำสั่ง” สำหรับเซิร์ฟเวอร์ผ่านไฟล์ .htaccess

อีกตัวอย่างหนึ่งของหน้าแรกที่ซ้ำกัน:

- http://site.com

- http://www.site.com

เพื่อหลีกเลี่ยงความซ้ำซ้อนดังกล่าว คุณสามารถลงทะเบียนมิเรอร์หลักของไซต์ในไฟล์ได้ robots.txtในคำสั่ง - "เจ้าภาพ"สำหรับยานเดกซ์:

- โฮสต์: site.com

และยังใช้ประโยชน์อีกด้วย 301 เปลี่ยนเส้นทางและชี้เครื่องมือค้นหา Yandex และ Google ไปที่กระจกหลักของเว็บไซต์โดยใช้เครื่องมือของผู้ดูแลเว็บ

ตัวอย่างของโฮมเพจที่ซ้ำกันซึ่งเกือบจะทำให้ฉันทึ่งเมื่อค้นหาวิธีแก้ปัญหามีลักษณะดังนี้:

- http://site.com

- http://site.com/

ฉันอ่านเจอว่ามีเครื่องหมายทับที่ส่วนท้ายของลิงก์ไปยังหน้าหลักทำให้เกิดการซ้ำกัน และเครื่องมือค้นหารับรู้ถึงลิงก์ที่มีและไม่มีเครื่องหมายทับเป็น URL ที่แตกต่างกันซึ่งนำไปสู่หน้าที่มีข้อความเดียวกัน สิ่งที่ทำให้ฉันกังวลไม่ใช่ความเป็นไปได้ที่จะทำซ้ำ แต่เป็นการลดน้ำหนักของหน้าหลักในสถานการณ์เช่นนี้

ฉันเริ่มขุด เมื่อมีการร้องขอไปยังเซิร์ฟเวอร์ที่ URL ข้างต้น ฉันได้รับรหัสตอบกลับ 200 รหัส 200 หมายถึง - "คำขอของผู้ใช้ได้รับการประมวลผลเรียบร้อยแล้วและการตอบกลับ เซิร์ฟเวอร์มีข้อมูลที่ร้องขอ" ต่อจากนี้ไปก็ยังเป็นสองเท่าบนใบหน้า

ฉันพยายามเปลี่ยนเส้นทาง 301 (เปลี่ยนเส้นทาง) แต่คำสั่งไม่ทำงานและฉันยังคงได้รับรหัสตอบกลับ 301 ที่ต้องการ วิธีแก้ปัญหาคือไม่มีปัญหาในตัวมันเอง นี่คือการเล่นสำนวน ปรากฎว่าเบราว์เซอร์สมัยใหม่เองแทรกอักขระ "/" ที่ท้ายบรรทัด ทำให้มองไม่เห็น ซึ่งจะทำให้สองเท่าเป็นไปไม่ได้โดยอัตโนมัติ แบบนี้!

อีกตัวอย่างหนึ่งของหน้าหลักที่ซ้ำกัน:

- http://site.com

- https://site.com

มีหลายครั้งที่ลิงก์ภายใต้โปรโตคอล https:// ที่ปลอดภัยไปจบลงในดัชนี เนื่องจากข้อผิดพลาดของผู้ดูแลเว็บหรือเครื่องมือค้นหาขัดข้อง หรือภายใต้สถานการณ์อื่นๆ จะทำอย่างไรในกรณีเช่นนี้และจะหลีกเลี่ยงสิ่งนี้ในอนาคตได้อย่างไร? แน่นอน คุณต้องลบลิงก์ที่มีโปรโตคอล https:// ออกจากการค้นหา แต่คุณจะต้องดำเนินการด้วยตนเองโดยใช้เครื่องมือของผู้ดูแลเว็บ:

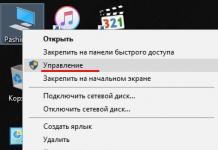

ในเครื่องมือค้นหา Yandex ผู้ดูแลเว็บ — เว็บไซต์ของฉัน — ลบ URL:

สำคัญ !คำสั่งที่เขียนในไฟล์ robots.txt ห้ามมิให้โรบ็อตการค้นหาสแกนข้อความ ซึ่งป้องกันไซต์จากการทำซ้ำ แต่คำสั่งเดียวกันไม่ได้ห้ามการจัดทำดัชนี URL ของหน้า

อ่านเพิ่มเติมในบทความ:

มีอีกวิธีที่มีประสิทธิภาพพอสมควรในการระบุ "โคลน" โดยใช้เครื่องมือค้นหาด้วยตนเอง ใน Yandex คุณต้องป้อนในช่องค้นหา: link.site.com “ส่วนทดสอบ”ตัวอย่าง:

ยานเดกซ์พบรายการที่ตรงกัน 2 รายการเนื่องจากฉันไม่ได้บล็อกหมวดหมู่จากการจัดทำดัชนีดังนั้นจึงมีรายการที่ตรงกับประกาศในหน้าหลัก แต่ถ้าสำหรับบล็อกการทำอาหารการมีส่วนร่วมของหมวดหมู่ในการค้นหานั้นสมเหตุสมผลแล้วสำหรับหัวข้ออื่น ๆ เช่น SEO ก็ไม่จำเป็นต้องเป็นเช่นนั้นและจะเป็นการดีกว่าถ้าปิดหมวดหมู่จากการจัดทำดัชนี

คุณสามารถตรวจสอบโดยใช้การค้นหาของ Google ได้ดังนี้: site:site.com “ส่วนของข้อความ”ตัวอย่าง:

โปรแกรมและบริการออนไลน์สำหรับการค้นหาเนื้อหาที่ซ้ำกันภายในและภายนอกโดยใช้ส่วนของข้อความ

ในบทความนี้ฉันจะไม่ทำการตรวจสอบโดยละเอียดเกี่ยวกับโปรแกรมและบริการยอดนิยม แต่จะเน้นเฉพาะที่ตัวฉันเองใช้อยู่ตลอดเวลา

หากต้องการค้นหารายการที่ซ้ำกันภายในและภายนอกฉันขอแนะนำให้คุณใช้บริการออนไลน์ที่ www.miratools.ru นอกจากการตรวจสอบข้อความแล้ว บริการยังมีฟีเจอร์ที่น่าสนใจอีกมากมาย

โปรแกรมสำหรับค้นหารายการที่ซ้ำกัน - Advego Plagiatus โปรแกรมดังมาก ส่วนตัวผมใช้มาตลอด ฟังก์ชั่นของโปรแกรมนั้นเรียบง่าย หากต้องการตรวจสอบข้อความ เพียงคัดลอกและวางลงในหน้าต่างโปรแกรมแล้วคลิกที่เริ่ม

หลังจากการตรวจสอบแล้ว จะมีการนำเสนอรายงานเกี่ยวกับความเป็นเอกลักษณ์ของข้อความที่ถูกตรวจสอบเป็นเปอร์เซ็นต์พร้อมลิงก์ไปยังแหล่งที่มาของรายการที่ตรงกัน:

นอกจากนี้ ส่วนของข้อความเฉพาะที่โปรแกรมพบว่าตรงกันจะถูกเน้นด้วยพื้นหลังสีเหลือง:

โปรแกรมที่ดีมาก ใช้งานและอย่าลืมสมัครรับข้อมูลอัปเดตบล็อก

พบกันใหม่!

ขอแสดงความนับถือ, คิริลลอฟ วิทาลี

1. ความรู้เบื้องต้นเกี่ยวกับปัญหา

ปัจจุบันปัญหาการทำซ้ำข้อมูลบนอินเทอร์เน็ตมีความรุนแรงมากขึ้นเรื่อยๆ บ่อยครั้งที่การทำซ้ำดังกล่าวเกิดขึ้นโดยเจตนาซึ่งเป็นการละเมิดลิขสิทธิ์ ผู้โจมตีใช้เนื้อหาที่มีลิขสิทธิ์เพื่อสร้างเว็บไซต์ของตนเองเพื่อผลประโยชน์ของตนเอง

ความซ้ำซ้อนของข้อมูลนี้ทำให้ผลลัพธ์ของเครื่องมือค้นหาแย่ลงซึ่งเป็นผลมาจากการที่ฝ่ายหลังกำลังต่อสู้กับปรากฏการณ์นี้อย่างแข็งขัน แท้จริงแล้ว หากผู้ใช้ได้รับเอกสารที่เหมือนกัน 10 ฉบับตามคำขอ (“ข้อมูลระบุตัวตน” ถูกกำหนดโดยผู้ใช้โดย ) ก็ไม่น่าจะเพิ่มความนิยมให้กับเครื่องมือค้นหาได้ เมื่อหลายปีก่อนมีการสังเกตสถานการณ์ดังกล่าวใน Rambler ซึ่งส่งผลให้เครื่องมือค้นหาสูญเสียส่วนหนึ่งของการจัดอันดับ อย่างไรก็ตาม ตอนนี้ Rambler จะกรองและซ่อนรายการที่ซ้ำกัน

ควรสังเกตว่าเนื้อหาที่ซ้ำกันอุดตันดัชนีของเครื่องมือค้นหา ทำให้ยากต่อการให้คำตอบอย่างรวดเร็วแก่ผู้ใช้ ในเวลาเดียวกัน เอกสารทั้งหมดจำเป็นต้องได้รับการจัดทำดัชนีอย่างสม่ำเสมอ และการปรากฏตัวของเอกสารใหม่ที่มีเนื้อหาที่ไม่ใช่ต้นฉบับจะส่งผลเสียต่อความเร็วในการจัดทำดัชนีอย่างชัดเจน

2. ทฤษฎีการกำหนด “การซ้ำซ้อนคลุมเครือ”

ก. “การถ่ายแบบคลุมเครือ” คืออะไร

ก่อนอื่นคุณต้องตัดสินใจเกี่ยวกับคำศัพท์ ยังไม่มีความเห็นพ้องต้องกันในเรื่องนี้ ดังนั้นคำศัพท์นี้จึงอิงตามสามัญสำนึกเท่านั้น

เอกสารเว็บสองเท่า (ซ้ำกัน)– สำเนาเอกสารเว็บที่ถูกต้อง “สำเนาเลือน” ของเอกสารเว็บ– เอกสารเว็บที่มีการเปลี่ยนแปลงบางส่วนในเนื้อหาและ/หรือการจัดรูปแบบ (ใช้แท็ก html อื่นเพื่อออกแบบเพจ)

เราจะตีความ "เอกสารเว็บที่ซ้ำกัน" จากมุมมองของเครื่องมือค้นหาเท่านั้น ไม่ใช่จากผู้ใช้ ดังนั้นเราจะไม่พิจารณาปรากฏการณ์ดังกล่าวว่า "การเขียนคำโฆษณา" เช่น การเขียนข้อความใหม่สำหรับเครื่องมือค้นหาโดยเฉพาะโดยใช้คำต่างกัน แต่ยังคงความหมายทั่วไป ข้อความดังกล่าวจะเป็นต้นฉบับสำหรับเครื่องมือค้นหาเสมอเพราะว่า คอมพิวเตอร์ยังไม่สามารถแยกแยะความหมายของข้อความได้

มีวิธีการพื้นฐานหลายประการในการระบุรายการที่ซ้ำกัน

ข. วิธีการใช้คำพรรณนา

วิธีนี้ใช้ได้ผลตามหลักการดังต่อไปนี้

ขั้นแรก สร้างตัวอย่างขนาดเล็ก (ประมาณ 2,000-3,000 คำ) ตัวอย่างต้องเป็นไปตามเงื่อนไขต่อไปนี้:

ด้วยความช่วยเหลือนี้ คุณสามารถอธิบายเอกสารเกือบทุกชนิดบนอินเทอร์เน็ตได้อย่างสมบูรณ์

- คำอธิบายของเอกสารไม่ควรซ้ำซ้อน

ดังนั้นในการจัดทำตัวอย่าง คุณจะต้องละทิ้งคำที่พบบ่อยที่สุดและน้อยที่สุด เช่น อย่าคำนึงถึงคำหยุดและคำศัพท์เฉพาะเรื่องที่แคบต่างๆ นอกจากนี้ คำคุณศัพท์จะไม่รวมอยู่ในตัวอย่าง เนื่องจากคำเหล่านี้ไม่มีความหมายในภาษารัสเซีย

ถัดไปแต่ละเอกสารจะถูกเปรียบเทียบกับตัวอย่างและคำนวณเวกเตอร์ซึ่งมีมิติเท่ากับจำนวนคำในตัวอย่าง ส่วนประกอบเวกเตอร์สามารถรับค่าได้ 2 ค่า ได้แก่ 0 หรือ 1 0 – หากคำจากตัวอย่างไม่อยู่ในเอกสาร 1 – หากคำนั้นปรากฏในเอกสาร ถัดไป เอกสารจะถูกตรวจสอบการทำซ้ำโดยการเปรียบเทียบเวกเตอร์

เมื่อใช้อัลกอริทึมนี้ Yandex จะระบุรายการที่ซ้ำกันแบบคลุมเครือ

ค. วิธีงูสวัด

วิธีการงูสวัดมีดังนี้ “เช็คซัม” ได้รับการคำนวณสำหรับห่วงโซ่ย่อยทั้งหมดของข้อความที่วิเคราะห์ เช็คซัม (หรือ "ลายเซ็น") คือตัวเลขเฉพาะที่เกี่ยวข้องกับข้อความและ/หรือฟังก์ชันในการคำนวณ ฟังก์ชั่นการคำนวณเช็คซัมอาจมีหลายเป้าหมาย: ตัวอย่างเช่น "ไม่แยก" (ลดโอกาสที่ข้อความต้นฉบับสามารถเดาได้จากค่าเช็คซัม) หรือ "ไม่ทำซ้ำ" (ลดโอกาสที่ข้อความสองฉบับจะมีค่าเหมือนกันน้อยที่สุด เช็คซัม)- นิตยสารอิเล็กทรอนิกส์ "Spamtest" ฉบับที่ 27.

โดยปกติจะใช้อัลกอริธึมต่อไปนี้สำหรับการคำนวณเช็คซัม: fnv, md5, crc หลังจากคำนวณเช็คซัมแล้ว ระบบจะสุ่มตัวอย่างจากชุดผลลัพธ์ จากตัวอย่างนี้ สามารถเปรียบเทียบเอกสารกับเอกสารอื่นๆ ที่ได้คำนวณตัวอย่างไว้ล่วงหน้าด้วย

วิธีการคำนวณนี้ค่อนข้างใช้ทรัพยากรมากและสามารถหลีกเลี่ยงได้โดยการเปลี่ยนข้อความเล็กน้อย เนื่องจากก่อนอื่นโรคงูสวัดขึ้นอยู่กับระยะห่างระหว่างคำ

ขณะนี้วิธีการมุงหลังคาได้พัฒนาไปสู่อัลกอริธึม "super shingle" ซึ่งใช้ชุดเช็คซัมที่จำกัด การทดลองที่ ROMIP นำไปสู่ผลลัพธ์ดังต่อไปนี้ - 84 งูสวัด, 6 งูสวัดซุปเปอร์มากกว่า 14 งูสวัดในแต่ละ ข้อความจะถือว่าตรงกันหากมีงูสวัดอย่างน้อยสองตัวจากทั้งหมด 6 รายการ

เจ้าหน้าที่ระบุซ้ำแล้วซ้ำอีกว่ายานเดกซ์ไม่ใช่ผู้ตรวจสอบและจะไม่ต่อสู้ ปัญหาการโจรกรรมเนื้อหาออนไลน์.

นี่คือคำตอบอย่างเป็นทางการจาก A. Sadovsky:

... การค้นหายานเดกซ์เมื่อตรวจพบรายการที่ซ้ำกันจะพยายามระบุเอกสารต้นฉบับ แน่นอนว่าอัลกอริธึมที่มีอยู่นั้นไม่สมบูรณ์ และเรากำลังดำเนินการปรับปรุงให้ดีขึ้น ในส่วนของกฎระเบียบทางกฎหมาย เสิร์ชเอ็นจิ้นยังไม่สามารถระบุผู้เขียนข้อความได้ หากการดัดแปลงเนื้อหาถูกลบออกจากเครือข่าย (เช่น อันเป็นผลมาจากการกระทำของผู้ถือลิขสิทธิ์) ยานเดกซ์ก็จะลบเนื้อหานั้นออกจากฐานข้อมูลในขณะที่หุ่นยนต์ทำการรวบรวมข้อมูล กระบวนการนี้สามารถเร่งรัดได้โดยใช้แบบฟอร์ม http://webmaster.yandex.ru/delurl.xml

ตอนนี้เรามาดูกันว่า "เอกสารที่ซ้ำกัน" สำหรับยานเดกซ์คืออะไร? ผู้เขียนเสนอการตีความดังต่อไปนี้ (หากคุณคุ้นเคยกับข้อความด้านล่างอย่าคิดแย่ผู้เขียนเมื่อไม่นานมานี้ได้พยายามพูดคุยถึงปัญหานี้ในฟอรัม)))

การทำซ้ำมีสองประเภท: "การทำซ้ำแบบคลุมเครือ" และ "การทำซ้ำแบบสมบูรณ์"

"การซ้ำซ้อนที่ไม่ชัดเจน" ขึ้นอยู่กับตัวอย่าง เช่น ถูกกำหนดโดยคำขอของผู้ใช้จริงๆ สิ่งนี้เกิดขึ้นดังนี้

1. ผู้ใช้ตั้งค่าคำขอ

2. ยานเดกซ์คำนวณความเกี่ยวข้องของไซต์กับคำขอและจัดอันดับไซต์ แต่ยังไม่ได้แสดงต่อผู้ใช้

3. ถัดไป ยานเดกซ์จะเปรียบเทียบตัวอย่างของเอกสารที่เลือกเพื่อระบุรายการที่ซ้ำกัน (บางทีอาจมีการเปรียบเทียบตัวอย่างโดยใช้วิธีงูสวัด)

4. และในที่สุดก็สร้างผลลัพธ์ที่กรอง โดยลบข้อมูลที่ซ้ำกันบางส่วนออก (โดยหลักการใดที่เอกสารบางฉบับที่เหลือไม่ชัดเจน บางทีอาจเลือกเอกสารที่เกี่ยวข้องมากที่สุด และนอกจากนั้น เอกสารที่คล้ายคลึงกันน้อยที่สุดก็รวมอยู่ในผลลัพธ์ด้วย บางทีเพียงเท่านั้น การอ้างอิงมีบทบาทในสภาพแวดล้อมของไซต์บทบาท)

การมีอยู่ของตัวกรองประเภทนี้ได้รับการพิสูจน์ทางอ้อมโดยคำพูดของ Sadovsky (โพสต์หมายเลข 9) และความจริงที่ว่าผลลัพธ์ที่มีการตั้งค่าการค้นหาที่แตกต่างกัน (โดยเฉพาะจำนวนส่วนที่แสดงพร้อมกับคำค้นหา) นั้นแตกต่างกัน

ด้วยการตั้งค่า "แสดงไม่เกิน 5 ส่วน" ทำให้มีไซต์ในผลการค้นหามากกว่าการตั้งค่า "แสดงไม่เกิน 1 ส่วน" มาลองใช้แบบสอบถาม“ ใน & วินาที & บท & นามธรรม & ทุ่มเทให้กับ & การปฏิบัติ & การตลาด & กิจกรรม & องค์กร & บน & ตัวอย่าง & เซิร์ฟเวอร์ & dux” (แบบสอบถามถูกตั้งค่าโดยไม่มีเครื่องหมายคำพูด!) - ในกรณีแรก (แสดง 1 แฟรกเมนต์ในตัวอย่าง) ในไซต์เอาต์พุต 21 ในส่วนที่สอง (5 แฟรกเมนต์) – 27 ไซต์

ทุกอย่างที่นี่มีเหตุผล - เมื่อมีการแสดงข้อความเดียวในตัวอย่างข้อมูล ตัวอย่างจะคล้ายกันมากกว่าเมื่อมีการแสดง 5 ข้อความในตัวอย่างข้อมูล ตัวอย่างเช่น ในกรณีที่สอง ตัวอย่างข้อมูลของไซต์ที่สองแตกต่างจากตัวอย่างข้อมูลของไซต์ที่หนึ่งและสาม

ตอนนี้เรามาจัดการกับ "การทำซ้ำโดยสมบูรณ์" ผู้เขียนเชื่อว่ารายการซ้ำดังกล่าวจะถูกกำหนด ณ เวลาที่จัดทำดัชนีเพจ สะดวกเนื่องจากช่วยให้คุณสามารถตัดขยะออกได้ทันทีและไม่เพิ่มข้อมูลที่ซ้ำกันลงในฐานข้อมูลเครื่องมือค้นหา

วิธีการระบุรายการที่ซ้ำกันคือ "วิธีการอธิบาย" (ตามที่กล่าวไว้ข้างต้น)

หน้าที่ระบุว่าซ้ำกันโดยสมบูรณ์จะถูกโยนออกจากฐานข้อมูล สิ่งนี้มักเกิดขึ้นกับหน้าต่างๆ ของไซต์หนึ่ง (เช่น แค็ตตาล็อกผลิตภัณฑ์ เมื่อมีข้อมูลที่มีความหมายน้อยกว่าคำในส่วนการนำทาง) ไม่ทราบว่ายานเดกซ์ทิ้งข้อมูลที่ซ้ำกันบางอย่างบนพื้นฐานใด ส่วนใหญ่จะขึ้นอยู่กับการรวมกันของสัญญาณเช่น: ปัจจัยชั่วคราว "การจัดอันดับทรัพยากร" ความไว้วางใจในทรัพยากร ฯลฯ

ยานเดกซ์ระบุแหล่งที่มาดั้งเดิมอย่างไรในกรณีที่ตรวจพบ "รายการซ้ำที่ไม่ชัดเจน" และจะระบุหรือไม่ ลองคิดดูสิ...

ก่อนอื่น เรามาเน้นปัจจัยที่อาจบ่งบอกถึงแหล่งที่มาดั้งเดิมของเนื้อหา...

วันที่สร้างเอกสาร

- ความเกี่ยวข้องของเอกสารกับการร้องขอ

- "ไว้วางใจในทรัพยากร" (ตัวอย่างเช่น คุณสามารถเชื่อถือทรัพยากรที่มีตำแหน่งที่ดีในแคตตาล็อกยานเดกซ์และมีปริมาณการใช้ข้อมูลสูงได้มากที่สุด)

- การเชื่อมโยงระหว่างสำเนา (เช่น ถ้าสำเนาทั้งหมดอ้างอิงถึงเอกสารเดียวกัน แสดงว่าเป็นแหล่งต้นฉบับ)

มาทดลองกันสักหน่อย มาดูหน้า href=http://zoom.cnews.ru/ru/publication/index.php?art_id80=1523 และวลี "การออกแบบของ Lumix FZ50 นั้นคล้ายคลึงกับ FZ30 รุ่นก่อนที่มีความละเอียด 8 ล้านพิกเซล" นี่มันต้นฉบับชัดๆ ตอนนี้เรามาดูกันว่าใครบ้างที่ใช้ข้อความในบทความ: มาตั้งค่าแบบสอบถามโดยใช้พารามิเตอร์ rd=0 กันดีกว่า หากไม่มี rd ในผลการค้นหาเฉพาะไซต์หมายเลข 1 และหมายเลข 5

ลักษณะของเว็บไซต์มีดังนี้ (โปรดทราบว่าลิงก์ไปยังหน้าแรกเท่านั้น ส่วนที่เหลือไม่มีลิงก์ย้อนกลับ):

| สตานิตซา | ติค | ส่วนแคตตาล็อก | ประชาสัมพันธ์ | หน้าประชาสัมพันธ์ |

| Zoom.cnews.ru/ru/publication/index.php?art_id80=1523 | 3800 | ใช่ | 6 | 4 |

| www.neograd.ru/firsttimers/howtofind_1/panasonic/test_panasonic_fz50 | 170 | ใช่ | 5 | 0 |

| www.apitcomp.ru/analytic/genre3/page637 | 700 | ใช่ | 4 | 0 |

| www.toplist.ru/card/35859 | 110 | เลขที่ | 3 | 0 |

| foto-focus.ru/forum/showthread.php?mode=hybrid&t=316 | 0 | เลขที่ | 1 | 0 |

| nmp4.ru/index.php?act=Print&client=printer&f=223&t=3323 | 0 | เลขที่ | 0 | 0 |

| www.media.nrd.ru/index.php?showtopic=3323&st=100 | 40 | เลขที่ | 0 | 0 |

| www.ledshop.ru/cgi-bin/nph-proxy.cgi/010110A/http/zoom.cnews.ru/ru/publication/index.php=3fart_id80=3d1523 | 0 | เลขที่ | 0 | 0 |

โปรดทราบว่าตัวอย่างข้อมูลสำหรับไซต์ทั้งหมดจะเหมือนกัน

เมื่อมองแวบแรกยังไม่ชัดเจนเลยว่าทำไมยานเดกซ์จึงกรองไซต์ทั้งหมดยกเว้นไซต์ที่ห้า ชัดเจนว่าไซต์ดังกล่าวไม่น่าเชื่อถือในสายตาของยานเดกซ์ มันจะสมเหตุสมผลกว่าถ้าออกจากหน้าเว็บไซต์ www.apitcomp.ru ในผลการค้นหา - ไซต์นั้นน่าเชื่อถือมากกว่าหรือออกจากหน้าจากฟอรัม (ตำแหน่ง 6 และ 7)

ในทำนองเดียวกัน ให้ตรวจสอบหน้า http://www.3dnews.ru/digital/lumix_fz50/ และวลี “ในยุคของเรา เมื่อผู้ซื้อโหยหาคุณลักษณะที่ดี” ไซต์ที่แสดงโดยไม่มี rd=0 จะถูกเน้นด้วยตัวหนา และแหล่งที่มาจะเป็นสีแดง ซึ่งยังไงก็ตาม จะถูกกรองออก!

| หน้าหนังสือ | ติค | ยาก้า | แอล.เอส. | ห้างหุ้นส่วนจำกัด | ประชาสัมพันธ์ | เพจประชาสัมพันธ์ |

| ดาวเสาร์-plus.ru/ | 70 | ใช่ | 54 | 20349 | 3 | 3 |

| saturn.24online.ru/ | 0 | เลขที่ | 1 | 1 | 0 | 0 |

| www.3dnews.ru/digital/lumix_fz50/print | 11000 | ใช่ | 0 | 0 | 6 | 2 |

| fotomag.com.ua/handbook14.html | 400 | ใช่ | 0 | 0 | 4 | 0 |

| Deshevshe.net.ua/ua/review-73/4.html | 80 | เลขที่ | 0 | 0 | 4 | 0 |

| Ephotolink.ru/?mod=articles&act=show&sort=date&page=9 | 1400 | ใช่ | 0 | 0 | 4 | 1 |

| mobil-up.com/tsifra/foto/novoe_pokolenie_ultrazumov_ot_panasonic.html | 0 | เลขที่ | 0 | 0 | 0 | 0 |

| uaport.net/UAit/?CGIQUERY=0&lang=RUS&cli=1&dtb=146&... | 4300 | ใช่ | 0 | 0 | 6 | 0 |

| www.velc.ru/podderjka/stati/lumix_fz50/ | 120 | ใช่ | 0 | 0 | 3 | 0 |

| Ephotolink.tkat.ru/?mod=articles&id_article=21007 | 10 | เลขที่ | 0 | 0 | 3 | 0 |

| www.ru-coding.com/rss.php?p=501 | 130 | ใช่ | 0 | 0 | 3 | 0 |

| www.toprunet.com/article.php?id=6388 | 200 | เลขที่ | 0 | 0 | 3 | 0 |

| www.dphotographer.com.ua/camera/from/2/ | 90 | เลขที่ | 0 | 0 | 4 | 0 |

| www.asmedia.ru/news/id8242.html | 400 | เลขที่ | 0 | 0 | 3 | 0 |

| www.mega-bit.ru/obzor/read/?id=70 | 40 | เลขที่ | 0 | 0 | 3 | 0 |

| www.audiovideophoto.ru/panasonic1.html | 0 | เลขที่ | 0 | 0 | 0 | 0 |

| www.foto-piter.ru/news/2006/12/01/127/ | 10 | เลขที่ | 0 | 0 | 2 | 0 |

| www.megastoke.ru/item951928/panasonic-lumix-dmc-fz50.html | 20 | เลขที่ | 0 | 0 | 1 | 0 |

| www.novoe.nnov.ru/articles/?parent_id=33 | 0 | เลขที่ | 0 | 0 | 0 | 0 |

| iwy.com.ua/top.php?p=326 | 0 | เลขที่ | 0 | 0 | 0 | 0 |

| www.5-uglov.ru/articles_view.php?id_news=1222 | 90 | ใช่ | 0 | 0 | 3 | 0 |

| www.techhome.ru/catalog/photo/article_17112.html | 950 | ใช่ | 0 | 0 | 5 | 3 |

| www.panasonic-spb.ru/articles_view.php?id_news=1222 | 0 | เลขที่ | 0 | 0 | 1 | 0 |

| new-articles.ru/page_215.html | 40 | เลขที่ | 0 | 0 | 3 | 0 |

| www.ekvator-hifi.ru/articles_view.php?id_news=1222 | 10 | เลขที่ | 0 | 0 | 1 | 0 |

| shop.key.ru/shop/goods/36608/ | 230 | เลขที่ | 3 | 18 | 4 | 0 |

| www.pc-shop.kz/index.php?g_id=1711 | เลขที่ | 0 | 0 | 3 | 0 | |

| Portalink.ru/portal/ecamera/infoat_15269.htm | 110 | เลขที่ | 0 | 0 | 3 | 3 |

| www.rusdoc.ru/articles/13085/ | 1100 | ใช่ | 3 | 13 | 5 | 1 |

| www.docs.com.ru/articles.php?p=509 | 220 | เลขที่ | 0 | 0 | 4 | 0 |

| e-libed.ru/a31/ | 0 | เลขที่ | 1 | 17 | 0 | 0 |

| dvdlink.ru/portal/Ecamera/infoat_15269.htm | 140 | เลขที่ | 0 | 0 | 3 | 0 |

| www.articlesearch.ru/a3b856d85.html | 0 | เลขที่ | 0 | 0 | 0 | 0 |

| www.bestarticles.ru/a31/ | 0 | เลขที่ | 1 | 5 | 2 | 0 |

| www.temu.ru/a31/ | 0 | เลขที่ | 0 | 0 | 2 | 0 |

LP – หน้าอ้างอิง, LS – เว็บไซต์อ้างอิง, หน้า PR – PR ของหน้า, PR – PR ของหน้าหลักของเว็บไซต์

ภาพคล้ายกัน – เกณฑ์การกรองไม่ชัดเจนโดยสิ้นเชิง อย่างไรก็ตามหากเราดูตัวอย่างเราจะเห็นว่าหน้าต่างๆ บนเว็บไซต์ uaport.net, www.megastoke.ru, Portalink.ru มีตัวอย่างที่ค่อนข้างแตกต่างจากตัวอย่างของไซต์อื่น ๆ ดังนั้นไซต์แรกและไซต์ที่สาม ไม่ได้ถูกกรอง

ฉันจะพูดอะไรได้ในที่สุด? ก่อนอื่นคุณยังคงต้องทดลองและวิเคราะห์อีกมาก แต่เป็นที่ชัดเจนแล้วว่าการตัดสินใจกรอง "รายการที่ซ้ำกันคลุมเครือ" นั้นขึ้นอยู่กับการวิเคราะห์ปัจจัยหลายประการซึ่งปัจจัยหลักคือความคิดริเริ่มของ ตัวอย่าง

4. Google และเนื้อหาที่ซ้ำกัน

Google มุ่งมั่นที่จะตอบสนองต่อคำขอของผู้ใช้เฉพาะกับไซต์ที่มีเนื้อหาสดใหม่และไม่เหมือนใคร

Google เชื่อว่าผู้ใช้ไม่ต้องการเห็นรายการที่ซ้ำกันในผลการค้นหา เอกสารดังกล่าวจึงซ่อนอยู่ในผลลัพธ์คำแนะนำ หากผู้ใช้ยังต้องการเห็นรายการที่ซ้ำกัน (เช่น ผู้ดูแลเว็บที่ต้องการค้นหาว่าใครขโมยเนื้อหาจากไซต์ของเขา) เขาควรเพิ่มพารามิเตอร์ “&filter=0” ต่อท้าย URL

Google เชื่อว่าการระบุผู้เขียนเนื้อหาจะช่วยปรับปรุงการค้นหา อย่างไรก็ตาม เขาตั้งข้อสังเกตว่าวิธีการดังกล่าวในการกำหนดแหล่งที่มาดั้งเดิมในการบันทึกวันที่สร้างเอกสารหรือการลงทะเบียนเนื้อหาโดยผู้เขียนในบริการพิเศษนั้นไม่ได้ผล ในตอนนี้ Google มุ่งเน้นไปที่อำนาจของทรัพยากรและจำนวนลิงก์ที่เข้ามาเป็นส่วนใหญ่ ดังนั้นจึงค่อนข้างเป็นไปได้ที่แหล่งข้อมูลที่มีชื่อเสียงยืมบทความเช่นจากแหล่งข้อมูลเฉพาะจากนั้นคนส่วนใหญ่เรียนรู้เกี่ยวกับบทความจากแหล่งข้อมูลที่มีชื่อเสียงและใส่ลิงก์ไปยังบทความนั้น ในที่สุด Google จะระบุไซต์ที่รู้จักกันดีเป็นแหล่งข้อมูลหลัก...

ในกรณีที่มีเนื้อหาซ้ำกันในไซต์เดียว (เช่น หน้าต้นฉบับและหน้าที่พิมพ์) Google ขอแนะนำให้ผู้ดูแลเว็บใช้งาน robots.txt อย่างจริงจัง ขอแนะนำให้คุณหยุดใช้รหัสเซสชัน เนื่องจากอาจทำให้เกิดเนื้อหาที่ซ้ำกันได้เช่นกัน เหล่านั้น. เครื่องมือค้นหาสามารถจัดทำดัชนีหน้าเดียวกันได้ แต่มี URL ที่แตกต่างกันและค่าพารามิเตอร์ sessid ที่แตกต่างกัน

5. คุณสามารถทดลองอะไรได้บ้างและทำอย่างไรให้ดีที่สุด

ดังนั้นเราจึงได้ชี้แจงประเด็นหลักเกี่ยวกับปัญหาการทำซ้ำเนื้อหาแล้ว หลักการทำงานของตัวกรอง (โดยเฉพาะยานเดกซ์) นั้นค่อนข้างง่าย แต่ค่อนข้างยากที่จะพิจารณาว่าปัจจัยต่าง ๆ นำมาพิจารณาอย่างไร

นี่คือสิ่งที่คุณต้องตรวจสอบเชิงทดลอง:

รายการซ้ำจะถูกกรองอย่างไร ณ เวลาที่ออก บนพื้นฐานอะไร?

- วิธีการ "คำพรรณนา" - ตัวอย่างคำเกิดขึ้นได้อย่างไร และเวกเตอร์เปรียบเทียบอย่างไร

- "สำเนาที่สมบูรณ์" ถูกโยนทิ้งไปบนพื้นฐานใด

สามารถแนะนำตัวเลือกต่อไปนี้ได้:

เราสร้างเว็บไซต์เดียวที่มีเนื้อหาต้นฉบับ เราสแปมมันเล็กน้อยเพื่อที่จะได้รับการจัดทำดัชนี ต่อไป เราจะสร้างโคลนจำนวนหนึ่ง (ซ้ำกัน) การโคลนสามารถทำได้หลายวิธี: การผสมคำของแหล่งที่มาดั้งเดิม, เขียนใหม่, แยกแต่ละย่อหน้า สามารถวางโคลนได้ทั้งในแต่ละไซต์ (บนโฮสติ้งปกติและปกติ) และบนหน้าภายในของไซต์ คุณสามารถโคลนสแปมได้บางส่วน จากนั้นเราประเมินผลลัพธ์อย่างเก็งกำไรและสรุปผล

- คุณสามารถกำหนดหลักการในการกรอง "รายการที่ซ้ำกันแบบคลุมเครือ" ได้โดยใช้วิธีการที่อธิบายไว้ข้างต้น เช่น เพียงแค่วิเคราะห์ไซต์ที่กรองแล้ว

6. อ่านต่อ

เนื้อหาที่ซ้ำกันหรือซ้ำกันเพียงอย่างเดียวคือหน้าเว็บในไซต์ของคุณที่เหมือนกันทั้งหมด (ซ้ำกันที่ชัดเจน) หรือบางส่วน (ซ้ำกันคลุมเครือ) เหมือนกัน แต่แต่ละหน้ามี URL ที่แตกต่างกัน หนึ่งหน้าสามารถมีรายการซ้ำได้หนึ่งรายการหรือหลายรายการ

เนื้อหาที่ซ้ำกันปรากฏบนเว็บไซต์อย่างไร

สำหรับเทคที่ชัดเจนและไม่ชัดเจน มีสาเหตุหลายประการที่ทำให้เกิดเหตุการณ์ดังกล่าว การล้างข้อมูลซ้ำอาจเกิดขึ้นได้จากสาเหตุต่อไปนี้:

- ปรากฏขึ้นเนื่องจาก CMS ของไซต์ ตัวอย่างเช่น การใช้ Replytocom ใน WordPress เมื่อเพิ่มความคิดเห็นใหม่จะสร้างหน้าใหม่โดยอัตโนมัติซึ่งแตกต่างกันเฉพาะใน URL

- อันเป็นผลมาจากข้อผิดพลาดของผู้ดูแลเว็บ

- เนื่องจากมีการเปลี่ยนแปลงโครงสร้างเว็บไซต์ ตัวอย่างเช่น เมื่อใช้เทมเพลตที่อัปเดตด้วย URL ใหม่

- สร้างโดยเจ้าของเว็บไซต์สำหรับฟังก์ชั่นบางอย่าง ตัวอย่างเช่น หน้าที่มีข้อความเวอร์ชันที่สามารถพิมพ์ได้

รายการซ้ำที่ไม่ชัดเจนบนไซต์ของคุณอาจปรากฏขึ้นเนื่องจากสาเหตุต่อไปนี้:

เหตุใดเนื้อหาที่ซ้ำกันจึงเป็นอันตรายต่อเว็บไซต์

- ส่งผลเสียต่อการโปรโมตในผลการค้นหาโรบ็อตการค้นหามีทัศนคติเชิงลบต่อเนื้อหาที่ซ้ำกัน และอาจลดตำแหน่งในผลการค้นหาเนื่องจากขาดเอกลักษณ์ ดังนั้นจึงเป็นประโยชน์ต่อลูกค้า ไม่มีประโยชน์ที่จะอ่านเรื่องเดียวกันในหน้าต่างๆ ของเว็บไซต์

- สามารถแทนที่หน้าที่เกี่ยวข้องอย่างแท้จริงได้โรบ็อตอาจเลือกที่จะส่งคืนหน้าที่ซ้ำกันหากเห็นว่าเนื้อหามีความเกี่ยวข้องกับคำขอมากกว่า ในขณะเดียวกัน รายการที่ซ้ำกันตามกฎจะมีตัวบ่งชี้ปัจจัยด้านพฤติกรรมและ/หรือจำนวนลิงก์ต่ำกว่าหน้าเว็บที่คุณตั้งใจโปรโมต ซึ่งหมายความว่า double จะแสดงในตำแหน่งที่แย่กว่า

- นำไปสู่การสูญเสียการเชื่อมโยงตามธรรมชาติเมื่อผู้ใช้สร้างลิงก์ไม่ใช่ไปยังต้นแบบ แต่เป็นลิงก์ที่ซ้ำกัน

- ส่งเสริมการกระจายน้ำหนักลิงค์ภายในที่ไม่ถูกต้องรายการซ้ำจะดึงน้ำหนักบางส่วนจากหน้าที่โปรโมต ซึ่งเป็นอุปสรรคต่อการโปรโมตในเครื่องมือค้นหาด้วย

จะตรวจสอบได้อย่างไรว่าคุณมีรายการซ้ำหรือไม่?

หากต้องการทราบว่าหน้าเว็บไซต์ซ้ำกันหรือไม่ มีหลายวิธี

คุณพบรายการที่ซ้ำกันหรือไม่? เราอ่านวิธีต่อต้านพวกเขา:

- การเปลี่ยนเส้นทางครั้งที่ 301วิธีนี้ถือว่าน่าเชื่อถือที่สุดเมื่อกำจัดสิ่งที่ซ้ำกันที่ไม่จำเป็นบนเว็บไซต์ของคุณ สาระสำคัญของวิธีการนี้คือการเปลี่ยนเส้นทางหุ่นยนต์ค้นหาจากหน้าที่ซ้ำกันไปยังหน้าหลัก ดังนั้น หุ่นยนต์จะข้ามสองเท่าและทำงานเฉพาะกับหน้าที่ต้องการของไซต์เท่านั้น เมื่อเวลาผ่านไป หลังจากตั้งค่าการเปลี่ยนเส้นทาง 301 หน้าที่ซ้ำกันจะติดกันและหลุดออกจากดัชนี

- แท็ก - ที่นี่เราจะระบุให้เครื่องมือค้นหาทราบว่าหน้าใดเป็นหน้าหลักของเราซึ่งมีจุดประสงค์เพื่อการจัดทำดัชนี ในการดำเนินการนี้ ในแต่ละเทค คุณจะต้องป้อนรหัสพิเศษสำหรับโรบ็อตการค้นหา ซึ่งจะมีที่อยู่ของหน้าหลัก เพื่อหลีกเลี่ยงการทำงานด้วยตนเองจึงมีปลั๊กอินพิเศษ

- ไม่อนุญาตใน robots.txt- ไฟล์ robots.txt เป็นคำสั่งประเภทหนึ่งสำหรับโรบ็อตการค้นหา ซึ่งระบุว่าหน้าใดจำเป็นต้องจัดทำดัชนี และหน้าใดไม่จำเป็นต้องจัดทำดัชนี เพื่อห้ามการจัดทำดัชนีและต่อสู้กับรายการที่ซ้ำกัน ให้ใช้คำสั่ง Disallow ที่นี่ เช่นเดียวกับเมื่อตั้งค่าการเปลี่ยนเส้นทาง 301 สิ่งสำคัญคือต้องตั้งค่าการแบนอย่างถูกต้อง

จะลบรายการที่ซ้ำกันออกจากดัชนีเครื่องมือค้นหาได้อย่างไร

สำหรับยานเดกซ์นั้นจะลบรายการที่ซ้ำกันออกจากดัชนีอย่างอิสระหากไฟล์ robots.txt ได้รับการกำหนดค่าอย่างถูกต้อง แต่สำหรับ Google คุณต้องตั้งกฎในแท็บ "พารามิเตอร์ URL" ผ่านทาง Google Webmaster

หากคุณมีปัญหาในการตรวจสอบและกำจัดเนื้อหาที่ซ้ำกัน คุณสามารถติดต่อผู้เชี่ยวชาญของเราได้ตลอดเวลา เราจะพบองค์ประกอบที่น่าสงสัยทั้งหมด ตั้งค่าการเปลี่ยนเส้นทาง 301, robots.txt, rel="canonical" และทำการตั้งค่าใน Google โดยทั่วไป เราจะดำเนินการทั้งหมดเพื่อให้แน่ใจว่าเว็บไซต์ของคุณทำงานได้อย่างมีประสิทธิภาพ

เนื้อหาที่ซ้ำกันเป็นหนึ่งในปัญหาหลักของการจัดอันดับเว็บไซต์ต่ำในเครื่องมือค้นหา ปัญหานี้เกิดจากการปรากฏบนไซต์ของหน้าเว็บที่เหมือนกันทั้งหมดหรือบางส่วนซึ่งกันและกัน โดยปกติแล้ว สำหรับเสิร์ชเอ็นจิ้น การมีอยู่ของหน้าขยะบนเว็บไซต์ถือเป็นปัญหาร้ายแรง เนื่องจากเพจเหล่านี้ต้องใช้พลังของเซิร์ฟเวอร์ในการประมวลผล มันไม่สมเหตุสมผลเลยที่เสิร์ชเอ็นจิ้นจะสิ้นเปลืองทรัพยากรทางกายภาพในการจัดทำดัชนีเนื้อหาที่ไร้ประโยชน์ดังกล่าว ดังนั้น พวกเขาจึงต่อสู้กับไซต์ดังกล่าวโดยการใช้ตัวกรองกับไซต์เหล่านั้นหรือลดอันดับลงในอันดับ ซึ่งนำไปสู่ตำแหน่งที่ต่ำสำหรับข้อความค้นหาที่ได้รับการเลื่อนระดับ

รายการที่ซ้ำกันและ SEO

การมีอยู่ของหน้าที่ซ้ำกันบนไซต์นำไปสู่สิ่งต่อไปนี้:

- ลิงค์ที่มีประโยชน์จะสูญเปล่ากับหน้าที่ไร้ประโยชน์เหล่านี้

- หลังจากการอัพเดตครั้งถัดไป เพจที่ซ้ำกันจะแทนที่เพจเป้าหมายและจะสูญเสียตำแหน่ง

- เนื้อหาที่ซ้ำกันจะลดความเป็นเอกลักษณ์ของทุกเพจที่มีการโพสต์

- เนื่องจากเครื่องมือค้นหาต่อสู้กับหน้าดังกล่าวโดยลบออกจากการค้นหา เครื่องมือค้นหาอาจยกเว้นหน้าที่โปรโมตด้วย

การจำแนกประเภทของสิ่งที่ซ้ำกันและแนวทางแก้ไขเพื่อกำจัดสิ่งเหล่านั้น

รายการที่ซ้ำกันอาจสมบูรณ์หรือบางส่วนก็ได้ การทำสำเนาโดยสมบูรณ์เกิดขึ้นเมื่อหน้าต่างๆ เหมือนกันโดยสิ้นเชิง ดังนั้น การทำซ้ำบางส่วนเกิดขึ้นเมื่อหน้าไม่ตรงกันทั้งหมด ข้อมูลซ้ำที่สมบูรณ์จะถูกกำจัดผ่าน robots.txt และการตั้งค่าการเปลี่ยนเส้นทาง 301 ข้อมูลซ้ำบางส่วนจะถูกกำจัดโดยทำการแก้ไขที่จำเป็นบนไซต์

นี่คือรายการตรวจสอบที่คุณต้องดำเนินการเพื่อระบุและแก้ไขปัญหารายการที่ซ้ำกัน:

- ค้นหารายการที่ซ้ำกันของหน้าหลักของเว็บไซต์ ตัวอย่างเช่น อาจมีตัวเลือกโฮมเพจต่อไปนี้: http://www.domen.com/, http://www.domen.com/index.php, http://www.domen.com, http:/ /domen.com/, https://www.domen.com/, http://www.domen.com/index.html อย่างที่คุณเห็นมีตัวเลือกมากมาย แต่ตัวเลือกที่ดีที่สุดคือ http://www.domen.com/ หากต้องการกำจัดสำเนาอื่นๆ ของหน้าหลัก จะมีการใช้การเปลี่ยนเส้นทาง 301 และการปิดใน robots.txt (ในกรณีของโครงสร้างเช่น https://www.domen.com/

- การตรวจสอบพื้นฐาน (กฎทองของ SEO) แต่ละหน้าควรสามารถเข้าถึงได้จากที่อยู่เดียวเท่านั้น ที่อยู่ต้องไม่แตกต่างกันดังต่อไปนี้: http://www.domen.com/stranica1/stranica2/ และ http://www.domen.com/stranica2/stranica1/

- การตรวจสอบการมีอยู่ของตัวแปรใน URL ไม่ควรอยู่ในที่อยู่หน้า ตัวอย่างเช่น การสร้าง URL เช่น: http://www.domen.ru/index.php?dir=4567&id=515 ถือเป็นข้อผิดพลาด URL ที่ถูกต้องจะเป็น: http://www.domen.ru/dir/4567/id/515

- การตรวจสอบการมีอยู่ของตัวระบุเซสชันใน URL ตัวอย่างเช่น URL เช่น http://www.domen.ru/dir/4567/id/515.php?PHPSESSID=3451 เป็นสิ่งที่ยอมรับไม่ได้ URL ดังกล่าวมีจำนวนสำเนาของแต่ละหน้าไม่สิ้นสุด ดังนั้นจึงจำเป็นต้องปิดตัวระบุเซสชันทั้งหมดใน robots.txt