เราทุกคนรู้โดยตรงเกี่ยวกับอัลกอริธึมที่มีอยู่ของเครื่องมือค้นหา Yandex และ Google เพื่อให้สอดคล้องกับกฎ "อัปเดตอย่างต่อเนื่อง" ของพวกเขา ซึ่งเครื่องมือเพิ่มประสิทธิภาพทั้งหมดกำลังใช้สมองด้วยวิธีใหม่ๆ มากขึ้นเรื่อยๆ ในการขึ้นสู่ตำแหน่งสูงสุดของผลการค้นหา นวัตกรรมล่าสุดที่เจ้าของไซต์ได้รับจาก PS คือข้อกำหนดสำหรับการเคลื่อนย้ายทรัพยากรอินเทอร์เน็ตและการค้นหาไซต์เหล่านั้นที่ลดลง ที่ไม่รู้วิธีซื้อลิงค์- อัลกอริธึมใดที่นำมาใช้ในการค้นหาจนถึงตอนนี้ที่มีอิทธิพลอย่างมากต่อการจัดอันดับไซต์ ในความเป็นจริง เครื่องมือเพิ่มประสิทธิภาพบางตัวไม่ทราบว่าเทคโนโลยีใด เมื่อใด และเพราะเหตุใดจึงถูกสร้างขึ้นเพื่อให้ตำแหน่งที่ยุติธรรมที่สุดแก่แต่ละไซต์ในการค้นหา และล้างผลการค้นหาของ "ขยะ" เราจะดูประวัติความเป็นมาของการสร้างและพัฒนาอัลกอริธึมการค้นหาในบทความนี้

ยานเดกซ์: ประเภทของอัลกอริทึมตั้งแต่ความคิดจนถึงทุกวันนี้

อัลกอริธึมไม่ได้ถูกสร้างขึ้นทั้งหมดในวันเดียว และแต่ละอัลกอริธึมต้องผ่านการปรับแต่งและการเปลี่ยนแปลงหลายขั้นตอน ชื่ออัลกอริธึม Yandex ส่วนใหญ่ประกอบด้วยชื่อเมือง แต่ละคนมีหลักการทำงาน จุดปฏิสัมพันธ์ และเอกลักษณ์ของตัวเอง คุณสมบัติการทำงานเข้ากันได้อย่างลงตัว เราจะพิจารณาเพิ่มเติมว่าอัลกอริทึม Yandex มีอะไรบ้างและส่งผลต่อไซต์อย่างไร

นอกจากข้อมูลเกี่ยวกับอัลกอริธึมการค้นหาแล้ว บทความเกี่ยวกับ . ฉันขอแนะนำให้คุณอ่านเคล็ดลับในการสร้างเนื้อหา SEO คุณภาพสูงที่เหมาะสำหรับเครื่องมือค้นหาของ Google และ Yandex

มากาดาน

อัลกอริทึมมากาดานจดจำคำย่อและระบุคำนามด้วยคำกริยา เปิดตัวครั้งแรกในโหมดทดสอบในเดือนเมษายน พ.ศ. 2551 และเวอร์ชันถาวรที่สองเปิดตัวในเดือนพฤษภาคมของปีเดียวกัน

ลักษณะเฉพาะ

"มากาดาน" ให้ผู้ใช้ที่เขียนคำย่อพร้อมเว็บไซต์และการถอดเสียง ตัวอย่างเช่น หากคุณป้อนคำขอสำหรับกระทรวงกิจการภายในลงในแถบค้นหา นอกเหนือจากไซต์ที่มีคำหลักดังกล่าวแล้ว รายการยังประกอบด้วยไซต์ที่ไม่มีตัวย่อ แต่มีการถอดรหัส "กระทรวงมหาดไทย" กิจการ”. การรู้จำการทับศัพท์ทำให้ผู้ใช้ไม่ต้องคิดว่าจะเขียนชื่อให้ถูกต้องในภาษาใด เช่น Mercedes หรือ Mercedes นอกจากนี้ Yandex ยังรวมเว็บไซต์ต่างประเทศเกือบพันล้านแห่งไว้ในรายการจัดทำดัชนี การจดจำส่วนของคำพูดและการจดจำเป็นคำค้นหาที่เทียบเท่าทำให้ไซต์ที่มีวลีสำคัญต่างกันสามารถรวมไว้ในการค้นหาครั้งเดียวได้ นั่นคือตอนนี้สำหรับคำหลัก "การเพิ่มประสิทธิภาพเว็บไซต์" ไซต์ที่มีวลี "เพิ่มประสิทธิภาพเว็บไซต์" จะแสดงในผลการค้นหาด้วย

ผลลัพธ์

หลังจากการเปิดตัวอัลกอริธึม Magadan มันก็ยากขึ้นโดยเฉพาะสำหรับไซต์ที่มีสิทธิ์ต่ำ ในการจัดอันดับ ตำแหน่งสำหรับข้อความค้นหาที่เกี่ยวข้องของทรัพยากรที่มีผู้เยี่ยมชมต่ำและทรัพยากรรุ่นเยาว์ลดลง และตำแหน่งที่เชื่อถือได้แม้จะมีเนื้อหาคุณภาพต่ำก็ถูกย้ายไปยังตำแหน่งแรก โดยคำนึงถึงสัณฐานวิทยาและการเจือจางของคำหลัก เนื่องจากการรวมการทับศัพท์เข้าด้วยกัน ทรัพยากรจากต่างประเทศจึงเข้าสู่อันดับต้น ๆ ของ Runet นั่นคือข้อความที่ปรับให้เหมาะสมในหัวข้ออาจปรากฏบนหน้าที่สองได้เพียงเพราะมีไซต์ที่เข้าชมมากกว่าในหัวข้อเดียวกันหรือไซต์ต่างประเทศที่คล้ายกัน ด้วยเหตุนี้ การแข่งขันสำหรับคำหลักความถี่ต่ำและวลีภาษาต่างประเทศจึงเพิ่มขึ้นอย่างรวดเร็ว การโฆษณาก็มีราคาแพงกว่าเช่นกัน - อัตราเพิ่มขึ้นเนื่องจากก่อนหน้านี้ไซต์แข่งขันกับคำขอเฉพาะเพียงคำขอเดียวเท่านั้น และตอนนี้พวกเขายังแข่งขันกับ "เพื่อนร่วมงาน" ด้วยวลีทางสัณฐานวิทยา การทับศัพท์ คำที่เปลี่ยนเป็นคำพูดอื่น

นาค็อดก้า

อัลกอริธึม "Nakhodka" เป็นพจนานุกรมศัพท์แบบขยายและความใส่ใจในการหยุดคำอย่างระมัดระวัง ปล่อยตัวขึ้นสังเวียนทันทีหลังมากาดาน จัดอันดับผลการค้นหาหลักตั้งแต่เดือนกันยายน 2551

ลักษณะเฉพาะ

นี่เป็นแนวทางใหม่ในการเรียนรู้ของเครื่อง - การจัดอันดับมีความชัดเจนและถูกต้องมากขึ้น พจนานุกรมขยายความของการเชื่อมต่อและความใส่ใจในการหยุดคำในอัลกอริทึม Nakhodka มีอิทธิพลอย่างมากต่อผลการค้นหา ตัวอย่างเช่น คำขอ "การเพิ่มประสิทธิภาพ SEO" ตอนนี้เชื่อมโยงกับคีย์ "การเพิ่มประสิทธิภาพ SEO" และไซต์เชิงพาณิชย์ถูกเจือจางด้วยพอร์ทัลข้อมูล รวมถึงตัวอย่างข้อมูลโดยละเอียดพร้อมคำตอบที่ปรากฏในรายการ วิกิพีเดียถูกแสดงโดยเฉพาะ

ผลลัพธ์

ไซต์เชิงพาณิชย์ให้ความสำคัญกับข้อความค้นหาการขายมากขึ้น เนื่องจากมีการแข่งขันเพิ่มขึ้นหลายครั้งสำหรับวลีที่ให้ข้อมูลและไม่เฉพาะเจาะจง ในทางกลับกัน แพลตฟอร์มข้อมูลสามารถขยายการสร้างรายได้โดยใช้หน้าคำแนะนำโดยการเข้าร่วม โปรแกรมพันธมิตร- ไซต์ข้อมูลยอดนิยมที่ได้รับการส่งเสริมตามคำขอเชิงพาณิชย์เริ่มขายลิงก์เพื่อสั่งซื้อ การแข่งขันมีความรุนแรงมากขึ้น

อาร์ซามาส

อัลกอริทึม "Arzamas" - มีการแนะนำสถิติคำศัพท์ของคำค้นหาและสร้างการอ้างอิงทางภูมิศาสตร์ของไซต์ เวอร์ชันแรกของ "Arzamas" (เมษายน 2552) ที่ไม่มีการพึ่งพาทางภูมิศาสตร์ได้รับการเผยแพร่ทันทีในผลการค้นหาหลักและประกาศ "Arzamas 2" พร้อมตัวแยกประเภทสำหรับการเชื่อมโยงไซต์กับภูมิภาคในเดือนสิงหาคม 2552

ลักษณะเฉพาะ

การนำลิงก์ไปยังคำพ้องความหมายออกทำให้ชีวิตของผู้ใช้ง่ายขึ้น เนื่องจากขณะนี้วลี "พายอเมริกัน" ส่งคืนเฉพาะไซต์ธีมภาพยนตร์ โดยไม่มีสูตรขนมหวานใดๆ ดังที่เคยเป็นมา การเชื่อมโยงไปยังภูมิภาคทำให้เกิดความก้าวหน้า โดยเปลี่ยนวลีสำคัญโดยการเพิ่มเมืองลงไปหลายจุด ตอนนี้ผู้ใช้สามารถป้อนคำว่า "ร้านอาหาร" และดูเฉพาะเว็บไซต์จากเมืองที่ตนอยู่ในผู้นำเท่านั้น หากคุณจำได้ว่า ก่อนหน้านี้คุณจะต้องป้อนวลีที่เฉพาะเจาะจงมากขึ้น เช่น "ร้านอาหารในเซนต์ปีเตอร์สเบิร์ก" มิฉะนั้นยานเดกซ์อาจตอบกลับว่า "ระบุคำขอ - พบตัวเลือกมากเกินไป" คำหลักที่ไม่ขึ้นอยู่กับภูมิศาสตร์จะแสดงเฉพาะไซต์ที่เกี่ยวข้องกับคำขอจากภูมิภาคใดๆ โดยไม่มีการอ้างอิง

ผลลัพธ์

ไชโย! ในที่สุด ไซต์จากภูมิภาคเล็กๆ ก็หยุดแข่งขันกับเมืองใหญ่แล้ว ตอนนี้การเข้าถึง TOP ในภูมิภาคของคุณได้ง่ายขึ้นมาก ในช่วงเวลานี้เองที่มีการเสนอบริการ "โปรโมชันระดับภูมิภาค" อัลกอริธึม Armazas ช่วยให้บริษัทขนาดเล็กสามารถพัฒนาได้เร็วขึ้นในพื้นที่ของตน แต่สิ่งที่จับได้ยังคงอยู่ ยานเดกซ์ไม่สามารถระบุตำแหน่งทางภูมิศาสตร์ของไซต์ทั้งหมดได้ และอย่างที่คุณเข้าใจเองว่าหากไม่มีลิงก์ ทรัพยากรก็ยังคงอยู่ พูดง่ายๆ ก็คือในสถานที่ที่ไม่น่าพอใจสักแห่ง การพิจารณาใบสมัครสำหรับการพึ่งพาทางภูมิศาสตร์อาจใช้เวลาหลายเดือน และไซต์อายุน้อยที่ไม่มีปริมาณการเข้าชมและลิงก์จำนวนมาก (มีข้อจำกัดเกี่ยวกับ TIC) โดยทั่วไปไม่สามารถส่งคำขอเพื่อกำหนดภูมิภาคให้พวกเขาได้ มันเป็นดาบสองคม

สเนชินสค์

อัลกอริทึม "Snezhinsk" - เสริมสร้างการพึ่งพาทางภูมิศาสตร์และชี้แจงความเกี่ยวข้องของข้อความค้นหากับผลการค้นหาโดยใช้เทคโนโลยี การเรียนรู้ของเครื่องเมทริกซ์เน็ต การประกาศดังกล่าวเกิดขึ้นในเดือนพฤศจิกายน พ.ศ. 2552 และโมเดลที่ได้รับการปรับปรุงภายใต้ชื่อ "Konakovo" ได้เริ่มดำเนินการในเดือนธันวาคมของปีเดียวกัน

ลักษณะเฉพาะ

ผลการค้นหามีความแม่นยำมากขึ้นสำหรับคำถามที่ป้อน ขณะนี้การเชื่อมโยงตำแหน่งทางภูมิศาสตร์มีบทบาทพิเศษ - ไซต์เชิงพาณิชย์ไม่เชื่อมโยงกับภูมิภาคด้วยอัลกอริทึม Snezhinsk ดังนั้นจึงหลุดออกจากผลการค้นหา มีการระบุคำหลักที่ไม่เชื่อมโยงกับสถานที่ แหล่งข้อมูล- สถาปัตยกรรมที่ซับซ้อนสำหรับการคำนวณความเกี่ยวข้องทำให้ชีวิตของเครื่องมือเพิ่มประสิทธิภาพมีความซับซ้อนอย่างมาก โดยสังเกตเห็นว่าการเปลี่ยนแปลงเพียงเล็กน้อยในตัวบ่งชี้ตัวใดตัวหนึ่ง ตำแหน่งของไซต์ในผลการค้นหาก็เปลี่ยนไปทันที

ผลลัพธ์

ในเวลานั้นมีข้อสังเกตว่าการซื้อลิงก์ภายนอกไปยังไซต์เล็ก ๆ ส่งผลกระทบต่อประสิทธิภาพของแหล่งข้อมูลใหม่ช้าเกินไปหากเราเปรียบเทียบการซื้อที่คล้ายกันกับไซต์ที่อยู่ในตลาดอินเทอร์เน็ตมาเป็นเวลานาน วิธีการใหม่ในการพิจารณาความเกี่ยวข้องของเนื้อหากับคำค้นหาได้ลบไซต์ที่มีข้อความที่มีวลีสำคัญมากเกินไปออกจากผลการค้นหา ยุคใหม่ของข้อความคุณภาพได้เริ่มต้นขึ้นแล้ว ซึ่งจะต้องมีมาตรการในทุกสิ่ง หากไม่มีสิ่งนี้ ไซต์ก็อาจตกอยู่ภายใต้การลงโทษสำหรับสแปมได้ ทรัพยากรเชิงพาณิชย์เริ่มตื่นตระหนก เนื่องจากแทบเป็นไปไม่ได้เลยที่จะเข้าถึงตำแหน่งสูงสุดโดยใช้คำหลักที่ไม่ขึ้นอยู่กับภูมิศาสตร์ (และเป็นคำหลักที่มีความถี่สูงสุด) ในเรื่องนี้มีการเผยแพร่รายการในบล็อก Yandex ซึ่งตามหลักการแล้วเราอยากเห็นในหน้าแรก องค์กรการค้าที่เขียนไม่สวยงาม แต่ทำงานได้ดี แต่สำหรับสิ่งนี้เราจะต้องสอนอัลกอริทึมเพื่อประเมินคุณภาพ ของบริการที่นำเสนอ ตั้งแต่นั้นเป็นต้นมา ในขณะนี้สิ่งนี้กลายเป็นงานที่เป็นไปไม่ได้ ชื่อเสียงของแหล่งข้อมูลทางอินเทอร์เน็ตเชิงพาณิชย์มีบทบาทสำคัญในผลการค้นหาทั้งทางออนไลน์และออฟไลน์

ออบนินสค์

อัลกอริธึม "Obninsk" ปรับปรุงอันดับและขยายฐานทางภูมิศาสตร์ของเว็บไซต์อินเทอร์เน็ต และลดผลกระทบของลิงก์ SEO ปลอมต่อประสิทธิภาพของเว็บไซต์ เปิดตัวในเดือนกันยายน 2010

ลักษณะเฉพาะ

ความนิยมในการซื้อลิงก์จำนวนมากกำลังลดลง และแนวคิดของ "การระเบิดของลิงก์" ก็ปรากฏขึ้น ซึ่งตอนนี้ทุกคนต่างหวาดกลัว คู่แข่งอาจทำร้ายกันและกันโดยการทำให้อัลกอริธึมเข้าใจผิดโดยการซื้อลิงก์จำนวนมากจาก "แหล่งที่ไม่ดี" ไปยัง "เพื่อนร่วมงาน" หลังจากนั้นผู้แข่งขันก็หลุดออกจากผลการค้นหาและไม่สามารถไปถึงที่นั่นได้เป็นเวลานาน คำที่ละเอียดอ่อนทางภูมิศาสตร์มักถูกเพิ่มลงในหน้าต่างๆ ของไซต์เชิงพาณิชย์เพื่อดึงดูดความสนใจของหุ่นยนต์ให้ทำงานกับภูมิภาคนี้

ผลลัพธ์

ขณะนี้ไซต์เชิงพาณิชย์ระมัดระวังชื่อเสียงของตนมากขึ้น ซึ่งถือเป็นข่าวดี แต่หลายแห่งยังคงหันไปใช้วิธีที่สกปรก (หลอกให้การเข้าชมและการซื้อบทวิจารณ์ปลอม) หลังจากการเปิดตัวอัลกอริธึม Obninsk การซื้อลิงก์และบทความนิรันดร์ก็ได้รับความนิยมมากขึ้น การซื้อลิงก์ตามปกติไม่ส่งผลต่อการจัดอันดับมากเหมือนเมื่อก่อนอีกต่อไป และหากแหล่งที่มาของลิงก์ย้อนกลับตกอยู่ภายใต้การลงโทษ ก็อาจนำไปสู่ ปฏิกิริยาลูกโซ่ ข้อความ SEO คุณภาพสูงเป็นคุณลักษณะบังคับของทรัพยากรใดๆ ไซต์ใหม่ที่มีเนื้อหาไม่ซ้ำใครและได้รับการปรับปรุงอย่างเหมาะสมสามารถขึ้นสู่ตำแหน่งสูงสุดได้

ครัสโนดาร์

อัลกอริทึม "ครัสโนดาร์" - การใช้เทคโนโลยี "สเปกตรัม" เพื่อลดทอนผลการค้นหา ขยายตัวอย่างและจัดทำดัชนีเครือข่ายโซเชียล การเปิดตัวเกิดขึ้นในเดือนธันวาคม พ.ศ. 2553

ลักษณะเฉพาะ

เทคโนโลยี “สเปกตรัม” ถูกสร้างขึ้นเพื่อจำแนกข้อความค้นหาเป็นหมวดหมู่ และใช้ในกรณีที่มีการป้อนวลีสำคัญที่ไม่เฉพาะเจาะจง “ครัสโนดาร์” ทำให้ผลการค้นหาเจือจางลง ทำให้ผู้ใช้มีตัวเลือกที่หลากหลายมากขึ้น ตัวอย่างเช่น ด้วยวลี "ภาพถ่ายของมอสโก" ในการค้นหา เราไม่เพียงแต่เห็นทิวทัศน์ทั่วไปเท่านั้น แต่ยังเห็นภาพถ่ายตามหมวดหมู่ เช่น "สถานที่ท่องเที่ยว" "แผนที่" "ร้านอาหาร" การเน้นที่ชื่อเฉพาะของบางสิ่งบางอย่าง (ไซต์ รุ่น ผลิตภัณฑ์) - ข้อมูลเฉพาะเริ่มโดดเด่น ตัวอย่างข้อมูลที่สมบูรณ์ทำให้สามารถทำได้ทันที ผลการค้นหาแสดงรายชื่อติดต่อของผู้ใช้และข้อมูลองค์กรอื่นๆ

ผลลัพธ์

การจัดอันดับไซต์เชิงพาณิชย์มีการเปลี่ยนแปลงอย่างมีนัยสำคัญ โดยให้ความสนใจเป็นพิเศษกับรายละเอียด (การ์ดผลิตภัณฑ์ แผนก คำอธิบายสั้น ๆจากทั้งหมด) เครือข่ายโซเชียลบน VK เริ่มได้รับการจัดทำดัชนีแล้วและตอนนี้โปรไฟล์ของผู้เข้าร่วมก็สามารถมองเห็นได้โดยตรงในผลการค้นหาอย่างเท่าเทียมกัน โพสต์ในฟอรั่มอาจอยู่ในอันดับแรกหากมีคำตอบสำหรับคำถามของผู้ใช้มากกว่าไซต์อื่นๆ

เรคยาวิก

อัลกอริธึม "Reykjavik" - มีการสร้างผลการค้นหาส่วนบุคคลและมีการเพิ่มเทคโนโลยี "Wizards" เพื่อแสดงผลเบื้องต้นของข้อความค้นหา ปรับปรุงสูตรคำใบ้การป้อนข้อมูล อัลกอริธึมเปิดตัวในเดือนสิงหาคม 2554

ลักษณะเฉพาะ

คำขวัญของผลการค้นหาส่วนบุคคลคือ “ผู้ใช้ทุกคนมีผลลัพธ์ของตัวเอง” ระบบในการจดจำความสนใจของผู้ค้นหาทำงานผ่านคุกกี้ ดังนั้นหากข้อความค้นหาของผู้ใช้มีความเกี่ยวข้องบ่อยมากขึ้น เช่น กับแหล่งข้อมูลต่างประเทศ ครั้งต่อไปจะแสดงข้อความเหล่านั้นในตำแหน่งผู้นำของผลการค้นหา คำแนะนำในแถบค้นหาจะอัปเดตทุกชั่วโมง จึงช่วยเพิ่มความเป็นไปได้ในการค้นหาเฉพาะเจาะจง การแข่งขันสำหรับการสืบค้นความถี่สูงกำลังเพิ่มขึ้นอย่างเหลือเชื่อ.

ผลลัพธ์

เว็บไซต์ข่าวที่มีชื่อเสียงมักจะเข้าถึงอันดับต้นๆ มากขึ้นเนื่องจากมีแกนความหมายที่ขยายออกไป (การมีอยู่ของคำค้นหาคีย์ความถี่ต่ำที่แตกต่างกันจำนวนมาก) การเพิ่มจำนวนหน้าสำหรับคำค้นหาเฉพาะบนเว็บไซต์ข้อมูลเริ่มมีบทบาทสำคัญหลังจากการเปิดตัวอัลกอริธึม Reykvik แต่ละไซต์พยายามเข้าไปในบุ๊กมาร์กของผู้ใช้เพื่อเป็นส่วนหนึ่งของระบบการตั้งค่าส่วนบุคคล ด้วยเหตุนี้จึงใช้วิธีการสมัครรับฟีด RSS และคำแนะนำแบนเนอร์ป๊อปอัปสำหรับการบุ๊กมาร์กไซต์ แหล่งข้อมูลทางอินเทอร์เน็ตเริ่มให้ความสนใจมากขึ้น แนวทางของแต่ละบุคคลและไม่กดดันมวลชน

คาลินินกราด

อัลกอริธึม "คาลินินกราด" เป็นการปรับแต่งการค้นหาและสตริงการค้นหาส่วนบุคคลทั่วโลก โดยมุ่งเน้นไปที่ปัจจัยด้านพฤติกรรม การเปิดตัวคาลินินกราดในเดือนธันวาคม 2555 ทำให้ต้นทุนบริการ SEO เพิ่มขึ้นอย่างมาก

ลักษณะเฉพาะ

ความสนใจของผู้ใช้ทำให้ผลการค้นหาทั้งหมดกลับหัวกลับหาง - เจ้าของไซต์ซึ่งก่อนหน้านี้ไม่สนใจความสะดวกสบายของการเข้าพักของผู้เยี่ยมชมบนไซต์เริ่มสูญเสียการรับส่งข้อมูลอย่างรวดเร็ว ตอนนี้ยานเดกซ์แบ่งความสนใจออกเป็นระยะสั้นและระยะยาวโดยอัปเดตฐานข้อมูลสายลับวันละครั้ง นั่นหมายความว่าวันนี้และพรุ่งนี้ สำหรับคำขอเดียวกัน ผู้ใช้คนเดียวกันอาจได้รับผลลัพธ์ที่แตกต่างไปจากเดิมอย่างสิ้นเชิง ตอนนี้ความสนใจมีบทบาทพิเศษสำหรับผู้ใช้ที่เคยสนใจการเดินทางเมื่อพิมพ์วลี แท็กซี่ - แสดงบริการแท็กซี่ และสำหรับผู้ที่ดูภาพยนตร์อยู่ตลอดเวลา - พวกเขาจะได้รับทุกอย่างเกี่ยวกับภาพยนตร์ตลกเรื่อง "แท็กซี่" ในผลการค้นหา . ในแถบค้นหาของทุกคนที่ “อยากหาข้อมูล” เคล็ดลับเกี่ยวกับความสนใจก่อนหน้านี้จะแสดงอยู่ในตำแหน่งแรก

ผลลัพธ์

เครื่องมือเพิ่มประสิทธิภาพเริ่มครอบคลุมทุกอย่าง วิธีอื่น ๆรักษาผู้ใช้ไว้: การใช้งานและการออกแบบได้รับการปรับปรุง เนื้อหาถูกสร้างขึ้นที่หลากหลายและมีคุณภาพสูงขึ้น เมื่อออก หน้าต่างเช่น "คุณแน่ใจหรือไม่ว่าต้องการออกจากหน้า" อาจปรากฏขึ้น และผู้ใช้จะถูกจ้องมองด้วยใบหน้าเศร้าของสิ่งมีชีวิตบางอย่าง การเชื่อมโยงหน้าเว็บที่คิดมาอย่างดีและเมนูที่เข้าถึงได้เสมอช่วยปรับปรุงตัวบ่งชี้กิจกรรมของผู้ใช้ ซึ่งเพิ่มอันดับของเว็บไซต์ในผลการค้นหา ไซต์ที่ไม่ชัดเจนสำหรับผู้ใช้อินเทอร์เน็ตในวงกว้างจะถูกลดระดับลงในตำแหน่งแรก จากนั้นโดยทั่วไปแล้วจะแขวนไว้ที่ส่วนท้ายของรายการผลลัพธ์ที่เสนอ

ดับลิน

อัลกอริธึมดับลิน - ปรับปรุงความเป็นส่วนตัวโดยการระบุเป้าหมายปัจจุบัน “คาลินินกราด” เวอร์ชันปรับปรุงใหม่นี้เปิดตัวสู่สายตาชาวโลกในเดือนพฤษภาคม 2556

ลักษณะเฉพาะ

เทคโนโลยีนี้มีฟังก์ชั่นสำหรับติดตามความสนใจที่เปลี่ยนแปลงของผู้ใช้ นั่นคือหากมีมุมมองการค้นหาสองแบบที่แตกต่างกันโดยสิ้นเชิง ช่วงระยะเวลาหนึ่งเวลา อัลกอริธึมจะเลือกอันหลังและรวมไว้ในผลการค้นหา

ผลลัพธ์

สำหรับเว็บไซต์ แทบไม่มีอะไรเปลี่ยนแปลงเลย การต่อสู้ยังคงดำเนินต่อไปไม่เพียงเพื่อการจราจรเท่านั้น แต่ยังเพื่อการปรับปรุงอีกด้วย ตัวชี้วัดพฤติกรรม- เลย์เอาต์ของเว็บไซต์เก่าเริ่มถูกทิ้งร้างเพราะการสร้างใหม่ง่ายกว่าการพยายามแก้ไขบางอย่างในอันเก่า บริการเทมเพลตเว็บไซต์มีเพิ่มมากขึ้น และการแข่งขันเพื่อเลย์เอาต์ทรัพยากรบนเว็บที่สะดวกและสวยงามกำลังเริ่มต้นขึ้น

หมู่เกาะ

อัลกอริธึม "Islands" - เทคโนโลยีได้รับการแนะนำเพื่อแสดงบล็อกเชิงโต้ตอบในผลการค้นหา ทำให้ผู้ใช้สามารถโต้ตอบกับไซต์ได้โดยตรงบนหน้าค้นหา Yandex อัลกอริธึมเปิดตัวในเดือนกรกฎาคม 2013 โดยมีข้อเสนอให้ผู้ดูแลเว็บสนับสนุนเวอร์ชันเบต้าอย่างจริงจัง และใช้เทมเพลตสำหรับสร้าง "เกาะ" แบบโต้ตอบ ขณะนี้เทคโนโลยีกำลังได้รับการทดสอบหลังประตูปิด

ลักษณะเฉพาะ

ตอนนี้เมื่อค้นหาข้อมูลที่สามารถพบได้ทันทีจากการค้นหาผู้ใช้จะได้รับ "เกาะ" - แบบฟอร์มและองค์ประกอบอื่น ๆ ที่สามารถใช้งานได้โดยไม่ต้องไปที่ไซต์ ตัวอย่างเช่น คุณกำลังมองหาภาพยนตร์หรือร้านอาหารที่เฉพาะเจาะจง สำหรับภาพยนตร์ที่อยู่ในการค้นหาและทางด้านขวา บล็อกจะแสดงพร้อมหน้าปกของภาพยนตร์ ชื่อภาพยนตร์ นักแสดง เวลาฉายในโรงภาพยนตร์ในเมืองของคุณ และแบบฟอร์มในการซื้อตั๋ว ร้านอาหารจะแสดงรูปภาพ ที่อยู่ หมายเลขโทรศัพท์ และแบบฟอร์มการจองโต๊ะ

ผลลัพธ์

ไม่มีการเปลี่ยนแปลงที่สำคัญในการจัดอันดับไซต์ในตอนแรก สิ่งเดียวที่สังเกตเห็นได้ชัดเจนคือลักษณะที่ปรากฏของแหล่งข้อมูลบนเว็บพร้อมบล็อกแบบโต้ตอบตั้งแต่แรกและทางด้านขวาของผลการค้นหา หากจำนวนไซต์ที่เข้าร่วมในการทดสอบเบต้ามีนัยสำคัญ ไซต์เหล่านั้นอาจเข้ามาแทนที่ไซต์ทั่วไปได้เนื่องจากความน่าดึงดูดและดึงดูดใจผู้ใช้ SEO กำลังคิดที่จะปรับปรุงการมองเห็นเนื้อหาของตนในผลการค้นหาโดยการเพิ่มรูปภาพ วิดีโอ การให้คะแนน และบทวิจารณ์ ชีวิตจะดีขึ้นสำหรับร้านค้าออนไลน์ - การ์ดผลิตภัณฑ์ที่กำหนดค่าอย่างถูกต้องสามารถเป็น "เกาะ" แบบโต้ตอบที่ยอดเยี่ยม

มินูซินสค์

อัลกอริธึม "Minusinsk" - เมื่อระบุลิงก์ SEO ซึ่งซื้อมาเพื่อบิดเบือนผลลัพธ์การจัดอันดับการค้นหา ตัวกรองจะถูกนำไปใช้กับไซต์ ซึ่งทำให้ตำแหน่งของไซต์เสียหายอย่างมาก “Minusinsk” ได้รับการประกาศในเดือนเมษายน 2558 และมีผลบังคับใช้อย่างสมบูรณ์ในเดือนพฤษภาคมของปีเดียวกัน ด้วยอัลกอริธึมนี้เองที่เชื่อมโยงกับอัลกอริธึมที่มีชื่อเสียง

ลักษณะเฉพาะ

ก่อนการเปิดตัว Minusinsk ในปี 2014 ยานเดกซ์ได้ปิดการใช้งานอิทธิพลของลิงก์ SEO สำหรับคีย์เชิงพาณิชย์จำนวนมากในมอสโกเพื่อทดสอบและวิเคราะห์ผลลัพธ์ ผลลัพธ์กลายเป็นสิ่งที่คาดเดาได้ - ยังคงใช้มวลลิงก์ที่ซื้อมา แต่สำหรับเครื่องมือค้นหามันเป็นสแปม การเปิดตัว Minusinsk ถือเป็นวันที่เจ้าของไซต์ต้องล้างโปรไฟล์ลิงก์และงบประมาณที่ใช้ไป ลิงค์โปรโมชั่นใช้เพื่อปรับปรุงคุณภาพของทรัพยากรอินเทอร์เน็ตของคุณ

ผลลัพธ์

ไซต์ "มีชื่อเสียง" ที่ประสบความสำเร็จสูงสุดด้วยการซื้อลิงก์จำนวนมากหลุดหน้าแรก และบางแห่งได้รับการลงโทษเนื่องจากละเมิดกฎ เว็บไซต์คุณภาพสูงและใหม่ที่ไม่ต้องใช้ลิงก์ย้อนกลับก็พบว่าตนเองอยู่ใน 10 อันดับแรก เว็บไซต์ “ติดอยู่ในการเผยแพร่” ที่ไม่ต้องการรอนานได้สร้างเว็บไซต์ใหม่ ถ่ายโอนเนื้อหาและเสียบปลั๊กเว็บไซต์เก่าหรือ หลอกลวงอย่างมีไหวพริบด้วยการเปลี่ยนเส้นทาง หลังจากผ่านไปประมาณ 3 เดือน เราพบช่องโหว่ในอัลกอริธึมที่ทำให้เราสามารถลบตัวกรองนี้ได้เกือบจะในทันที

การใช้งานและเนื้อหาเริ่มได้รับการปรับปรุงให้ดีขึ้นโดยรวม ลิงก์ถูกซื้อด้วยความระมัดระวังมากยิ่งขึ้น และการควบคุมลิงก์ย้อนกลับก็กลายเป็นหนึ่งในนั้น หน้าที่รับผิดชอบเครื่องมือเพิ่มประสิทธิภาพ

จากข้อมูลในปัจจุบัน หากคุณซื้อลิงก์อย่างไม่เหมาะสม คุณสามารถรับตัวกรองได้แม้กระทั่งลิงก์ 100 ลิงก์ แต่หากมวลลิงก์ถูกเจือจางอย่างเหมาะสม คุณสามารถซื้อลิงก์นับพันได้อย่างปลอดภัยเหมือนสมัยก่อน โดยพื้นฐานแล้ว การเชื่อมโยงงบประมาณสำหรับการลดสัดส่วนนี้ ซึ่งเกิดจากการทำให้หนาแน่นและการกล่าวถึง ได้เพิ่มขึ้นอย่างมาก

วลาดิวอสต็อก

อัลกอริธึม "วลาดิวอสต็อก" เป็นการแนะนำเทคโนโลยีการค้นหาในการตรวจสอบไซต์ว่าเข้ากันได้กับอุปกรณ์มือถืออย่างสมบูรณ์ การเริ่มต้นโครงการเต็มรูปแบบเกิดขึ้นในเดือนกุมภาพันธ์ 2559

ลักษณะเฉพาะ

ยานเดกซ์ก้าวไปอีกขั้นสำหรับผู้ใช้มือถือ อัลกอริธึมวลาดิวอสต็อกได้รับการพัฒนาเพื่อพวกเขาโดยเฉพาะ ตอนนี้เพื่อการจัดอันดับที่ดีขึ้น ค้นหาบนมือถือไซต์ต้องเป็นไปตามข้อกำหนดการเข้าถึงผ่านมือถือ หากต้องการนำหน้าคู่แข่งในผลการค้นหา ทรัพยากรอินเทอร์เน็ตจะต้องแสดงอย่างถูกต้องบนอุปกรณ์เว็บใดๆ รวมถึงแท็บเล็ตและสมาร์ทโฟน วลาดิวอสต็อกกำลังตรวจสอบ ขาดจาวาและ ปลั๊กอินแฟลช, ความสามารถในการปรับใช้เนื้อหากับการขยายหน้าจอ (ความจุข้อความตลอดความกว้างของจอแสดงผล), ความสะดวกในการอ่านข้อความ และความสามารถในการคลิกลิงก์และปุ่มต่างๆ ได้อย่างสะดวกสบาย

ผลลัพธ์

เมื่อถึงเวลาที่อัลกอริธึมวลาดิวอสต็อกเปิดตัว มีเพียง 18% ของไซต์ที่กลายเป็นไซต์ที่เหมาะกับอุปกรณ์เคลื่อนที่ ส่วนที่เหลือต้องกำจัด "ความหนักหน่วง" บนหน้าเว็บที่ไม่ได้แสดงหรือทำให้เนื้อหาไม่สามารถแสดงได้อย่างถูกต้องได้อย่างรวดเร็ว สมาร์ทโฟนและแท็บเล็ต ปัจจัยหลักที่มีอิทธิพลต่อการจัดอันดับเว็บไซต์ในผลการค้นหาบนมือถือคือพฤติกรรมของผู้ใช้มือถือ อย่างน้อยก็ตอนนี้ ท้ายที่สุดมีไซต์ที่เหมาะกับอุปกรณ์พกพาไม่มากนักดังนั้นสถานที่ว่างในการค้นหาจึงถูกครอบครองโดยผู้ที่สามารถมอบเงื่อนไขที่สะดวกสบายที่สุดแก่ผู้ใช้แม้ว่าจะไม่สมบูรณ์ก็ตาม ไซต์ที่ไม่ได้ปรับให้เข้ากับอุปกรณ์มือถือจะไม่ถูกโยนออกจากการค้นหาบนมือถือ แต่เพียงอยู่ในอันดับต่ำกว่าไซต์ที่ได้รับในการปรับปรุงคุณภาพบริการสำหรับผู้ใช้อัจฉริยะ ผลลัพธ์ที่ดีที่สุด- ในขณะนี้ รูปแบบการสั่งซื้อเว็บไซต์ที่ได้รับความนิยมมากที่สุดเป็นแบบปรับเปลี่ยนได้ ไม่ใช่บนมือถืออย่างที่ใครๆ คิด ไซต์ที่ผ่านข้อกำหนดทั้งหมดของอัลกอริทึมจะได้รับ ปริมาณสูงสุด การเข้าชมบนมือถือในช่องของคุณ

Google: ประวัติความเป็นมาของการสร้างและพัฒนาอัลกอริทึม

อัลกอริธึมและตัวกรองของ Google ยังไม่เข้าใจโดยเครื่องมือเพิ่มประสิทธิภาพที่พูดภาษารัสเซียทั้งหมด สำหรับ Google เสมอ จุดสำคัญคือการซ่อนรายละเอียดเกี่ยวกับวิธีการจัดอันดับ โดยอธิบายว่าไซต์ที่ "เหมาะสม" ไม่มีอะไรต้องกลัว และไซต์ที่ "ไม่ซื่อสัตย์" จะดีกว่าหากไม่รู้ว่ามีอะไรรออยู่ ดังนั้นจึงยังคงมีการสร้างตำนานเกี่ยวกับอัลกอริธึมของ Google และข้อมูลจำนวนมากได้มาหลังจากถามคำถามเพื่อสนับสนุนเมื่อไซต์ลดลงในผลการค้นหาเท่านั้น Google มีการปรับปรุงเล็กๆ น้อยๆ มากมายจนนับไม่ได้ และเมื่อถูกถามว่ามีอะไรเปลี่ยนแปลงไปบ้าง PS ต่างประเทศก็เงียบไป พิจารณาอัลกอริธึมหลักที่มีอิทธิพลอย่างมากต่อตำแหน่งของไซต์

คาเฟอีน

อัลกอริทึม "คาเฟอีน" - ในหน้าแรกของการค้นหาอาจมีหลายหน้าของไซต์เดียวกันตามแบรนด์และมีตัวเลือกการแสดงตัวอย่าง การเปิดตัวเกิดขึ้นในเดือนมิถุนายน พ.ศ. 2553

ลักษณะเฉพาะ

เน้นเว็บไซต์ของบริษัทเมื่อค้นหาตามแบรนด์ “แว่นขยาย” จะปรากฏขึ้นใกล้กับบรรทัดเอาต์พุตเพื่อดูตัวอย่าง คำหลักของแบรนด์มีแนวโน้มการเติบโตเชิงบวกในตำแหน่งของทรัพยากรอินเทอร์เน็ตโดยรวม ดัชนีอันดับของหน้าได้รับการอัปเดต ในขณะที่ PR เพิ่มขึ้นในเว็บไซต์ที่เป็นที่รู้จักและเยี่ยมชม

ผลลัพธ์

SEO ได้เริ่มให้ความสำคัญกับการสร้างแบรนด์เว็บไซต์มากขึ้น ได้แก่ โทนสี, โลโก้, ชื่อ คำหลักสำหรับแบรนด์ทำให้หน้าเว็บไซต์โดดเด่นเป็นพิเศษในการค้นหา และเมื่อผู้เยี่ยมชมเปลี่ยนจากวลีดังกล่าวไปยังหน้าหลัก ตำแหน่งของเขาในผลการค้นหาก็เพิ่มขึ้น (หากก่อนหน้านั้นทรัพยากรไม่ได้เป็นผู้นำ) . เครื่องมือเพิ่มประสิทธิภาพ SEO เริ่มซื้อลิงก์เพิ่มเติมเพื่อเพิ่มการอ้างอิง แทบจะเป็นไปไม่ได้เลยที่แบรนด์อายุน้อยและไม่ค่อยมีใครรู้จักจะบุกเข้าไปในผลการค้นหาอันดับต้นๆ

แพนด้า

อัลกอริธึม Panda เป็นเทคโนโลยีสำหรับตรวจสอบเว็บไซต์เกี่ยวกับคุณภาพและประโยชน์ของเนื้อหา รวมถึงปัจจัย SEO หลายประการ เว็บไซต์ที่มี SEO “หมวกดำ” จะไม่รวมอยู่ในการค้นหา Panda ได้รับการประกาศเมื่อเดือนมกราคม พ.ศ. 2555

ลักษณะเฉพาะ

“แพนด้า” ออกไปค้นหาทำความสะอาดเศษซาก นั่นคือสิ่งที่คุณสามารถพูดได้หลังจากที่ไม่เกี่ยวข้องกันมากมาย คำถามสำคัญเว็บไซต์ได้หายไปจาก ผลการค้นหาของ Google- อัลกอริทึมให้ความสำคัญกับ: สแปมคำหลักและการใช้งานที่ไม่สม่ำเสมอ ความเป็นเอกลักษณ์ของเนื้อหา ความสอดคล้องของการเผยแพร่และการอัปเดต กิจกรรมของผู้ใช้ และการโต้ตอบกับไซต์ การให้ผู้เยี่ยมชมเลื่อนไปที่ด้านล่างของหน้าด้วยความเร็วในการอ่านถือเป็นปัจจัยบวก

ผลลัพธ์

หลังจากเปิดใช้งาน Panda แล้ว เว็บไซต์จำนวนมากก็ถูกคว่ำบาตรจากเสิร์ชเอ็นจิ้น ระบบกูเกิลและในตอนแรกทุกคนคิดว่านี่เป็นเพราะการมีส่วนร่วมในปิรามิดลิงก์และการซื้อมวลลิงก์ เป็นผลให้เครื่องมือเพิ่มประสิทธิภาพ SEO ดำเนินกระบวนการทดสอบอัลกอริทึมและวิเคราะห์ผลกระทบ ข้อสรุปของการทดลองคือ Panda ยังคงตรวจสอบคุณภาพของเว็บไซต์เพื่อหาคุณค่าสำหรับผู้เยี่ยมชม แหล่งข้อมูลทางอินเทอร์เน็ตหยุดการคัดลอกและวางและเริ่มการเขียนคำโฆษณาอย่างแข็งขัน ปัจจัยด้านพฤติกรรมปรับปรุงโดยการเปลี่ยนโครงสร้างเว็บไซต์ให้เป็นตัวเลือกที่สะดวกยิ่งขึ้น และการเชื่อมโยงภายในบทความโดยใช้ไฮไลท์พิเศษกลายเป็นส่วนสำคัญของการเพิ่มประสิทธิภาพ ความนิยมของ SEO ในฐานะบริการได้พุ่งสูงขึ้น พบว่าไซต์ที่ไม่ปฏิบัติตามกฎของ Panda หายไปจากการค้นหาอย่างรวดเร็ว

เค้าโครงหน้า (Paige Lyot)

อัลกอริธึม Page Lyot เป็นเทคโนโลยีสำหรับต่อสู้กับสแปมการค้นหาที่คำนวณอัตราส่วนของเนื้อหาที่มีประโยชน์ต่อสแปมบนหน้าเว็บไซต์ เปิดตัวในเดือนมกราคม 2555 และอัปเดตจนถึงปี 2014 รวมอยู่ด้วย

ลักษณะเฉพาะ

“เค้าโครงหน้า” ถูกสร้างขึ้นหลังจากการร้องเรียนของผู้ใช้จำนวนมากเกี่ยวกับเจ้าของไซต์ที่ไร้ยางอายซึ่งหน้ามีเนื้อหาที่เกี่ยวข้องน้อยมากหรือเข้าถึงข้อมูลที่จำเป็นได้ยาก และบางครั้งก็ขาดหายไปโดยสิ้นเชิง อัลกอริธึมคำนวณเปอร์เซ็นต์ของเนื้อหาที่เกี่ยวข้องและสแปมบนเพจสำหรับคำขอที่เข้ามา ได้มีการคว่ำบาตรเว็บไซต์ที่ไม่เป็นไปตามข้อกำหนด และเว็บไซต์ดังกล่าวถูกลบออกจากการค้นหา การไม่ปฏิบัติตามกฎสำหรับการโพสต์เอกสารยังรวมถึงส่วนหัวของไซต์ที่เต็มไปด้วยโฆษณาเมื่อดูข้อความที่ต้องไปที่หน้าจอที่สอง

ผลลัพธ์

ไซต์ที่มีโฆษณาสแปมมากเกินไปหลุดออกจากตำแหน่ง แม้ว่าเนื้อหาบนหน้าเว็บจะได้รับการปรับให้เหมาะสมสำหรับคำหลักในระดับปานกลางก็ตาม หน้าที่ไม่เกี่ยวข้องกับคำค้นหาถูกลดระดับในผลการค้นหา แต่มีเว็บไซต์ไม่มากนักที่ไม่ปฏิบัติตามกฎอย่างโจ่งแจ้งและไม่ต้องกังวลกับความสะดวกสบายของผู้เยี่ยมชม หลังจากอัปเดตอัลกอริทึมสามครั้ง จำนวนทรัพยากรโดยประมาณที่อยู่ภายใต้ตัวกรองกลายเป็นไม่เกิน 3%

(เวนิส)

อัลกอริธึม "เวนิส" จะอ้างอิงทางภูมิศาสตร์ของไซต์ไปยังภูมิภาคใดภูมิภาคหนึ่ง โดยคำนึงถึงการมีอยู่ของชื่อเมืองบนหน้าไซต์ เปิดตัวในเดือนกุมภาพันธ์ 2012

ลักษณะเฉพาะ

“เวนิส” กำหนดให้เว็บมาสเตอร์ต้องมีหน้า “เกี่ยวกับเรา” บนเว็บไซต์ โดยระบุที่อยู่ของสถานที่ โดยไม่ต้องสนใจข้อเท็จจริงที่ว่าบริษัทอาจไม่มีที่ตั้งจริง ตามบริบท อัลกอริธึมจะค้นหาชื่อเมืองที่จะส่งออก หน้าแยกกันตามภูมิภาคที่ระบุไว้นั้น เริ่มใช้มาร์กอัป schema-creator.org เพื่อชี้แจง หุ่นยนต์ค้นหาที่ตั้งทางภูมิศาสตร์

ผลลัพธ์

ไซต์ปรากฏในผลการค้นหาสำหรับภูมิภาคเหล่านั้นที่ไม่ได้กล่าวถึงบนหน้าเว็บ โดยไม่ได้คำนึงถึงคำค้นหาที่ไม่ขึ้นอยู่กับภูมิศาสตร์ เครื่องมือเพิ่มประสิทธิภาพรวมคำหลักที่ละเอียดอ่อนทางภูมิศาสตร์และพยายามสร้างไมโครดาต้า เนื้อหาในแต่ละหน้าได้รับการปรับให้เหมาะกับแต่ละเมืองหรือภูมิภาคโดยรวม การสร้างลิงค์เป็นภาษาท้องถิ่นเริ่มถูกนำมาใช้เพื่อเพิ่มตำแหน่งในภูมิภาคที่เลือก

(เพนกวิน)

อัลกอริทึม "เพนกวิน" - เทคโนโลยีอัจฉริยะการกำหนดน้ำหนักของไซต์และคุณภาพ ลิงก์ย้อนกลับ- ระบบสำหรับการแก้ไขตัวบ่งชี้ที่สูงเกินจริงของอำนาจของทรัพยากรอินเทอร์เน็ต เริ่มเข้าสู่การค้นหาในเดือนเมษายน พ.ศ. 2555

ลักษณะเฉพาะ

“เพนกวิน” มุ่งเป้าไปที่การทำสงครามกับการซื้อลิงก์ย้อนกลับ ซึ่งเป็นชุดอำนาจของไซต์ที่ผิดธรรมชาติ กล่าวคือ เป็นของปลอม อัลกอริธึมจะสร้างฐานของทรัพยากรที่สำคัญโดยพิจารณาจากคุณภาพของลิงก์ย้อนกลับ แรงจูงใจในการเปิดตัว Penguin คือการเกิดขึ้นของเครื่องมือเพิ่มประสิทธิภาพลิงก์ เมื่อลิงก์ไปยังแหล่งข้อมูลบนเว็บมีน้ำหนักเท่ากันและยกไซต์ดังกล่าวขึ้นในผลการค้นหา นอกจากนี้ พวกเขาเริ่มได้รับการจัดอันดับในการค้นหาที่เทียบเท่ากับแหล่งข้อมูลอินเทอร์เน็ตมาตรฐาน โปรไฟล์ปกติผู้ใช้เครือข่ายโซเชียลซึ่งเป็นที่นิยมในการโปรโมตเว็บไซต์ทั่วไปที่ใช้ สัญญาณทางสังคม- พร้อมกับความสามารถของอัลกอริทึมเหล่านี้ ระบบก็เริ่มต่อสู้กับการแทรกคำค้นหาที่ไม่เกี่ยวข้องลงในคำหลักและชื่อโดเมน

ผลลัพธ์

Penguin “ทำให้เว็บไซต์หลายแห่งผิดหวังในผลการค้นหาเนื่องจากมีลิงก์ย้อนกลับเพิ่มขึ้นอย่างผิดปกติและไม่เกี่ยวข้องกับเนื้อหาที่ผู้ใช้ร้องขอ” ความสำคัญของแค็ตตาล็อกและไซต์สำหรับการขายลิงก์ลดลงอย่างรวดเร็วจนเหลือน้อยที่สุด ในขณะที่แหล่งข้อมูลที่เชื่อถือได้ (ไซต์ข่าว ไซต์ที่มีเนื้อหาเฉพาะเรื่องและใกล้เคียงเนื้อหา) เพิ่มขึ้นต่อหน้าต่อตาเรา เนื่องจากการแนะนำอัลกอริธึม Penguin ทำให้ PR สำหรับไซต์สาธารณะเกือบทั้งหมดได้รับการคำนวณใหม่ ความนิยมในการซื้อลิงก์ย้อนกลับจำนวนมากลดลงอย่างรวดเร็ว เว็บไซต์เริ่มปรับแต่งวลีสำคัญให้เข้ากับเนื้อหาบนหน้าเว็บไซต์ให้มากที่สุด “ความคลั่งไคล้ที่เกี่ยวข้อง” ได้เริ่มขึ้นแล้ว การติดตั้งปุ่มโซเชียลบนเพจในรูปแบบของโมดูลนั้นแพร่หลายเนื่องจาก การจัดทำดัชนีอย่างรวดเร็วบัญชีเครือข่ายโซเชียลในการค้นหา

โจรสลัด

อัลกอริธึม "การละเมิดลิขสิทธิ์" เป็นเทคโนโลยีสำหรับการตอบสนองต่อข้อร้องเรียนของผู้ใช้และระบุกรณีการละเมิดลิขสิทธิ์ ระบบเปิดตัวในเดือนสิงหาคม 2555

ลักษณะเฉพาะ

“ Pirate” ยอมรับข้อร้องเรียนจากผู้เขียนเกี่ยวกับการละเมิดลิขสิทธิ์โดยเจ้าของเว็บไซต์ นอกจากข้อความและรูปภาพแล้ว เว็บไซต์ที่มีเนื้อหาวิดีโอซึ่งจัดเก็บภาพภาพยนตร์ละเมิดลิขสิทธิ์จากโรงภาพยนตร์ยังได้รับความเสียหายร้ายแรงอีกด้วย คำอธิบายและบทวิจารณ์ของวิดีโอยังต้องถูกกรองด้วย - ขณะนี้ไม่อนุญาตให้คัดลอกและวางภายใต้ความเจ็บปวดจากการคว่ำบาตร เนื่องจากมีการร้องเรียนจำนวนมากเกี่ยวกับการละเมิดไซต์ ไซต์ดังกล่าวจึงถูกโยนออกจากผลการค้นหา

ผลลัพธ์

จากผลการดำเนินงานเดือนแรกของ Pirate ของ Google ไฟล์วิดีโอหลายล้านไฟล์ที่ละเมิดสิทธิ์ของผู้ถือลิขสิทธิ์ถูกบล็อกไม่ให้รับชมบนไซต์เกือบทั้งหมด รวมถึงไซต์โฮสต์วิดีโอและโรงภาพยนตร์ออนไลน์ เว็บไซต์ที่มีเพียง เนื้อหาละเมิดลิขสิทธิ์ถูกลงโทษและถอนตัวออกจากการค้นหา การล้างข้อมูลเนื้อหา "ที่ถูกขโมย" ครั้งใหญ่ยังคงดำเนินต่อไป

นกฮัมมิ่งเบิร์ด

อัลกอริธึม "Hummingbird" เป็นการแนะนำเทคโนโลยีเพื่อทำความเข้าใจผู้ใช้เมื่อข้อความค้นหาไม่ตรงกับรายการทุกประการ ระบบ "ระบุความต้องการที่แน่นอน" เปิดตัวในเดือนกันยายน 2556

ลักษณะเฉพาะ

ตอนนี้ผู้ใช้ไม่ได้เปลี่ยนวลีเพื่อค้นหาข้อมูลที่ต้องการโดยเฉพาะ อัลกอริธึม "Hummingbird" ทำให้ไม่สามารถค้นหาด้วยเหตุการณ์ที่เกิดขึ้นโดยตรง แต่ส่งคืนผลลัพธ์จากฐานข้อมูล "ถอดรหัสความปรารถนา" ตัวอย่างเช่น ผู้ใช้พิมพ์เข้าไป แถบค้นหาวลี “สถานที่สำหรับการพักผ่อน” และ “Kolibri” จัดอันดับไซต์ที่มีข้อมูลเกี่ยวกับสถานพยาบาล โรงแรม ศูนย์สปา สระว่ายน้ำ และคลับในการค้นหา นั่นคืออัลกอริทึมจะจัดกลุ่มฐานข้อมูลมาตรฐานด้วยวลีของมนุษย์เกี่ยวกับคำอธิบาย ระบบความเข้าใจได้เปลี่ยนแปลงผลการค้นหาอย่างมาก

ผลลัพธ์

ด้วยความช่วยเหลือของเทคโนโลยี Hummingbird เครื่องมือเพิ่มประสิทธิภาพ SEO จึงสามารถขยายขอบเขตได้ แกนความหมายและดึงดูดผู้ใช้มายังไซต์มากขึ้นเนื่องจากลักษณะทางสัณฐานวิทยา การจัดอันดับเว็บไซต์ได้รับการชี้แจง เนื่องจากขณะนี้ไม่เพียงแต่คำนึงถึงการเกิดขึ้นของวลีสำคัญโดยตรงและข้อความค้นหาที่เกี่ยวข้องกับข้อความเท่านั้น แต่ยังรวมถึงความปรารถนาเฉพาะของผู้ใช้ด้วย แนวคิดของการเขียนคำโฆษณา LSI ปรากฏขึ้น - การเขียนข้อความที่คำนึงถึงการจัดทำดัชนีความหมายแฝง นั่นคือตอนนี้บทความถูกเขียนไม่เพียงแต่มีการแทรกเท่านั้น คำหลักแต่ยังรวมถึงคำพ้องความหมายและวลีที่ใกล้เคียงใจความให้มากที่สุด

(นกพิราบ)

อัลกอริธึม “Dove” เป็นระบบสำหรับแปลผู้ใช้และเชื่อมโยงผลการค้นหาไปยังตำแหน่งของพวกเขา เทคโนโลยีนี้เปิดตัวในเดือนกรกฎาคม 2014

ลักษณะเฉพาะ

ตำแหน่งของผู้ใช้มีบทบาทสำคัญในการให้ผลลัพธ์ การค้นหาทั่วไปกลายเป็นเรื่องของการระบุตำแหน่งทางภูมิศาสตร์ การเชื่อมโยงไซต์ไปยัง Google Maps มีบทบาทพิเศษ ในตอนนี้ เมื่อผู้ใช้ร้องขอ อัลกอริธึมจะค้นหาไซต์ที่อยู่ใกล้ตำแหน่งหรือเนื้อหาเป้าหมายมากที่สุดก่อน จากนั้นจึงย้ายออกห่างจากผู้เยี่ยมชม ผลการค้นหาทั่วไปมีการเปลี่ยนแปลงอย่างมาก

ผลลัพธ์

เว็บไซต์ท้องถิ่นมีอันดับการค้นหาเพิ่มขึ้นอย่างรวดเร็วและได้รับการเข้าชมในท้องถิ่น แพลตฟอร์มอินเทอร์เน็ตที่ไม่มีการพึ่งพาทางภูมิศาสตร์ตกอยู่ในตำแหน่ง การต่อสู้เพื่อแต่ละเมืองเริ่มต้นขึ้นอีกครั้ง และจำนวนสถานการณ์ก็เพิ่มขึ้นเมื่อไซต์ที่เหมือนกันซึ่งมีเนื้อหาที่แก้ไขและลิงก์ไปยังพื้นที่ต่างๆ เริ่มปรากฏขึ้น ก่อนรับ ข้อมูลที่ถูกต้องเกี่ยวกับการแนะนำอัลกอริทึม "Dove" ในการค้นหาทางอินเทอร์เน็ตในภาษารัสเซียเว็บมาสเตอร์หลายคนคิดว่าพวกเขาอยู่ภายใต้การคว่ำบาตรของ Penguin

(เป็นมิตรกับมือถือ)

อัลกอริธึมที่เหมาะกับอุปกรณ์พกพาคือการใช้เทคโนโลยีสำหรับตรวจสอบไซต์เพื่อปรับให้เข้ากับอุปกรณ์มือถือได้ ระบบนี้เปิดตัวในเดือนเมษายน 2558 และถูก "เรียก" บนอินเทอร์เน็ตว่า "Mobile Armageddon" (mobilegeddon), "Mobile Apocalypse" (mobilepocalyse, mobocalypse, mopocalypse)

ลักษณะเฉพาะ

เปิดตัวแล้วเป็นมิตรกับมือถือ ยุคใหม่สำหรับ ผู้ใช้มือถือโดยแนะนำให้เครื่องมือเพิ่มประสิทธิภาพดำเนินการอย่างเร่งด่วนเพื่อให้แน่ใจว่าผู้เข้าชมบนมือถือบนเว็บไซต์ของตนจะได้รับความสะดวกสบาย ความสามารถในการปรับตัวของไซต์กับอุปกรณ์เคลื่อนที่ได้กลายเป็นหนึ่งใน ตัวชี้วัดที่สำคัญที่สุดความกังวลของเจ้าของเว็บไซต์เกี่ยวกับผู้เยี่ยมชม แพลตฟอร์มเว็บที่ไม่ตอบสนองต้องทำ โดยเร็วที่สุดแก้ไขข้อบกพร่อง: กำจัดปลั๊กอินที่ไม่รองรับบนแท็บเล็ตและสมาร์ทโฟน ปรับขนาดข้อความให้พอดีกับส่วนขยาย หน้าจอที่แตกต่างกันลบโมดูลที่ป้องกันไม่ให้ผู้เข้าชมที่มีหน้าจอขนาดเล็กเคลื่อนที่ไปรอบๆ ไซต์ มีคนเพิ่งสร้างอันแยกต่างหาก รุ่นมือถือทรัพยากรอินเทอร์เน็ตของคุณ

ผลลัพธ์

ทรัพยากรที่เตรียมไว้ล่วงหน้าสำหรับรอบดังกล่าวได้รับการเน้นเป็นพิเศษจากเว็บไซต์อินเทอร์เน็ตอื่นๆ ในผลการค้นหา และการรับส่งข้อมูลจากอุปกรณ์ที่ไม่ใช่เดสก์ท็อปที่หลากหลายไปยังเว็บไซต์ดังกล่าวเพิ่มขึ้นมากกว่า 25% ไซต์ที่ไม่ตอบสนองโดยสิ้นเชิงถูกลดระดับในการค้นหาบนมือถือ การมุ่งเน้นที่ความคล่องตัวมีบทบาทสำคัญ โดยลดการมีสคริปต์จำนวนมากบนทรัพยากรให้เหลือน้อยที่สุด โฆษณาและเพจต่างๆ ก็เริ่มโหลดเร็วขึ้นอย่างเป็นธรรมชาติ เนื่องจากผู้ใช้ส่วนใหญ่ที่ใช้แท็บเล็ต/สมาร์ทโฟน อินเทอร์เน็ตบนมือถือซึ่งช้ากว่ามาตรฐานหลายเท่า

ประวัติย่อ

แค่นั้นแหละ

ตอนนี้คุณรู้แล้วว่าการค้นหาพัฒนาไปอย่างไรในช่วงหลายปีที่ผ่านมา ทั้งสำหรับผู้ใช้ทั่วไปและไซต์ที่ "โดนแล้วพลาด" อัลกอริธึมการค้นหาข้างต้นแต่ละรายการได้รับการอัปเดตเป็นระยะ แต่นี่ไม่ได้หมายความว่าเครื่องมือเพิ่มประสิทธิภาพและผู้ดูแลเว็บควรกลัวบางสิ่งบางอย่าง (เว้นแต่แน่นอนว่าคุณกำลังใช้ SEO หมวกดำ) แต่ก็ยังคุ้มค่าที่จะจับตาดูเพื่อไม่ให้เกิดความล่าช้าในการค้นหาโดยไม่คาดคิดเนื่องจากครั้งต่อไป ตัวกรองใหม่

เมื่อวันที่ 2 พฤศจิกายน 2559 ยานเดกซ์ได้ประกาศเปิดตัวอัลกอริทึมใหม่ การจัดอันดับการค้นหา"ปาเล็ค". ตอนนี้เว็บมาสเตอร์จะต้องปรับตัวให้เข้ากับความต้องการของตน

ฉันขอเตือนคุณว่าอัลกอริทึม การส่งเสริมเครื่องมือค้นหาดังที่ชื่อแนะนำ ได้รับการออกแบบมาเพื่อจัดอันดับในผลการค้นหาโดย คำขอเฉพาะ- และสิ่งนี้สำคัญมากสำหรับพวกเราเว็บมาสเตอร์ เพราะว่า... ที่ต้องการไซต์ที่อยู่ในอันดับที่ 50 ขึ้นไปในผลการค้นหา - จะไม่มีใครพบและจะไม่มีใครมาที่นั่น

โดยปกติแล้ว ผู้ดูแลเว็บมือใหม่ควรมุ่งเน้นไปที่ข้อความค้นหาที่มีความถี่ต่ำ ซึ่งจะง่ายกว่ามากในการบุกเข้าสู่ TOP และใช้เวลาและเงินน้อยกว่ามาก นี่เป็นคำขอที่ Palekh มุ่งหวังเป็นอย่างยิ่ง

ยิ่งไปกว่านั้น มันไม่ได้มุ่งเน้นไปที่การสืบค้นที่มีความถี่ต่ำเท่านั้น แต่ยังมุ่งเน้นไปที่การสืบค้นที่มีความถี่ต่ำมาก ๆ และแม้กระทั่งการสืบค้นที่ไม่ซ้ำใครอีกด้วย และตามกฎแล้ว SEO ที่มีประสบการณ์มักไม่ค่อยสนใจคำขอดังกล่าว ซึ่งทำให้เรามีโอกาสที่จะดึงดูดผู้เยี่ยมชมเว็บไซต์ของเรามากขึ้น

สาระสำคัญของ Palekh คือตอนนี้การจัดอันดับไม่เพียงขึ้นอยู่กับวลีสำคัญที่แน่นอนเท่านั้น (ยากต่อการเดา) แต่ยังรวมถึงวลีที่มีความหมายคล้ายกันด้วย

เพื่อแก้ไขปัญหานี้ ยานเดกซ์จึงหันไปใช้โครงข่ายประสาทเทียมซึ่งไม่ได้ตั้งโปรแกรมตามความหมายปกติ แต่เป็นการเรียนรู้ด้วยตนเอง ด้วยการเรียนรู้ด้วยตนเอง เครือข่ายดังกล่าวจึงสามารถเข้าใจความหมายของวลีค้นหาและค้นหาวลีที่คล้ายกันได้ อ่านเพิ่มเติมเกี่ยวกับเรื่องนี้ในบล็อกของเขาที่อุทิศให้กับ Palekh

เป็นผลให้ยานเดกซ์สามารถจัดอันดับวลีจากสิ่งที่เรียกว่าได้อย่างกระตือรือร้นมากขึ้น "หางยาว"; ฉันขอเตือนผู้ที่ลืมไปแล้วว่านี่คืออะไร

“หางยาว” คืออะไร

ในปี 2004 Chris Anderson หัวหน้าบรรณาธิการนิตยสาร Wired ได้ทำการศึกษายอดขายผลิตภัณฑ์ (ผลิตภัณฑ์ใดๆ) เขาสนใจคำถาม: อะไรนำมาซึ่งผลกำไรมากที่สุด - สินค้ายอดนิยมในปัจจุบัน (ที่เรียกว่าขายดี) หรือผลิตภัณฑ์ที่หลุดออกจากรายการขายดีและกลายเป็นสินค้าอุปโภคบริโภค (ตัวแทนจำหน่าย)

ปรากฎว่ากำไรจากสินค้าทั้งสองกลุ่มใกล้เคียงกัน: สินค้าขายดีให้ผลกำไรจำนวนมากในช่วงแรกของการปรากฏตัวของพวกเขาจากนั้นเมื่อมีการมาถึงของสินค้าขายดีอื่น ๆ - สินค้าใหม่กว่าสินค้าแรกจะกลายเป็นผู้ค้าปลีก แต่ดำเนินการต่อ เพื่อทำกำไร - จนกว่าพวกเขาจะถูกตัดออกจากการขาย ใกล้เคียงกับช่วงที่ขายดีที่สุด

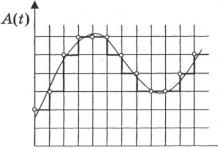

หากคุณจัดเรียงข้อมูลทั้งหมดนี้บนกราฟ คุณจะได้สิ่งนี้:

ทฤษฎีนี้ได้ถูกนำมาประยุกต์ใช้กับ พื้นที่ที่แตกต่างกันกิจกรรมของมนุษย์ รวมถึง SEO และให้ผลลัพธ์ที่ยอดเยี่ยม ปรากฎว่าผู้ใช้อินเทอร์เน็ตมากถึงครึ่งหนึ่งคลิกข้อความค้นหาที่ประกอบเป็น "หางยาว"

ลองนึกภาพว่าคุณอาศัยอยู่ใน Cherepovets และต้องการซื้อโต๊ะ คุณจะเขียนถึง แถบที่อยู่ขอ "เฟอร์นิเจอร์" หรือ "ซื้อโต๊ะสองแท่นใน Cherepovets ในราคาไม่แพง"?

คำขอ "เฟอร์นิเจอร์" เป็นคำขออันดับต้นๆ และคำขอแบบยาวของเราเป็นคำขอแบบหางยาว ยังไง คำเพิ่มเติมใช้ในการสืบค้น ยิ่งปรากฏในความถี่ต่ำสุดเร็วเท่าไร โดยปกติจะพิจารณาว่าข้อความค้นหาที่มีคำมากกว่าสองหรือสามคำจะถูกจัดประเภทเป็นข้อความค้นหาความถี่ต่ำ หากมีคำมากกว่านั้นก็ถือเป็นข้อความหางยาวทั่วไป

ตัวอย่างที่ดีแสดงอยู่ในภาพ:

รูปที่ 2

รูปที่ 2

ตามสถิติของยานเดกซ์ จากคำขอ 280 ล้านคำขอต่อวัน ประมาณ 100 ล้านคำขอเป็นคำขอจากพื้นที่หางยาว และสำหรับคำขอจำนวนมากเช่นนี้จำเป็นต้องตอบสนองและเขาก็ตอบ - ด้วย Palekh

ทำไมต้องปาเลห์?

รูปภาพที่มี " หางยาว» มีการแสดงภาพในรูปแบบต่างๆ กัน โดยปกติจะใช้ภาพสัตว์ต่างๆ เช่น หนู กิ้งก่า ฯลฯ นี่คือตัวอย่างไดโนเสาร์:

รูปที่ 3

รูปที่ 3

แต่เนื่องจากตอนนี้มีความรักชาติอย่างบ้าคลั่งในประเทศของเรา ยานเดกซ์จึงต้องค้นหาสิ่งที่ไม่มีใครมี แต่มีเพียงชาวรัสเซียเท่านั้น เขาพบนกไฟ:

รูปที่ 4

รูปที่ 4

Firebird มักถูกนำเสนอในรูปแบบย่อส่วน Palekh ดังนั้น "Palekh" โอเคไหม?

แต่รูปและชื่อนั้นเป็นสิ่งที่สิบ เราเว็บมาสเตอร์ ควรทำอย่างไร และเราควรคาดหวังอะไร?

เรากำหนดเส้นทางสำหรับ Palekh

ฉันจะบอกทันทีว่าไม่มีอะไรพิเศษที่จะคาดหวังจาก Palekh: Yandex ใช้งานมาสองเดือนแล้วและจัดการจัดอันดับไซต์ได้ ดังนั้นหากตำแหน่งเว็บไซต์ของคุณมีการเปลี่ยนแปลงเมื่อเร็ว ๆ นี้ นี่ก็เป็นสิ่งที่เขาทำ ยานเดกซ์เพิ่งประกาศเมื่อวันที่ 2 พฤศจิกายน แต่อัลกอริทึมมีผลแล้ว

เขาเน้นไปที่ไซต์เหล่านั้นซึ่งมีเนื้อหามากมายเป็นหลัก หากเนื้อหาดีไซต์ก็เริ่มได้รับการจัดอันดับเพิ่มเติมสำหรับคำหลักใหม่ - เพื่อสิ่งที่ดีที่สุด แบบสอบถามความถี่ต่ำ- และถ้ายานเดกซ์คิดว่ามันแย่...

โดยปกติแล้วยานเดกซ์จะถือว่าเนื้อหาในไซต์ที่ดีที่เรียกว่าไซต์ที่เชื่อถือได้นั้นดี จะเข้าสู่เว็บไซต์ที่เชื่อถือได้ได้อย่างไร? - ยาวและแพง เส้นทางที่เร็วที่สุดนำไปสู่ มีการลงทะเบียนฟรี แต่ฉันจะบอกทันทีว่าคุณผู้เริ่มต้นมีโอกาสน้อย และมี - 14,500 รูเบิล รวมภาษีมูลค่าเพิ่ม ทุกอย่างง่ายขึ้นที่นี่ แต่ไม่มีใครรับประกันคุณได้ 100%

หรือเขียนเขียนเขียนและในขณะเดียวกันก็พยายามอย่างหนักแล้วคุณจะมีความไว้วางใจ เส้นทางสู่ความไว้วางใจมีการอธิบายไว้อย่างดีบนอินเทอร์เน็ต ลองค้นหาดู

วณ:ฟ

...และบอกเพื่อนของคุณเกี่ยวกับเรื่องนี้:

คุณยังสามารถสมัครรับจดหมายข่าวได้ -ฉันมีวัสดุที่น่าสนใจมากมายในสต็อก

ข้อมูลบริการเกี่ยวกับบทความ:

บทความนี้จะตรวจสอบคุณสมบัติของอัลกอริทึม Yandex ใหม่และให้คำแนะนำเชิงปฏิบัติแก่ผู้ดูแลเว็บมือใหม่

เขียนโดย: เซอร์เกย์ โวลิน

วันที่เผยแพร่: 11/08/2016

Palekh - อัลกอริทึม Yandex ใหม่, 5.0 จาก 5 ขึ้นอยู่กับ 3 การให้คะแนน

อัลกอริธึมการจัดอันดับเว็บไซต์ในยานเดกซ์อาจมีการเปลี่ยนแปลงและเพิ่มเติมอยู่ตลอดเวลา: มีการเพิ่มฟังก์ชันใหม่ ข้อ จำกัด และตัวกรองได้รับการอัปเดต... มาก เป็นเวลานานการบัญชีของอัลกอริธึมการจัดอันดับทั้งหมดจะถูกเก็บไว้ภายในบริษัทเท่านั้น และเมื่อมีการอัปเดตอย่างกะทันหัน ผู้ใช้รู้สึกขุ่นเคืองและพูดตามตรงว่าเข้าใจเพียงเล็กน้อย

ต้องใช้เวลามากในการค้นคว้าอัลกอริธึมการจัดอันดับ Yandex ค้นหาคำตอบสำหรับหัวข้อตัวกรองและวิธีที่จะไม่เข้าไปใน "บัญชีดำ" ตอนนี้ทุกอย่างง่ายขึ้นเล็กน้อย แต่ก็ไม่ได้มากจนเราเพิกเฉยต่อการวิเคราะห์วิธีการทำงานของยานเดกซ์

อัลกอริธึมยานเดกซ์มีประวัติยาวนานในการสร้างและพัฒนาย้อนหลังไปถึงปี 1997 ตั้งแต่นั้นเป็นต้นมายานเดกซ์ก็เปลี่ยนไปและมีอัลกอริธึมใหม่และตัวกรองใหม่ปรากฏขึ้น มาเริ่ม "การซักถาม" ของเราด้วยอัลกอริธึมที่ "ใหม่ล่าสุด" กัน

อัลกอริทึม Yandex ใหม่ "Baden-Baden" 2017

ยานเดกซ์มีอัลกอริทึมใหม่สำหรับตรวจจับสแปมข้อความที่เรียกว่า "บาเดน-บาเดน"

อัลกอริธึมถูกสร้างขึ้นเพื่อต่อสู้กับ "การโกง" ของความเกี่ยวข้องโดยการเขียนข้อความที่ไม่มีประโยชน์สำหรับผู้ใช้และ "เพิ่มประสิทธิภาพมากเกินไป" (โดยมีคีย์เกิดขึ้นจำนวนมาก)

ตามที่ระบุไว้ในบล็อก Yandex อัลกอริทึมที่ตรวจจับสแปมข้อความได้รับการเปลี่ยนแปลงและปรับปรุงอย่างมาก ผู้เขียนสิ่งพิมพ์เองก็อ้างว่า อัลกอริทึมนี้“เป็นส่วนหนึ่งของอัลกอริธึมการจัดอันดับโดยรวม ผลลัพธ์ของการทำงานอาจทำให้ตำแหน่งของหน้าที่เพิ่มประสิทธิภาพมากเกินไปในผลการค้นหาลดลง” และนี่อาจหมายถึงอะไร?

ประการแรก หากได้รับการ "ปรับปรุงและปรับปรุง" เป็นไปได้มากว่าอัลกอริทึมนี้ถูกสร้างขึ้นเพื่อแทนที่ตัวกรอง "โอเวอร์สแปม" และ "โอเวอร์ออปติไมซ์" ที่คุ้นเคยอยู่แล้ว และถ้ามัน “เป็นส่วนหนึ่งของอัลกอริธึมการจัดอันดับโดยรวม” จริงๆ แน่นอนว่าการวินิจฉัยว่ามี “ค่าปรับ” ที่เกิดจากอัลกอริธึมนี้ทำได้ยากขึ้น

ใหม่อัลกอริทึม Yandex 2016 “ปาเล็ค”

อัลกอริธึมจะพยายามเปรียบเทียบความหมายของคำขอโดยใช้โครงข่ายประสาทเทียม ไม่ใช่แค่เปรียบเทียบคำหลักตามปกติ สิ่งนี้ทำขึ้นเพื่อให้แน่ใจว่าได้รับผลลัพธ์ที่ดีที่สุดสำหรับคำขอของผู้ใช้ที่หายากที่สุด อัลกอริธึมใหม่นี้ใช้โครงข่ายประสาทเทียมและช่วยให้ยานเดกซ์ค้นหาคู่ที่ตรงกันระหว่างคำค้นหาและชื่อหน้า แม้ว่าจะไม่มีวลีสำคัญที่เหมือนกันก็ตาม เพื่อให้เข้าใจถึงสิ่งที่เกิดขึ้นจริง คำพูดบางส่วนจากบล็อกอย่างเป็นทางการของ บริษัท Yandex:

ในกรณีของเรา เราไม่ได้เกี่ยวข้องกับรูปภาพ แต่เกี่ยวข้องกับข้อความ - นี่คือข้อความค้นหาและชื่อหน้าเว็บ - แต่การฝึกอบรมเป็นไปตามรูปแบบเดียวกัน: ใช้ตัวอย่างเชิงบวกและเชิงลบ แต่ละตัวอย่างเป็นคู่ส่วนหัวคำขอ คุณสามารถเลือกตัวอย่างโดยใช้สถิติที่สะสมจากการค้นหา เมื่อเรียนรู้จากพฤติกรรมของผู้ใช้ โครงข่ายประสาทเทียมจะเริ่ม "เข้าใจ" ความสอดคล้องเชิงความหมายระหว่างคำขอและชื่อเพจ

เวกเตอร์เชิงความหมายไม่เพียงแต่ใช้ในการค้นหายานเดกซ์เท่านั้น แต่ยังใช้ในบริการอื่น ๆ เช่นในรูปภาพ ช่วยในการค้นหารูปภาพบนอินเทอร์เน็ตที่ตรงกับข้อความค้นหามากที่สุด

เทคโนโลยีเวกเตอร์ความหมายมีศักยภาพมหาศาล ตัวอย่างเช่น ไม่เพียงแต่ส่วนหัวเท่านั้น แต่ยังสามารถแปลข้อความทั้งหมดของเอกสารเป็นเวกเตอร์ดังกล่าวได้ ซึ่งจะช่วยให้สามารถเปรียบเทียบข้อความค้นหาและหน้าเว็บได้แม่นยำยิ่งขึ้น

การเปิดตัวอัลกอริธึม Yandex ใหม่เป็นอีกข้อโต้แย้งที่สำคัญในการส่งเสริมการสืบค้นความถี่ต่ำสำหรับผู้ที่เกี่ยวข้องในการพัฒนาและโปรโมตเว็บไซต์ โอกาสในการพัฒนาอัลกอริธึม Yandex ใหม่เพียงยืนยันความถูกต้องของทิศทางที่เลือกเพราะในอนาคตอันใกล้นี้เราจะพูดถึงการปรับปรุงการรับรู้ไม่เพียง แต่ส่วนหัวเท่านั้น แต่ยังรวมถึงเอกสารข้อความทั้งหมดโดยรวม (!)

ในยานเดกซ์กราฟการกระจายความถี่จะแสดงในรูปแบบของนกที่มีจะงอยปากลำตัวและหางยาวซึ่งเป็นลักษณะของนกไฟ

- Beak - ข้อความค้นหาที่มีความถี่สูงสุด รายการคำขอดังกล่าวมีขนาดไม่ใหญ่มาก แต่จะถูกถามบ่อยมาก

- เนื้อตัว - ข้อความค้นหาความถี่กลาง

- Tail - ข้อความค้นหาความถี่ต่ำและความถี่ต่ำระดับไมโคร “โดยลำพังพวกมันหายาก แต่เมื่อรวมกันแล้วพวกมันก็เป็นส่วนสำคัญของกระแสการค้นหา ดังนั้นจึงรวมกันเป็นหางยาว”

หางนี้เป็นของนกที่ปรากฏค่อนข้างบ่อยในภาพย่อส่วน Palekh นั่นคือสาเหตุที่อัลกอริทึมถูกเรียกว่า "Palekh"

อัลกอริธึม Yandex ทั้งหมด (2550-2560)

- 2 กรกฎาคม 2550- "เวอร์ชัน 7" สูตรการจัดอันดับใหม่ การเพิ่มจำนวนปัจจัย การประกาศเกิดขึ้นบน searchengines.guru เท่านั้น

- 20 ธันวาคม 2550- 17 มกราคม 2551 "เวอร์ชัน 8" และ "แปด SP1" ทรัพยากรที่มีชื่อเสียงได้รับข้อได้เปรียบที่สำคัญในการจัดอันดับ โดยมีการใช้การกรอง "การรัน" เพื่อเพิ่มปัจจัยอ้างอิง

- 16 พฤษภาคม 2 กรกฎาคม 2551- “Magadan” (อันดับที่รวดเร็วสำหรับการเลือกผู้สมัครอย่างรวดเร็ว ความนุ่มนวล การขยายฐานของตัวย่อและคำพ้องความหมาย ตัวแยกประเภทเอกสารแบบขยาย) “Magadan 2.0” (ความเป็นเอกลักษณ์ของเนื้อหา ตัวแยกประเภทใหม่ของคำขอของผู้ใช้และเอกสาร)

- 11 กันยายน 2551- “ Nakhodka” (คำนึงถึงคำหยุดในคำค้นหา แนวทางใหม่การเรียนรู้ของเครื่อง อรรถาภิธาน)

- 10 เมษายน 24 มิถุนายน 20 สิงหาคม 31 สิงหาคม 23 กันยายน 28 กันยายน 2552

“Arzamas / Anadyr” (คำนึงถึงภูมิภาคของผู้ใช้ ลบคำพ้องเสียง), “Arzamas 1.1” (สูตรภูมิภาคใหม่สำหรับหลายเมือง ยกเว้นมอสโก, เซนต์ปีเตอร์สเบิร์ก และเยคาเตรินเบิร์ก), “Arzamas 1.2” (ตัวจําแนกทางภูมิศาสตร์ใหม่ - การพึ่งพาแบบสอบถาม), "Arzamas+ 16" (สูตรอิสระสำหรับ 16 ภูมิภาคของรัสเซีย), "Arzamas 1.5" (ใหม่ สูตรทั่วไปสำหรับการสืบค้นที่ไม่ขึ้นอยู่กับภูมิศาสตร์) "Arzamas 1.5 SP1" (ปรับปรุงสูตรภูมิภาคสำหรับการสืบค้นที่ไม่ขึ้นอยู่กับภูมิศาสตร์) - 17 พฤศจิกายน 2552- “Snezhinsk” (การเปิดตัวเทคโนโลยีแมชชีนเลิร์นนิง MatrixNet จำนวนปัจจัยการจัดอันดับที่เพิ่มขึ้นหลายเท่า สูตรท้องถิ่น 19 สูตรสำหรับภูมิภาคที่ใหญ่ที่สุดของรัสเซีย การเปลี่ยนแปลงผลการค้นหาอย่างมาก)

- 22 ธันวาคม 2552 10 มีนาคม 2553- “Konakovo” (ชื่ออย่างไม่เป็นทางการ แต่ต่อมาจะเป็น Obninsk ซึ่งเป็นสูตรของตัวเองสำหรับ 1,250 เมืองทั่วรัสเซีย), “Konakovo 1.1” (“Snezhinsk 1.1”) - อัปเดตสูตรสำหรับการสืบค้นที่ไม่ขึ้นอยู่กับภูมิศาสตร์

- 13 กันยายน 2553- “Obninsk” (กำหนดค่าสูตรใหม่ เพิ่มผลผลิต ปัจจัยใหม่ และการจัดอันดับสำหรับการสืบค้นที่ไม่ขึ้นอยู่กับภูมิศาสตร์ ซึ่งมีส่วนแบ่งในโฟลว์มากกว่า 70%)

- 15 ธันวาคม 2553- “ครัสโนดาร์” (เทคโนโลยีสเปกตรัมและการเพิ่มความหลากหลายของผลการค้นหา แยกคำขอของผู้ใช้ออกเป็นความตั้งใจ) เพิ่มเติม: การเพิ่มการแปลผลการค้นหาสำหรับข้อความค้นหาที่ขึ้นอยู่กับภูมิศาสตร์ สูตรอิสระสำหรับ 1,250 เมืองในรัสเซีย

- 17 สิงหาคม 2554- “เรคยาวิก” (คำนึงถึงการตั้งค่าภาษาของผู้ใช้ ซึ่งเป็นขั้นตอนแรกในการปรับแต่งผลลัพธ์ในแบบของคุณ)

- 12 ธันวาคม 2555- “คาลินินกราด” (การปรับเปลี่ยนผลการค้นหาในแบบของคุณอย่างมีนัยสำคัญ: คำแนะนำ โดยคำนึงถึงความสนใจในระยะยาวของผู้ใช้ การเพิ่มความเกี่ยวข้องสำหรับไซต์ "รายการโปรด")

- 30 พฤษภาคม 2556- “ดับลิน” (การปรับเปลี่ยนผลการค้นหาในแบบของคุณเพิ่มเติม: โดยคำนึงถึงความสนใจของผู้ใช้ทันที ปรับผลการค้นหาให้เข้ากับผู้ใช้โดยตรงในระหว่างเซสชันการค้นหา)

- 12 มีนาคม 2557- “Nachalovo”*, “ไม่มีลิงก์” (ยกเลิกการพิจารณาลิงก์ / ปัจจัยลิงก์จำนวนหนึ่งในการจัดอันดับกลุ่ม สอบถามข้อมูลเชิงพาณิชย์ในภูมิภาคมอสโก)

- 5 มิถุนายน 2557- “โอเดสซา”*, “หมู่เกาะ” (การออกแบบการจัดส่งและบริการ “เกาะ” ใหม่ การแนะนำการตอบสนองแบบโต้ตอบ ต่อมาการทดลองถือว่าไม่ประสบความสำเร็จและเสร็จสมบูรณ์)

- 1 เมษายน 2558- “อัมสเตอร์ดัม”*, “การตอบสนองตามวัตถุประสงค์” (การ์ดเพิ่มเติมพร้อมข้อมูลทั่วไปเกี่ยวกับเรื่องของคำขอทางด้านขวาของผลการค้นหา Yandex จำแนกและจัดเก็บหลายสิบล้านในฐานข้อมูล วัตถุต่างๆค้นหา).

- 15 พฤษภาคม 2558- “ Minusinsk” (ลดระดับในการจัดอันดับไซต์ที่มีจำนวนมากเกินไปและส่วนแบ่งลิงก์ SEO ในโปรไฟล์ลิงก์, การลบลิงก์ SEO จำนวนมาก, กลับไปพิจารณาปัจจัยลิงก์เพิ่มเติมในการจัดอันดับสำหรับข้อความค้นหาทั้งหมดในภูมิภาคมอสโก)

- 14 กันยายน 2558(± 3 เดือน) “คิรอฟ”*, “โจรหลายอาวุธแห่งยานเดกซ์” (การสุ่มเพิ่มเติมกับค่าตัวเลขของความเกี่ยวข้องของเอกสารจำนวนหนึ่งที่มีระดับ "Rel+" เพื่อรวบรวมข้อมูลพฤติกรรมเพิ่มเติมในภูมิภาคมอสโก การสุ่มในภายหลัง เปิดตัวในภูมิภาคของรัสเซีย)

- 2 กุมภาพันธ์ 2559- “ วลาดิวอสต็อก” (คำนึงถึงความสามารถในการปรับตัวของไซต์เพื่อการรับชมจากอุปกรณ์พกพา, เพิ่มผลลัพธ์ของการออกโครงการดัดแปลงบนมือถือ)

* - ชื่ออัลกอริธึมที่ไม่เป็นทางการ เมืองต่างๆ จะถูกเลือกตามดุลยพินิจของผู้เขียนเพื่อรักษาความสงบเรียบร้อย

และอัลกอริธึมสุดท้ายในขณะนี้ (เรากำลังพัฒนา) เป็นอัลกอริธึมที่อธิบายไว้ข้างต้นพร้อมชื่อที่ยิ่งใหญ่และไม่ธรรมดา "Palekh" และ "Baden-Baden"

ตัวกรอง Yandex ทั้งหมดและประเภทของตัวกรอง

ยานเดกซ์มีตัวกรองมากมายที่สามารถใช้ได้ทั้งกับไซต์โดยรวมและกับแต่ละหน้าโดยเฉพาะ น่าเสียดายที่ไม่ชัดเจนเสมอไปว่ามีการใช้ตัวกรองตัวใดในไซต์และสำหรับการละเมิดใด - ตอนนี้มีความคลาดเคลื่อนในการใช้งานเพียงเล็กน้อย วิธีการมาตรฐานโปรโมชั่นอาจถูกมองว่าเป็น "สแปม" ผลลัพธ์: การมองโลกในแง่ร้าย

ตัวกรอง Yandex ทั้งหมด (ขึ้นอยู่กับลักษณะที่ปรากฏ) สามารถแบ่งออกเป็น 3 ประเภท:

— ตัวกรองล่วงหน้า:ลดมูลค่าของปัจจัยใดๆ ลงก่อนที่จะคำนวณความเกี่ยวข้องของไซต์ด้วยซ้ำ ผลกระทบของตัวกรองล่วงหน้าอาจไม่สังเกตเห็นได้ทันที - โดยปกติจะปรากฏในไซต์ "ติด" ในบางสถานที่ (ไซต์มาถึงหน้า 2 แล้วและไม่ได้ย้ายไปเพิ่มเติมแม้ว่าจะสร้างมวลลิงก์ขึ้นก็ตาม)

— ตัวกรองโพสต์:พวกเขารีเซ็ตค่าของปัจจัยหนึ่งหรือปัจจัยอื่นหลังจากคำนวณความเกี่ยวข้องของไซต์แล้ว เป็นการยากที่จะไม่สังเกตเห็นตัวกรองประเภทนี้ - ตัวกรองเหล่านี้คือตัวกรองที่แสดงให้เห็นว่าตำแหน่งและการรับส่งข้อมูลจากยานเดกซ์ลดลงอย่างรวดเร็ว ตัวกรองเกือบทั้งหมดสามารถจัดเป็นตัวกรองหลังเพื่อเพิ่มปัจจัยภายในได้

– การกรองก่อนออก:นี่คือเวลาที่คำนวณความเกี่ยวข้องของไซต์ แต่ด้วยเหตุผลบางประการจึงไม่ได้รับอนุญาตให้ปรากฏในผลการค้นหา

— ห้าม: เกิดขึ้นได้ยาก แต่ก็ยังเกิดขึ้นที่ไซต์ถูกแยกออกจากผลการค้นหาโดยสิ้นเชิงเนื่องจากมีการละเมิดใบอนุญาตการค้นหาอย่างร้ายแรง

เห็นได้ชัดว่ายานเดกซ์ค่อนข้างต้องการคุณภาพของไซต์และเตือนเราถึงจุดยืนอย่างเป็นทางการในทุกโอกาสที่เหมาะสม - พัฒนาไซต์ของคุณมุ่งเน้นไปที่ผู้ใช้ "สด" และหากการให้คะแนนของไซต์จากยานเดกซ์นั้น "ยอดเยี่ยม" คุณจะ ไซต์จะไม่ถูกละเลย เพิ่มประสิทธิภาพไซต์ของคุณเพื่อให้การเพิ่มประสิทธิภาพไม่เป็นอันตราย แต่ในทางกลับกัน จะช่วยให้ผู้ใช้สำรวจไซต์ของคุณได้

วันนี้เราได้ประกาศอัลกอริธึมการค้นหาใหม่ “Palekh” รวมถึงการปรับปรุงทั้งหมดที่เราได้ดำเนินการเมื่อเร็วๆ นี้

ตัวอย่างเช่น ตอนนี้การค้นหาใช้เป็นครั้งแรก โครงข่ายประสาทเทียมเพื่อค้นหาเอกสารไม่ใช่ตามคำที่ใช้ในการร้องขอและในตัวเอกสารเอง แต่ตามความหมายของคำขอและชื่อเรื่อง

เป็นเวลาหลายทศวรรษแล้วที่นักวิจัยต้องต่อสู้กับปัญหาการค้นหาเชิงความหมาย ซึ่งเอกสารต่างๆ ได้รับการจัดอันดับตามความเกี่ยวข้องเชิงความหมายกับข้อความค้นหา และตอนนี้มันกำลังกลายเป็นความจริงแล้ว

ในโพสต์นี้ ฉันจะพยายามพูดคุยเล็กน้อยเกี่ยวกับวิธีที่เราทำ และเหตุใดนี่จึงไม่ใช่แค่อัลกอริธึมการเรียนรู้ของเครื่อง แต่เป็นก้าวสำคัญสู่อนาคต

ปัญญาประดิษฐ์หรือการเรียนรู้ของเครื่อง?

เกือบทุกคนรู้ดีว่าสมัยใหม่ เครื่องมือค้นหาทำงานโดยใช้การเรียนรู้ของเครื่อง เหตุใดเราจึงควรพูดคุยแยกกันเกี่ยวกับการใช้โครงข่ายประสาทเทียมสำหรับงานของตน และทำไมตอนนี้เท่านั้นเนื่องจากกระแสโฆษณาในหัวข้อนี้ไม่ลดลงมาหลายปีแล้ว? ฉันจะพยายามบอกคุณเกี่ยวกับประวัติความเป็นมาของปัญหาการค้นหาทางอินเทอร์เน็ตเป็นระบบที่ซับซ้อนซึ่งปรากฏมานานแล้ว ในตอนแรกเป็นเพียงการค้นหาหน้าเว็บจากนั้นก็กลายเป็นตัวแก้ปัญหาและตอนนี้ก็กลายเป็นผู้ช่วยที่เต็มเปี่ยม ยังไง อินเทอร์เน็ตมากขึ้นและยิ่งมีคนมากขึ้น ความต้องการก็ยิ่งมากขึ้น การค้นหาก็จะยิ่งยากขึ้นเท่านั้น

ยุคแห่งการค้นหาที่ไร้เดียงสา

ในตอนแรกมีเพียงการค้นหาคำ - ดัชนีกลับหัว มีจำนวนหน้ามากเกินไป จึงต้องจัดอันดับ เริ่มคำนึงถึงภาวะแทรกซ้อนต่าง ๆ - ความถี่ของคำ, tf-idfยุคแห่งลิงค์

จากนั้นมีหน้ามากเกินไปในหัวข้อใด ๆ มีความก้าวหน้าครั้งสำคัญเกิดขึ้น - พวกเขาเริ่มคำนึงถึงลิงก์ PageRank ก็ปรากฏขึ้นยุคแห่งการเรียนรู้ของเครื่อง

อินเทอร์เน็ตมีความสำคัญในเชิงพาณิชย์ และมีนักต้มตุ๋นจำนวนมากที่พยายามหลอกอัลกอริธึมง่ายๆ ที่มีอยู่ในขณะนั้น ความก้าวหน้าที่สำคัญประการที่สองเกิดขึ้น - เครื่องมือค้นหาเริ่มใช้ความรู้เกี่ยวกับพฤติกรรมผู้ใช้เพื่อทำความเข้าใจว่าหน้าใดดีและไม่ดีในขั้นตอนนี้ จิตใจของมนุษย์ไม่เพียงพอที่จะทราบวิธีจัดอันดับเอกสารอีกต่อไป การเปลี่ยนแปลงครั้งต่อไปเกิดขึ้น - เครื่องมือค้นหาเริ่มใช้การเรียนรู้ของเครื่องอย่างแข็งขัน

หนึ่งในอัลกอริธึมการเรียนรู้ของเครื่องที่ดีที่สุดถูกคิดค้นใน Yandex - Matrixnet เราสามารถพูดได้ว่าการจัดอันดับได้รับความช่วยเหลือจากความฉลาดโดยรวมของผู้ใช้และ “ภูมิปัญญาของฝูงชน” ข้อมูลเกี่ยวกับไซต์และพฤติกรรมของผู้คนจะถูกแปลงเป็นปัจจัยหลายประการ ซึ่งแต่ละปัจจัยถูกใช้โดย Matrixnet เพื่อสร้างสูตรการจัดอันดับ ในความเป็นจริงสูตรการจัดอันดับเขียนโดยเครื่อง (มีขนาดประมาณ 300 เมกะไบต์)

แต่แมชชีนเลิร์นนิงแบบ “คลาสสิก” มีข้อจำกัด: ใช้งานได้เฉพาะเมื่อมีข้อมูลจำนวนมากเท่านั้น ตัวอย่างเล็กๆ น้อยๆ ผู้ใช้หลายล้านคนป้อนข้อความค้นหา [VKontakte] เพื่อค้นหาไซต์เดียวกัน ใน ในกรณีนี้พฤติกรรมของพวกเขาเป็นเช่นนั้น สัญญาณแรงการค้นหาไม่ได้บังคับให้ผู้คนดูผลลัพธ์ แต่แจ้งที่อยู่ทันทีเมื่อป้อนข้อความค้นหา

แต่ผู้คนมีความซับซ้อนมากขึ้นและพวกเขาต้องการการค้นหามากขึ้นเรื่อยๆ ขณะนี้คำขอทั้งหมดมากถึง 40% ไม่ซ้ำกัน กล่าวคือ จะไม่ทำซ้ำอย่างน้อยสองครั้งตลอดระยะเวลาการสังเกตทั้งหมด ซึ่งหมายความว่าการค้นหาไม่มีข้อมูลพฤติกรรมของผู้ใช้เพียงพอ และ Matrixnet ขาดปัจจัยอันมีค่า ข้อความค้นหาดังกล่าวในยานเดกซ์เรียกว่า "หางยาว" เนื่องจากคำค้นหาเหล่านี้รวมกันเป็นสัดส่วนที่สำคัญในการค้นหาของเรา

ยุคแห่งปัญญาประดิษฐ์

และตอนนี้ก็ถึงเวลาพูดคุยเกี่ยวกับความก้าวหน้าครั้งล่าสุด เมื่อไม่กี่ปีก่อน คอมพิวเตอร์มีความเร็วเพียงพอ และมีข้อมูลเพียงพอที่จะใช้โครงข่ายประสาทเทียม เทคโนโลยีที่ใช้เทคโนโลยีเหล่านี้เรียกอีกอย่างว่าปัญญาประดิษฐ์หรือปัญญาประดิษฐ์ เนื่องจากโครงข่ายประสาทเทียมถูกสร้างขึ้นในรูปของเซลล์ประสาทในสมองของเรา และพยายามจำลองการทำงานของบางส่วนความชาญฉลาดของเครื่องจักรนั้นดีกว่าวิธีการแบบเดิมๆ ในงานต่างๆ ที่มนุษย์สามารถทำได้ เช่น การรู้จำเสียงพูด หรือการรู้จำรูปแบบในรูปภาพ แต่สิ่งนี้จะช่วยค้นหาได้อย่างไร?

ตามกฎแล้ว ข้อความค้นหาที่มีความถี่ต่ำและไม่ซ้ำกันนั้นค่อนข้างจะยากในการค้นหา และเป็นการยากกว่ามากที่จะหาคำตอบที่ดีสำหรับคำค้นหาเหล่านั้น วิธีการทำเช่นนี้? เราไม่ได้รับคำแนะนำจากผู้ใช้ (เอกสารใดดีกว่าและเอกสารใดแย่กว่า) ดังนั้นเพื่อแก้ไขปัญหาการค้นหา เราจำเป็นต้องเรียนรู้ที่จะเข้าใจความสัมพันธ์เชิงความหมายระหว่างสองข้อความให้ดีขึ้น: ข้อความค้นหาและเอกสาร

มันง่ายที่จะพูด

พูดอย่างเคร่งครัด โครงข่ายประสาทเทียมเป็นหนึ่งในวิธีการเรียนรู้ของเครื่อง เมื่อไม่นานมานี้มีการอุทิศให้กับพวกเขา โครงข่ายประสาทเทียมแสดงผลลัพธ์ที่น่าประทับใจในด้านการวิเคราะห์ข้อมูลธรรมชาติ ทั้งเสียงและภาพ สิ่งนี้เกิดขึ้นมาหลายปีแล้ว แต่ทำไมถึงไม่ถูกนำมาใช้อย่างแข็งขันในการค้นหาจนถึงตอนนี้?คำตอบง่ายๆ ก็คือ เนื่องจากการพูดถึงความหมายนั้นยากกว่าการพูดถึงรูปภาพในรูปภาพ หรือวิธีเปลี่ยนเสียงให้เป็นคำที่ถอดรหัส อย่างไรก็ตาม ในการค้นหาความหมาย ปัญญาประดิษฐ์ได้เริ่มมาจากพื้นที่ที่มันครองราชย์มายาวนาน นั่นคือการค้นหารูปภาพ

คำไม่กี่คำเกี่ยวกับวิธีการทำงานของการค้นหารูปภาพ คุณถ่ายภาพและใช้โครงข่ายประสาทเทียมเพื่อแปลงให้เป็นเวกเตอร์ในปริภูมิ N รับคำขอ (ซึ่งอาจเป็นเช่นใน แบบฟอร์มข้อความและในรูปของอีกรูปหนึ่ง) และทำเช่นเดียวกันกับรูปนั้น แล้วคุณเปรียบเทียบเวกเตอร์พวกนี้ ยิ่งอยู่ใกล้กันเท่าไร. รูปภาพเพิ่มเติมตรงกับคำขอ

โอเค ถ้ามันใช้ได้กับรูปภาพ ทำไมไม่ใช้ตรรกะเดียวกันกับการค้นหาเว็บล่ะ

ปีศาจอยู่ในเทคโนโลยี

ให้เรากำหนดปัญหาดังต่อไปนี้ เรามีคำขอของผู้ใช้และชื่อหน้าที่ป้อนข้อมูล คุณต้องเข้าใจว่าพวกเขามีความหมายต่อกันมากแค่ไหน ในการทำเช่นนี้ จำเป็นต้องแสดงข้อความคำขอและข้อความส่วนหัวในรูปแบบของเวกเตอร์ดังกล่าว ซึ่งการคูณสเกลาร์จะมากกว่า เกี่ยวข้องกับคำขอมากขึ้นเอกสารที่มีชื่อนี้ กล่าวอีกนัยหนึ่ง เราต้องการฝึกโครงข่ายประสาทเทียมในลักษณะที่สำหรับข้อความที่มีความหมายใกล้เคียงกัน จะสร้างเวกเตอร์ที่คล้ายกัน แต่สำหรับการสืบค้นและส่วนหัวทางความหมายที่ไม่เกี่ยวข้อง เวกเตอร์ควรจะแตกต่างกันความซับซ้อนของงานนี้อยู่ที่การเลือกสถาปัตยกรรมและวิธีการฝึกอบรมโครงข่ายประสาทเทียมที่ถูกต้อง แนวทางแก้ไขปัญหาบางประการเป็นที่รู้จักจากสิ่งพิมพ์ทางวิทยาศาสตร์ อาจเป็นวิธีที่ง่ายที่สุดในที่นี้คือการแสดงข้อความเป็นเวกเตอร์โดยใช้อัลกอริธึม word2vec (น่าเสียดายที่ประสบการณ์เชิงปฏิบัติแนะนำว่าสำหรับปัญหาที่เกิดขึ้นนี่ค่อนข้างจะเป็นเช่นนั้น การตัดสินใจที่ไม่ดี).

ดีเอสเอสเอ็ม

ในปี 2013 นักวิจัยจาก Microsoft Research ได้อธิบายแนวทางของพวกเขา ซึ่งเรียกว่า Deep Structured Semantic Model

อินพุตโมเดลคือข้อความของแบบสอบถามและส่วนหัว เพื่อลดขนาดของโมเดล การดำเนินการจะดำเนินการกับโมเดลเหล่านั้น ซึ่งผู้เขียนเรียกว่าการแฮชคำ เครื่องหมายเริ่มต้นและสิ้นสุดจะถูกเพิ่มลงในข้อความ หลังจากนั้นจะถูกแบ่งออกเป็นสามเหลี่ยมตัวอักษร ตัวอย่างเช่น สำหรับข้อความค้นหา [palekh] เราจะได้รูปสามเหลี่ยม [pa, ale, lekh, ex] เนื่องจากจำนวนไตรแกรมที่แตกต่างกันมีจำกัด เราจึงสามารถแสดงข้อความคำขอเป็นเวกเตอร์ขององค์ประกอบหลายหมื่นขนาด (ขนาดของตัวอักษรของเรายกกำลัง 3) องค์ประกอบของเวกเตอร์ที่สอดคล้องกับตรีแกรมของคำขอจะเท่ากับ 1 ส่วนที่เหลือ - 0 โดยพื้นฐานแล้วเราจึงทำเครื่องหมายรายการของตรีโกณมิติจากข้อความลงในพจนานุกรมที่ประกอบด้วยตรีโกณมิติที่รู้จักทั้งหมด หากคุณเปรียบเทียบเวกเตอร์ดังกล่าว คุณจะพบเพียงการมีอยู่ของไตรแกรมที่เหมือนกันในคำขอและส่วนหัวเท่านั้น ซึ่งไม่น่าสนใจเป็นพิเศษ ดังนั้นตอนนี้จำเป็นต้องแปลงเป็นเวกเตอร์อื่นซึ่งจะมีคุณสมบัติใกล้เคียงความหมายที่เราต้องการอยู่แล้ว

หลังจากเลเยอร์อินพุต ตามที่คาดไว้ในสถาปัตยกรรมเชิงลึก จะมีเลเยอร์ที่ซ่อนอยู่หลายเลเยอร์สำหรับทั้งคำขอและส่วนหัว เลเยอร์สุดท้ายมีขนาด 128 องค์ประกอบและทำหน้าที่เป็นเวกเตอร์ที่ใช้สำหรับการเปรียบเทียบ ผลลัพธ์ของโมเดลคือผลลัพธ์ของการคูณสเกลาร์ของส่วนหัวสุดท้ายและเวกเตอร์ที่ร้องขอ (เพื่อให้แม่นยำยิ่งขึ้น คือคำนวณโคไซน์ของมุมระหว่างเวกเตอร์) แบบจำลองได้รับการฝึกฝนในลักษณะที่สำหรับตัวอย่างการฝึกเชิงบวก ค่าเอาต์พุตจะมีขนาดใหญ่ และสำหรับตัวอย่างการฝึกเชิงบวกจะมีค่าน้อย กล่าวอีกนัยหนึ่ง โดยการเปรียบเทียบเวกเตอร์ของเลเยอร์สุดท้าย เราสามารถคำนวณข้อผิดพลาดในการทำนายและแก้ไขแบบจำลองเพื่อให้ข้อผิดพลาดลดลง

พวกเราที่ Yandex กำลังค้นคว้าโมเดลที่ใช้โครงข่ายประสาทเทียมอย่างจริงจัง ดังนั้นเราจึงเริ่มสนใจโมเดล DSSM ต่อไปเราจะพูดถึงการทดลองของเราในพื้นที่นี้

ทฤษฎีและการปฏิบัติ

คุณสมบัติที่เป็นลักษณะเฉพาะของอัลกอริธึมที่อธิบายไว้ในวรรณกรรมทางวิทยาศาสตร์ก็คือ อัลกอริธึมเหล่านี้ไม่ได้ทำงานนอกกรอบเสมอไป ความจริงก็คือนักวิจัย “เชิงวิชาการ” และนักวิจัยอุตสาหกรรมอยู่ในสภาพที่แตกต่างกันอย่างมีนัยสำคัญ เป็นจุดเริ่มต้น (พื้นฐาน) จากที่ผู้เขียน สิ่งพิมพ์ทางวิทยาศาสตร์เมื่อเปรียบเทียบโซลูชัน ต้องใช้อัลกอริธึมที่รู้จักกันดีซึ่งช่วยให้มั่นใจได้ถึงผลลัพธ์ที่ทำซ้ำได้ นักวิจัยนำผลลัพธ์ของแนวทางที่เผยแพร่ก่อนหน้านี้และแสดงให้เห็นว่าจะสามารถเอาชนะได้อย่างไร ตัวอย่างเช่น ผู้เขียน DSSM ดั้งเดิมจะเปรียบเทียบโมเดลของตนโดยใช้หน่วยเมตริก NDCG กับอัลกอริธึม BM25 และ LSA ในกรณีของนักวิจัยประยุกต์ที่ศึกษาคุณภาพการค้นหาในเครื่องมือค้นหาจริง จุดเริ่มต้นไม่ใช่อัลกอริธึมเฉพาะเจาะจงเพียงอย่างเดียว แต่เป็นการจัดอันดับโดยรวม เป้าหมายของนักพัฒนา Yandex ไม่ใช่การแซง BM25 แต่เพื่อให้ได้การปรับปรุงโดยเทียบกับปัจจัยและโมเดลที่แนะนำก่อนหน้านี้ทั้งชุด ดังนั้นพื้นฐานสำหรับนักวิจัยในยานเดกซ์จึงสูงมากและอัลกอริธึมหลายอย่างที่มีความแปลกใหม่ทางวิทยาศาสตร์และแสดงผลลัพธ์ที่ดีด้วยแนวทาง "เชิงวิชาการ" กลับกลายเป็นว่าไร้ประโยชน์ในทางปฏิบัติเนื่องจากพวกเขาไม่ได้ปรับปรุงคุณภาพของการค้นหาจริงๆในกรณีของ DSSM เราพบปัญหาเดียวกัน ดังที่มักจะเกิดขึ้น ในเงื่อนไข "การต่อสู้" การใช้งานโมเดลที่แน่นอนจากบทความแสดงผลลัพธ์ที่ค่อนข้างเรียบง่าย จำเป็นต้องมี "การแก้ไขไฟล์" ที่สำคัญจำนวนหนึ่งก่อนที่เราจะได้ผลลัพธ์ที่น่าสนใจจากมุมมองเชิงปฏิบัติ เราจะพูดถึงการแก้ไขหลักที่นี่ รุ่นดั้งเดิมซึ่งทำให้เราสามารถทำให้มันมีพลังมากขึ้นได้

เลเยอร์อินพุตขนาดใหญ่

ในโมเดล DSSM ดั้งเดิม เลเยอร์อินพุตคือชุดของอักษรไตรแกรม ขนาดของมันคือ 30,000 วิธีไตรแกรมมีข้อดีหลายประการ ประการแรก มีค่อนข้างน้อย ดังนั้นการทำงานกับพวกเขาจึงไม่ต้องใช้ทรัพยากรจำนวนมาก ประการที่สอง การใช้งานทำให้ง่ายต่อการระบุการพิมพ์ผิดและคำที่สะกดผิด อย่างไรก็ตาม การทดลองของเราแสดงให้เห็นว่า การแสดงข้อความเป็น "ถุง" ของไตรแกรมจะช่วยลดพลังการแสดงออกของเครือข่ายอย่างเห็นได้ชัด ดังนั้นเราจึงเพิ่มขนาดของเลเยอร์อินพุตอย่างรุนแรง รวมถึงนอกเหนือจากไตรแกรมตัวอักษรแล้ว ยังเพิ่มคำและวลีอีกประมาณ 2 ล้านคำด้วย ดังนั้นเราจึงนำเสนอข้อความค้นหาและส่วนหัวเป็น "ถุง" ร่วมกันของคำ บิ๊กแกรมคำ และไตรแกรมตัวอักษร

การใช้เลเยอร์อินพุตขนาดใหญ่ทำให้ขนาดโมเดล เวลาการฝึกอบรมเพิ่มขึ้น และต้องใช้ทรัพยากรการประมวลผลเพิ่มขึ้นอย่างมาก

ยากที่จะเรียนรู้: โครงข่ายประสาทเทียมต่อสู้กับตัวเองและเรียนรู้จากความผิดพลาดได้อย่างไร

การฝึกอบรม DSSM ดั้งเดิมประกอบด้วยการเปิดเผยเครือข่ายให้เห็นตัวอย่างเชิงบวกและเชิงลบจำนวนมาก ตัวอย่างเหล่านี้นำมาจากผลการค้นหา (เห็นได้ชัดว่ามีการใช้เครื่องมือค้นหา Bing สำหรับสิ่งนี้) ตัวอย่างเชิงบวกคือชื่อของเอกสารการค้นหาที่ถูกคลิก ตัวอย่างเชิงลบคือชื่อของเอกสารที่ไม่ถูกคลิก วิธีนี้มีข้อเสียบางประการ ความจริงก็คือการไม่มีการคลิกไม่ได้หมายความว่าเอกสารนั้นไม่เกี่ยวข้องเสมอไป ข้อความตรงกันข้ามก็เป็นจริงเช่นกัน - การมีอยู่ของการคลิกไม่ได้รับประกันความเกี่ยวข้องของเอกสาร โดยพื้นฐานแล้ว ด้วยการเรียนรู้ในลักษณะที่อธิบายไว้ในบทความต้นฉบับ เรามุ่งมั่นที่จะคาดการณ์ความน่าดึงดูดใจของหัวข้อข่าว โดยมีเงื่อนไขว่าหัวข้อข่าวเหล่านั้นจะต้องปรากฏในผลการค้นหา แน่นอนว่าสิ่งนี้ก็ไม่เลวเช่นกัน แต่มันมีความสัมพันธ์ทางอ้อมกับเป้าหมายหลักของเรา - เพื่อเรียนรู้ที่จะเข้าใจความใกล้ชิดทางความหมายในระหว่างการทดลอง เราค้นพบว่าผลลัพธ์สามารถปรับปรุงได้อย่างมีนัยสำคัญหากเราใช้กลยุทธ์อื่นในการเลือกตัวอย่างเชิงลบ เพื่อให้บรรลุเป้าหมาย ตัวอย่างเชิงลบที่ดีคือเอกสารเหล่านั้นที่รับประกันว่าจะไม่เกี่ยวข้องกับข้อความค้นหา แต่ในขณะเดียวกันก็ช่วยให้โครงข่ายประสาทเทียมเข้าใจความหมายของคำได้ดีขึ้น ฉันสามารถหาได้จากที่ไหน?

ลองครั้งแรก

ขั้นแรก ลองใช้ชื่อเรื่องของเอกสารสุ่มเป็นตัวอย่างเชิงลบ ตัวอย่างเช่น สำหรับคำขอ [ภาพวาด Palekh] ชื่อแบบสุ่มอาจเป็น "กฎ" การจราจร 2559 สหพันธรัฐรัสเซีย" แน่นอนว่าเป็นไปไม่ได้ที่จะยกเว้นความเป็นไปได้ที่เอกสารที่สุ่มเลือกจากพันล้านจะเกี่ยวข้องกับคำขอนั้นโดยสิ้นเชิง แต่ความน่าจะเป็นของสิ่งนี้มีน้อยมากจนสามารถถูกละเลยได้ วิธีนี้ทำให้เราสามารถได้รับตัวอย่างเชิงลบจำนวนมากได้อย่างง่ายดาย ดูเหมือนว่าตอนนี้เราสามารถสอนเครือข่ายของเราได้อย่างชัดเจนถึงสิ่งที่เราต้องการ - เพื่อแยกแยะ เอกสารที่ดีซึ่งผู้ใช้สนใจจากเอกสารที่ไม่เกี่ยวข้องกับคำขอ น่าเสียดายที่โมเดลที่ได้รับการฝึกตามตัวอย่างดังกล่าวกลับกลายเป็นว่าค่อนข้างอ่อนแอ โครงข่ายประสาทเทียมเป็นสิ่งที่ชาญฉลาด และมักจะหาวิธีทำให้งานของมันง่ายขึ้น ในกรณีนี้ เธอเริ่มมองหาคำเดียวกันในข้อความค้นหาและส่วนหัว: ใช่ - คู่ที่ดี ไม่ใช่ - คู่ที่ไม่ดี แต่เราทำเองได้ เป็นสิ่งสำคัญสำหรับเราที่เครือข่ายเรียนรู้ที่จะแยกแยะรูปแบบที่ไม่ชัดเจนลองอีกครั้งหนึ่ง

การทดลองครั้งต่อไปคือการเพิ่มคำจากการสืบค้นลงในชื่อเรื่องของตัวอย่างเชิงลบ ตัวอย่างเช่น สำหรับคำขอ [ภาพวาด Palekh] ชื่อสุ่มดูเหมือน [ภาพวาดกฎจราจรปี 2016 ของสหพันธรัฐรัสเซีย] โครงข่ายประสาทเทียมมีความยากเพิ่มขึ้นเล็กน้อย แต่ถึงกระนั้นก็เรียนรู้อย่างรวดเร็วที่จะแยกแยะคู่ธรรมชาติออกจากคู่ที่คอมไพล์ด้วยตนเอง เห็นได้ชัดว่าเราจะไม่ประสบความสำเร็จหากใช้วิธีการดังกล่าวความสำเร็จ

วิธีแก้ปัญหาที่ชัดเจนหลายอย่างจะชัดเจนหลังจากค้นพบแล้วเท่านั้น ครั้งนี้ก็เกิดขึ้นด้วย ต่อมาสักพักก็พบว่า วิธีที่ดีที่สุดการสร้างตัวอย่างเชิงลบหมายถึงการบังคับให้เครือข่าย “ต่อสู้” กับตัวเอง เรียนรู้จากความผิดพลาดของตัวเอง ในบรรดาหัวข้อข่าวแบบสุ่มหลายร้อยรายการ เราได้เลือกหัวข้อที่โครงข่ายประสาทเทียมในปัจจุบันถือว่าดีที่สุด แต่เนื่องจากส่วนหัวนี้ยังคงเป็นแบบสุ่ม จึงมีความเป็นไปได้สูงที่จะไม่ตรงกับคำขอ และนี่คือหัวข้อข่าวที่เราเริ่มใช้เป็นตัวอย่างเชิงลบ กล่าวอีกนัยหนึ่ง คุณสามารถแสดงส่วนหัวแบบสุ่มที่ดีที่สุดแก่เครือข่าย ฝึกฝน ค้นหาส่วนหัวแบบสุ่มที่ดีที่สุดใหม่ แสดงเครือข่ายอีกครั้ง และอื่นๆ ซ้ำแล้วซ้ำอีก ขั้นตอนนี้เราเห็นว่าคุณภาพของโมเดลดีขึ้นอย่างเห็นได้ชัด และบ่อยครั้งคู่สุ่มที่ดีที่สุดเริ่มดูเหมือนตัวอย่างเชิงบวกจริงๆ ปัญหาได้รับการแก้ไขแล้วโครงการฝึกอบรมดังกล่าวมักเรียกว่าการขุดเชิงลบอย่างหนักในวรรณกรรมทางวิทยาศาสตร์ ควรสังเกตว่าโซลูชันที่คล้ายกันได้แพร่หลายในชุมชนวิทยาศาสตร์สำหรับการสร้างภาพที่ดูสมจริง แบบจำลองประเภทนี้เรียกว่า Generative Adversarial Networks

เป้าหมายที่แตกต่าง

นักวิจัยจาก Microsoft Research ใช้การคลิกเอกสารเป็นตัวอย่างเชิงบวก อย่างไรก็ตาม ดังที่ได้กล่าวไปแล้ว นี่เป็นสัญญาณที่ค่อนข้างไม่น่าเชื่อถือเกี่ยวกับความสอดคล้องเชิงความหมายของส่วนหัวกับคำขอ ท้ายที่สุดแล้ว งานของเราไม่ใช่การจัดอันดับเว็บไซต์ที่มีผู้เข้าชมมากที่สุดในผลการค้นหา แต่ต้องค้นหาให้เจอจริงๆ ข้อมูลที่เป็นประโยชน์- ดังนั้นเราจึงลองใช้คุณลักษณะอื่นของพฤติกรรมผู้ใช้เป็นเป้าหมายการฝึกอบรม ตัวอย่างเช่น หนึ่งในแบบจำลองคาดการณ์ว่าผู้ใช้จะอยู่บนเว็บไซต์หรือออกไป อีกประการหนึ่งคือเขาจะอยู่ในไซต์นี้นานแค่ไหน ปรากฎว่าคุณสามารถปรับปรุงผลลัพธ์ได้อย่างมากหากคุณปรับเมตริกเป้าหมายดังกล่าวให้เหมาะสม ซึ่งบ่งชี้ว่าผู้ใช้พบสิ่งที่เขาต้องการกำไร

โอเค สิ่งนี้ให้อะไรเราในทางปฏิบัติ? มาเปรียบเทียบพฤติกรรมของแบบจำลองประสาทของเรากับปัจจัยข้อความอย่างง่ายโดยอิงตามความสอดคล้องระหว่างคำค้นหาและข้อความ - BM25 มันมาหาเราตั้งแต่สมัยที่การจัดอันดับนั้นเรียบง่าย และตอนนี้มันสะดวกที่จะใช้เป็นระดับพื้นฐานแล้วลองใช้ข้อความค้นหา [Book of Kells] เป็นตัวอย่าง และดูว่าปัจจัยต่างๆ มีนัยสำคัญอย่างไรในหัวข้อต่างๆ เพื่อควบคุมสิ่งนี้ ให้เพิ่มผลลัพธ์ที่ไม่เกี่ยวข้องอย่างชัดเจนลงในรายการส่วนหัว

ปัจจัยทั้งหมดในยานเดกซ์จะถูกทำให้เป็นมาตรฐานตามช่วงเวลา คาดว่า BM25 จะมีค่าสูงสำหรับชื่อเรื่องที่มีคำค้นหา และค่อนข้างคาดเดาได้ว่าปัจจัยนี้จะได้รับค่าเป็นศูนย์ในหัวข้อข่าวที่ไม่มี คำทั่วไปด้วยการร้องขอ ตอนนี้สังเกตว่าแบบจำลองประสาททำงานอย่างไร มันรับรู้ถึงความเชื่อมโยงของข้อความค้นหากับชื่อภาษารัสเซียของหน้า Wikipedia ที่เกี่ยวข้องและชื่อบทความเป็นภาษาอังกฤษได้ดีพอๆ กัน! นอกจากนี้ ดูเหมือนว่าโมเดล "เห็น" ความเชื่อมโยงระหว่างข้อความค้นหากับชื่อ ซึ่งไม่ได้กล่าวถึง Book of Kells แต่มีวลีที่คล้ายกัน ("Irish Gospels") ค่าของโมเดลสำหรับชื่อที่ไม่เกี่ยวข้องจะลดลงอย่างมาก

ตอนนี้เรามาดูกันว่าปัจจัยของเราจะมีลักษณะอย่างไรหากเราจัดรูปแบบคำขอโดยไม่เปลี่ยนความหมายของมัน: [gospel of Kells]

สำหรับ BM25 การปรับรูปแบบการสืบค้นกลายเป็นหายนะอย่างแท้จริง ปัจจัยกลายเป็นศูนย์ในหัวข้อที่เกี่ยวข้อง และแบบจำลองของเราแสดงให้เห็นถึงความต้านทานต่อการกำหนดรูปแบบได้ดีเยี่ยม กล่าวคือพาดหัวที่เกี่ยวข้องยังคงมีค่าปัจจัยสูง ในขณะที่พาดหัวที่ไม่เกี่ยวข้องยังคงมีค่าปัจจัยต่ำ ดูเหมือนว่านี่เป็นพฤติกรรมที่เราคาดหวังจากสิ่งที่อ้างว่าสามารถ "เข้าใจ" ความหมายของข้อความได้

อีกตัวอย่างหนึ่ง ขอ [เรื่องผีเสื้อถูกทับ]

ดังที่เราเห็น โมเดลประสาทสามารถประเมินชื่อเรื่องได้ในระดับสูงด้วยคำตอบที่ถูกต้อง แม้ว่าจะไม่มีคำทั่วไปในแบบสอบถามก็ตาม ยิ่งไปกว่านั้น จะเห็นได้อย่างชัดเจนว่าหัวข้อที่ไม่ตอบคำถามแต่ยังคงสัมพันธ์กันในความหมายนั้นจะได้รับค่าตัวประกอบที่ค่อนข้างสูง เหมือนกับว่านางแบบของเรา "อ่าน" เรื่องราวของ Bradbury และ "รู้" ว่านี่คือสิ่งที่เขากำลังพูดถึงในคำขอ!

อะไรต่อไป?

เราอยู่ที่จุดเริ่มต้นของการเดินทางที่ยาวนานและน่าสนใจมาก เห็นได้ชัดว่าโครงข่ายประสาทเทียมมีศักยภาพที่ดีในการปรับปรุงอันดับ ทิศทางหลักที่ต้องการการพัฒนาเชิงรุกนั้นชัดเจนอยู่แล้วตัวอย่างเช่น เห็นได้ชัดว่าชื่อมีข้อมูลที่ไม่สมบูรณ์เกี่ยวกับเอกสาร และเป็นการดีที่จะเรียนรู้วิธีการสร้างแบบจำลองตาม ข้อความฉบับเต็ม(ปรากฎว่านี่ไม่ใช่งานจิ๊บจ๊อยเลย) นอกจากนี้ เราสามารถจินตนาการถึงโมเดลที่มีสถาปัตยกรรมที่ซับซ้อนกว่า DSSM ได้อย่างมีนัยสำคัญ - มีเหตุผลให้เชื่อได้ว่าด้วยวิธีนี้ เราจะสามารถจัดการกับการออกแบบบางอย่างได้ดีขึ้น ภาษาธรรมชาติ- เราเห็นเป้าหมายระยะยาวของเราในการสร้างแบบจำลองที่สามารถ "เข้าใจ" ความสอดคล้องเชิงความหมายระหว่างข้อความค้นหาและเอกสารในระดับที่เทียบเคียงได้กับมนุษย์ จะมีปัญหามากมายระหว่างทางไปสู่เป้าหมายนี้ - ยิ่งน่าสนใจมากเท่าไรก็ยิ่งต้องผ่านมันไปให้ได้ เราสัญญาว่าจะพูดคุยเกี่ยวกับงานของเราในด้านนี้ ติดตามสิ่งพิมพ์ต่อไป