Elke blog heeft hier zijn eigen antwoord op. Daarom raken nieuwkomers op het gebied van zoekmachinepromotie vaak in de war, zoals deze:

Wat voor soort robots ti ex ti?

Bestand robots.txt of indexbestand- een regulier tekstdocument in UTF-8-codering, geldig voor de http-, https- en FTP-protocollen. Het bestand geeft aanbevelingen voor zoekrobots: welke pagina's/bestanden moeten worden gecrawld. Als het bestand tekens bevat in een andere codering dan UTF-8, kunnen zoekrobots deze verkeerd verwerken. De regels in het robots.txt-bestand zijn alleen geldig voor de host, het protocol en het poortnummer waar het bestand zich bevindt.

Het bestand moet zich in de hoofdmap bevinden als een tekstdocument en beschikbaar zijn op: https://site.com.ua/robots.txt.

In andere bestanden is het gebruikelijk om BOM (Byte Order Mark) te markeren. Dit is een Unicode-teken dat wordt gebruikt om de bytevolgorde te bepalen bij het lezen van informatie. Het codekarakter ervan is U+FEFF. Aan het begin van het robots.txt-bestand wordt de bytereeksmarkering genegeerd.

Google heeft een maximale grootte ingesteld voor het robots.txt-bestand: het mag niet meer dan 500 KB wegen.

Oké, als je geïnteresseerd bent in puur technische details: het robots.txt-bestand is een beschrijving in Backus-Naur-vorm (BNF). Hierbij worden de regels van RFC 822 gebruikt.

Bij het verwerken van regels in het robots.txt-bestand ontvangen zoekrobots een van de volgende drie instructies:

- gedeeltelijke toegang: scannen van individuele website-elementen is beschikbaar;

- volledige toegang: u kunt alles scannen;

- volledig verbod: de robot kan niets scannen.

Bij het scannen van het robots.txt-bestand ontvangen robots de volgende reacties:

- 2xx — scannen was succesvol;

- 3xx — de zoekrobot volgt de omleiding totdat hij een ander antwoord ontvangt. Meestal zijn er vijf pogingen voor de robot om een ander antwoord dan 3xx te ontvangen, waarna een 404-fout wordt geregistreerd;

- 4xx — de zoekrobot denkt dat het mogelijk is om de gehele inhoud van de site te crawlen;

- 5xx — worden beoordeeld als tijdelijke serverfouten, scannen is volledig verboden. De robot heeft toegang tot het bestand totdat hij een nieuw antwoord ontvangt. De Google-zoekrobot kan bepalen of het antwoord van ontbrekende pagina's op de site correct of onjuist is geconfigureerd, dat wil zeggen of de pagina in plaats van een 404-fout een 5xx-antwoord retourneert. in dit geval wordt de pagina verwerkt met responscode 404.

Het is nog niet bekend hoe het robots.txt-bestand wordt verwerkt, dat ontoegankelijk is vanwege serverproblemen met internettoegang.

Waarom heb je een robots.txt-bestand nodig?

Soms mogen robots bijvoorbeeld niet bezoeken:

- pagina's met persoonlijke informatie van gebruikers op de site;

- pagina's met verschillende formulieren voor het verzenden van informatie;

- spiegelsites;

- pagina's met zoekresultaten.

Belangrijk: zelfs als de pagina zich in het robots.txt-bestand bevindt, bestaat de mogelijkheid dat deze in de resultaten verschijnt als er een link ernaar wordt gevonden op de site of ergens op een externe bron.

Zo zien robots van zoekmachines een site met en zonder robots.txt-bestand:

Zonder robots.txt kan informatie die voor nieuwsgierige blikken verborgen moet blijven, in de zoekresultaten terechtkomen, en hierdoor zullen zowel u als de site eronder lijden.

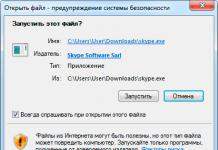

Dit is hoe de robot van de zoekmachine het robots.txt-bestand ziet:

Google heeft het robots.txt-bestand op de site gedetecteerd en de regels gevonden waarmee de pagina's van de site moeten worden gecrawld

Een robots.txt-bestand maken

Met Kladblok, Kladblok, Sublime of een andere teksteditor.

User-agent - visitekaartje voor robots

User-agent: een regel over welke robots de instructies moeten bekijken die worden beschreven in het robots.txt-bestand. Er zijn momenteel 302 zoekrobots bekend

Er staat dat we regels in robots.txt specificeren voor alle zoekrobots.

Voor Google is Googlebot de belangrijkste robot. Als we alleen hiermee rekening willen houden, ziet de invoer in het bestand er als volgt uit:

In dit geval zullen alle andere robots de inhoud crawlen op basis van hun richtlijnen voor het verwerken van een leeg robots.txt-bestand.

Voor Yandex is de belangrijkste robot... Yandex:

Andere speciale robots:

- Googlebot-Nieuws— om naar nieuws te zoeken;

- Mediapartners-Google— voor de AdSense-service;

- AdsBot-Google— om de kwaliteit van de landingspagina te controleren;

- YandexAfbeeldingen— Yandex.Images-indexer;

- Googlebot-afbeelding- voor foto's;

- Yandex Metrika— Yandex.Metrica-robot;

- YandexMedia— een robot die multimediagegevens indexeert;

- YaDirectFetcher— Yandex.Direct-robot;

- Googlebot-Video— voor video;

- Googlebot-Mobiel- voor mobiele versie;

- YandexDirectDyn— dynamische robot voor het genereren van banners;

- YandexBlogs– een blogzoekrobot die berichten en reacties indexeert;

- YandexMarkt— Yandex.Market-robot;

- YandexNieuws– Yandex.News-robot;

- YandexDirect— downloadt informatie over de inhoud van partnersites van het Advertentienetwerk om hun onderwerpen te verduidelijken voor de selectie van relevante advertenties;

- YandexPagechecker— validator voor micro-markeringen;

- YandexKalender- Yandex.Calendar-robot.

Niet toestaan - “stenen” plaatsen

Het is de moeite waard om het te gebruiken als de site bezig is met verbeteringen en u niet wilt dat deze in de huidige staat in de zoekresultaten verschijnt.

Het is belangrijk om deze regel te verwijderen zodra de site klaar is voor gebruikers om deze te bekijken. Helaas vergeten veel webmasters dit.

Voorbeeld. Hoe u een Disallow-regel instelt om robots te adviseren de inhoud van een map niet te bekijken /papka/:

Deze regel verbiedt het indexeren van alle bestanden met de extensie .gif

Toestaan - wij sturen de robots

Met Toestaan kunt u elk bestand/richtlijn/pagina scannen. Stel dat u wilt dat robots alleen pagina's kunnen bekijken die beginnen met /catalog en alle andere inhoud kunnen sluiten. In dit geval wordt de volgende combinatie voorgeschreven:

Regels voor Toestaan en Niet toestaan worden gesorteerd op de lengte van het URL-voorvoegsel (van klein naar groot) en opeenvolgend toegepast. Als er meer dan één regel overeenkomt met een pagina, selecteert de robot de laatste regel in de gesorteerde lijst.

Host - selecteer een mirrorsite

Host is een van de verplichte regels voor robots.txt. Het vertelt de Yandex-robot welke van de mirrors van de site in aanmerking moet komen voor indexering.

Een sitemirror is een exacte of bijna exacte kopie van een site, beschikbaar op verschillende adressen.

De robot raakt niet in de war bij het vinden van sitespiegelservers en begrijpt dat de hoofdspiegelserver is gespecificeerd in het robots.txt-bestand. Het siteadres wordt aangegeven zonder het voorvoegsel ‘http://’, maar als de site op HTTPS draait, moet het voorvoegsel ‘https://’ worden opgegeven.

Hoe deze regel te schrijven:

Een voorbeeld van een robots.txt-bestand als de site op het HTTPS-protocol draait:

Sitemap - medische sitemap

Sitemap vertelt robots dat alle site-URL's die nodig zijn voor indexering zich bevinden op http://site.ua/sitemap.xml. Bij elke crawl kijkt de robot welke wijzigingen in dit bestand zijn aangebracht en werkt hij snel de informatie over de site in de databases van zoekmachines bij.

Crawl-delay - stopwatch voor zwakke servers

Crawl-delay is een parameter die kan worden gebruikt om de periode in te stellen waarna sitepagina's worden geladen. Deze regel is relevant als u een zwakke server heeft. In dit geval kunnen er lange vertragingen optreden wanneer zoekrobots toegang krijgen tot de sitepagina's. Deze parameter wordt gemeten in seconden.

Clean-param - jager op dubbele inhoud

Clean-param helpt bij het omgaan met get-parameters om duplicatie van inhoud te voorkomen die mogelijk beschikbaar is op verschillende dynamische adressen (met vraagtekens). Dergelijke adressen verschijnen als de site verschillende sorteringen, sessie-ID's, enzovoort heeft.

Stel dat de pagina beschikbaar is op de volgende adressen:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

In dit geval ziet het robots.txt-bestand er als volgt uit:

Hier ref geeft aan waar de link vandaan komt, dus deze staat helemaal aan het begin geschreven, en pas dan wordt de rest van het adres aangegeven.

Maar voordat u verdergaat met het referentiebestand, moet u nog enkele tekens leren kennen die worden gebruikt bij het schrijven van een robots.txt-bestand.

Symbolen in robots.txt

De hoofdtekens van het bestand zijn “/, *, $, #”.

Door het gebruiken van schuine streep "/" we laten zien dat we detectie door robots willen voorkomen. Als er bijvoorbeeld één schuine streep in de Disallow-regel staat, verbieden we het scannen van de hele site. Met behulp van twee schuine streeptekens kunt u voorkomen dat een specifieke map wordt gescand, bijvoorbeeld: /catalog/.

Deze vermelding zegt dat we het scannen van de volledige inhoud van de catalogusmap verbieden, maar als we /catalog schrijven, verbieden we alle links op de site die beginnen met /catalog.

Sterretje "*" betekent elke reeks tekens in het bestand. Het wordt na elke regel geplaatst.

Deze vermelding zegt dat alle robots geen bestanden met de extensie .gif in de map /catalog/ mogen indexeren

Dollarteken «$» beperkt de acties van het asterisk-teken. Als u de volledige inhoud van de catalogusmap wilt blokkeren, maar u kunt geen URL's blokkeren die /catalog bevatten, ziet de vermelding in het indexbestand er als volgt uit:

Rooster "#" gebruikt voor opmerkingen die een webmaster voor zichzelf of andere webmasters achterlaat. De robot houdt er geen rekening mee bij het scannen van de site.

Bijvoorbeeld:

Hoe een ideale robots.txt eruit ziet

Het bestand opent de inhoud van de site voor indexering, de host wordt geregistreerd en er wordt een sitemap aangegeven, waardoor zoekmachines altijd de adressen kunnen zien die moeten worden geïndexeerd. De regels voor Yandex worden afzonderlijk gespecificeerd, omdat niet alle robots de hostinstructies begrijpen.

Maar haast u niet om de inhoud van het bestand naar uzelf te kopiëren - elke site moet unieke regels hebben, die afhankelijk zijn van het type site en het CMS. Daarom is het de moeite waard om alle regels te onthouden bij het invullen van het robots.txt-bestand.

Hoe u uw robots.txt-bestand kunt controleren

Als je wilt weten of het robots.txt-bestand correct is ingevuld, controleer dit dan in de webmastertools Googlen en Yandex. Voer eenvoudigweg de broncode van het robots.txt-bestand in het formulier in via de link en specificeer de site die moet worden gecontroleerd.

Hoe u het robots.txt-bestand niet invult

Vaak worden bij het invullen van een indexbestand vervelende fouten gemaakt, die verband houden met gewone onoplettendheid of haast. Hieronder vindt u een overzicht van de fouten die ik in de praktijk tegenkwam.

2. Verschillende mappen/mappen in één Disallow-instructie schrijven:

Zo'n invoer kan zoekrobots in verwarring brengen; ze begrijpen misschien niet wat ze precies niet mogen indexeren: de eerste map of de laatste, dus je moet elke regel afzonderlijk schrijven.

3. Het bestand zelf moet worden aangeroepen alleen robots.txt, en niet Robots.txt, ROBOTS.TXT of iets anders.

4. U kunt de User-agent-regel niet leeg laten. U moet aangeven welke robot rekening moet houden met de regels die in het bestand zijn geschreven.

5. Extra tekens in het bestand (slashes, asterisken).

6. Pagina's toevoegen aan het bestand die niet in de index mogen staan.

Niet-standaard gebruik van robots.txt

Naast directe functies kan het indexbestand een platform worden voor creativiteit en een manier om nieuwe medewerkers te vinden.

Hier is een site waar robots.txt zelf een kleine site is met werkende elementen en zelfs een advertentie-eenheid.

Het bestand wordt vooral door SEO-bureaus gebruikt als platform voor het zoeken naar specialisten. Wie weet er nog meer van het bestaan ervan? :)

En Google heeft een speciaal bestand mensen.txt, zodat je niet nadenkt over discriminatie van leer- en vleesspecialisten.

conclusies

Met behulp van Robots.txt kun je instructies geven om robots te zoeken, reclame maken voor jezelf, je merk en op zoek gaan naar specialisten. Dit is een geweldig veld voor experimenten. Het belangrijkste is om te onthouden dat u het bestand correct invult en dat u typische fouten opmerkt.

Regels, ook wel richtlijnen genoemd, ook wel instructies genoemd in het robots.txt-bestand:

- User-agent - een regel over welke robots de instructies moeten bekijken die worden beschreven in robots.txt.

- Disallow geeft aanbevelingen over welke informatie niet mag worden gescand.

- Sitemap vertelt robots dat alle site-URL's die nodig zijn voor indexering zich op http://site.ua/sitemap.xml bevinden.

- De host vertelt de Yandex-robot welke van de sitespiegels in aanmerking moeten komen voor indexering.

- Met Toestaan kunt u elk bestand/richtlijn/pagina scannen.

Tekenen bij het compileren van robots.txt:

- Het dollarteken "$" beperkt de acties van het asterisk-teken.

- Met de schuine streep “/” geven we aan dat we het willen verbergen voor detectie door robots.

- Het sterretje "*" betekent een willekeurige reeks tekens in het bestand. Het wordt na elke regel geplaatst.

- De hash "#" wordt gebruikt om commentaar aan te geven dat een webmaster voor zichzelf of voor andere webmasters schrijft.

Gebruik het indexbestand verstandig - en de site zal altijd in de zoekresultaten verschijnen.

Bestand robots.txt is een gewoon bestand met de extensie .txt, dat kan worden gemaakt met een gewoon Windows-kladblok. Dit bestand bevat instructies voor het indexeren van zoekrobots. Plaats dit rootdirectorybestand op de hosting.

Bij het betreden van een site gaat een zoekrobot eerst naar het robots.txt-bestand om instructies te ontvangen voor verdere actie en om uit te zoeken welke bestanden en mappen niet mogen worden geïndexeerd. Bestand robots.txt is adviserend van aard voor zoekmachines. Het kan niet met absolute zekerheid worden gezegd dat alle bestanden die niet mogen worden geïndexeerd, uiteindelijk niet zullen worden geïndexeerd.

Laten we eens kijken naar een eenvoudig voorbeeld van een robots.txt-bestand. Dit bestand bevat de volgende regels:

User-agent: * Niet toestaan: /wp-admin/ Niet toestaan: /images/

De eerste regel geeft aan voor welke zoekrobots deze instructies gelden. In dit voorbeeld is een asterisk aangegeven - dit betekent dat de instructies van toepassing zijn op alle zoekrobots. Als u instructies moet geven voor een specifieke zoekrobot, moet u de naam ervan invoeren. De tweede en derde regel verbieden het indexeren van de mappen “wp-admin” en “images”.

Voor de Yandex-zoekrobot is het ook belangrijk om de Host-map te registreren om de hoofdspiegel van de site aan te geven:

User-agent: Yandex Disallow: /wp-admin/ Disallow: /images/ Host: jouwsite.ru

Voorbeelden van het schrijven van een robots.txt-bestand voor specifieke taken

1. Verbied robots van zoekmachines niet om de site te indexeren:

User-agent: googlebot Niet toestaan: /

4. Verbied indexering door slechts één robot (bijvoorbeeld Googlebot) niet en verbied alle andere zoekrobots om te indexeren:

User-agent: googlebot Niet toestaan:

User-agent: * Niet toestaan: /admin/ Niet toestaan: /wp-content/ Niet toestaan: /images/

User-agent: * Niet toestaan: /News/webnews.html Niet toestaan: /content/page.php

User-agent: * Niet toestaan: /page.php Niet toestaan: /links.htm Niet toestaan: /secret.html

Basisregels voor het schrijven van robots.txt

Er worden vaak fouten gemaakt bij het schrijven van het robots.txt-bestand. Laten we eens kijken naar de basisregels om ze te vermijden:

1. De inhoud van het bestand mag uitsluitend in hoofdletters worden geschreven.

2. De Disallow-instructie mag slechts één map of één bestand specificeren.

3. De regel “User-agent” mag niet leeg zijn. Als de instructies op alle zoekrobots van toepassing zijn, moet u een asterisk aangeven, en als ze op een specifieke zoekrobot van toepassing zijn, moet u de naam ervan vermelden.

4. De Disallow- en User-agent-instructies kunnen niet worden verwisseld.

5. In de Host-richtlijn, die wordt gebruikt voor Yandex, moet het adres van onze site worden opgegeven zonder het HTTP-protocol en zonder een afsluitende slash.

6. Wanneer het indexeren van mappen wordt verboden, is het noodzakelijk om schuine strepen op te nemen.

7. Controleer het robots.txt-bestand voordat u het naar de server uploadt. Dit voorkomt mogelijke problemen met site-indexering in de toekomst.

Robots.txt voor de site is een indextekstbestand in UTF-8-codering.

Het werd index genoemd omdat het aanbevelingen bevat voor zoekrobots: welke pagina's moeten worden gecrawld en welke niet.

Als de bestandscodering afwijkt van UTF-8, kunnen zoekrobots de informatie daarin verkeerd waarnemen.

Het bestand is geldig voor de http-, https- en ftp-protocollen en heeft ook alleen “power” binnen de grenzen van het host-/protocol-/poortnummer waarop het zich bevindt.

Waar bevindt robots.txt zich op de site?

Het robots.txt-bestand kan slechts één locatie hebben: de hoofdmap op de hosting. Het ziet er ongeveer zo uit: http://uw-site.xyz/robots.txt

Robots txt-bestandsrichtlijnen voor de site

De vereiste componenten van het robots.txt-bestand voor een site zijn de Disallow-regel en de User-agent-instructie. Er zijn ook kleine regels.

Regel niet toestaan

Disallow is een regel die de zoekrobot vertelt welke pagina's het niet heeft om te crawlen. En slechts een paar specifieke voorbeelden van de toepassing van deze regel:

Voorbeeld 1 - Toegestaan om de hele site te indexeren:

Voorbeeld 2 - site-indexering volledig verbieden:

In dat geval zal het nutteloos zijn. Het gebruik van dit voorbeeld is relevant als de site “gesloten” is voor verbetering (de site functioneert bijvoorbeeld niet goed). In dit geval heeft de site geen plaats in de zoekresultaten, dus moet de site worden afgesloten voor indexering via het robots txt-bestand. Nadat de site klaar is, zou het verbod op indexeren natuurlijk moeten worden opgeheven, maar mensen vergeten dit.

Voorbeeld 6 - hoe bestanden met een specifieke extensie (in dit geval - .gif) kunnen worden geblokkeerd voor indexering in robots txt:

Het sterretje vóór .gif$ geeft aan dat de bestandsnaam van alles kan zijn, en het $-teken geeft het einde van de regel aan. Die. zo'n “masker” verbiedt het scannen van alle GIF-bestanden.

Regel toestaan in robots txt

De regel Toestaan doet precies het tegenovergestelde: hij staat indexering van een bestand/map/pagina toe.

En meteen een concreet voorbeeld:

We weten al dat we met behulp van de Disallow: / richtlijn de site kunnen blokkeren voor robots txt-indexering. Tegelijkertijd hebben we een regel Toestaan: /catalog, waarmee u de map /catalog kunt scannen. Daarom zal de combinatie van deze twee regels door zoekrobots worden opgevat als “het is verboden om de site te crawlen, met uitzondering van de map /catalog”

Regels en richtlijnen voor Toestaan en Niet toestaan worden gesorteerd op oplopende lengte van het URL-voorvoegsel en opeenvolgend toegepast. Als er meerdere regels geschikt zijn voor dezelfde pagina, selecteert de robot de laatste geschikte uit de lijst.

Laten we twee situaties bekijken met twee regels die elkaar tegenspreken: de ene regel verbiedt het indexeren van de /content-mappen, en de andere staat dit toe.

In dit geval heeft de Allow-richtlijn voorrang, omdat het staat hieronder in de lijst:

Maar hier heeft de Disallow-richtlijn om dezelfde redenen prioriteit (onder de lijst):

User-agent in robots txt

User-agent is een regel die een “oproep” doet aan een zoekrobot, zogenaamd “een lijst met aanbevelingen speciaal voor jou” (er kunnen trouwens verschillende lijsten zijn in robots.txt - voor verschillende zoekrobots van Google en Yandex ).

In dit geval zeggen we bijvoorbeeld: 'Hé, Googlebot, kom hier, hier is een speciaal opgestelde lijst met aanbevelingen voor jou', en dan zeggen we: 'Oké, vooral voor mij, dat betekent speciaal voor mij', en dat doen we niet. andere lijsten scannen.

Correcte robots-txt voor Google (Googlebot)

Het gaat over hetzelfde verhaal met de Yandex-zoekbot. Vooruitkijkend wijkt de lijst met aanbevelingen voor Yandex in bijna 100% van de gevallen enigszins af van de lijst voor andere zoekrobots (we zullen u later vertellen waarom). Maar de essentie is hetzelfde: "Hé, Yandex, er is een aparte lijst voor je" - "Oké, laten we die nu bestuderen."

Die. als er in dezelfde robots.txt 3 lijsten zijn met User-agent: *, User-agent: Googlebot en User-agent: Yandex, betekent dit dat de eerste “één voor iedereen” is, met uitzondering van Googlebot en Yandex , d.w.z. Aan. er zijn “persoonlijke” lijsten voor hen.

Sitemap

Sitemapregel: de locatie van een bestand met een XML-sitemap die de adressen bevat van alle pagina's die moeten worden gecrawld. In de regel wordt een adres als http://site.ua/sitemap.xml opgegeven.

Die. elke keer zal de zoekrobot naar de sitemap kijken naar nieuwe adressen en deze vervolgens volgen voor verder scannen om informatie over de site in de databases van zoekmachines bij te werken.

De sitemapregel moet als volgt in Robots.txt worden ingevoerd:

Hostrichtlijn

De transversale Host-instructie in het robots.txt-bestand is ook vereist. Dit is noodzakelijk voor de Yandex-zoekrobot: hij vertelt met welke van de spiegels van de site rekening moet worden gehouden bij het indexeren. Dat is de reden waarom er voor Yandex een aparte lijst met regels wordt gevormd, omdat Google en andere zoekmachines begrijpen de Host-richtlijn niet. Als uw site kopieën heeft of als de site onder verschillende URL's kan worden geopend, voegt u daarom de hostinstructie toe aan het robots txt-bestand, zodat de sitepagina's correct worden geïndexeerd.

Een “site mirror” wordt gewoonlijk een exacte of bijna exacte “kopie” van een site genoemd, die op een ander adres beschikbaar is.

Het hoofdspiegeladres moet als volgt worden opgegeven:

Voor sites die werken via http - Host: site.ua of Host: http://site.ua (d.w.z. http:// wordt optioneel geschreven)

Voor sites die op https draaien - Host: https://site.ua (d.w.z. https:// is verplicht)

Een voorbeeld van een hostrichtlijn in robots txt voor een site die het HTTPS-protocol gebruikt:

Crawlvertraging

In tegenstelling tot de vorige is de parameter Crawl-delay niet langer verplicht. De belangrijkste taak is om de zoekrobot te vertellen hoeveel seconden het duurt voordat de pagina's zijn geladen. Meestal gebruikt als u zwakke servers gebruikt. Alleen relevant voor Yandex.

Reinig parameters

Met behulp van de Clean-param-richtlijn kunt u get-parameters bestrijden om duplicatie van inhoud te voorkomen, omdat dezelfde inhoud is toegankelijk via verschillende dynamische links (dit zijn de links met vraagtekens). Dynamische links kunnen door een site worden gegenereerd wanneer verschillende sorteringen worden gebruikt, sessie-ID's worden gebruikt, enz.

Dezelfde inhoud kan bijvoorbeeld op drie adressen beschikbaar zijn:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

In dit geval is de Clean-param-richtlijn als volgt opgemaakt:

Die. na de dubbele punt wordt het ref-attribuut geschreven, dat de bron van de link aangeeft, en alleen dan wordt de “staart” aangegeven (in dit geval - /catalog/get_phone.ua).

Meest gestelde vragen

Hoe schakel ik indexering in robots.txt uit?

Voor deze doeleinden is de Disallow-regel uitgevonden: d.w.z. kopieer de link naar het document/bestand dat moet worden gesloten voor indexering en plak deze na de dubbele punt:

Niet toestaan: http://uw-site.xyz/privance.html

Niet toestaan: http://uw-site.xyz/foord.doc

Niet toestaan: http://uw-site.xyz/barcode.jpg

En verwijder vervolgens het domeinadres (in dit geval moet u dit gedeelte verwijderen: http://uw-site.xyz). Na verwijdering houden we precies over wat er moet blijven:

Niet toestaan: /privance.html

Niet toestaan: /foord.doc

Niet toestaan: /barcode.jpg

Als je wilt voorkomen dat alle bestanden met een bepaalde extensie worden geïndexeerd, dan zien de regels er als volgt uit:

Niet toestaan: /*.html

Niet toestaan: /*.doc

Niet toestaan: /*.jpg

Hoe specificeer ik de hoofdspiegel in robots.txt?

Voor deze doeleinden is de Host-richtlijn uitgevonden. Die. als de adressen http://uw-site.xyz en http://uwsite.com “spiegels” zijn van dezelfde site, dan moet één daarvan worden gespecificeerd in de Host-instructie. Laat de hoofdspiegel http://uw-site.xyz zijn. In dit geval zijn de juiste opties de volgende:

Als de site werkt met het https-protocol, hoeft u alleen dit te doen:

Gebruikersagent: Yandex

Niet toestaan: /privance.html

Niet toestaan: /foord.doc

Niet toestaan: /barcode.jpg

Host: https://uw-site.xyz

Als de site werkt met het http-protocol, zijn beide onderstaande opties correct:

Gebruikersagent: Yandex

Niet toestaan: /privance.html

Niet toestaan: /foord.doc

Niet toestaan: /barcode.jpg

Host: http://uw-site.xyz

Gebruikersagent: Yandex

Niet toestaan: /privance.html

Niet toestaan: /foord.doc

Niet toestaan: /barcode.jpg

Host: uw-site.xyz

Houd er echter rekening mee dat de Host-richtlijn een aanbeveling is en geen regel. Die. het is mogelijk dat één domein wordt gespecificeerd in de Host, en dat Yandex een ander domein als de hoofdspiegel beschouwt als de juiste instellingen zijn ingevoerd in het webmasterpaneel.

Het eenvoudigste voorbeeld van correcte robots.txt

In deze vorm kan het robots.txt-bestand (met de kleinste aanpassingen) op vrijwel elke website worden geplaatst.

Laten we nu eens kijken wat er is.

- Er zijn 2 lijsten met regels: de ene "persoonlijk" voor Yandex, de andere - voor alle andere zoekrobots.

- Disallow-regel: leeg, wat betekent dat er geen beperkingen zijn voor het scannen.

- De lijst voor Yandex bevat een Host-instructie die de hoofdspiegel aangeeft, evenals een link naar de sitemap.

MAAR... Dit betekent NIET dat u robots.txt op deze manier moet formatteren. De regels moeten strikt individueel voor elke site worden geschreven. Het heeft bijvoorbeeld geen zin om “technische” pagina’s te indexeren (pagina’s voor het invoeren van login en wachtwoord, of testpagina’s waarop een nieuw siteontwerp wordt getest, enz.). De regels zijn overigens ook afhankelijk van het gebruikte CMS.

Een site die niet meer kan worden geïndexeerd: hoe ziet robots.txt eruit?

We leveren onmiddellijk kant-en-klare code waarmee u site-indexering kunt verbieden, ongeacht het CMS:

Hoe specificeer ik de hoofdspiegel voor een site op https robots.txt?

Erg makkelijk:

Host: https://uw-site.xyz

BELANGRIJK!!! Voor https-sites moet het protocol strikt worden gespecificeerd!

De meest voorkomende fouten in robots.txt

Speciaal voor jou hebben we een selectie gemaakt van de meest voorkomende fouten in robots.txt. Bijna al deze fouten hebben één ding gemeen: ze worden gemaakt door onzorgvuldigheid.

1. Gemengde instructies:

Juiste optie:

2. Er worden een aantal mappen in één Disallow ingevoegd:

Bij zo’n opname kan de robot in de war raken. Welke map kan niet worden geïndexeerd? De eerste? De laatste? Of allemaal? Of hoe? Of wat? Eén map = één Disallow-regel en niets anders.

3. Er is slechts één bestandsnaam toegestaan: robots.txt, en alle letters zijn klein. Namen Robots.txt, ROBOTS.TXT, enz. niet toegestaan.

4. De User-agent-regel mag niet leeg blijven. Ofwel geven we de naam van de zoekrobot aan (bijvoorbeeld voor Yandex), of plaatsen we een asterisk (voor alle andere).

5. Onzin in het bestand (extra schuine strepen, sterretjes, etc.).

6. Volledige adressen van verborgen pagina's aan het bestand toevoegen, soms zelfs zonder de Disallow-regel.

Fout:

http://mega-site.academy/serrot.html

Ook fout:

Niet toestaan: http://mega-site.academy/serrot.html

Rechts:

Niet toestaan: /serrot.html

Online controle van het robots.txt-bestand

Er zijn verschillende manieren om te controleren of uw robots.txt-bestand voldoet aan de algemeen aanvaarde standaard op internet.

Methode 1. Registreer u in de webmasterpanelen van Yandex en Google. Het enige negatieve is dat je moet graven om de functionaliteit te achterhalen. Vervolgens worden de aanbevolen wijzigingen aangebracht en wordt het voltooide bestand geüpload naar de hosting.

Methode 2. Gebruik online services:

https://services.sl-team.ru/other/robots/

https://technicalseo.com/seo-tools/robots-txt/

Http://tools.seochat.com/tools/robots-txt-validator/

Er wordt dus robots.txt gegenereerd. Het enige dat overblijft is het controleren op fouten. Hiervoor kun je het beste gebruik maken van de tools die de zoekmachines zelf aanbieden.

Google Webmasters (Google Search Console): log in op uw account. Als de site daarin niet is bevestigd, bevestigt u dit en gaat u vervolgens naar Crawlen -> Robots.txt-bestandsverificatietool.

Hier kan je:

- detecteer onmiddellijk alle fouten en potentiële problemen,

- breng onmiddellijk correcties “ter plekke” aan en controleer opnieuw op fouten (om het bestand niet 20 keer opnieuw naar de site te uploaden)

- controleer de juistheid van de verbodsbepalingen en machtigingen voor pagina-indexering.

Het is vergelijkbaar met de vorige, behalve:

- toestemming is niet vereist;

- bevestiging van rechten op de site is niet nodig;

- massale controle van pagina's op toegankelijkheid is beschikbaar;

- u kunt ervoor zorgen dat alle regels correct worden geaccepteerd door Yandex.

Kant-en-klare oplossingen voor het populairste CMS

Corrigeer robots.txt voor Wordpress

Disallow: /cgi-bin # klassiekers van het genre

Niet toestaan: /? # alle verzoekparameters op de hoofdpagina

Disallow: /wp- # alle WP-bestanden: /wp-json/, /wp-includes, /wp-content/plugins

Niet toestaan: *?s= # zoeken

Niet toestaan: *&s= # zoeken

Niet toestaan: /search # zoeken

Niet toestaan: *?attachment_id= # bijlagepagina. Eigenlijk is het een omleiding...

Niet toestaan: */feed # alle feeds

Niet toestaan: */rss # RSS-feed

Niet toestaan: */embed # alle insluitingen

Disallow: */page/ # alle soorten paginering

Toestaan: */uploads # open uploads

Toestaan: /*/*.js # inside /wp- (/*/ - voor prioriteit)

Toestaan: /*/*.css # binnen /wp- (/*/ - voor prioriteit)

Toestaan: /wp-*.png # afbeeldingen in plug-ins, cachemap, etc.

Toestaan: /wp-*.jpg # afbeeldingen in plug-ins, cachemap, enz.

Toestaan: /wp-*.jpeg # afbeeldingen in plug-ins, cachemap, enz.

Toestaan: /wp-*.gif # afbeeldingen in plug-ins, cachemap, etc.

Toestaan: /wp-*.svg # afbeeldingen in plug-ins, cachemap, enz.

Toestaan: /wp-*.pdf # bestanden in plug-ins, cachemap, etc.

#Disallow: /wp/ # wanneer WP is geïnstalleerd in de wp-submap

Sitemap: http://site.ru/sitemap2.xml # nog een bestand

#Sitemap: http://site.ru/sitemap.xml.gz # gecomprimeerde versie (.gz)

Host: www.site.ru # voor Yandex en Mail.RU. (intersectioneel)

# Codeversie: 1.0

# Vergeet niet `site.ru` naar uw site te wijzigen.

Laten we eens kijken naar de robots txt-bestandscode voor WordPress CMS:

Hier geven we aan dat alle regels relevant zijn voor alle zoekrobots (met uitzondering van degenen voor wie “persoonlijke” lijsten zijn samengesteld). Als de lijst voor een specifieke robot wordt samengesteld, wordt * gewijzigd in de naam van de robot:

Gebruikersagent: Yandex

User-agent: Googlebot

Toestaan: */uploads

Hier geven we bewust groen licht voor het indexeren van links die /uploads bevatten. In dit geval is deze regel verplicht, omdat in de WordPress-engine bevindt zich een map /wp-content/uploads (die mogelijk afbeeldingen of andere “open” inhoud bevat), waarvan indexering verboden is door de Disallow-regel: /wp-. Daarom maken we met behulp van Allow: */uploads een uitzondering op de Disallow: /wp- regel.

Anders zijn er eenvoudigweg verboden op indexering:

Disallow: /cgi-bin - verbied indexeringsscripts

Disallow: /feed - verbiedt het scannen van de RSS-feed

Disallow: /trackback - verbied scanmeldingen

Disallow: ?s= of Disallow: *?s= - verbiedt indexering van interne zoekpagina's van de site

Disallow: */page/ - verbiedt indexering van alle soorten paginering

De sitemapregel: http://site.ru/sitemap.xml vertelt de Yandex-robot het pad naar het bestand met de xml-kaart. Het pad moet volledig worden opgegeven. Als er meerdere van dergelijke bestanden zijn, schrijven we verschillende sitemapregels (1 bestand = 1 regel).

In de regel Host: site.ru hebben we specifiek de hoofdspiegel van de site voor Yandex geregistreerd. Het is zo gespecificeerd dat andere spiegels gelijkelijk worden geïndexeerd. Een lege regel vóór Host: is vereist.

Jullie weten waarschijnlijk allemaal waar WordPress robots txt zich bevindt - net als in andere CMS'en zou dit bestand zich in de hoofdmap van de site moeten bevinden.

Robots.txt-bestand voor Joomla

Joomla is bijna de meest populaire engine onder webmasters, omdat... Ondanks de ruimste mogelijkheden en de vele kant-en-klare oplossingen is het gratis. Het is echter altijd zinvol om de standaard robots.txt te corrigeren, omdat Er is te veel “afval” open voor indexering, maar de foto’s zijn gesloten (dit is slecht).

Dit is hoe de juiste robots.txt voor Joomla eruit ziet:

Niet toestaan: /administrator/

Niet toestaan: /cache/

Niet toestaan: /componenten/

Niet toestaan: /images/

Niet toestaan: / omvat /

Niet toestaan: /installatie/

Niet toestaan: /taal/

Niet toestaan: /layouts/

Niet toestaan: /bibliotheken/

Niet toestaan: /logs/

Niet toestaan: /media/

Niet toestaan: /modules/

Niet toestaan: /plugins/

Niet toestaan: /templates/

robots.txt Wix

Het Wix-platform genereert automatisch afzonderlijk robots.txt-bestanden voor elke Wix-site. Die. voeg /robots.txt toe aan uw domein (bijvoorbeeld: www.domain.com/robots.txt) en u kunt veilig de inhoud van het robots.txt-bestand op uw site bestuderen.

Robots.txt kan niet worden bewerkt. Met noindex kunt u echter voorkomen dat bepaalde pagina's worden geïndexeerd.

robots.txt voor Opencart

Standaard robots.txt-bestand voor OpenCart:

Niet toestaan: /*route=account/

Niet toestaan: /*route=affiliate/

Niet toestaan: /*route=afrekenen/

Niet toestaan: /admin

Niet toestaan: /catalog

Niet toestaan: /download

Niet toestaan: /export

Niet toestaan: /system

Niet toestaan: /*?sort=

Niet toestaan: /*&sort=

Niet toestaan: /*?order=

Niet toestaan: /*&order=

Niet toestaan: /*?limit=

Niet toestaan: /*&limit=

Niet toestaan: /*?filter_name=

Niet toestaan: /*&filter_name=

Niet toestaan: /*?filter_sub_category=

Niet toestaan: /*&filter_sub_category=

Niet toestaan: /*?filter_description=

Niet toestaan: /*&filter_description=

Niet toestaan: /*?tracking=

Niet toestaan: /*&tracking=

Niet toestaan: /*?page=

Niet toestaan: /*&page=

Niet toestaan: /verlanglijst

Niet toestaan: /login

Gebruikersagent: Yandex

Niet toestaan: /*route=account/

Niet toestaan: /*route=affiliate/

Niet toestaan: /*route=afrekenen/

Niet toestaan: /*route=product/zoeken

Niet toestaan: /index.php?route=product/product*&manufacturer_id=

Niet toestaan: /admin

Niet toestaan: /catalog

Niet toestaan: /download

Niet toestaan: /export

Niet toestaan: /system

Niet toestaan: /*?sort=

Niet toestaan: /*&sort=

Niet toestaan: /*?order=

Niet toestaan: /*&order=

Niet toestaan: /*?limit=

Niet toestaan: /*&limit=

Niet toestaan: /*?tracking=

Niet toestaan: /*&tracking=

Niet toestaan: /*route=product/zoeken

Niet toestaan: /*?page=

Niet toestaan: /*&page=

Clean-param: tracking

Clean-param: filternaam

Clean-param: filter_sub_category

Clean-param: filter_description

Niet toestaan: /verlanglijst

Niet toestaan: /login

Niet toestaan: /index.php?route=product/fabrikant

Niet toestaan: /index.php?route=product/compare

Niet toestaan: /index.php?route=product/categorie

Host: Uw_domein

Sitemap: http://Vash_domain/sitemap.xml

robots.txt voor Bitrix

1. De mappen /bitrix en /cgi-bin moeten gesloten zijn, omdat Dit is puur technisch “afval” dat niet in de zoekresultaten hoeft te verschijnen.

Niet toestaan: /bitrix

Niet toestaan: /cgi-bin

2. De map /search is ook niet interessant voor gebruikers of zoekmachines. En niemand heeft de vorming van duplicaten nodig. Daarom sluiten wij deze ook.

Niet toestaan: /zoeken

Niet toestaan: /auth/

Niet toestaan: /auth.php

4. Ook het afdrukken van materialen (bijvoorbeeld facturen) heeft geen zin om in de zoekresultaten te verschijnen. Laten we sluiten.

Niet toestaan: /*?print=

Niet toestaan: /*&print=

5. Een van de grote voordelen van Bitrix is dat het de volledige geschiedenis van de site registreert: wie wanneer heeft ingelogd, wie wanneer het wachtwoord heeft gewijzigd en andere vertrouwelijke informatie die niet kan worden gelekt. Daarom sluiten wij:

Niet toestaan: /*register=ja

Niet toestaan: /*forgot_password=ja

Niet toestaan: /*change_password=yes

Niet toestaan: /*login=ja

Niet toestaan: /*uitloggen=ja

Niet toestaan: /*auth=ja

6. Het heeft ook geen zin om achteradressen te indexeren. Deze adressen kunnen bijvoorbeeld worden gevormd wanneer u een fotoalbum bekijkt, wanneer u er eerst “vooruit” en vervolgens “terug” doorheen bladert. Op deze momenten kan er zoiets als een obscene vloek in de adresbalk verschijnen: ?back_url_ =%2Fbitrix%2F%2F. De waarde van dergelijke adressen is nul, dus we sluiten ze ook uit van indexering. Als bonus verwijderen we mogelijke ‘duplicaten’ in de zoekresultaten.

Niet toestaan: /*BACKURL=*

Niet toestaan: /*back_url=*

Niet toestaan: /*BACK_URL=*

Niet toestaan: /*back_url_admin=*

7. Afhankelijk van de omstandigheden moet de map /upload strikt gesloten zijn. Als foto's en videomateriaal op pagina's daar worden opgeslagen, hoeft u deze niet te verbergen om extra verkeer niet af te sluiten. Als er iets vertrouwelijks is, sluiten we het zeker:

Niet toestaan: /uploaden

Kant-en-klaar robots.txt-bestand voor Bitrix:

Toestaan: /search/map.php

Toestaan: /bitrix/templates/

Niet toestaan: */index.php

Niet toestaan: /*action=

Niet toestaan: /*print=

Niet toestaan: /*/gallery/*order=

Niet toestaan: /*/zoeken/

Niet toestaan: /*/slide_show/

Niet toestaan: /*?utm_source=

Niet toestaan: /*ADD_TO_COMPARE_LIST

Niet toestaan: /*arrFilter=

Niet toestaan: /*auth=

Niet toestaan: /*back_url_admin=

Niet toestaan: /*BACK_URL=

Niet toestaan: /*back_url=

Niet toestaan: /*backurl=

Niet toestaan: /*bitrix_*=

Niet toestaan: /*bitrix_include_areas=

Niet toestaan: /*building_directory=

Niet toestaan: /*bxajaxis=

Niet toestaan: /*change_password=

Niet toestaan: /*clear_cache_session=

Niet toestaan: /*clear_cache=

Niet toestaan: /*count=

Niet toestaan: /*COURSE_ID=

Niet toestaan: /*forgot_password=

Niet toestaan: /*index.php$

Niet toestaan: /*login=

Niet toestaan: /*uitloggen=

Niet toestaan: /*modern-repair/$

Niet toestaan: /*MUL_MODE=

Niet toestaan: /*ORDER_BY

Niet toestaan: /*PAGE_NAME=

Niet toestaan: /*PAGE_NAME=detail_slide_show

Niet toestaan: /*PAGE_NAME=zoeken

Niet toestaan: /*PAGE_NAME=user_post

Niet toestaan: /*PAGEN_

Niet toestaan: /*print_course=

Niet toestaan: /*print=

Niet toestaan: /*register=

Niet toestaan: /*register=ja

Niet toestaan: /*set_filter=

Niet toestaan: /*show_all=

Niet toestaan: /*show_include_exec_time=

Niet toestaan: /*show_page_exec_time=

Niet toestaan: /*show_sql_stat=

Niet toestaan: /*SHOWALL_

Niet toestaan: /*sort=

Niet toestaan: /*sphrase_id=

Niet toestaan: /*tags=

Niet toestaan: /access.log

Niet toestaan: /admin

Niet toestaan: /auth.php

Niet toestaan: /bitrix

Niet toestaan: /bitrix/

Niet toestaan: /cgi-bin

Niet toestaan: /club/$

Niet toestaan: /club/forum/search/

Niet toestaan: /club/gallery/tags/

Niet toestaan: /club/group/search/

Niet toestaan: /club/log/

Niet toestaan: /club/berichten/

Niet toestaan: /club/search/

Niet toestaan: /communication/blog/search.php

Niet toestaan: /communicatie/forum/zoeken/

Niet toestaan: /communicatie/forum/gebruiker/

Niet toestaan: /content/board/my/

Niet toestaan: /content/links/my/

Niet toestaan: /error

Niet toestaan: /e-store/affiliates/

Niet toestaan: /e-store/paid/detail.php

Niet toestaan: /examples/download/download_private/

Niet toestaan: /voorbeelden/mijn-componenten/

Niet toestaan: /include

Niet toestaan: /persoonlijk

Niet toestaan: /zoeken

Niet toestaan: /uploaden

Niet toestaan: /*/*ELEMENT_CODE=

Niet toestaan: /*/*SECTION_CODE=

Niet toestaan: /*/*IBLOCK_CODE

Niet toestaan: /*/*ELEMENT_ID=

Niet toestaan: /*/*SECTION_ID=

Niet toestaan: /*/*IBLOCK_ID=

Niet toestaan: /*/*CODE=

Niet toestaan: /*/*ID=

Niet toestaan: /*/*IBLOCK_EXTERNAL_ID=

Niet toestaan: /*/*SECTION_CODE_PATH=

Niet toestaan: /*/*EXTERNAL_ID=

Niet toestaan: /*/*IBLOCK_TYPE_ID=

Niet toestaan: /*/*SITE_DIR=

Niet toestaan: /*/*SERVER_NAME=

Sitemap: http://site.ru/sitemap_index.xml

Sitemap: http://site.ru/sitemap.xml

robots.txt voor Modx en Modx Revo

CMS Modx Revo is ook niet zonder het probleem van duplicaten. Het is echter niet zo ernstig als bij Bitrix. Nu over haar beslissing.

- We schakelen CNC in de site-instellingen in.

- sluiten van indexering:

Niet toestaan: /index.php # omdat Dit is een duplicaat van de hoofdpagina van de site

Niet toestaan: /*? # los het probleem met duplicaten voor alle pagina's in één keer op

Klaar robots.txt-bestand voor Modx en Modx Revo:

Niet toestaan: /*?id=

Niet toestaan: /assets

Niet toestaan: /assets/cache

Niet toestaan: /assets/components

Niet toestaan: /assets/docs

Niet toestaan: /assets/export

Niet toestaan: /assets/import

Niet toestaan: /assets/modules

Niet toestaan: /assets/plugins

Niet toestaan: /assets/snippets

Niet toestaan: /connectors

Niet toestaan: /index.php

Niet toestaan: /install

Niet toestaan: /manager

Niet toestaan: /profile

Niet toestaan: /zoeken

Sitemap: http://site.ru/sitemap.xml

conclusies

Zonder overdrijving kan het robots.txt-bestand “een gids voor Yandex- en Google-zoekrobots” worden genoemd (uiteraard als het correct is samengesteld). Als het robots txt-bestand ontbreekt, moet u het maken en uploaden naar uw websitehosting. Help Disallow-regels worden hierboven in dit artikel beschreven en u kunt ze veilig voor uw eigen doeleinden gebruiken.

We vatten nogmaals de regels/richtlijnen/instructies voor robots.txt samen:

- User-agent - geeft aan voor welke zoekrobot de lijst met regels is gemaakt.

- Niet toestaan - “Ik raad aan dit niet te indexeren.”

- Sitemap - Specificeert de locatie van de XML-sitemap met alle URL's die moeten worden geïndexeerd. In de meeste gevallen bevindt de kaart zich op http://[uw_site]/sitemap.xml.

- Crawl-delay is een richtlijn die de periode (in seconden) aangeeft waarna de sitepagina wordt geladen.

- Host - toont Yandex de hoofdspiegel van de site.

- Toestaan - “Ik raad aan dit te indexeren, ondanks het feit dat dit in tegenspraak is met een van de Disallow-regels.”

- Clean-param - helpt bij de strijd tegen get-parameters en wordt gebruikt om het risico op dubbele pagina's te verminderen.

Tekenen bij het compileren van robots.txt:

- Het "$"-teken voor "asterisk" is een "scheidingsteken".

- Na de schuine streep “/” wordt de naam van het bestand/map/extensie aangegeven die verborgen moet worden (in het geval van Disallow) of geopend (in het geval van Allow) voor indexering.

- Het teken “*” betekent “een willekeurig aantal tekens.”

- Het teken “#” scheidt eventuele opmerkingen of aantekeningen die de webmaster voor zichzelf of voor iemand anders heeft achtergelaten. Zoekrobots lezen ze niet.

Het eerste dat een zoekbot doet als het om uw site gaat, is het robots.txt-bestand zoeken en lezen. Wat is dit bestand? is een set instructies voor een zoekmachine.

Het is een tekstbestand met de extensie txt, dat zich in de hoofdmap van de site bevindt. Deze reeks instructies vertelt de zoekrobot welke pagina's en bestanden op de site moeten worden geïndexeerd en welke niet. Het geeft ook de hoofdspiegel van de site aan en waar u de sitemap kunt zoeken.

Waar is het robots.txt-bestand voor? Voor een goede indexering van uw site. Zodat de zoekopdracht geen dubbele pagina's, verschillende servicepagina's en documenten bevat. Zodra u richtlijnen in robots correct configureert, bespaart u uw site veel problemen met indexering en site-mirroring.

Hoe u de juiste robots.txt maakt

Het is vrij eenvoudig om robots.txt te maken; we maken een tekstdocument in een standaard Windows-kladblok. In dit bestand schrijven we richtlijnen voor zoekmachines. Sla dit bestand vervolgens op onder de naam “robots” en de tekstextensie “txt”. Alles kan nu worden geüpload naar de hosting, in de hoofdmap van de site. Houd er rekening mee dat u slechts één “robots”-document voor één site kunt maken. Als dit bestand niet op de site staat, ‘beslist’ de bot automatisch dat alles geïndexeerd kan worden.

Omdat er maar één is, bevat deze instructies voor alle zoekmachines. Bovendien kunt u zowel afzonderlijke instructies voor elke PS opschrijven, als een algemene instructie voor allemaal tegelijk. De scheiding van instructies voor verschillende zoekbots gebeurt via de User-agent-richtlijn. Laten we hier hieronder meer over praten.

Robots.txt-richtlijnen

Het bestand “voor robots” kan de volgende richtlijnen bevatten voor het beheren van indexering: User-agent, Disallow, Allow, Sitemap, Host, Crawl-delay, Clean-param. Laten we elke instructie in meer detail bekijken.

User-agent-richtlijn

User-agent-richtlijn— geeft aan voor welke zoekmachine de instructies zijn bedoeld (meer precies, welke specifieke bot). Als er een “*” staat, zijn de instructies bedoeld voor alle robots. Als een specifieke bot is opgegeven, zoals Googlebot, zijn de instructies alleen bedoeld voor de belangrijkste indexeringsrobot van Google. Als er bovendien afzonderlijk instructies zijn voor Googlebot en voor alle andere subsystemen, zal Google alleen zijn eigen instructies lezen en de algemene instructies negeren. De Yandex-bot zal hetzelfde doen. Laten we eens kijken naar een voorbeeld van het schrijven van een richtlijn.

User-agent: YandexBot - alleen instructies voor de belangrijkste Yandex-indexeringsbot

User-agent: Yandex - instructies voor alle Yandex-bots

User-agent: * - instructies voor alle bots

Disallow- en Allow-richtlijnen

Disallow- en Allow-richtlijnen— instructies geven over wat wel en niet moet worden geïndexeerd. Disallow geeft de opdracht om een pagina of een volledig gedeelte van de site niet te indexeren. Integendeel, Allow geeft aan wat geïndexeerd moet worden.

Disallow: / - verbiedt het indexeren van de gehele site

Disallow: /papka/ - verbiedt het indexeren van de volledige inhoud van de map

Disallow: /files.php - verbiedt het indexeren van het bestand files.php

Toestaan: /cgi-bin – staat toe dat cgi-bin-pagina's worden geïndexeerd

Het is mogelijk en vaak eenvoudigweg noodzakelijk om speciale tekens te gebruiken in de Disallow- en Allow-richtlijnen. Ze zijn nodig om reguliere expressies te specificeren.

Speciaal teken * - vervangt elke reeks tekens. Het wordt standaard toegewezen aan het einde van elke regel. Zelfs als je het niet hebt geregistreerd, zal de PS het zelf toewijzen. Gebruiksvoorbeeld:

Disallow: /cgi-bin/*.aspx – verbiedt het indexeren van alle bestanden met de .aspx-extensie

Disallow: /*foto - verbiedt het indexeren van bestanden en mappen die het woord foto bevatten

Het speciale teken $ annuleert het effect van het speciale teken “*” aan het einde van de regel. Bijvoorbeeld:

Disallow: /example$ - verbiedt indexering van '/example', maar verbiedt '/example.html' niet

En als je het schrijft zonder het speciale symbool $, dan werkt de instructie anders:

Disallow: /example - staat zowel '/example' als '/example.html' niet toe

Sitemaprichtlijn

Sitemaprichtlijn— is bedoeld om aan de zoekmachinerobot aan te geven waar de sitemap zich op de hosting bevindt. Het sitemapformaat moet sitemaps.xml zijn. Voor een snellere en completere indexering van de site is een sitemap nodig. Bovendien is een sitemap niet noodzakelijkerwijs één bestand; er kunnen er meerdere zijn. Formaat voor directe berichten:

Sitemap: http://site/sitemaps1.xml

Sitemap: http://site/sitemaps2.xml

Hostrichtlijn

Hostrichtlijn- geeft aan de robot de hoofdspiegel van de site aan. Wat er ook in de index van sitespiegelservers staat, u moet deze richtlijn altijd specificeren. Als u dit niet opgeeft, indexeert de Yandex-robot minimaal twee versies van de site met en zonder www. Totdat de spiegelrobot ze aan elkaar lijmt. Voorbeeld invoer:

Host: www.site

Gastheer: website

In het eerste geval indexeert de robot de versie met www, in het tweede geval zonder. Het is toegestaan om slechts één Host-instructie in het robots.txt-bestand op te geven. Als u er meerdere invoert, zal de bot alleen de eerste verwerken en er rekening mee houden.

Een geldige hostrichtlijn moet de volgende gegevens bevatten:

— geef het verbindingsprotocol aan (HTTP of HTTPS);

— een correct geschreven domeinnaam (u kunt geen IP-adres invoeren);

— poortnummer, indien nodig (bijvoorbeeld Host: site.com:8080).

Richtlijnen die verkeerd zijn opgesteld, worden eenvoudigweg genegeerd.

Crawl-delay-richtlijn

Crawl-delay-richtlijn Hiermee kunt u de belasting van de server verminderen. Het is nodig voor het geval uw site onder de aanval van verschillende bots begint te vallen. De Crawl-delay-richtlijn vertelt de zoekbot de wachttijd tussen het einde van het downloaden van één pagina en het begin van het downloaden van een andere pagina op de site. De richtlijn moet onmiddellijk na de vermeldingen "Disallow" en/of "Allow" komen. De Yandex-zoekrobot kan fractionele waarden lezen. Bijvoorbeeld: 1,5 (anderhalve seconde).

Clean-param-richtlijn

Clean-param-richtlijn nodig voor sites waarvan de pagina's dynamische parameters bevatten. We hebben het over degenen die geen invloed hebben op de inhoud van de pagina's. Dit is verschillende service-informatie: sessie-ID's, gebruikers, verwijzers, enz. Om ervoor te zorgen dat er geen duplicaten van deze pagina's zijn, wordt deze richtlijn gebruikt. Ze zal de PS vertellen de ontvangen informatie niet opnieuw te uploaden. Ook de belasting van de server en de tijd die de robot nodig heeft om de site te crawlen, worden verminderd.

Clean-param: s /forum/showthread.php

Deze invoer vertelt de PS dat de parameter s als onbelangrijk wordt beschouwd voor alle URL's die beginnen met /forum/showthread.php. De maximale invoerlengte is 500 tekens.

We hebben de richtlijnen uitgezocht, laten we verder gaan met het opzetten van ons robotsbestand.

Robots.txt instellen

Laten we direct doorgaan met het instellen van het robots.txt-bestand. Het moet ten minste twee vermeldingen bevatten:

User-agent:— geeft aan voor welke zoekmachine de onderstaande instructies bedoeld zijn.

Niet toestaan:— specificeert welk deel van de site niet mag worden geïndexeerd. Het kan zowel een enkele pagina van een site als hele secties blokkeren voor indexering.

Bovendien kunt u aangeven dat deze richtlijnen voor alle zoekmachines bedoeld zijn, of voor één specifiek. Dit wordt aangegeven in de User-agent-richtlijn. Als je wilt dat alle bots de instructies lezen, plaats dan een asterisk

Als u instructies voor een specifieke robot wilt schrijven, moet u de naam ervan opgeven.

Gebruikersagent: YandexBot

Een vereenvoudigd voorbeeld van een correct samengesteld robotsbestand zou er als volgt uitzien:

User-agent: *

Niet toestaan: /files.php

Niet toestaan: /sectie/

Gastheer: website

Waar, *

geeft aan dat de instructies bedoeld zijn voor alle PS;

Niet toestaan: /files.php– verbiedt indexering van het bestand file.php;

Niet toestaan: /foto/— verbiedt het indexeren van de gehele “foto”-sectie met alle bijgevoegde bestanden;

Gastheer: website— vertelt robots welke spiegel moet worden geïndexeerd.

Als u geen pagina's op uw site heeft die moeten worden afgesloten voor indexering, moet uw robots.txt-bestand er als volgt uitzien:

User-agent: *

Niet toestaan:

Gastheer: website

Robots.txt voor Yandex (Yandex)

Om aan te geven dat deze instructies bedoeld zijn voor de Yandex-zoekmachine, moet u in de User-agent: Yandex-richtlijn opgeven. Als we bovendien “Yandex” invoeren, zullen alle Yandex-robots de site indexeren, en als we “YandexBot” specificeren, dan is dit alleen een commando voor de hoofdindexeringsrobot.

Het is ook noodzakelijk om de “Host” -richtlijn te specificeren, waar de hoofdspiegel van de site moet worden aangegeven. Zoals ik hierboven schreef, wordt dit gedaan om dubbele pagina's te voorkomen. Uw juiste robots.txt voor Yandex zal er als volgt uitzien:

Gebruikersagent: Yandex

Niet toestaan: /cgi-bin

Niet toestaan: /adminka

Gastheer: website

We horen nog steeds vaak vragen over wat je beter kunt aangeven in de hostrichtlijn, een site met of zonder www. Maar er is geen verschil. Het is maar net hoe je wilt dat de site eruitziet in de PS-resultaten. Het belangrijkste is om niet te vergeten het helemaal aan te geven, om geen duplicaten te maken.

Robots.txt voor Google

De Google-zoekmachine ondersteunt alle gangbare robots.txt-bestandsformaten. Het is waar dat er geen rekening wordt gehouden met de Host-richtlijn. Daarom zullen er eigenlijk geen verschillen zijn met Yandex. Robots.txt voor Google ziet er als volgt uit:

User-agent: Googlebot

Niet toestaan: /cgi-bin

Niet toestaan: /adminka

Sitemap: http://site/sitemaps.xml

Ik hoop dat de gegevens die ik heb gepresenteerd voldoende zijn om een kwalitatief hoogstaand en vooral correct bestand te maken. robots.txt. Als je een van de populaire CMS'en gebruikt, dan heb ik in het volgende artikel een selectie robots voor je voorbereid - robots.txt voor populaire CMS'en 1 beoordeling, gemiddeld: 5,00

uit 5)

Snelle navigatie op deze pagina:

De moderne realiteit is dat in Runet geen enkele zichzelf respecterende site zonder een bestand met de naam robots.txt kan - zelfs als je niets te verbieden hebt om te indexeren (hoewel bijna elke site technische pagina's en dubbele inhoud heeft die moet worden afgesloten voor indexering) , dan is het op zijn minst zeker de moeite waard om een richtlijn met www en zonder www voor Yandex te registreren - dit is waar de regels voor het schrijven van robots.txt voor zijn, die hieronder zullen worden besproken.

Wat is robots.txt?

Een bestand met deze naam dateert uit 1994, toen het W3C-consortium besloot een dergelijke standaard in te voeren, zodat sites zoekmachines konden voorzien van indexeringsinstructies.

Een bestand met deze naam moet worden opgeslagen in de hoofdmap van de site; het plaatsen ervan in andere mappen is niet toegestaan.

Het bestand voert de volgende functies uit:

- verbiedt het indexeren van pagina's of groepen pagina's

- Hiermee kunnen alle pagina's of groepen pagina's worden geïndexeerd

- geeft aan de Yandex-robot aan welke sitespiegel de belangrijkste is (met www of zonder www)

- toont de locatie van het sitemapbestand

Alle vier de punten zijn uiterst belangrijk voor de zoekmachineoptimalisatie van websites. Door indexering te verbieden, kunt u voorkomen dat pagina's worden geïndexeerd die dubbele inhoud bevatten, bijvoorbeeld tagpagina's, archieven, zoekresultaten, pagina's met afdrukbare versies, enzovoort. De aanwezigheid van dubbele inhoud (wanneer dezelfde tekst, zelfs in de grootte van meerdere zinnen, op twee of meer pagina's aanwezig is) is een minpunt voor de site in de rankings van zoekmachines, daarom moeten er zo min mogelijk duplicaten zijn.

De allow-richtlijn heeft geen zelfstandige betekenis, omdat standaard alle pagina's al beschikbaar zijn voor indexering. Het werkt in combinatie met disallow - wanneer bijvoorbeeld een bepaalde categorie volledig is afgesloten voor zoekmachines, maar u deze of een aparte pagina daarin wilt openen.

Het verwijzen naar de hoofdspiegel van de site is ook een van de belangrijkste elementen bij optimalisatie: zoekmachines beschouwen de sites www.yoursite.ru en yoursite.ru als twee verschillende bronnen, tenzij u hen rechtstreeks anders vertelt. Het resultaat is een verdubbeling van de inhoud - het verschijnen van duplicaten, een afname van de sterkte van externe links (externe links kunnen zowel met www als zonder www worden geplaatst) en als gevolg daarvan kan dit leiden tot een lagere ranking in de zoekresultaten.

Voor Google is de hoofdspiegel geregistreerd in de Webmastertools (http://www.google.ru/webmasters/), maar voor Yandex kunnen deze instructies alleen in dezelfde robots.tkht worden geregistreerd.

Door naar een XML-bestand met een sitemap te verwijzen (bijvoorbeeld sitemap.xml), kunnen zoekmachines dit bestand detecteren.

Regels voor het opgeven van User-agent

De user-agent is in dit geval de zoekmachine. Bij het schrijven van instructies moet u aangeven of deze van toepassing zijn op alle zoekmachines (in dat geval wordt een asterisk aangegeven - *) of dat ze bedoeld zijn voor een specifieke zoekmachine - bijvoorbeeld Yandex of Google.

Om een User-agent in te stellen die alle robots aangeeft, schrijft u de volgende regel in uw bestand:

User-agent: *

Voor Yandex:

Gebruikersagent: Yandex

Voor Google:

User-agent: GoogleBot

Regels voor het opgeven van niet toestaan en toestaan

Ten eerste moet worden opgemerkt dat het robots.txt-bestand ten minste één disallow-instructie moet bevatten om geldig te zijn. Laten we nu eens kijken naar de toepassing van deze richtlijnen aan de hand van specifieke voorbeelden.

Met deze code staat u indexering van alle pagina's van de site toe:

User-agent: * Niet toestaan:

En met deze code worden daarentegen alle pagina's gesloten:

User-agent: * Niet toestaan: /

Om het indexeren van een specifieke map met de naam map te verbieden, geeft u het volgende op:

User-agent: * Niet toestaan: /map

U kunt ook sterretjes gebruiken om een willekeurige naam te vervangen:

User-agent: * Niet toestaan: *.php

Belangrijk: het sterretje vervangt de volledige bestandsnaam, dat wil zeggen dat u bestand*.php niet kunt opgeven, alleen *.php (maar alle pagina's met de .php-extensie zijn verboden; om dit te voorkomen kunt u een specifiek pagina-adres opgeven) .

De allow-richtlijn, zoals hierboven vermeld, wordt gebruikt om uitzonderingen te maken in disallow (anders heeft het geen betekenis, omdat pagina's standaard al geopend zijn).

We zullen bijvoorbeeld voorkomen dat pagina's in de archiefmap worden geïndexeerd, maar we laten de index.html-pagina uit deze map open:

Toestaan: /archive/index.html Niet toestaan: /archive/

Geef de host en sitemap op

De host is de hoofdspiegel van de site (dat wil zeggen de domeinnaam plus www of de domeinnaam zonder dit voorvoegsel). De host is alleen gespecificeerd voor de Yandex-robot (in dit geval moet er minstens één niet-toestaan-commando zijn).

Om een host te specificeren, moet robots.txt de volgende vermelding bevatten:

User-agent: Yandex Disallow: Host: www.uwsite.ru

Wat de sitemap betreft: in robots.txt wordt de sitemap aangegeven door simpelweg het volledige pad naar het overeenkomstige bestand te schrijven, met vermelding van de domeinnaam:

Sitemap: http://uwsite.ru/sitemap.xml

Er is geschreven over het maken van een sitemap voor WordPress.

Voorbeeld robots.txt voor WordPress

Voor WordPress moeten de instructies zo worden gespecificeerd dat alle technische mappen (wp-admin, wp-includes, enz.) worden gesloten voor indexering, evenals dubbele pagina's die zijn gemaakt door tags, RSS-bestanden, opmerkingen en zoeken.

Als voorbeeld van robots.txt voor wordpress kunt u het bestand van onze website halen:

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /search Disallow: */trackback Disallow: */feed/ Niet toestaan: */feed Niet toestaan: */comments/ Niet toestaan: /?feed= Niet toestaan: /?s= Niet toestaan: */page/* Niet toestaan: */commentaar Niet toestaan: */tag/* Niet toestaan: */ bijlage/* Toestaan: /wp-content/uploads/ Host: www..php Niet toestaan: /wp-register.php Niet toestaan: /xmlrpc.php Niet toestaan: /search Niet toestaan: */trackback Niet toestaan: */feed/ Niet toestaan: * /feed Niet toestaan: */comments/ Niet toestaan: /?feed= Niet toestaan: /?s= Niet toestaan: */page/* Niet toestaan: */comment Niet toestaan: */tag/* Niet toestaan: */attachment/* Toestaan: /wp -content/uploads/ User-agent: * Niet toestaan: /wp-admin Niet toestaan: /wp-includes Niet toestaan: /wp-login.php Niet toestaan: /wp-register.php Niet toestaan: /xmlrpc.php Niet toestaan: /search Niet toestaan: */trackback Niet toestaan: */feed/ Niet toestaan: */feed Niet toestaan: */comments/ Niet toestaan: /?feed= Niet toestaan: /?s= Niet toestaan: */page/* Niet toestaan: */commentaar Niet toestaan: */tag/ * Niet toestaan: */attachment/* Toestaan: /wp-content/uploads/ Sitemap: https://www..xml

U kunt het robots.txt-bestand van onze website downloaden met behulp van .

Mocht je na het lezen van dit artikel nog vragen hebben, stel ze dan in de reacties!