Наличие внутренних дублей страниц может привести к ошибкам индексации сайта и даже свести на нет результаты продвижения. К примеру, если у продвигаемой страницы есть дубли, после очередного апдейта один из них может заменить в выдаче нужную страницу. А это обычно сопровождается существенным проседанием позиций, так как у дубля, в отличие от продвигаемой страницы, нет ссылочной массы.

Откуда берутся дубли страниц?

Как я только что упоминала, дубли бывают четкие и нечеткие.

Четкие дубли – это страницы с абсолютно одинаковым контентом, которые имеют разные URL-адреса.

Например, страница для печати и ее обычный оригинал, страницы с идентификаторами сессий, одни и те же страницы с разными расширениями (.html, .php, .htm). Большинство четких дублей генерируются движком сайта, но есть и такие, которые возникают из-за невнимательности вебмастера.

К примеру, разные URL для главной страницы – у одного нашего клиента до недавнего времени «морда» совершенно статичного сайта (без движка) была доступна по трем разным URL-адресам: site.ru/, site.ru/index.html и site.ru/default.html. Очень часто четкие дубли появляются после замены дизайна и структуры сайта – все страницы получают новые URL-адреса, но старые адреса тоже работают, и в результате каждая страница доступна по 2 разным URL.

Нечеткие дубли – это страницы с очень похожим контентом:

– где контентная часть по объему намного меньше сквозной части

: страницы галерей (где само содержание страницы состоит из одной лишь картинки, а остальное – сквозные блоки), страницы товарных позиций с описанием товара всего одним предложением и т.д..

– страницы, на которых частично (или полностью, но в разном порядке) повторяется одно и то же содержание

. Например, страницы категорий товаров в интернет-магазинах, на которых одни и те же товары отсортированы по разным показателям (по цене, по новизне, по рейтингу и т.д.) или страницы рубрик, где пересекаются одни и те же товары с одними и теми же описаниями. А также страницы поиска по сайту, страницы с анонсами новостей (если один и тот же анонс используется на нескольких страницах) и т.д.

Как определить, есть ли на сайте дубли?

Определить наличие внутренних дублей на сайте можно с помощью поиска Яндекса. Для этого в поисковой строке в расширенном поиске нужно ввести кусок текста страницы, подозреваемой в дублях (текст нужно вводить в кавычках), указав в строке «на сайте» свой домен. Все найденные страницы могут быть четкими или нечеткими дублями друг друга:

Определить дубли можно и с помощью поиска Google. Для этого нужно в поисковую строку ввести кусок текста проверяемой страницы в кавычках и через пробел указать область поиска – site:examplesite.ru. Пример запроса на проверку дублей:

“Длинное предложиение из десяти-пятнадцати слов со страницы, которую мы подозреваем в том, что у нее есть дубли и хотим подтвердить или опровергнуть это” site:examplesite.ru

Если дубли найдутся, это будет выглядеть так:

Как избавиться от дублей страниц?

Оптимальный способ избавления от дублей зависит от того, каким образом дубль появился на сайте и есть ли необходимость оставлять его в индексе (например, если это страница товарной категории или галереи).

Директива Disallow в Robots.txt

Директива “Disallow”

используется для запрещения индексации страниц поисковыми роботами и для удаления из базы уже проиндексированных страниц. Это оптимальный вариант борьбы с дублями в случаях, если дублированные страницы находятся сугубо в конкретных директориях или если структура URL позволяет закрыть много дублей одним правилом.

Например, если нужно закрыть все страницы с результатами поиска по сайту, которые находятся в папке www.examplesite.ru/search/, достаточно в Robots.txt прописать правило:

Другой пример. Если знак «?» является идентификатором сеанса, можно запретить индексацию всех страниц, содержащих этот знак, одним правилом:

Таким образом можно запрещать к индексации четкие дубли: страницы для печати, страницы идентификаторов сессий и т.д., страницы поиска по сайту и т.д.

Описание директивы «Disallow» в разделе помощи Яндекса

Описание правил блокировки и удаления страниц в справке Google

Тег rel=canonical

Тег rel=canonical

используется для того, чтоб указать роботам, какая именно страница из группы дублей должна участвовать в поиске. Такая страница называется канонической

.

Для того, чтоб указать роботам каноническую страницу, необходимо на неосновных страницах прописать ее URL:

Такой способ избавления от дублей отлично подходит в том случае, если дублей достаточно много, но закрыть их единым правилом в Robots.txt невозможно из-за особенностей URL .

301 редирект

301 Permanent Redirect используется для переадресации пользователей и поисковых ботов с одной страницы на другую. Использовать этот способ нужно в случае, если некоторые страницы в результате смены движка или структуры сайта поменяли URL, и одна и та же страница доступна и по старому, и по новому URL. 301 редирект дает сигнал поисковым ботам, что страница навсегда сменила адрес на новый, в результате чего вес cтарой страницы передается новой (в большинстве случаев).

Настроить редирект с одной страницы на другую можно, прописав в файле.htaccess такое правило:

Redirect 301 /category/old-page.html http://www.melodina.ru/category/new-page.html

Можно настроить и массовый редирект со страниц одного типа на другой, но для этого нужно, чтоб у них была одинаковая структура URL.

О том, как сделать 301 редирект на блоге Devaka.ru .

Творческий подход

Бывают случаи, когда страницы, имеющие признаки нечетких дублей, действительно содержат полезную информацию, и удалять их из индекса не хотелось бы. Что делать в таком случае? Менять, добавлять или уникализировать контент.

Например, если проблема с нечеткими дублями возникла из-за слишком объемной навигации

, нужно искать способы увеличить контентную часть или .

Часто бывает, что страницы с описаниями товаров одной и той же категории очень похожи друг на друга . Уникализировать такой текст не всегда возможно, а закрывать к индексации нецелесообразно (это уменьшает контентную часть). В этом случае можно посоветовать добавлять на страницы какие-то интересные блоки: отзывы о товаре, список отличий от других товаров и т.д.

В случае, если в разных рубриках выводится много одних и тех же товаров с одинаковыми описаниями, тоже можно применить творческий подход

. Допустим, есть интернет-магазин сумок, где одни и те же товары выводятся сразу в нескольких категориях. Например, женская кожаная сумка с ручкой от Chanel может выводиться сразу в 4-х категориях женские сумки, кожаные сумки, сумки с ручкой и сумки Chanel. В этом нет ничего плохого, так как сумка действительно подходит для всех 4-х категорий, но если анонс с описанием сумки выводится во всех этих категориях, это может навредить (особенно если пересекающихся товаров много). Выход – либо не выводить анонсы на страницах рубрик вообще, либо сокращать их до минимум и автоматически менять описания в зависимости от категорий, на которых выводится товар.

Пример: Стильная [женская] [кожаная] cумка черного цвета [с ручкой] на каждый день.

Я встречала много разных вариантов внутренних дублей на сайтах разной сложности, но не было такой проблемы, которую нельзя было бы решить . Главное, не откладывать вопрос с дублями до тех пор, когда нужные страницы начнут выпадать из индекса и сайт станет терять трафик.

Мы разговаривали про дубли страниц сайта replytocom. Напомню суть прошлой статьи. Она в том, то не следует делать закрытым в Роботсе путь чему-либо на вашем блоге. Желательно наоборот, роботс сделать открытым, чтобы робот зашел, посмотрел, увидел тег и не стал индексировать дубли страниц.

Если же данные копии страниц будут закрыты, данный робот скорее всего подобные дубли наоборот проиндексирует. Желательно это запомнить! Далее давайте вспомним, как мы искали копии реплитоком в поисковике Гугл. Я напомню:

site:ваш сайт replytocom , т.е. на примере моего это будет выглядеть site:сайт replytocom

Как искать дубли страниц на вашем блоге

Отлично. Сейчас мы поищем прочие копии страничек, а подробнее копии: feed, category, tag, comment-page, page, trackback, attachment_id, attachment

Их поиск проводим похожим образом, как мы искали дубли страниц реплитоком. Делаем все подобным образом, а именно зайдем в и внесем в поисковик любой блог, например site:realnodengi.ru feed

Нажав «Показ скрытых результатов» мы увидим:

22 дубля страницы. Что значит feed? Это непонятный отросток в конце адреса статьи. Для любого вашего поста жмете ctr + u и скорее всего увидите ссылочку feed в конце. Другими словами, подобные ссылки необходимо удалять. Давайте войдем в роботс данного сайта, мы увидим:

То есть то, что нам не нужно . Что же нам делать, подобные запрещения в роботсе желательно удалить. Что бы робот на них не заходил и не индексировал их на «всякий случай».

Отлично! Мы сделали проверку страничек feed.

Возьмём другой сайт, например reall-rabota.ru и вставим page. У нас получится site:reall-rabota.ru page:

Мы видим, что на данном сайте присутствует 61 дубль страниц page. От них необходимо избавляться. Я надеюсь, авторы данных блогов за анализ на меня не в обиде?

Подобный анализ проведите для своих блогов, и не только по данным копиям, но и по прочим, которые я приводил выше, таким как — category, tag и пр.

Ну как? Ваш результат вас порадовал?

Скорее всего не по всем данным словам вы найдете копии. Это конечно отлично! Но от тех, которые у вас имеются, придется избавиться! Давайте подумаем как?

Как убрать дубли страниц сайта решение проблемы

Во-первых , зайдите в мой роботс и скопируйте его себе, соответственно заменив сайт на название вашего сайта. Заменили? Отлично! Я думаю на многих блогах присутствовали запреты, как на сайте, приведенном выше.

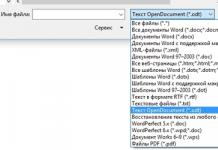

Во вторых , перепишите следующие строки в ваш файлик.htaccess:

Данный файл находится в вашей корневой папке, которая чаще всего называется public_html. Для этого я обычно открываю программу , переношу нужный файл на рабочий стол, открываю данный файлик софтом Notepad + +, вношу необходимые изменения и заменяю старый файл на новый.

Данный файл находится в вашей корневой папке, которая чаще всего называется public_html. Для этого я обычно открываю программу , переношу нужный файл на рабочий стол, открываю данный файлик софтом Notepad + +, вношу необходимые изменения и заменяю старый файл на новый.

После закачки нового файла ваш.htaccess должен получиться примерно таким:

В третьих , вставляем в function.php после /*** ДОБАВЛЯЕМ meta robots noindex,nofollow ДЛЯ СТРАНИЦ ***/ function my_meta_noindex () { if (is_paged() // Все и любые страницы пагинации) {echo "".""."\n";} } add_action("wp_head", "my_meta_noindex", 3); // добавляем свой noindex, nofollow в head

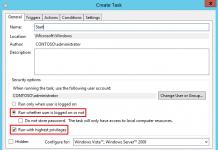

В четвертых , проходим в расширение All in One Seo Pack и делаем так:

Если у вас другой плагин, например SEO, поставьте noindex в разделах, похожих по смыслу.

В пятых , в «Параметрах» идем в «Настройки-Обсуждения» и удаляем галку с пунктика Разбития комментариев:

В заключение предлагаю подробное видео про дубли.

На этом не всё, существует ещё множество дублей страниц и прочего хлама. Его необходимо удалять. Самому это не всегда сделать просто, поэтому иногда необходимо обращаться к профессионалу. Но его не всегда найдешь, да и не станешь постоянно обращаться.

Отсюда, желательно все тонкости узнать самому. Это можно сделать как при лично общении, так и изучив материал. Я имею в виду видеокурс. На мой взгляд, видеокурс предпочтительнее, т.к. вы пройдете обучение дама перед своим монитором!

Я не просто так привел данный курс, я его изучил. Мне лично он понравился. Раньше, Яндекс показывал у меня проиндексированных страниц 1220, хотя реально их 250. Сейчас, после очистки, Яндекс показывает 490, Гугл 530. Согласитесь, данные цифры ближе к реальным!

Но, как это не покажется странным, на большом количестве сайтов данные цифры зашкаливают за 200000 дублей и более. Без всяких шуток! Сайты с подобными показателями в скором времени могут быть забанены поисковиком. Но давайте вернемся к курсу. Приведу слова Александра:

Подробнее обо всём этом на сайте Борисова, для этого просто кликните по картинке с курсом.

В основном работа проделана, дубли страниц будут удалены после индексации, но не сразу, вам придется подождать несколько месяцев! Успехов в продвижении вашего ресурса! Если вам известны другие способы, как убрать дубли страниц сайта, пишите в комментариях, изучим вместе!

Анекдот в каждой статье.

Добрый день, друзья! Уже очень давно меня просили читатели блога сделать пост о том, как избавиться от replytocom. Тема эта актуальна, так как из-за этого в индексе получается огромное число похожих страничек с параметрами коммента. Все дело в том, что многие блоги созданы на CMS WordPress, который грешит дубликацией комментариев. Поэтому я решил дать всю информацию не только о replytocom. В статье я раскрываю понятие дублированного контента, даю методику поиска дублей страниц сайта и поясняю, почему от них нужно избавляться. А в следующем посте я покажу, как нужно их удалять.

Дублированный контент на сайте

Дубли бывают разными — тихими и заразными. 🙂 Если серьезно, то дублированная страница — это документ сайта, который может иметь полностью или частично одинаковый контент. Разумеется, каждый дубль имеет свой адрес (url страницы). Четкий дубль страницы может возникнуть по следующим причинам:

- искусственно создаются владельцем сайта для специальных нужд. Например, страницы для печати, которые позволяют пользователю коммерческого сайта скопировать информацию по выбранному товару / услуге.

- генерируются движком ресурса, так как это у них заложено в теле. Некоторые современные CMS выдают похожие страницы с другими урлами, размещенные по своим разным дерикториям.

- появляются за счет ошибок веб-мастера, который управляет сайтом. Например, ресурс обзаводиться двумя одинаковыми главными страницами с разными адресами (например, site.ru и site.ru/index.php).

- возникают по случаю изменения структуры сайта. Например, при создании нового шаблона с другой системой урлов, новые страницы со старым контентом получают совершенно другие адреса.

Нечеткий дубль получают страницы, которые частично дублируют контент. Такие страницы имеют общую часть шаблона сайта, но отличаются небольшим контентным наполнением. Например, такими небольшими дублями могут быть страницы ресурса, имеющие результаты поиска или отдельные элементы статьи (например, картинки — такое очень часто бывает во многих шаблонах блогов).

На следующем рисунке я собрал самые частые варианты дублей страниц, которые присущие блогу с движком Вордпресс (без учета различных плагинов и фишек шаблона, которые также частенько создают дублированные документы):

Наличие дублей страниц на сайте может говорить о том, что или веб-мастер не знает об их присутствии, или он просто не умеет с ними бороться. А бороться с ними нужно, так как они приводят к различным ошибкам и проблемам в плане поискового продвижения. Об этом сейчас и поговорим.

Почему нужно удалять дубли страниц

Но какими бы не были пассивными дубли страниц, они могут подложить конкретную свинью владельцу любого сайта или блога. Итак, чем же так опасен дублированный контент? Вот основные проблемы, которые возникают при наличии дублей:

Ухудшение индексации сайта . Я называю это проблемой №1. Дело в том, что в зависимости от источника и ошибок веб-мастера, страница сайта может иметь от одного до нескольких или больше дублей. Например, главная может грешить двумя-тремя дупликатами, а посты блогов из-за вездесущего replytocom скопируются по количеству комментариев. И если блог популярный, то и число «левых» страниц будет огромным. А поисковые системы (особенно Google) не любят дубли и поэтому частенько занижают позиции самого сайта.

Замена релевантной страницы. Алгоритм поисковой системы может посчитать дубль более релевантным, чем продвигаемая страница-оригинал (). Тем самым в выдаче будет находиться не целевая страница, а ее клон. Но у этого клона совсем другие незначительные параметры (ссылочный вес, ), которые со временем пессимизируют сайт в серпе поисковой системы.

Итак, подытожим вышесказанное. Дубли страниц создают помеху в нормальной индексации сайта, становятся источником неправильного выбора поисковиком релевантной страницы, забирают влияние естественных внешних ссылок. Также дубли неправильно распределяют внутренний ссылочный вес, отбирая силу у продвигаемых страниц и меняя поведенческие показатели:

В общем, дубли — это большое зло в поисковом продвижении и страшный сон оптимизатора. 🙂

Как определить и проверить дубли страниц

Есть разные способы поиска и проверки дублей страниц. Они требуют разного уровня знаний CMS и понимание работы поискового индекса. Я покажу самый простой из способов. Это не значит, что если он простой, то не точный. С его помощью легко находятся дубликаты документов сайта. И самое главное — этот способ не требует особых знаний и не займет много времени.

Для того, чтобы найти и проверить свой сайт на наличие дубликатов страниц, нужно или воспользоваться расширенным поиском Яндекса (Гугла) или сразу ввести в поисковую строку специальный запрос. Сначала рассмотрим первый вариант.

Проверка сайта на дубли с помощью расширенного поиска

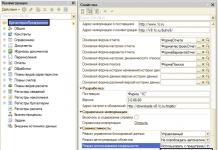

Расширенный поиск Яндекса позволяет получить более точную выдачу благодаря уточняющим параметрам запроса. В нашем случае нам нужно только два параметра — адрес сайта и кусочек текста той страницы, по которой мы ищем дубли. Сначала мы выделяем текст, который находится на той странице нашего сайта (для примера взят абсолютно чужой ресурс), которую будем проверять на дубли. Затем идет в расширенный поиск Яндекса и вносим в соответствующие позиции кусочек контента и адрес сайта:

Далее мы нажимаем заветное слово «Найти» и русский поисковик начинает формировать выдачу. Она получится не той, которую мы обычно наблюдаем — она будет состоять полностью из заголовков и сниппетов только нашего ресурса. Причем, если в выдаче будет только один результат поиска, то все хорошо — дублированного контента этой страницы нет. Если же есть в полученном серпе несколько результатов, то придется доставать лопату:

В моем примере поисковик нашел несколько нечетких дублей — ряд страниц из пагинации по некоторым рубрикам. Сразу видно, что на данном сайте страница с выделенным текстом про рецепт салата явно размещалась сразу в разных рубриках. А так как запрет на индексацию страниц пагинации для этого ресурса не ставился, в индексе повылазили всевозможные дубли.

Теперь рассмотрим те же действия для зарубежного поисковика. Заходим на страницу расширенного поиска Google и совершаем те же самые действия:

Заполнив все необходимое на расширенном поиске, получаем индексацию исследуемого сайта согласно указанному куску текста:

Как видим, Гугл также проиндексировал неточные дубли исследуемой страницы — в выдаче все те же страницы рубрик.

В принципе получить те же самые результаты можно и не используя расширенный поиск. Для этого нужно в простом варианте Гугла или Яндекса прописать следующий запрос. И в этом заключается второй способ определения дублей.

Поиск дублей страниц с помощью специального запроса

С помощью расширенного поиска легко находятся все дубликаты по заданному тексту. Конечно, с помощью данного способа мы не получим дубли страниц, которые не содержат текст. Например, если дубль создается «кривым» шаблоном, который зачем-то показывает на другой странице картинку, которая находится на странице-оригинале. То такой дубликат выше описанным способом найти не получиться. В таком случае придется использовать другой способ.

Его суть проста — с помощью специального оператора мы запрашиваем индексацию всего нашего сайта (или отдельной страницы) и уже вручную смотрим выдачу в поисках дубликаторов. Вот правила синтаксиса этого запроса:

Когда мы в запросе указываем адрес главной страницы,то получаем просто список проиндексированных страниц поисковым роботом. Если же мы указывает адрес конкретной страницы, то получаем список проиндексированных дублей этой страницы. В Яндексе они сразу видны. А вот в Гугле все немного сложнее — сначала нам покажут те страницы, которые есть в основной выдаче:

Как видно на картинке, в основной выдаче у нас находится одна страница сайта и она же является оригиналом. Но в индексе есть и другие страницы, которые являются дублями. Чтобы их увидеть, нужно нажать на ссылку «Показать скрытые результаты»:

В итоге нам выдается список дублей, которые Гугл проиндексировал и связал со страницей-оригиналом (цифра 1 на картинке). В моем примере такими дублями стали страницы с позициями 2 и 3.

На второй позиции находится дубль, который является трекбэком данного документа ( автоматическое уведомление для других сайтов данной публикации). Вещь конечно нужная, но ее присутствие в индексе не желательно. Хозяин данного сайта это прекрасно понимает и поэтому прописал запрет на индексацию трэкбеков с сайта. Об этом говорит надпись «Описание веб-страницы недоступно из-за ограничений в файле robots.txt». Если посмотреть инструкцию для поисковых систем (robots.txt), то увидим следующую картину:

Благодаря последним директивам, автор сайта указал на запрет индексации трэкбеков. Но к сожалению, Гугл заносит в свой индекс все, что ему попадется под руку. И здесь уже нужно просто удалять дубли из базы данных. об этом поговорим уже во второй статье, посвященной дублированному контенту.

На третьей позиции показан горячо любимый многими блоггерами replytocom. Он получается путем использования комментирования на блогах и сайтах. И благодаря ему возникает просто огромная куча дублей — обычно это количество примерно равно число комментов на ресурсе. В нашем примере этот атрибут, как и трэкбек закрыты для индексации. Но Гугл и его схавал в свой индекс. Тоже нужно чистить вручную.

Кстати, если мы немного изменим наш запрос, то можем получить те же результаты, что дает расширенный поиск дублей по кусочку текста:

Итак, друзья, в этой статье я приоткрыл занавес над понятием дублей страниц и их успешным поиском и проверкой. В качестве закрепления пройденного материала предлагаю посмотреть мой видеоролик на эту тему. В нем я наглядно показал не только сегодняшний материал в двух частях, но и добавил другие примеры дублированного контента:

В следующей статье Вы узнаете, . До встречи!

С уважением, Ваш Максим Довженко

— , который работает над продвижением сайта. Он может создать две одинаковые главные страницы, которые отличаются адресами.

Алгоритмы поисковых систем работают автоматически, и нередко бывает так, что дубль воспринимается системой более релевантным, чем страница-оригинал. В результате выдача будет выдавать не оригинал, а его дубль. В свою очередь, дубль обладает другими параметрами, что позже скажется на пессимизации сайта.

Существуют различные способы поиска и проверки дублированных страниц. От исполнителя они требуют разной степени знаний CMS, а также понимания того, каким образом работает поисковый индекс. Попробуем показать Вам наипростейший способ для проверки сайта на дубли страниц. Сразу отметим, что данный способ является не очень то и точным. Но, в тоже время подобный способ позволяет совершать поиск дублей страниц сайта, и не занимает много времени.

Теперь давайте посмотрим, как сделать то же самое только в системе Google. В принципе, процедура ничем не отличается, потребуется совершить такие же действия, как и в Яндексе.

Поисковая система Яндекс сразу же предоставляет список дублей, а вот в Гугле, чтобы увидеть дубли, необходимо будет дополнительно нажать «Показать скрытые результаты», поскольку зачастую на экран выводится оригинал страницы.

С картинки видно что, в основной выдаче находится 1 страница сайта, и она же и является оригиналом. Но в индексе существуют другие страницы, являющиеся дублями. Чтобы их увидеть, нужно нажать на ссылку “Показать скрытые результаты”. В результате мы получаем список, где под номером 1 находится оригинал, а дальше уже размещены дубликаторы. Частенько дубли придется чистить вручную.

Как проверить сайт на дубли страниц

В ниже приведенной статье мы сегодня попытаемся рассмотреть много вопросов, касающихся проблемы дублирования страниц, что становится причиной возникновения дублей, как от этого избавиться, и вообще, почему нужно избавляться от дубликатов.

Для начала давайте разберемся, что кроется под понятием «дублирование контента». Нередко случается, что некоторые страницы могут содержать частично или в полной мере одинаковый контент. Понятно, что каждая отдельная страница имеет свой собственный адрес.

Причины возникновения дублей:

— владельцы сайта сами создают дубли для определенных целей. Допустим, это может быть страница для печати, которая позволяет посетителю коммерческого сайта скопировать необходимую информацию по определенному товару или услуге.

— они генерируются движком интернет-ресурса, поскольку это заложено в их теле. Определенное количество современных СMS могут выдавать похожие страницы с различными URL, которые размещены на разных директориях.

— ошибки вебмастера, который работает над продвижением сайта. Он может создать две одинаковые главные страницы, которые отличаются адресами.

— изменение структуры сайта. При создании нового шаблона с иной системой URL, новые страницы, вмещающие старый контент, получают другие адреса.

Мы перечислили возможные причины возникновения четких дублей, но существуют еще и нечеткие, то есть частичные. Зачастую подобные страницы имеют схожую часть шаблона ресурса, но контент их немного отличается. Подобными дублями могут быть страницы сайта, которые имеют одинаковый результат поиска или же отдельный элемент статьи. Чаще всего, такими элементами становятся картинки.

От дублированных страниц необходимо избавляться. Нет, это не вирус, но он также со временем разрастается, правда, это зависит не от самого ресурса. Дубли зачастую становятся последствием непрофессионального вебмастера, или же результатом неправильного кода сайта.

Важно знать, что дубли могут нанести ресурсу немалый ущерб. К каким же последствиям может привести наличие дублей на сайте? Во-первых, это ухудшение индексации ресурса. Согласитесь, что подобная ситуация не очень то обрадует владельца сайта. В то время как на продвижение ресурса постоянно тратятся финансы и время, ресурс начинает терять свою популярность за несколько дней. Глубина проблемы будет зависеть от количества дублей.

Бывает так, что главная страница может иметь пару-тройку дубликатов. С блогам дело обстоит несколько по-другому. Благодаря replytocom может быть огромное количество дублей из-за копирования комментариев. Получается, что чем популярнее блог, тем больше дубликатов он будет содержать. В свою очередь, системы поиска, в особенности Google, из-за наличия таких вот дублей занижает позиции ресурса.

Алгоритмы поисковых систем работают автоматически, и нередко бывает так, что дубль воспринимается системой более релевантным, чем страница-оригинал. В результате выдача будет выдавать не оригинал, а его дубль. В свою очередь, дубль обладает другими параметрами, что позже скажется на пессимизации сайта.

Что же у нас получается? Дублированные страницы становятся реальной помехой в индексации сайта, а также причиной неверного выбора поисковой системы релевантной страницы, снижают влияние естественных ссылок. Помимо этого, дубли неправильно распределяют внутренний вес, снижая силу продвигаемых страниц, а также меняя поведенческие показатели.

Как проверить сайт на дубли страниц?

Существуют различные способы поиска и проверки дублировааных страниц. От исполнителя они требуют разной степени знаний CMS, а также понимания того, каким образом работает поисковый индекс. Попробуем показать Вам наипростейший способ для проверки сайта на дубли страниц. Сразу отметим, что данный способ является не очень то и точным. Но, в тоже время подобный способ позволяет совершать поиск дублей страниц сайта, и не занимает много времени.

Для поиска и проверки собственного ресурса на наличие дубликатов, следует просто ввести в расширенный поиск поисковой системы специальный запрос. Если Вы используете расширенную версию поиска в Яндекс, можно получить довольно подробные результаты благодаря тому, что здесь имеется возможность вводить уточняющие параметры для запроса.

Нам понадобится адрес ресурса и та часть текста, дубликат которого мы хотим найти. Для этого нам потребуется на своей странице выделить фрагмент текста, после чего в расширенном поиске системы Яндекс ввести скопированный текст и адрес сайта. Теперь необходимо нажать кнопку «Найти», после чего система начнет поиск.

Результаты будут выведены не в обычном режиме. Список сайтов будет содержать только заголовки и сннипеты нашего ресурса. В том случае, когда система выдает единственный результат, это значит, что дубликатов данной страницы нет. А вот при выдаче нескольких результатов придется поработать.

Теперь давайте посмотрим, как сделать то же самое только в системе Google. В принципе, процедура ничем не отличается, потребуется совершить такие же действия, как и в Яндексе.

Расширенный поиск позволяет легко находить все дубликаты по определенному фрагменту текста. Безусловно, что таким способом мы не получим дублей страниц, которые не содержат указанного текста. Нужно сказать что, если дубль был создан искривленным шаблоном, то он только показывает, например, картинку из оригинала на другой странице. Разумеется, что если текста дубликат не содержит, то выше описанным способом его определить не удастся. Для этого необходим другой способ.

Второй способ также отличается своей простотой. Надо воспользоваться специальным оператором и запросить индексацию своего сайта, или же его отдельных страниц. После этого придется вручную смотреть выдачу в поиске дублей.

Правила синтаксиса необходимого запроса:

В той ситуации, когда в поиск вводится просто адрес главной страницы, нам показан список проиндексированных страниц с помощью поискового робота. А вот, если укажем адрес конкретной страницы, то система выводит уже проиндексированные дубли данной страницы.

Поисковая система Яндекс сразу же предоставляет список дублей, а вот в Гугле, чтобы увидеть дубли, необходимо будет дополнительно нажать «Показать скрытые результаты», поскольку зачастую на экран выводится оригинал страницы.

Как видно на картинке, в основной выдаче у нас находится одна страница сайта и она же является оригиналом. Но в индексе есть и другие страницы, которые являются дублями. Чтобы их увидеть, нужно нажать на ссылку “Показать скрытые результаты”. В результате мы получаем список, где под номером 1 находится оригинал, а дальше уже размещены дубликаторы. Частенько дубли придется чистить вручную.

Поисковые алгоритмы постоянно развиваются, часто уже сами могут определить дубли страницы и не включать такие документы в основной поиск. Тем не менее, проводя экспертизы сайтов, мы постоянно сталкиваемся с тем, что в определении дублей алгоритмы еще далеки от совершенства.

Что такое дубли страниц?

Дубли страниц на сайте – это страницы, контент которых полностью или частично совпадает с контентом другой, уже существующей в сети страницы.

Адреса таких страниц могут быть почти идентичными.

Дубли:

- с доменом, начинающимся на www и без www, например, www.site.ru и site.ru.

- со слешем в конце, например, site.ru/seo/ и site.ru/seo

- с.php или.html в конце, site.ru/seo.html и site.ru/seo.php

Одна и та же страница, имеющая несколько адресов с указанными отличиями восприниматься как несколько разных страниц – дублей по отношению друг к другу.

Какими бывают дубликаты?

Перед тем, как начать процесс поиска дублей страниц сайта, нужно определиться с тем, что они бывают 2-х типов, а значит, процесс поиска и борьбы с ними будет несколько отличным. Так, в частности, выделяют:

- Полные дубли - когда одна и та же страница размещена по 2-м и более адресам.

- Частичные дубли - когда определенная часть контента дублируется на ряде страниц, но они уже не являются полными копиями.

Причины возникновения дублей

Сначала вам нужно разобраться, почему на вашем сайте появляются дубли. Это можно понять по урлу, в принципе.

- Дубли могут создавать ID-сессии. Они используются для контроля за действиями пользователя или анализа информации о вещах, которые были добавлены в корзину;

- Особенности CMS (движка). В WordPress обычно дублей страниц нет, а вот Joomla генерирует огромное количество дублей;

- URL с параметрами зачастую приводят к неправильной реализации структуры сайтов;

- Страницы комментариев;

- Страницы для печати;

- Разница в адресе: www – не www. Даже сейчас поисковые роботы продолжают путать домены с www, а также не www. Об этом нужно позаботиться для правильной реализации ресурса.

Влияние дублей на продвижение сайта

- Дубли нежелательны с точки зрения SEO, поскольку поисковые системы накладывают на такие сайты санкции, отправляют их в фильтры, в результате чего понижается рейтинг страниц и всего сайта вплоть до изъятия из поисковой выдачи.

- Дубли мешают продвижению контента страницы, влияя на релевантность продвигаемых страниц. Если одинаковых страниц несколько, то поисковику непонятно, какую из них нужно продвигать, в результате ни одна из них не оказывается на высокой позиции в выдаче.

- Дубли снижают уникальность контента сайта: она распыляется между всеми дублями. Несмотря на уникальность содержания, поисковик воспринимает вторую страницу неуникальной по отношении к первой, снижает рейтинг второй, что сказывается на ранжировании (сортировка сайтов для поисковой выдачи).

- За счет дублей теряется вес основных продвигаемых страниц: он делится между всеми эквивалентными.

- Поисковые роботы тратят больше времени на индексацию всех страниц сайта, индексируя дубли.

Как найти дубли страниц

Исходя из принципа работы поисковых систем, становится понятно, что одной странице должна соответствовать только одна ссылка, а одна информация должна быть только на одной странице сайта. Тогда будут благоприятные условия для продвижения нужных страниц, а поисковики смогут адекватно оценить ваш контент. Для этого дубли нужно найти и устранить.

Программа XENU (полностью бесплатно)

Программа Xenu Link Sleuth (http://home.snafu.de/tilman/xenulink.html), работает независимо от онлайн сервисов, на всех сайтах, в том числе, на сайтах которые не проиндексированы поисковиками. Также с её помощью можно проверять сайты, у которых нет накопленной статистики в инструментах вебмастеров.

Поиск дублей осуществляется после сканирования сайта программой XENU по повторяющимся заголовкам и метаописаниям.

Программа Screaming Frog SEO Spider (частично бесплатна)

Адрес программы https://www.screamingfrog.co.uk/seo-spider/ . Это программа работает также как XENU, но более красочно. Программа сканирует до 500 ссылок сайта бесплатно, более объемная проверка требует платной подписки. Сам ей пользуюсь.

Программа Netpeak Spider (платная с триалом)

Яндекс Вебмастер

Для поиска дублей можно использовать Яндекс.Вебмастер после набора статистики по сайту. В инструментах аккаунта на вкладке Индексирование > Страницы в поиске можно посмотреть «Исключенные страницы» и выяснить причину их удаления из индекса. Одна из причин удаления это дублирование контента. Вся информация доступна под каждым адресом страницы.

Google Search Console

В консоли веб-мастера Google тоже есть инструмент поиска дублей. Откройте свой сайт в консоли Гугл вебмастер. На вкладке Вид в поиске > Оптимизация HTML вы увидите, если есть, повторяющиеся заголовки и метаописания. Вероятнее всего это дубли (частичные или полные).

Язык поисковых запросов

Используя язык поисковых запросов можно вывести список всех страниц сайта, которые есть в выдаче (оператор «site:» в Google и Yandex) и поискать дубли «глазами».

Сервисы онлайн

Есть сервисы, который проверяют дубли страниц на сайте онлайн. Например, сервис Siteliner.com (http://www.siteliner.com/). На нём можно найти битые ссылки и дубли. Можно проверить до 25000 страниц по подписке и 250 страниц бесплатно.

Российский сервис Saitreport.ru, может помочь в поиске дублей. Адрес сервиса: https://saitreport.ru/poisk-dublej-stranic

Удаление дублей страниц сайта

Способов борьбы с дубликатами не так уж и много, но все они потребуют от вас привлечения специалистов-разработчиков, либо наличия соответствующих знаний. По факту же арсенал для «выкорчевывания» дублей сводится к:

- Их физическому удалению - хорошее решение для статических дублей.

- Запрещению индексации дублей в - подходит для борьбы со служебными страницами, частично дублирующими контент основных посадочных.

- в файле-конфигураторе «.htaccess» - хорошее решение для случая с рефф-метками и ошибками в иерархии URL.

- Установке тега « » - лучший вариант для страниц пагинации, фильтров и сортировок, utm-страниц.

- Установке тега «meta name=»robots» content=»noindex, nofollow»» - решение для печатных версий, табов с отзывами на товарах.

Чек-лист по дублям страниц

Часто решение проблемы кроется в настройке самого движка, а потому основной задачей оптимизатора является не столько устранение, сколько выявление полного списка частичных и полных дублей и постановке грамотного ТЗ исполнителю.

Запомните следующее:

- Полные дубли - это когда одна и та же страница размещена по 2-м и более адресам. Частичные дубли - это когда определенная часть контента дублируется на ряде страниц, но они уже не являются полными копиями.

- Полные и частичные дубли могут понизить позиции сайта в выдаче не только в масштабах URL, а и всего домена.

- Полные дубликаты не трудно найти и устранить. Чаще всего причина их появления зависит от особенностей CMS сайта и навыков SEO разработчика сайта.

- Частичные дубликаты найти сложнее и они не приводят к резким потерям в ранжировании, однако делают это постепенно и незаметно для владельца сайта.

- Чтобы найти частичные и полные дубли страниц, можно использовать мониторинг выдачи с помощью поисковых операторов, специальные программы-парсеры, поисковую консоль Google и ручной поиск на сайте.

- Избавление сайта от дублей сводится к их физическому удалению, запрещению индексации дублей в файле «robots.txt», настройке 301 редиректов, установке тегов «rel=canonical» и «meta name=»robots» content=»noindex, nofollow»».