Учебное пособие

ББК 22.172я73

Рецензенты:

Мартышенко С.Н.

Компьютерный анализ данных:

Учебное пособие. – Владивосток: Изд-во ВГУЭС, 2010. – 80 с.

Составлено в соответствии с учебной программой по дисциплине «Компьютерный анализ данных» и требованиями государственного стандарта России. Предназначена для студентов специальностей 0618000 Математические методы в экономике и 351400 «Прикладная информатика в экономике». Содержит теоретический материал по дисциплине, задания к практическим занятиям и указания к их выполнению.

Утверждена на заседании кафедры Математики и моделирования 19.10.08***,протокол№ 18 ***

© Издательство Владивостокского государственного университета

экономики и сервиса, 2010

Введение

Для современной науки и большинства направлений практической деятельности сейчас характерен статистический подход. Закономерности экономики только в среднем смогут считаться детерминистическими, при более детальном исследовании оказывается, что они носят типично случайный характер.

В пособии рассматриваются теоретические и практические вопросы анализа статистических данных. Компьютерный анализ данных следует рассматривать как изучение методик практического применения теоретических методов математической статистики. Прикладной характер, изучаемой дисциплины подчеркивается ориентацией ее на применение конкретного программного продукта EXCEL.

Социально-экономические процессы и явления зависят от большого количества характеризующих их параметров, что обуславливает трудности, связанные с выявлением структуры взаимосвязей этих параметров. В подобных ситуациях, когда решение принимается на основе анализа стохастической, неполной информации необходимо применение методов статистического анализа данных.

Методы анализа данных позволяют обоснованно выбрать среди множества возможных вероятностно-статистических моделей такую, которая наилучшим образом соответствует исходным статистическим данным, характеризующим реальное поведение исследуемой совокупности объектов, оценить надежность и точность выводов, сделанных на основании большого статистического материала.

В пособии рассматривается совокупность глубоко формализованных статистических методов, базирующихся на представлении исходной информации в многомерном геометрическом пространстве и позволяющих определять неявные (латентные), но объективно существующие закономерности в организационной структуре и тенденциях развития изучаемых социально-экономических процессов и явлений.

Основной задачей пособия является обучение студентов теоретическим основам наиболее распространенных методов статистического анализа данных и развития навыков применения стандартных программных средств, в которых реализованы процедуры статистического анализа данных.

Для успешного изучения материала, изложенного в пособии студенту необходимы знания по основным разделам «Высшей математики» и «Математическая статистика». Необходимы знания таких основополагающих понятий как: виды случайных величин, характеристики случайных величин, основные законы распределения случайных величин, способы оценки выборочных характеристик, основы статистического вывода с использованием статистических критериев и проверки гипотез, линейная и нелинейная регрессии.

В ходе изучения материала, изложенного в пособии, у студента должно формироваться представление о конкретных практических ситуациях, в которых необходимо использование методов статистического анализа.

В результате работы с пособием и выполнения практических заданий студенту необходимо достигнуть определенного уровня знаний в области компьютерного анализа данных. Необходимый уровень знаний состоит из трех пунктов.

1. освоить:

Концепцию и технологии современного анализа данных на компьютере;

Принципы работы программных средств, предназначенных для статистического анализа данных;

Принципы работы современных визуальных методов анализа данных и использования их для статистического вывода и формулировки гипотез о структуре данных.

2. Выработать умения самостоятельного решения задач по выбору методов анализа в практических ситуациях;

3. полученть навыкиприменения программных систем; предназначенных для статистического анализа данных, а также тестирования программных модулей на модельных данных.

англ. analysis, data; нем. Datenanalyse. Этап эмпирического социол. исследования, в ходе к-рого при помощи содержательных соображений и мате-матико-статист. методов на основе первичной информации раскрываются связи исследуемых переменных.

Отличное определение

Неполное определение ↓

АНАЛИЗ ДАННЫХ

1. Совокупность действий, осуществляемых исследователем в процессе изучения полученных тем или иным образом данных с целью формирования определенных представлений о характере явления, описываемого этими данными. В процессе А.д. исследователь чаще всего пытается сократить их количество, стремясь потерять при этом как можно меньше полезной информации, потенциально в них заложенной. Делается это обычно с помощью математич. методов. При использовании математич. статистики, напр., сокращение количества данных достигается за счет двух взаимно дополняющих друг друга принципов: выборочного метода и свертки информации. Первый из них декларирует отказ от всей совокупности данных в пользу специально организованной их части - выборки (см.), а второй заменяет всю выборку несколькими числами - ее характеристиками Таковыми могут быть, напр., среднее арифметич. и дисперсия, уравнение регрессии, рез-ты применения факторного анализа, методов классификации и т. д. Для получения подобных характеристик данные подвергаются нек-рым воздействиям: они или обрабатываются, или исследуются, или анализируются. Поэтому процесс "свертки" данных называется не только их анализом, но и их обработкой, исследованием. 2. Процесс изучения статистич. данных (т. е. анализ этих данных в смысле п. 1) с помощью математич. методов, не предполагающих вероятностной модели интересующего исследователя явления (в частности, не опирающихся на допущения о вероятностной природе исходных данных, о статистич. модели порождения данных). Развитие теории и практики статистич. обработки данных идет в двух параллельных направлениях. Одно из них представлено методами, предусматривающими возможность вероятностной интерпретации данных и полученных в рез-те обработки статистич. выводов, использования вероятностных моделей для построения и выбора наилучших методов статистич. обработки. Эти методы обычно называют вероятностно-статистическими. Они предполагают адекватную реальности определенную вероятностную модель изучаемого с их помощью явления. В предположении этой адекватности получаемые с помощью таких методов выводы будут основываться на строго доказанных математич. рез-тах, дающих возможность помимо всего прочего устанавливать точность упомянутых выводов (см. Оценивание статистическое, Проверка статистических гипотез). Др. направление представлено методами А.д., не предполагающими вероятностных моделей изучаемых явлений. Строгих же математич. методов обработки статистич. данных с помощью такого рода методов пока не существует. Они не основываются на строго доказанных математич. рез-тах и, как следствие, не дают возможности устанавливать точность получаемых с их помощью выводов. Применение методов А.д. чаще всего основывается на следующей схеме. Подлежащие статистич. обработке исходные данные не могут интерпретироваться как выборка из генеральной совокупности и, следовательно, использование вероятностных моделей при построении и выборе наилучших методов статистич. обработки и последующая вероятностная интерпретация статистич. выводов оказываются неправомерными. Из множества методов, реализующих поставленную цель статистич. обработки данных, в качестве к-рой может выступать классификация объектов, нахождение латентных факторов и т. д. (см. Статистика математич. и Анализ многомерный статистич.), наилучший метод обычно выбирается с помощью оптимизации нек-рого задаваемого из эвристич., содержательных соображений критерия (функционала) качества метода. Естественно, что при этом проблема обоснованности получаемых с помощью методов А.д. выводов требует особого внимания. Здесь особенно острой является необходимость выделения "точек соприкосновения содержания задачи и математич. формализма (см. Адекватность математич. метода, п. 1). К методам А.д. следует отнести и вероятностно-статистич. метод, если у исследователя не имеется возможности проверить адекватность реальности предполагаемой методом вероятностной модели изучаемого явления; тем более, если в подобной ситуации социолог имеет основания сомневаться в такой адекватности. Правомерность использования вероятностно-статистич. метода в таком случае также должна опираться на содержательные соображения. Поскольку методы А.д. с т.зр. ортодоксальной математики не являются достаточно обоснованными, то имеет смысл использовать эти методы лишь на предварительном этапе анализа для уточнения представлений исследователя об изучаемом явлении, корректировки понятийного аппарата, формулировки гипотез и т. д. Однако с этим положением, выдвигаемым рядом авторов как неоспоримое, во многих ситуациях трудно согласиться. Методы А.д. могут служить и средством получения фундаментального знания, выявления неизвестных ранее закономерностей, если перейти на новый уровень понимания самого математич. формализма: считать, что адекватным решаемой задаче является не к.-л. отдельный метод (при этом не играет роли, имеется в виду вероятностно-статистич. метод или метод А.д.), а целая совокупность таких методов, применяемых в соответствии с определенными методологич. принципами (см. п. 4). Выделение класса методов анализа данных в рассматриваемом смысле обусловлено потребностями целого ряда наук, в т. ч. и социологии. В этих науках, с одной стороны, велика потребность анализа статистич. данных, а с другой - традиционные предположения, лежащие в основе вероятностно-статистич. методов, разработанных специально для решения такого рода задач, часто не выполняются. Однако невыполнение вероятностно-статистич. посылок не является единственной причиной отсутствия "законной" возможности использования вероятностно-статистич. аппарата в социологии. Др. не менее распространенной причиной непригодности тех или иных методов является их неадекватность относительно типа используемых шкал (см. Адекватность математич. метода, п. 2). Так, неадекватным является применение традиционных математико-статистич. методов к данным, полученным по порядковым шкалам, что часто делается на практике. Метод, используемый для шкал, относительно типа к-рых он не адекватен, также может быть отнесен к области А.д. 3. А.д. - прикладная статистика, понимаемая как науч. дисциплина, разрабатывающая и систематизирующая понятия, приемы, математич. методы и модели, предназначенные для организации сбора (имеется в виду лишь определение способа отбора подлежащих статистич. обследованию единиц из всей исследуемой совокупности), стандартной записи, систематизации и обработки (в т. ч. с помощью ЭВМ) статистич. данных с целью их удобного представления, интерпретации и получения науч. и практич. выводов. 4. Такие процедуры получения "свертки" информации (см. п.1), к-рые не допускают формального алгоритмич. подхода. Такое понимание термина "А.д." отвечает новому направлению исследований, оказавшемуся в центре внимания многих статистиков и специалистов по переработке данных. Применение любого математич. метода для изучения любого явления означает использование формальной модели этого явления - определенной системы предпосылок и постулатов. Специфика социологич. (и не только социологич.) задач проявляется, в частности, в том, что для большинства известных математико-статистич. методов проверка адекватности этих предпосылок и постулатов, состоятельности соответствующей модели является весьма проблематичным делом. А.д. предлагает "затеять игру" с предпосылками: варьировать их и рассматривать последствия такого варьирования. Так, можно сначала смотреть на данные как на числа (детерминированная модель), а потом - как на случайные величины (стохастическая модель) и выбирать такой ответ, к-рый лучше гармонируют с требованиями конкретной задачи. Такое отношение к предпосылкам в А.д., возведенное в принцип, назовем первым. Второй принцип А.д. - системный подход. А.д. изыскивает различ. приемы для наиболее полного использования эндогенной информации (т. е. данных, описывающих изучаемый объект), но вместе с тем он постоянно нацелен на максимальное использование экзогенной информации (т. е. данных, описывающих "среду обитания" объекта). Системный подход предъявляет исследователям повышенные требования, поскольку он носит принципиально междисциплинарный характер. Третьим принципом А.д. можно считать отказ от той т.зр., что любое исследование имеет начало и конец. Анализ - способ существования данных. Готовность к постоянному возврату к одним и тем же данным - важная новая особенность процесса применения математики для получения нового знания. В непрерывном процессе анализа предусматриваются разрывы, позволяющие извлекать накопленную информацию и принимать решения, связанные с управлением обработкой данных и с их дальнейшим анализом. Формальные операции перемежаются с неформальными процедурами принятия решения. С появлением новых экспериментальных данных возникают новые идеи, подходы, методы, уточняется понимание происходящих процессов и т. д. А.д. сводит воедино изначально как бы не связанные друг с другом элементы, подчинив их единому механизму решения задачи, открыв тем самым дорогу новому взгляду на возможности сбора, анализа и интерпретации данных различ. природы. В социологии насущная необходимость использования А.д. обусловливается отнюдь не только трудностью проверки предпосылок, заложенных в представляющихся подходящими (для решения соответствующих задач) методах. Напротив, известно много таких пригодных для социологии методов, к-рым отвечают сравнительно слабые предпосылки. Таковыми являются, напр., многие методы поиска взаимодействий (см.), в т. ч. такой, как анализ детерминационный (см.), к-рые вообще практически не предполагают никакой модели реальности, не опираются ни на какие предпосылки. Тем не менее потребность в А.д. остается, поскольку у социолога очень часто отсутствует та априорная социологич. модель изучаемого явления (см. Адекватность математич. метода, п.1), формирование к-рой является необходимой для однозначного выбора математич. формализма (да и вообще для проведения исследования, начиная с формулировки гипотез и разработки анкеты). Творческая реализация принципов А.д. позволяет восполнить этот недостаток. (См. также: Комплексное использование математич. методов.). В качестве одной из главных целей разработки алгоритмов А.д. в смысле п. 2 и принципов комплексного использования серии алгоритмов в смысле п. 4 нек-рые авторы (Дж.У.Тьюки) выдвигают такой "охват" содержания исходных данных значительного объема, к-рый позволяет прийти к представлениям (предпочтительно визуальным), легко доступным для понимания пользователя (см. Интерпретация рез-тов применения математич. метода). Лит.: Тьюки Дж.У. Анализ данных, вычисления на ЭВМ и математика// Современные проблемы математики. М., 1977; Миркин Б.Г. Анализ качественных признаков и структур. М., 1980; Тьюки Дж.У. Анализ результатов наблюдений: разведочный анализ. М., 1981; Мостеллер Ф., Тьюки Дж.У. Анализ данных и регрессия. М., 1982; Елисеева И.И., Рукавишников В.О. Логика прикладного статистического анализа. М., 1982; Айвазян С.А., Енюков И.С., Мешалкин Н.Д. Прикладная статистика. М., 1983; Дидэ Э. и др. Методы анализа данных. М., 1985; Дрейпер Н., Смит Г. Прикладной регрессионный анализ. Т.2. М., 1987; Толстова Ю.Н. Логика математического анализа социологических данных. М., 1991; Benzecri J.P. Lanalyse des donnees. Vol. 1. La taxonomie. Vol. 2. Lanalyse des correspon-dances. Dunod, 1973; Statistical data analysis. Providence, Rhode Island: American Mathematical Society, 1983; Фелингер А.Ф. Статистические алгоритмы социологических исследований. Новосибирск, 1985; Тюрин Ю.Н., Макаров А.А. Анализ данных на компьютере. М., 1995. Андре-енков В.Г. Анализ и интерпретация эмпирических данных/ /Социология. Основы общей теории (под ред. Осипова Г.В., Москвичева Л.Н.). М., 1996; см. также лит. к ст. Комплексное использование математич. методов. Ю.Н. Толстова

Механизм анализа данных и прогнозирования предоставляет пользователям (экономистам, аналитикам и т.д.) возможность осуществлять поиск неочевидных закономерностей в данных, накопленных в информационной базе. Этот механизм позволяет:

- осуществлять поиск закономерностей в исходных данных информационной базы;

- управлять параметрами выполняемого анализа как программно, так и интерактивно;

- осуществлять программный доступ к результату анализа;

- автоматически выводить результат анализа в табличный документ;

- создавать модели прогноза, позволяющие автоматически прогнозировать последующие события или значения неких характеристик новых объектов.

Механизм анализа данных представляет собой набор взаимодействующих друг с другом объектов встроенного языка, что позволяет разработчику использовать его составные части в произвольной комбинации в любом прикладном решении. Встроенные объекты позволяют легко организовать интерактивную настройку параметров анализа пользователем, а также позволяют выводить результат анализа в удобной для отображения форме в табличный документ.

Механизм позволяет работать как с данными, полученными из информационной базы, так и с данными, полученными из внешнего источника, предварительно загруженными в таблицу значений или табличный документ:

Применяя к исходным данным один из видов анализа, можно получить результат анализа. Результат анализа представляет собой некую модель поведения данных. Результат анализа может быть отображен в итоговом документе, или сохранен для дальнейшего использования.

Дальнейшее использование результата анализа заключается в том, что на его основе может быть создана модель прогноза, позволяющая прогнозировать поведение новых данных в соответствии с имеющейся моделью.

Например, можно проанализировать, какие товары приобретаются вместе (в одной накладной) и сохранить этот результат анализа в базе данных. В дальнейшем, при создании очередной накладной:

на основании сохраненного результата анализа можно построить модель прогноза, подать ей "на вход" новые данные, содержащиеся в этой накладной, и "на выходе" получить прогноз, - список товаров, которые контрагент Петров Б.С. тоже, скорее всего, приобретет, если их ему предложить:

В механизме анализа данных и прогнозирования реализовано несколько типов анализа данных:

Реализованные типы анализа

Общая статистика

Представляет собой механизм для сбора информации о данных, находящихся в исследуемой выборке. Этот тип анализа предназначен для предварительного исследования анализируемого источника данных.

Анализ показывает ряд характеристик числовых и непрерывных полей. При выводе отчета в табличный документ заполняются круговые диаграммы для отображения состава полей.

Поиск ассоциаций

Данный тип анализа осуществляет поиск часто встречаемых вместе групп объектов или значений характеристик, а также производит поиск правил ассоциаций. Поиск ассоциаций может использоваться, например, для определения часто приобретаемых вместе товаров, или услуг:

Этот тип анализа может работать с иерархическими данными, что позволяет, например, находить правила не только для конкретных товаров, но и для их групп. Важной особенностью этого типа анализа является возможность работать как с объектным источником данных, в котором каждая колонка содержит некоторую характеристику объекта, так и с событийным источником, где характеристики объекта располагаются в одной колонке.

Для облегчения восприятия результата предусмотрен механизм отсечения избыточных правил.

Поиск последовательностей

Тип анализа поиск последовательностей позволяет выявлять в источнике данных последовательные цепочки событий. Например, это может быть цепочка товаров или услуг, которые часто последовательно приобретают клиенты:

Этот тип анализа позволяет осуществлять поиск по иерархии, что дает возможность отслеживать не только последовательности конкретных событий, но и последовательности родительских групп.

Набор параметров анализа позволяет специалисту ограничивать временные расстояния между элементами искомых последовательностей, а также регулировать точность получаемых результатов.

Кластерный анализ

Кластерный анализ позволяет разделить исходный набор исследуемых объектов на группы объектов, таким образом, чтобы каждый объект был более схож с объектами из своей группы, чем с объектами других групп. Анализируя в дальнейшем полученные группы, называемые кластерами, можно определить, чем характеризуется та или иная группа, принять решение о методах работы с объектами различных групп. Например, при помощи кластерного анализа можно разделить клиентов, с которыми работает компания, на группы, для того, чтобы применять различные стратегии при работе с ними:

При помощи параметров кластерного анализа аналитик может настроить алгоритм, по которому будет производиться разбиение, а также может динамически изменять состав характеристик, учитываемых при анализе, настраивать для них весовые коэффициенты.

Результат кластеризации может быть выведен в дендрограмму - специальный объект, предназначенный для отображения последовательных связей между объектами.

Дерево решений

Тип анализа дерево решений позволяет построить иерархическую структуру классифицирующих правил, представленную в виде дерева.

Для построения дерева решений необходимо выбрать целевой атрибут, по которому будет строиться классификатор и ряд входных атрибутов, которые будут использоваться для создания правил. Целевой атрибут может содержать, например, информацию о том, перешел ли клиент к другому поставщику услуг, удачна ли была сделка, качественно ли была выполнена работа и т.д. Входными атрибутами, для примера, могут выступать возраст сотрудника, стаж его работы, материальное состояние клиента, количество сотрудников в компании и т.п.

Результат работы анализа представляется в виде дерева, каждый узел которого содержит некоторое условие. Для принятия решения, к какому классу следует отнести некий новый объект, необходимо, отвечая на вопросы в узлах, пройти цепочку от корня до листа дерева, переходя к дочерним узлам в случае утвердительного ответа и к соседнему узлу в случае отрицательного.

Набор параметров анализа позволяет регулировать точность полученного дерева:

Модели прогноза

Модели прогноза, создаваемые механизмом, представляют собой специальные объекты, которые создаются из результата анализа данных, и позволяют в дальнейшем автоматически выполнять прогноз для новых данных.

Например, модель прогноза поиска ассоциаций, построенная при анализе покупок клиентов, может быть использована при работе с осуществляющим покупку клиентом, для того, чтобы предложить ему товары, которые он с определенной степенью вероятности приобретет вместе с выбранными им товарами.

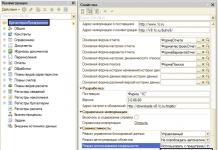

Использование механизма анализа данных в прикладных решениях

Для ознакомления разработчиков прикладных решений с механизмом анализа данных, на диске «Информационно-технологическое сопровождение» (ИТС) размещена демонстрационная информационная база. В ее состав входит универсальная обработка "Консоль анализа данных", которая позволяет выполнять анализ данных в любом прикладном решении, без доработки конфигурации.

Введение

Настоящий выпуск является вторым из серии выпусков, в которых излагается курс «Математическое моделирование геологических объектов», сопровождаемый учебно-методическими рекомендациями, контрольными вопросами и комментариями. В этом выпуске первоочередное внимание уделяется анализу данных как самостоятельной научной дисциплине и в его сопряжении с прикладной статистикой. Излагается, конечно, не «весь» анализ данных, а только отдельные его фрагменты, необходимые для понимания курса в целом. Приводятся минимально необходимые сведения о прикладной статистике.

Математическое моделирование геологических объектов тесно связано с анализом данных, как самостоятельной научной дисциплиной, и прикладной статистикой.

Каким образом анализ данных, математическое моделирование и прикладная статистика совместно используются при решении конкретных геологических задач и, в частности, при создании моделей геологических объектов? Обычно создание модели геологического объекта разбивается на ряд подзадач, образующих единую блок-схему с последовательным и параллельным движением обрабатываемой информации от исходных процедур к конечному результату – синтезу модели.

Решение каждой из таких подзадач сводится либо к построению и анализу некоторой частной модели, либо к поиску стохастической зависимости между некоторыми параметрами, либо к решению той или иной типовой задачи анализа данных и т.п. В последнем случае выбирается алгоритм, удовлетворяющий требованиям, предъявляемым исходной информацией. Требования эти могут иметь как чисто формальный характер (например, наличие в таблице разнотипных признаков делает невозможным применение некоторых алгоритмов), так и представлять собой «трудно» формализуемые представления о системе исследуемых объектов, которыми тоже не следует пренебрегать.

В настоящее время не существует универсального формально-математического способа для выбора подходящего алгоритма. Поэтому при выборе алгоритма наряду с проверкой его формально-математической пригодности рекомендуется ориентироваться и на его относительную простоту и содержательную интерпретируемость используемого математического аппарата в конкретной задаче, опыт применения алгоритма при решении аналогичных задач.

Распознавание образов

Основные подзадачи

Основными подзадачами задачи распознавания являются:

1 ) создание исходного списка признаков;

2 ) выбор классов объектов;

3 ) подготовка таблицы (таблиц) обучения;

4 ) выбор семейства решающих правил;

5 ) поиск оптимального (относительно некоторого критерия или критериев) решающего правила в этом семействе;

6 ) подготовка описаний проб;

7 ) распознавание проб.

На этапах 1 -3 производится выбор и экспликация признаков (см. пособие Красавчикова, 2008) и составление базы данных.

При создании исходного перечня признаков могут быть реализованы два подхода:

А ) всестороннее описание объектов, характерное для ситуаций, когда исследователь не знает, из каких признаков должен быть составлен окончательный список (информативная система признаков), по которому будет производиться распознавание проб. Поэтому он отбирает такие признаки, которые, в принципе, могут содержать полезную информацию (хотя, на первый взгляд, их связь с решаемой задачей может быть и не очевидна), и полагается в выборе информативной системы признаков на алгоритм и реализующую его программу.

Б ) описание объектов, основанное на некоторой геологической модели, для которой список признаков заранее известен.

При выборе классов объектов исходят не только из постановки задачи (например, разбраковать локальные поднятия на перспективные и бесперспективные по результатам интерпретации данных сейсморазведки), но и основываются на геологическом смысле и опыте решения аналогичных задач. Возможно, придётся проводить декомпозицию задачи и осуществлять поэтапное решение в рамках последовательно-параллельной блок-схемы несколько задач распознавания.

При подготовке таблицы (таблиц) обучения следует, по-возможности, избегать появления характеристических признаков, замеренных в шкале наименований (номинальных) с числом принимаемых ими значений, превосходящим два, поскольку они резко ограничивают выбор алгоритма распознавания. Они могут содержать весьма существенную информацию, но лучше, чтобы они не входили в список характеристических признаков. Обычно, по значениям таких признаков формируются классы.

Выбор семейства решающих правил не является формальной процедурой. Однако, при этом выборе есть и формальные требования. Например, если среди признаков есть номинальные или ранговые, то можно использовать только те алгоритмы, которые способны работать с информацией, представленной в качественных шкалах.

Одним из главных критериев выбора решающего правила является его «простота». Практика показала, что предпочтение следует отдавать более простым решающим правилам. Если среди «простых» решающих правил (причём, доступных исследователю в программной реализации) не удаётся найти способного справиться с поставленной задачей (или, в случае (а ), радикально сократить размерность описания), то переходят к более сложным и т.д.

Формализовать понятие простоты не так-то просто! В математической логике и теории алгоритмов есть целое направление, связанное с формализацией и изучением простоты математических конструкций, но знакомство с этой тематикой не входит в задачи курса. Поэтому будем относиться к этой проблематике как интуитивно ясной. По всей видимости, примером наиболее простых решающих правил могут служить линейные (см. ниже). Если есть два линейных решающих правила, то более простым, очевидно, является то, которое использует меньшее число признаков.

В случае (а ) при выборе семейства решающих правил следует обращать особое внимание на способность радикального сокращения размерности описания.

После выбора семейства проводится поиск решающей функции и соответствующего правила, которые в этом семействе обладают «наилучшим качеством» по отношению к материалу обучения и экзамена.

Для оценки качества решающего правила используются функционалы наподобие нижеприведённого:

Δ(F,λ,ε)=p 1 M 1 + p 2 M 2 +p 3 M 3 + p 4 M 4 ,

где для материала обучения и экзамена

M 1 – число ошибочно распознанных объектов первого класса;

M 2 – число ошибочно распознанных объектов второго класса;

M 3 – число отказов для объектов первого класса;

M 4 – число отказов для объектов второго класса.

Коэффициенты p j , j=1,…,4, – «штрафы» за ошибку соответствующего типа. Чем меньше значение Δ(F,λ,ε) (при фиксированных списках объектов обучения и экзамена), тем выше качество решающего правила.

После того, как для всех объектов обучения и экзамена вычислены значения решающей функции, управляющие параметры алгоритма λ, ε могут быть выбраны оптимальным образом, т.е. так, чтобы функционал качества решающего правила достигал минимума:

Δ(F,λ * ,ε *)=min Δ(F,λ,ε),

где минимум берётся по всемλ, ε и ε>0.

В случае (а ) ещё одним (и не менее важным) критерием качества является резко сокращение числа признаков, используемых в распознавании, по сравнению с исходным списком. Это обусловлено тем, что

Малое число признаков уменьшает влияние «информационных шумов», что делает распознавание более надёжным;

Сокращается время на подготовку описаний проб. Так, при распознавании в узлах сеток уменьшается число карт, которые приходится строить;

Появляется возможность содержательно проинтерпретировать решающее правило и т.д.

Описание проб производится по признакам, используемым в оптимальном решающем правиле. В случае (а ) это особенно важно, т.к., в частности, существенно сокращается время на подготовку описаний.

Примеры алгоритмов распознавания

К настоящему времени опубликованы сотни методов распознавания. Они объединяются в семейства. Зачастую, эти семейства описываются в виде решающих функций (либо правил) с неопределёнными параметрами. Устоявшейся общепризнанной классификации семейств алгоритмов распознавания не существует. Поэтому ограничимся кратким описанием нескольких семейств алгоритмов, показавших свою эффективность при решении прикладных геологических задач, особенно в геологии нефти и газа.

Для подробного ознакомления с применением методов распознавания в геологии нефти и газа отсылаем читателя к публикациям 60-80 годов прошлого века, когда их использование при решения задач прогнозно-поискового профиля было массовым. Методы распознавания применялись, в частности, при решении задач прогноза гигантских нефтяных месторождений, продуктивности локальных поднятий, фазового состояния УВ в залежах и др. (Распознавание образов…, 1971; Раздельное прогнозирование…, 1978, Прогноз месторождений …, 1981 и др.).

4.3.1. Байесовские решающие правила

Эти решающие правила подробно охарактеризованы в учебном пособии Дёмина (2005), куда мы и отсылаем читателя. Для более глубокого ознакомления с приложениями байесовской теории принятия решений в геологии нефти и газа рекомендуем обратиться к монографии (Прогноз месторождений…, 1981).

4.3.2. Комбинаторно-логические методы в распознавании

Применение этих методов рассмотрим на примере одной конкретной схемы распознавания, основанной на аппарате дискретной математики и математической логики.

Пусть сначала для простоты изложения все признаки X 1 ,…,X n – бинарные. Согласно Журавлёву (1978) назовём произвольную совокупность W наборов признаков вида w=(X j (1) ,…,X j (k)), где k=1,…,n, системой опорных множеств, W={w 1 , w 2 ,…, w N }, а её элементы w r – опорными множествами.

Пусть wÎW, w=(X j (1) ,…,X j (L)), S k – строка таблицы , Q p – строка таблицы . Строки S k и Q p различаются по набору признаков w, если найдётся входящий в w признак X j (r) такой, что X j (r) (S k)¹X j (r) (Q p). В противном случае будем говорить, что они не различаются.

Определение 1 .Набор признаков wÎW голосует за отнесение строки S к первому классу, если в таблице T 1 найдётся строка S k , такая, что по набору w строки S и S k не различаются; w голосует за отнесение строки S ко второму классу, если в таблице T 2 найдётся строка Q p , такая, что по набору w строки S и Q p не различаются.

при Г 1 (S) > Q p) и Г 2 (S) ≤ Г 2 (S i) объект S относится к классу K 1 ;

при Г 2 (S) > S i) и Г 1 (S) ≤ Г 1 (Q p) объект S относится к классу K 2 ;

в остальных случаях S не распознаётся.

Смысл этого решающего правила заключается в том, что для отнесения пробы S к классу K j , где j=1,2, она должна получить

Эта схема представляет собой один из простейших вариантов голосования по системе опорных множеств. Алгоритм представляет собой реализацию так называемого «принципа частичной прецедентности» (Журавлёв, 1978), при котором заключение о принадлежности объекта к классу выносится на основе анализа совпадений фрагментов его описания с соответствующими фрагментами описаний объектов этого класса. Совпадение фрагментов описаний объекта обучения и пробы является частичным прецедентом.

Пример системы опорных множеств: тестовая конструкция. Её основой являются понятия теста и тупикового теста, предложенные С.В. Яблонским в качестве математического аппарата диагностики технических устройств (Журавлёв, 1978).

Определение 2. Набор столбцовw называется тестом для пары таблиц T 1 , T 2 если по нему нет совпадений между строками S i и Q p , где

Определение 3 .Тест называетсятупиковым, если из него нельзя удалить ни одного столбца без того, чтобы он перестал быть тестом.

Дмитриев, Журавлёв, Кренделев (1966) воспользовались аппаратом тупиковых тестов для создания алгоритмов классификации предметов и явлений.

В геологии нефти и газа комбинаторно-логические методы впервые были применены при решении задач прогноза гигантских нефтяных месторождений (Распознавание образов …, 1971), где была использована тестовая конструкция. Под руководством А.А. Трофимука тестовый подход применён также и к решению других важнейших прогнозных задач геологии нефти и газа (Раздельное прогнозирование…, 1978 и др.). Ряд сделанных А.А. Трофимуком прогнозов, не нашедших поддержки в момент опубликования, в дальнейшем блестяще подтвердились.

Константиновым, Королёвой, Кудрявцевым (1976) на представительном фактическом материале по прогнозу рудоносности была подтверждена эффективность алгоритмов тестового подхода по сравнению с другими алгоритмами распознавания, применявшимися для решения задач рудопрогноза.

В геологии нефти и газа другие системы опорных множеств не применялись.

Если в таблицах встречаются признаки, замеренные в количественных шкалах, то для них используются пороговые меры различимости значений (см. Красавчиков, 2009).

4.3.1. Линейные методы

Линейные методы стали применяться для решения задач распознавания образов одними из первых (см.. Ту, Гонсалес, 1978) в середине прошлого века.

Пусть F(u 1 ,…,u n)=a 1 u 1 + a 2 u 2 + … +a n u n – линейная функция n переменных u 1 ,…,u n . Методы отыскания линейных решающих функций и правил принято называть линейными. Общий вид линейных решающих правил может быть задан следующим образом:

при a 1 X 1 (S) + a 2 X 2 (S) + … +a n X n (S)≥λ+ε объект S относится к К 1 ;

при a 1 X 1 (S) + a 2 X 2 (S) + … +a n X n (S)≤λ-ε объект S относится к К 2 ;